全网最干净!! deepseek+Ollama本地化部署全流程(细节很多收藏看)

主要是介绍了deepseek的安装和ollama的安装

想要本地部署,必须安装deepseek大模型,和LLM程序(ollama或者vllm都可以,文章以Ollama举例).

当然,开展以下工作之前要看一下自己能不能部署!

【WIN + I】 打开设置——》系统——》系统信息

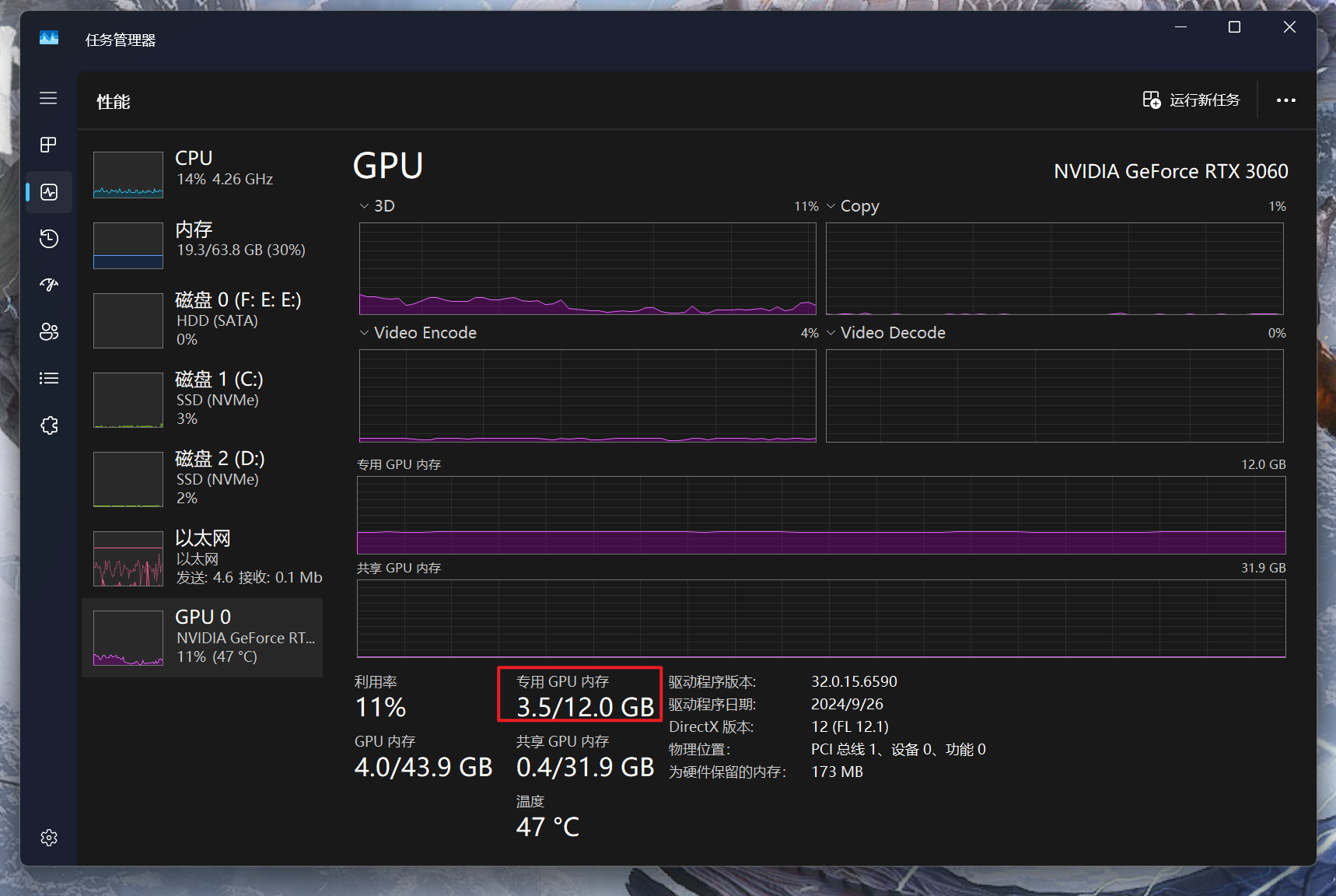

【Ctrl + Shift + ESC】打开任务管理器——》性能——》GPU

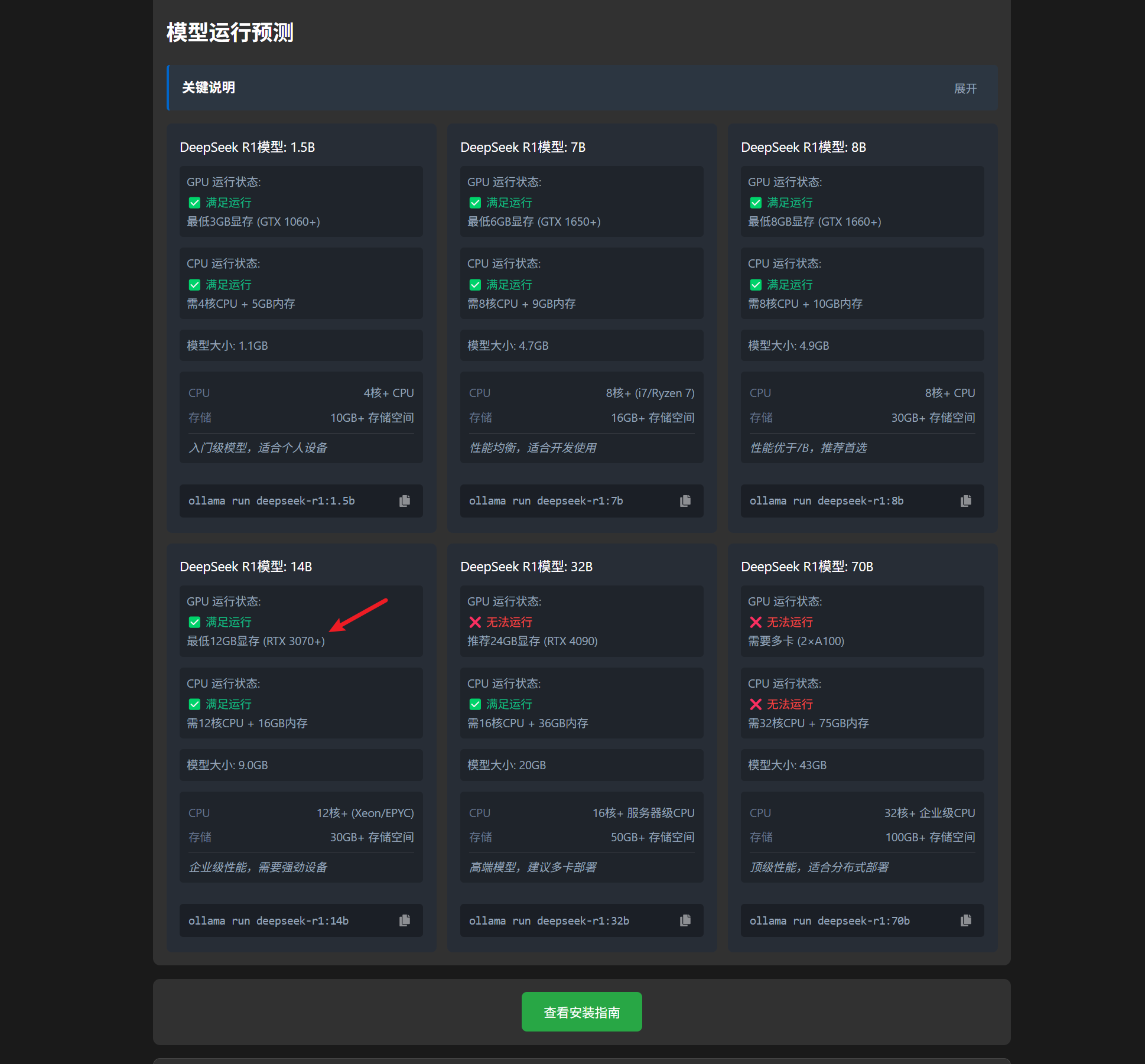

然后在deepseek模型兼容性检测网站按照自己的参数输入下看看能不能本地跑大模型.

比如我电脑虽然有12G显存但是显卡是3060ti,所以听劝直接下载DeepSeekR1模型:8B就行

Ollama大模型

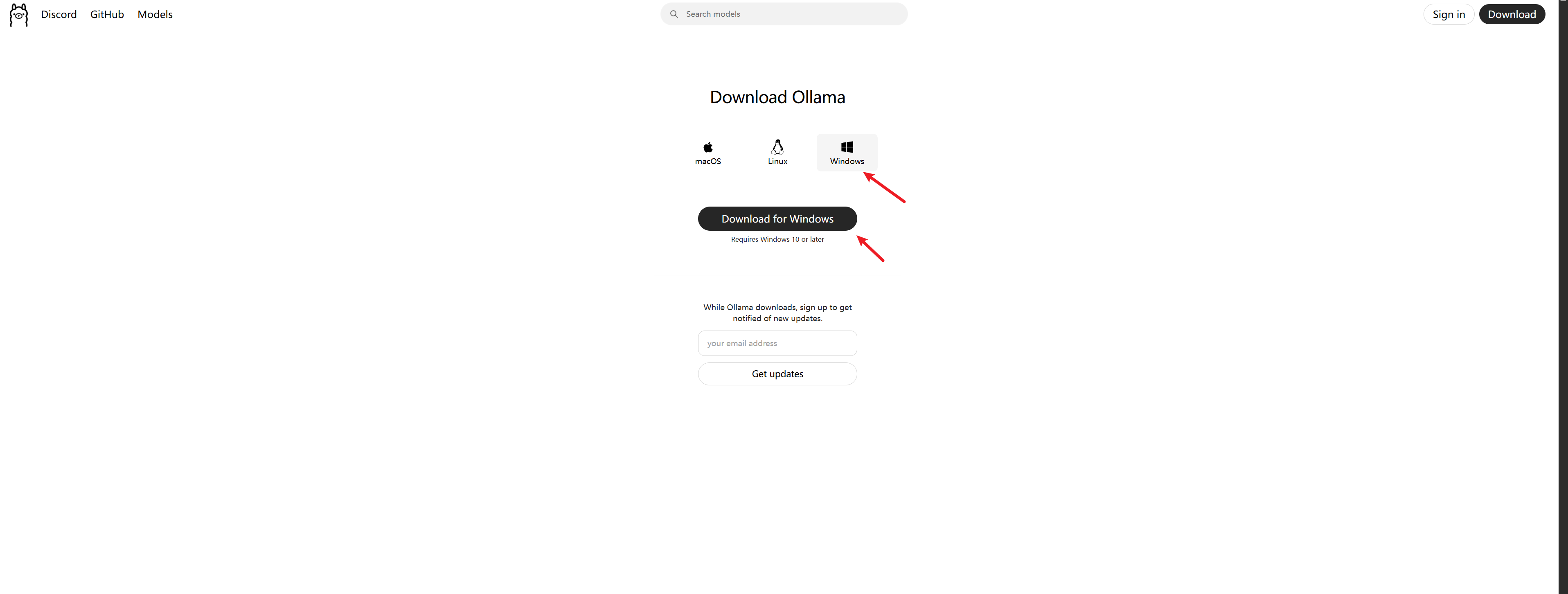

下载地址如下:ollama下载地址,下载慢也可以在百度网盘下载.

直接点击 Download 下载他识别到的系统类型的Ollama就行,不需要考虑别的.

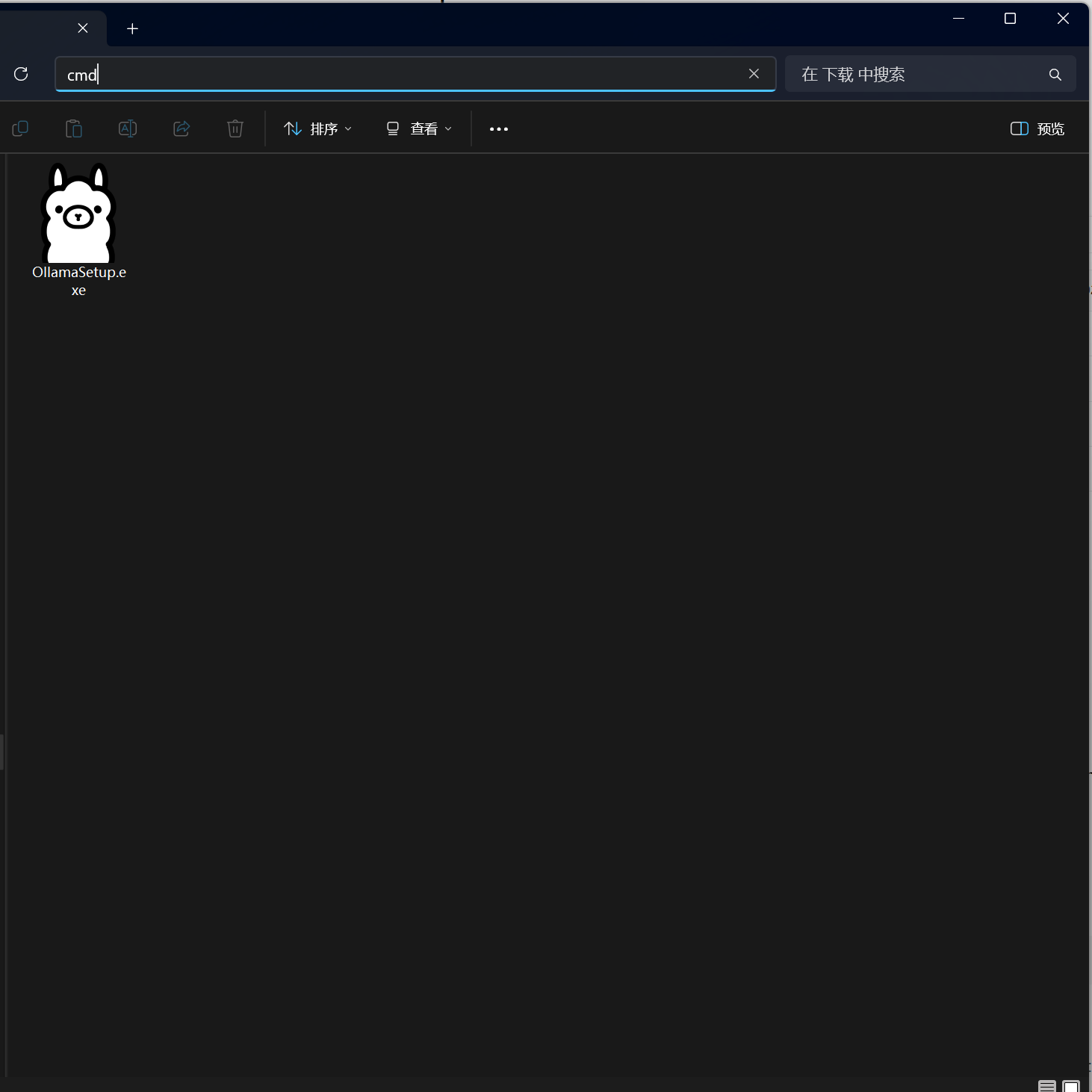

下载好之后直接双击安装会安装到C盘,如果想安装到其他位置,可以准备一个安装位置(我要安装到 D:\Ollama )

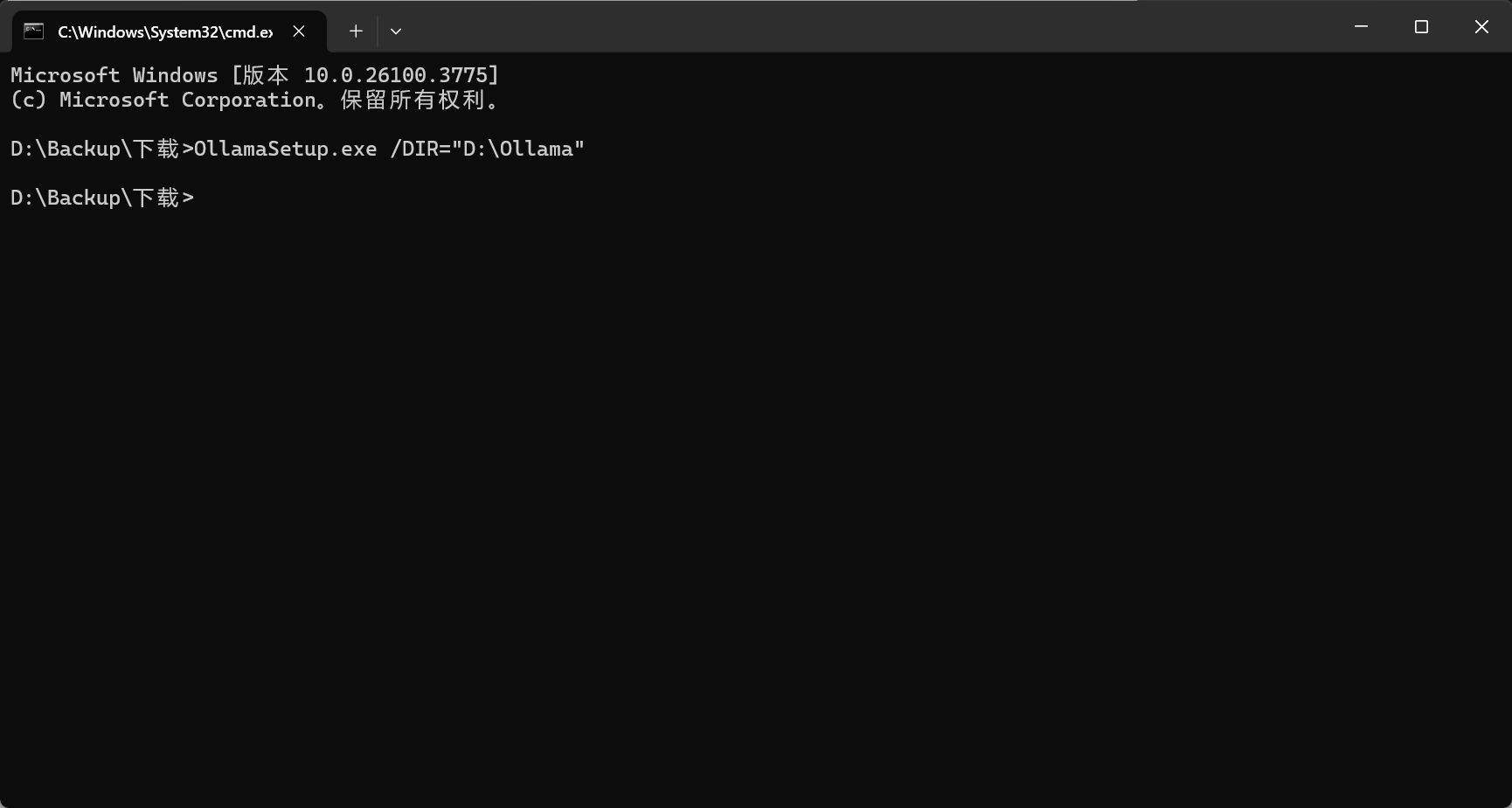

可以通过在安装包的位置栏输入cmd,回车打开控制台

然后再控制台输入 : OllamaSetup.exe /DIR=“D:\Ollama”

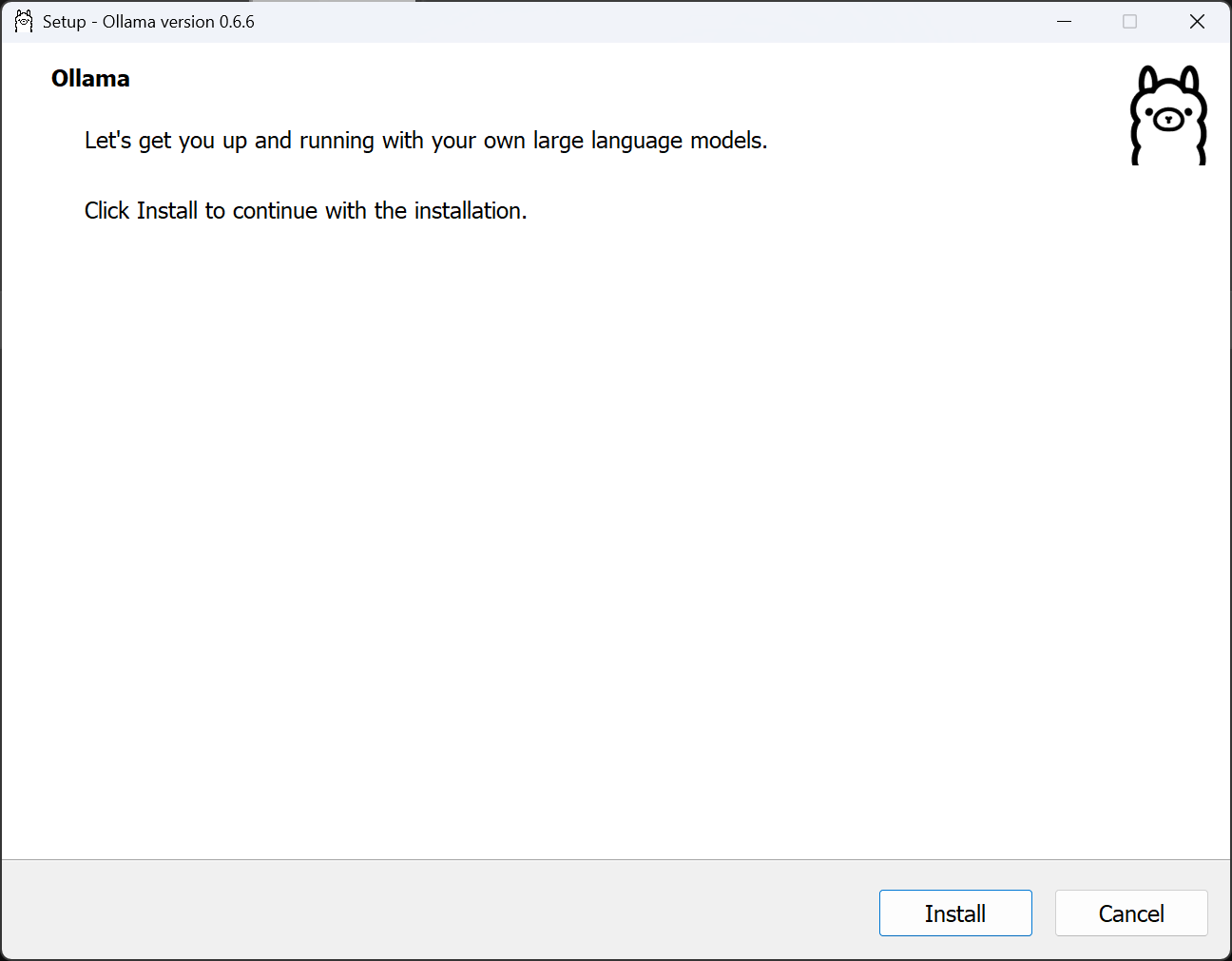

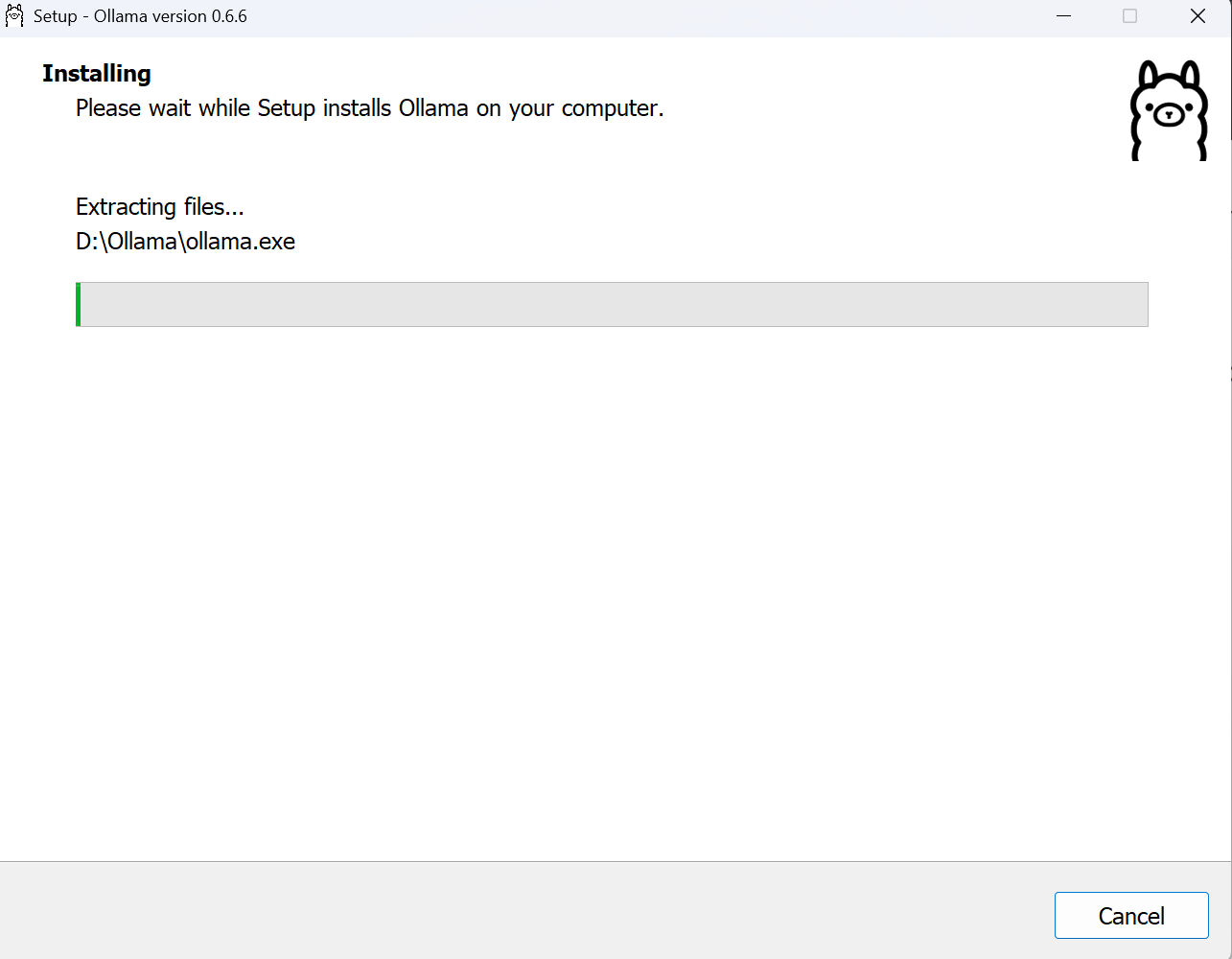

输出完后,会弹出安装界面,直接点击Install就会安装到你设置的位置上

安装完成会自己启动,后续我们根据官网提供的指令直接再控制台安装模型就好了.

这里可以在 控制台 设置一下模型允许源、 监听端口和安装位置

setx OLLAMA_ORIGINS *

setx OLLAMA_HOST 0.0.0.0

setx OLLAMA_MODELS D:\models

setx OLLAMA_ORIGINS * 作用是设置Ollama服务的允许的源列表为所有源(*),这意味着Ollama服务将接受来自任何来源的请求

setx OLLAMA_HOST 0.0.0.0 作用是让Ollama服务监听所有可用的网络接口,从而允许外部网络访问。

setx OLLAMA_MODELS D:\models 作用是设置ollama下载模型的位置

设置完后需要重新启动一下ollama

DeepSeek

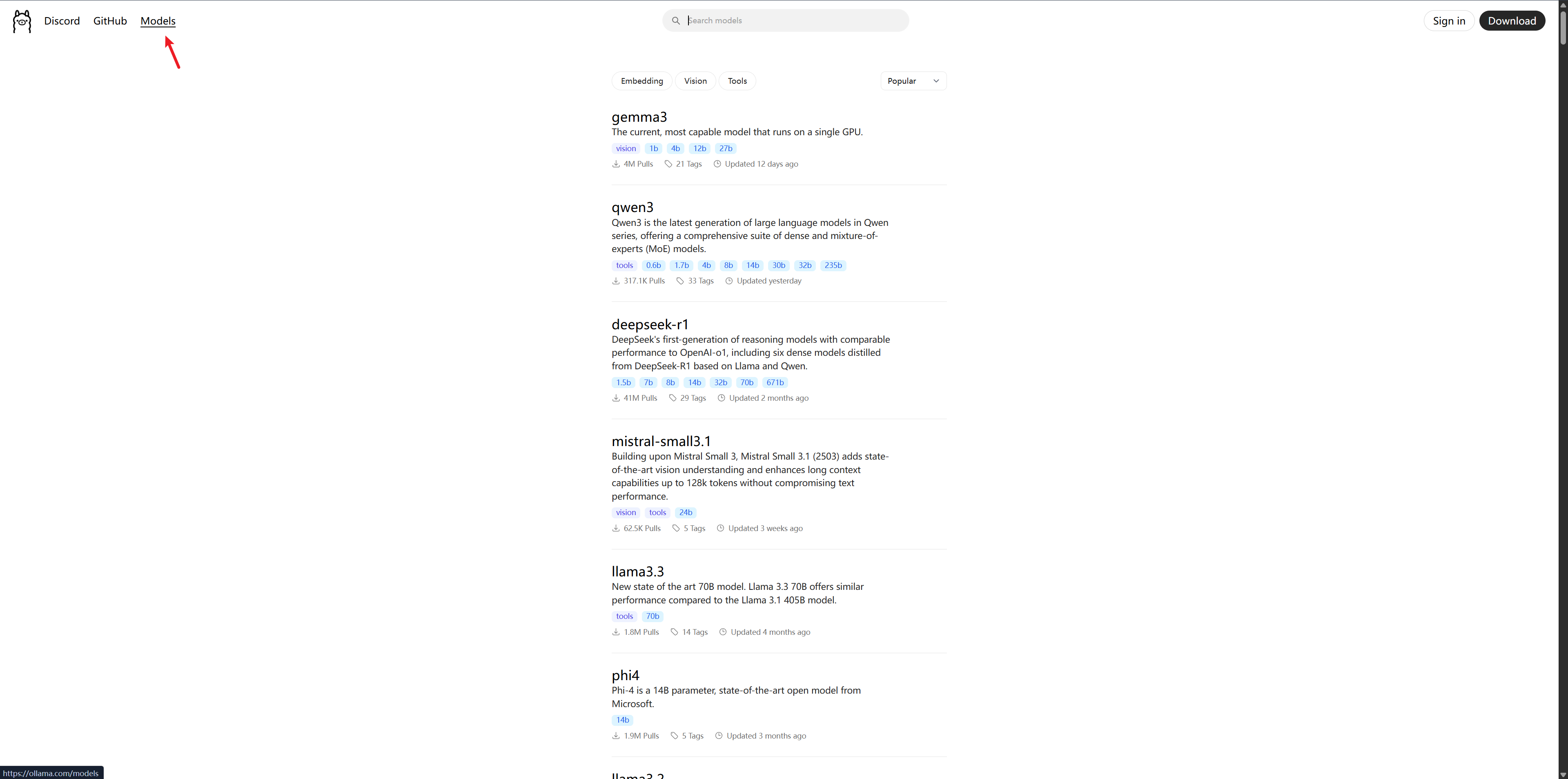

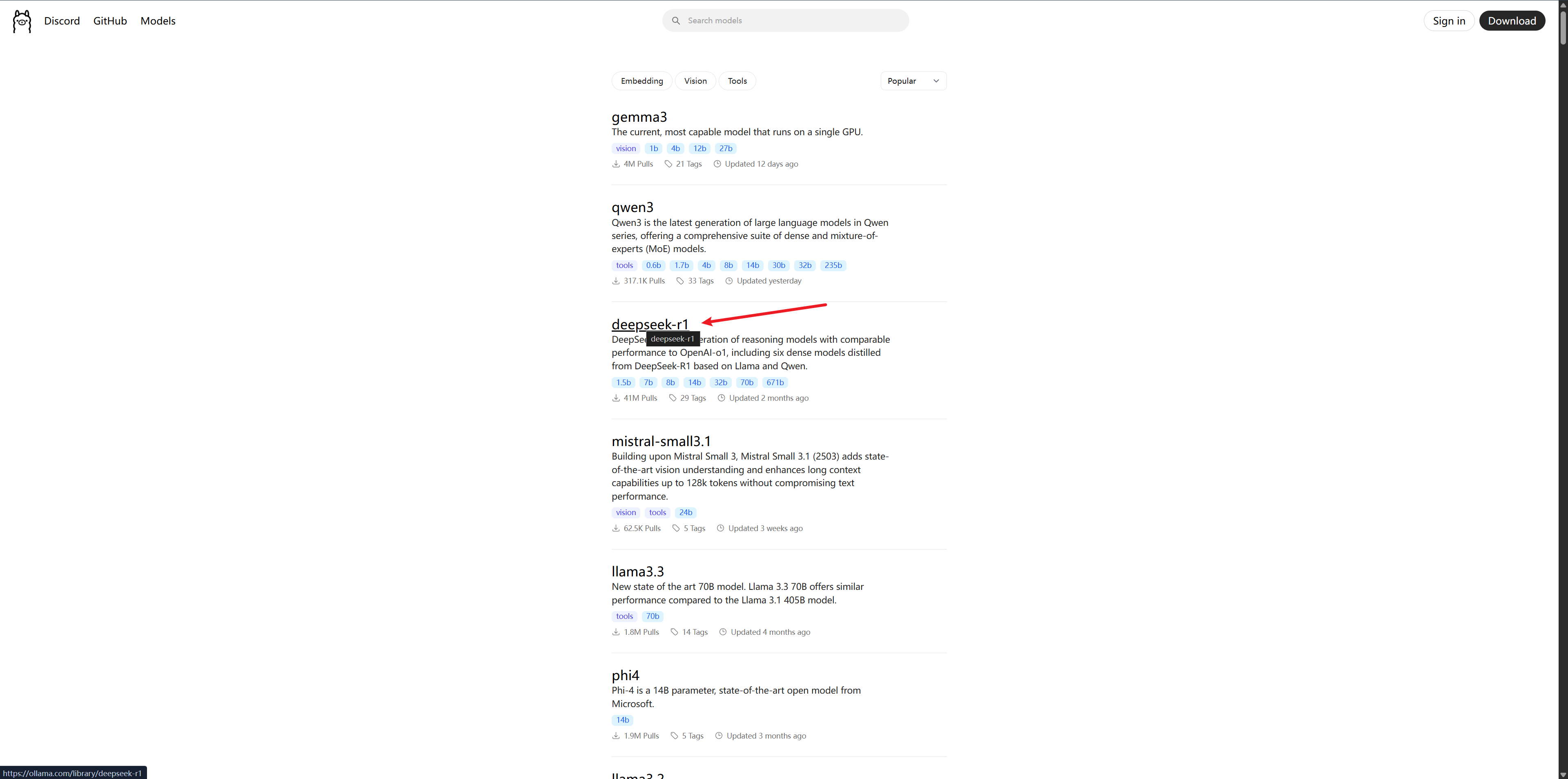

在ollama网站点击Model

会出现如图的很多模型选项,选择自己想体验的就行.这里推荐qwen3 或者deepseek-r1 个人体验下来还不错

文章以deepseek举例

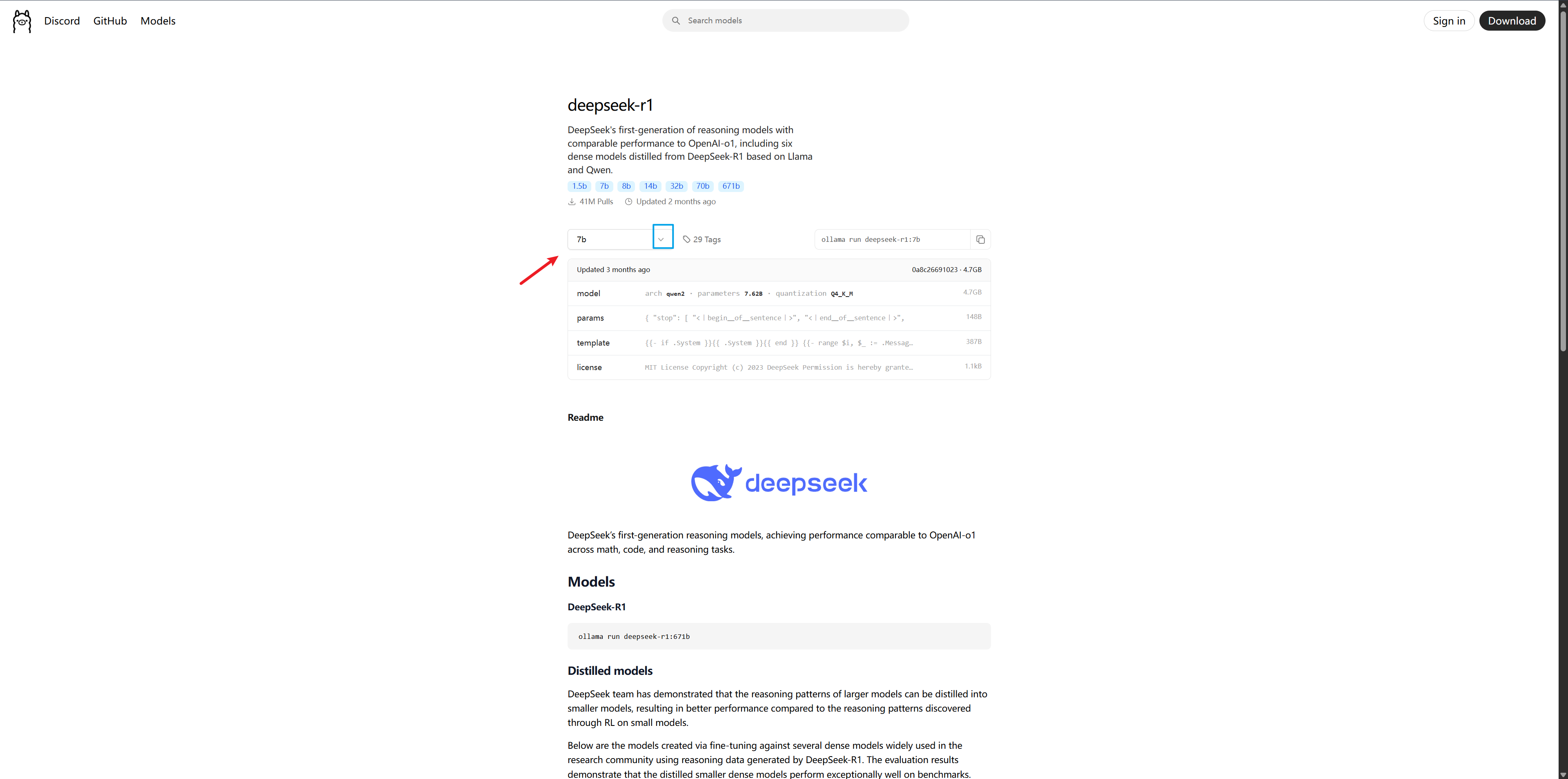

点击上图位置,查看详细大模型信息,会出现如下图所示的信息

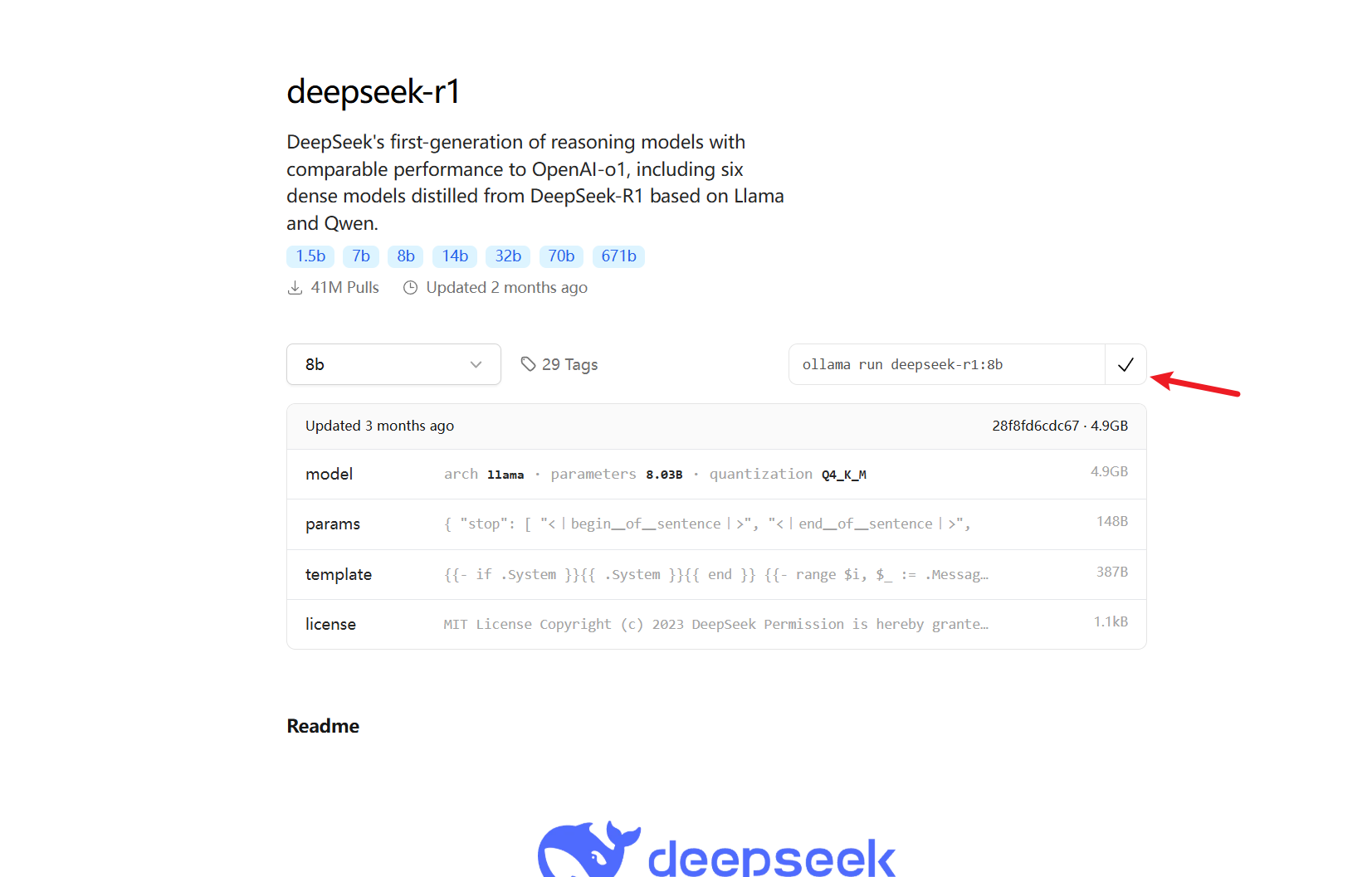

这里的模型默认是7b,可以根据自己的电脑配置切换模型版本;点击图中蓝色框起来的向下的箭头进行切换.

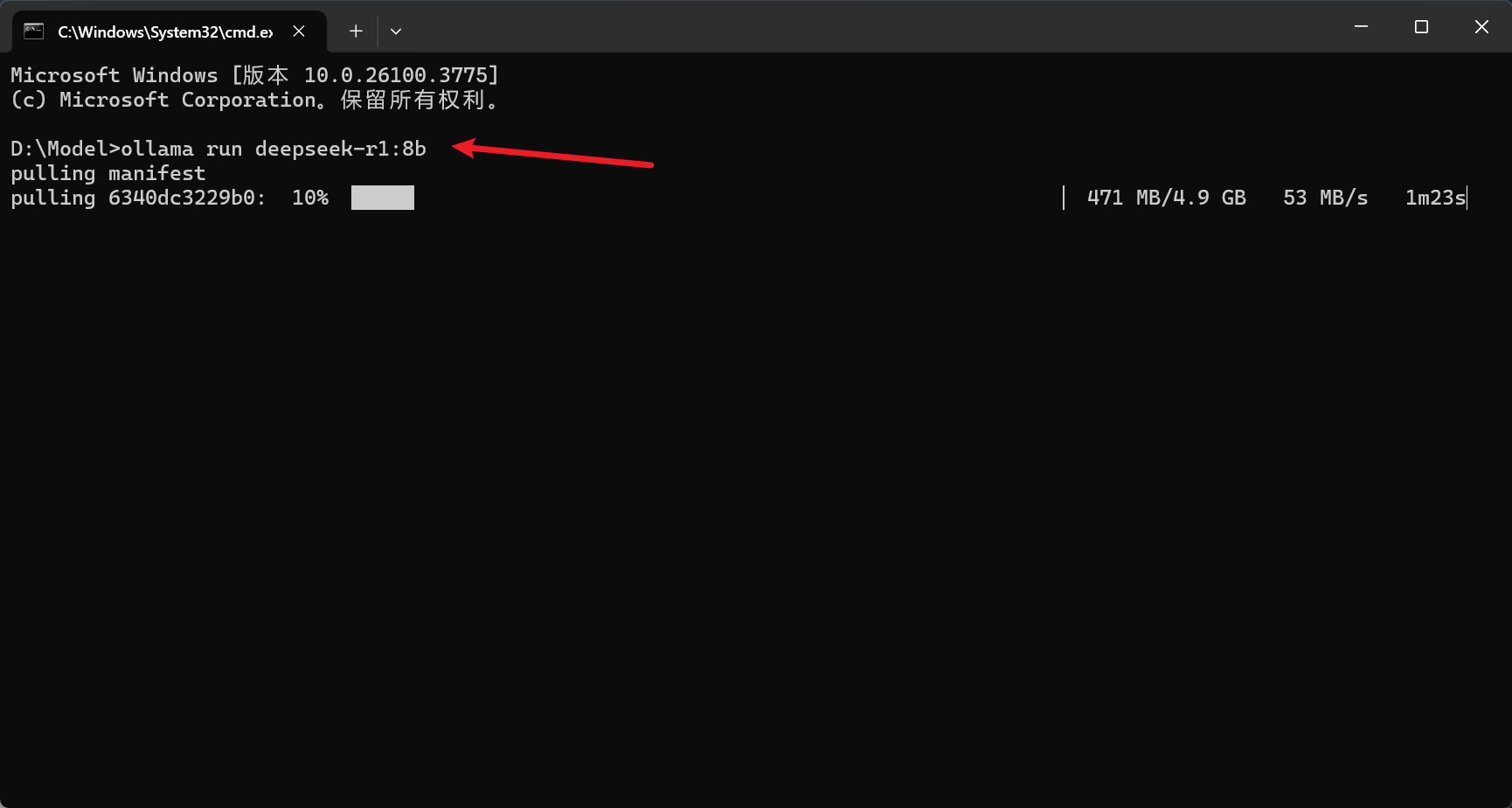

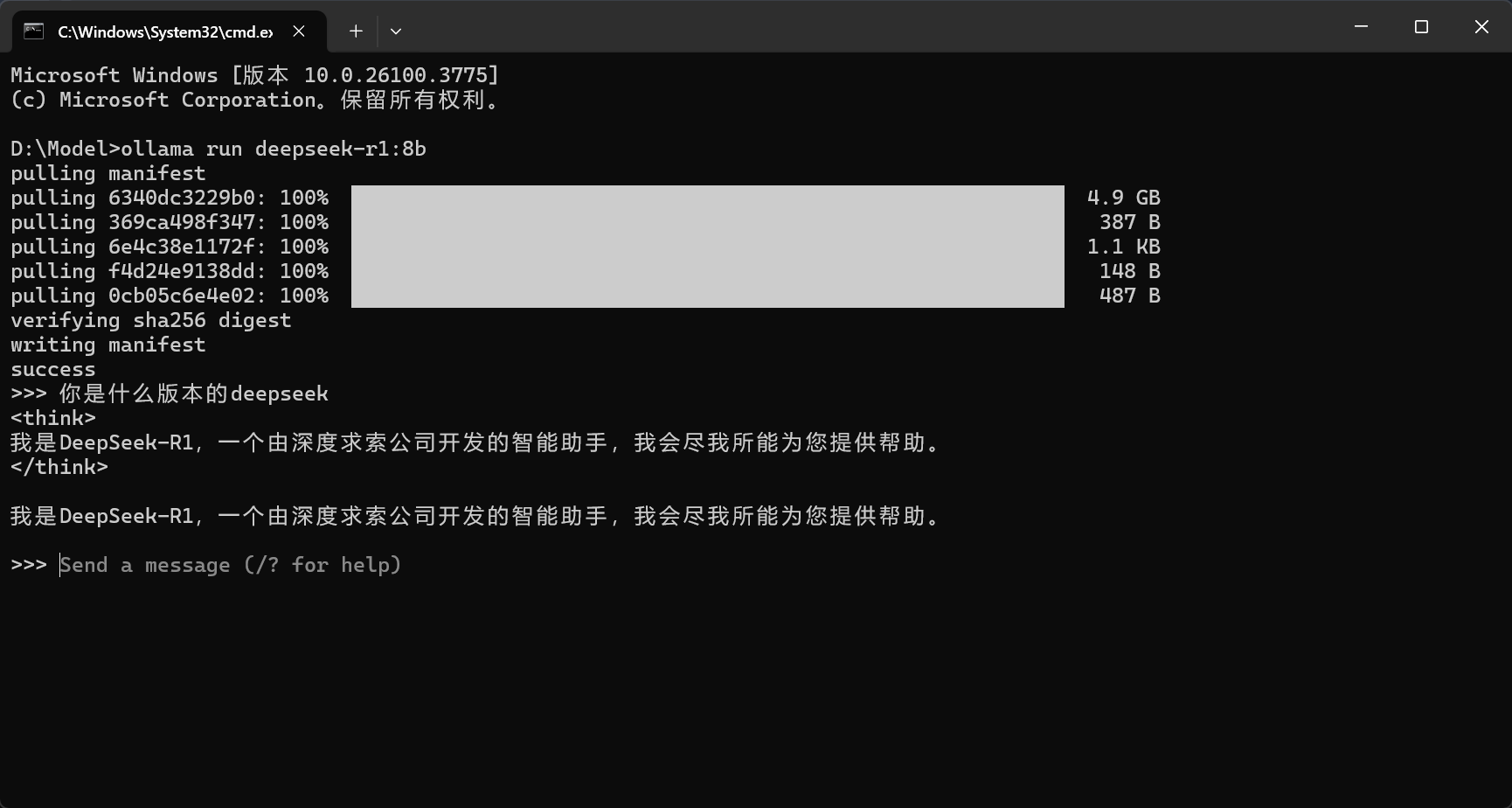

因为我电脑可以用8B,所以我直接复制了安装的代码,在控制台进行了安装

ollama pull deepseek-r1:8b # 只下载模型

ollama run deepseek-r1:8b # 下载+运行模型

等待下载完成,就可以直接对话了

控制台的对话很炫酷,但是确实不方便.可以再安装个ChatAtBox,将deepseek配置上去.

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)