【动手学习深度学习】9 循环神经网络(先验知识、RNN、GRU、LSTM etc.)

循环神经网络一些总结

·

目录

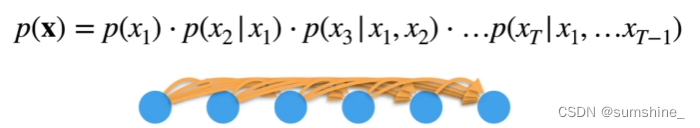

9.1 序列模型

方案A——马尔可夫假设:假设当前数据只与t个过去数据点相关

方案B——潜变量模型:引入潜变量ht来表示过去的信息

9.2 文本预处理

步骤:

1、将数据集读取搭配由多条文本行组成的列表中

2、每个文本序列被拆分成一个标记列表

3、构建一个字典,通常也叫做词汇表(vocabulary),用来将字符串类型的标记映射到从0开始的数字索引中

4、将每一条文本行转换成一个数字索引列表

9.3 语言模型

eg:Bert、GPT

1、使用计数来建模

2、N元语法 引入马尔可夫假设

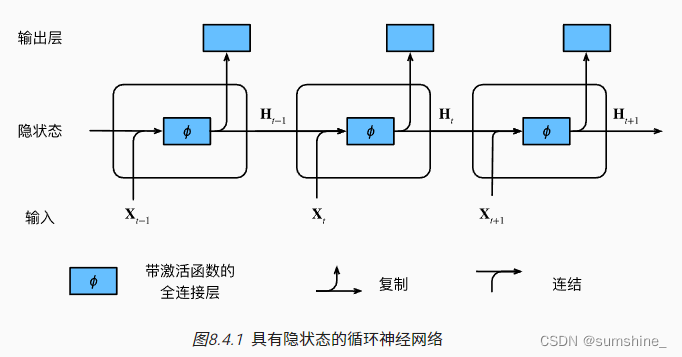

9.4 循环神经网络

-

对隐状态使用循环计算的神经网络称为循环神经网络(RNN)。

-

循环神经网络的隐状态可以捕获直到当前时间步序列的历史信息。

-

循环神经网络模型的参数数量不会随着时间步的增加而增加。

-

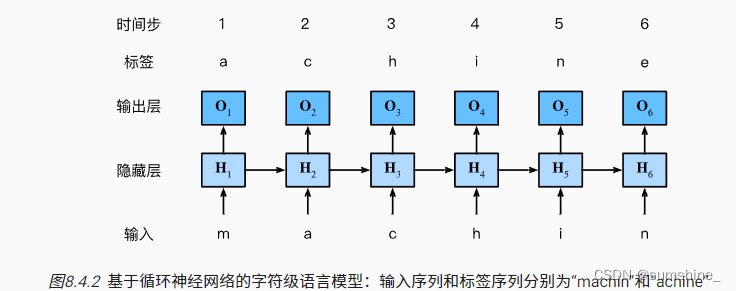

我们可以使用循环神经网络创建字符级语言模型。

-

我们可以使用困惑度来评价语言模型的质量。

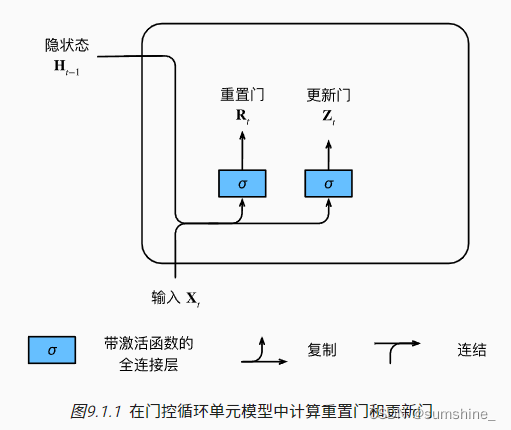

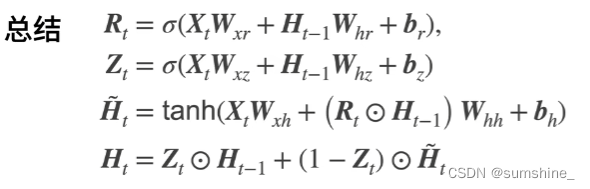

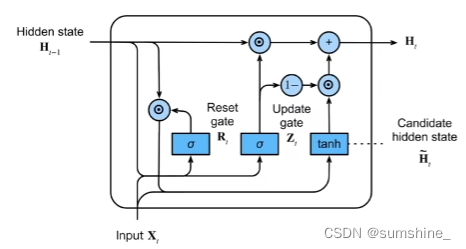

9.5 门控循环单元(GRU)

能关注的机制(更新门)

能遗忘的机制(重置门)

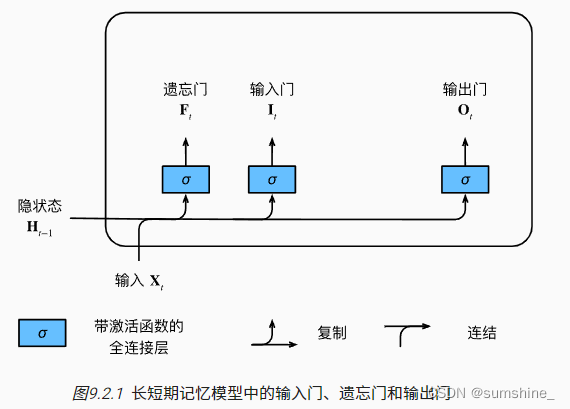

9.6 LSTM

忘记门:将值朝0减少

输入门:决定不是忽略掉输入数据

输出门:决定是不是使用隐状态

9.7 深层循环神经网络

使用多个隐藏层来获得更多的非线性性

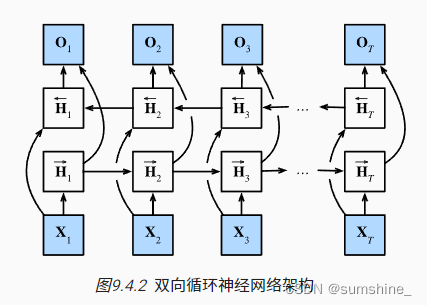

9.8 双向循环神经网络

取决于过去与未来的上下文

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)