Linux安装ollama和LLM模型

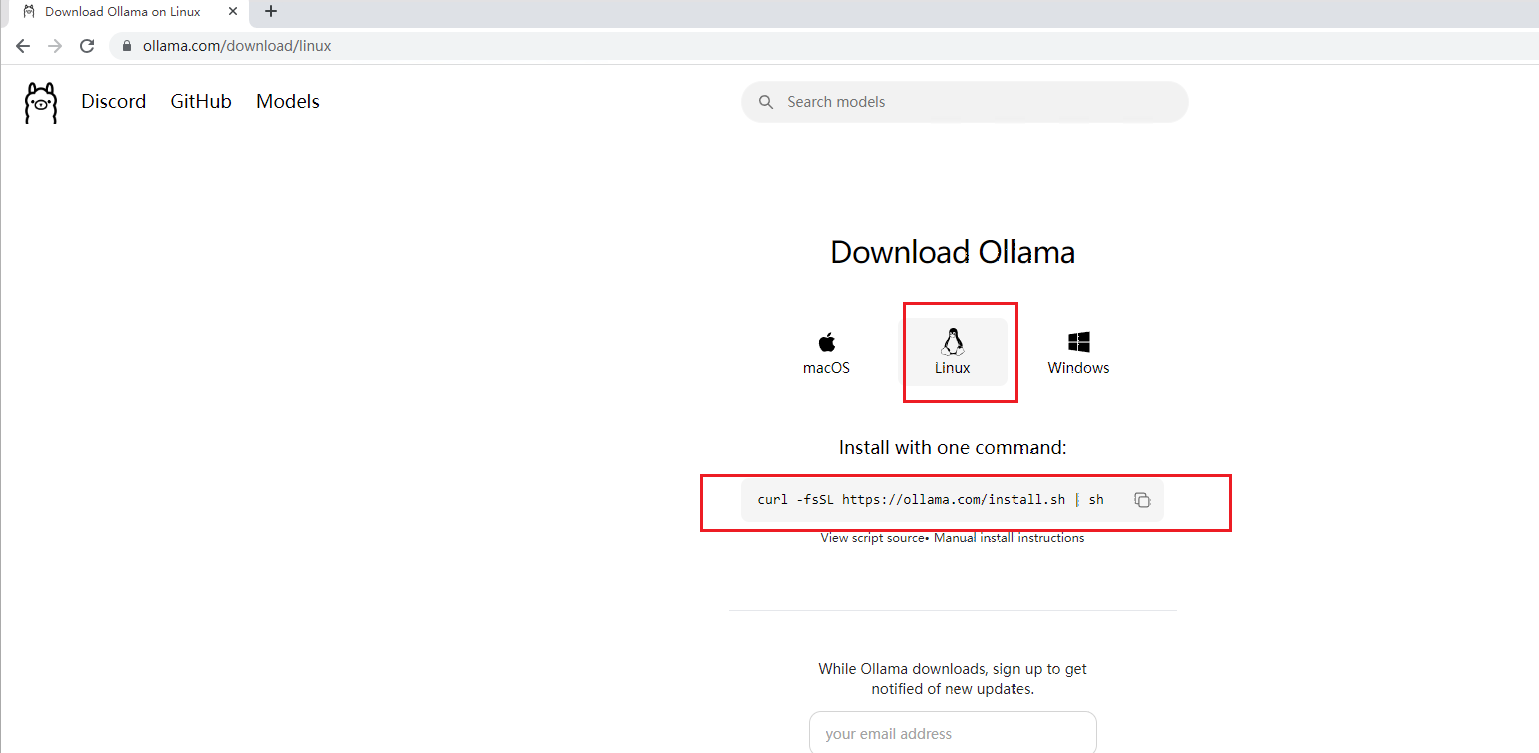

Ollama 是一个由 AI 研究实验室开发的开源人工智能模型,专注于为用户提供高效、灵活的自然语言处理能力。它基于先进的大规模语言模型架构,能够执行多种任务,包括文本生成、对话交互、问答系统等。Ollama 的设计旨在简化模型的使用和部署,支持多种语言和领域特定的应用场景。目前macOS和Windows都可直接通过页面下载,Linux需要通过命令下载。

Ollama

Ollama介绍

Ollama 是一个由 AI 研究实验室开发的开源人工智能模型,专注于为用户提供高效、灵活的自然语言处理能力。它基于先进的大规模语言模型架构,能够执行多种任务,包括文本生成、对话交互、问答系统等。Ollama 的设计旨在简化模型的使用和部署,支持多种语言和领域特定的应用场景。

地址:https://ollama.com/download/

目前macOS和Windows都可直接通过页面下载,Linux需要通过命令下载。

安装Ollama(两种方式)

1.使用快捷命令自动安装【不推荐】

以下命令是官网推荐的安装方式

curl -fsSL https://ollama.com/install.sh | sh

虽然该方式安装便捷,不过国内网络原因下载很慢,不推荐使用。

2.通过下载压缩包方式手动安装【推荐】

直接去github上下载,不过网络原因,也可能会下载不了。下载地址:

https://github.com/ollama/ollama/releases/latest/download/ollama-linux-amd64.tgz

如果上面的地址下载很慢,有个小技巧,可以使用国内的一些github加速平台,加速下载,比如下面这个:

虾壳 - GitHub下载加速网站 GitHub Proxy加速器

使用方法如下:

解压压缩包

使用以下命令将ollama-linux-amd64.tgz解压到某个目录下,解压到哪里取决于想把安装文件放到哪个目录中。

新建一个文件夹ollama

mkdir ollama

将ollama-linux-amd64.tgz解压到ollama文件夹中

sudo tar -C /usr/local/soft/ollama -xzf ollama-linux-amd64.tgz

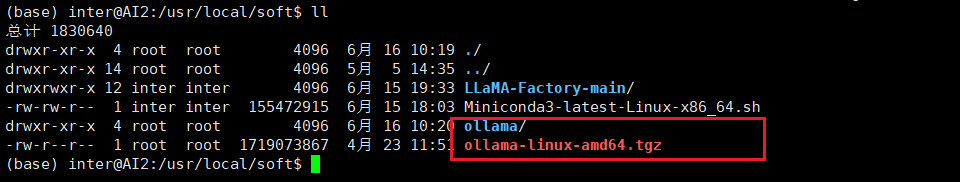

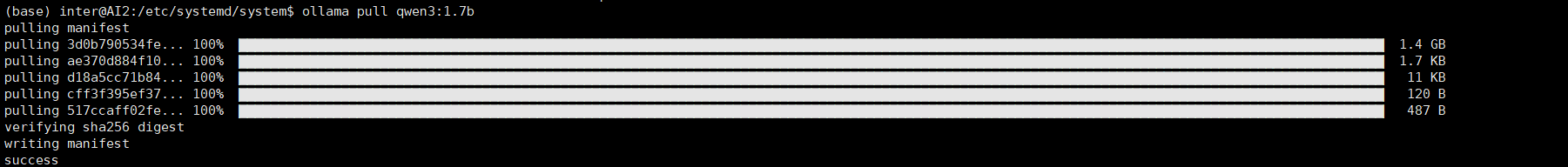

注意,新建的ollama文件夹,位于usr/local/soft文件夹中。文件夹目录结构如下:

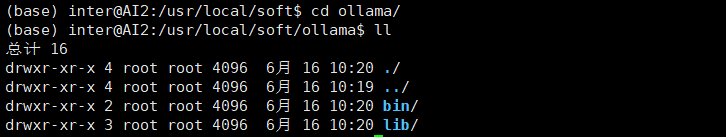

解压之后,文件内容:

将ollama添加为启动服务

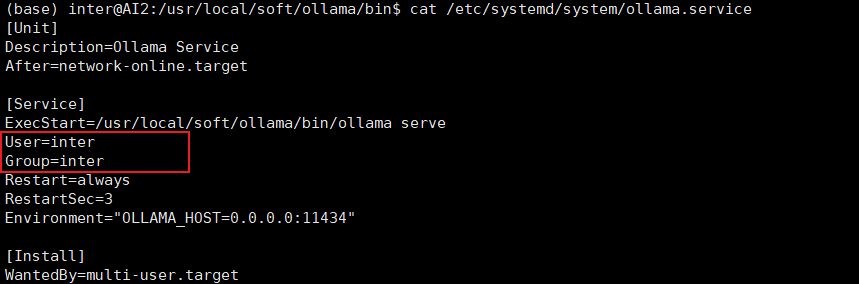

在/etc/systemd/system目录下添加个ollama.service

sudo vim /etc/systemd/system/ollama.service

输入i,添加内容如下(注意:这里User和Group填写你自己当前用户的):

通过id命令,查看用户和组信息

![]()

复制进去后,再输入:wq保存下,可以看到已成功创建了ollama.service

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/local/soft/ollama/bin/ollama serve

User=inter

Group=inter

Restart=always

RestartSec=3

Environment="OLLAMA_HOST=0.0.0.0:11434"

[Install]

WantedBy=multi-user.target注意要把user和group改成自己的信息:

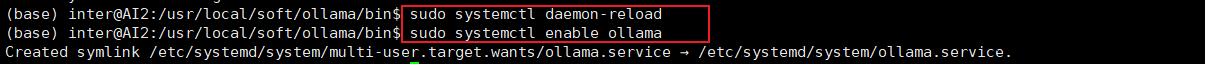

加载配置并创建Ollama软链接

输入以下命令加载ollama.service配置并创建软链接

sudo systemctl daemon-reload

sudo systemctl enable ollama

详细操作如下:

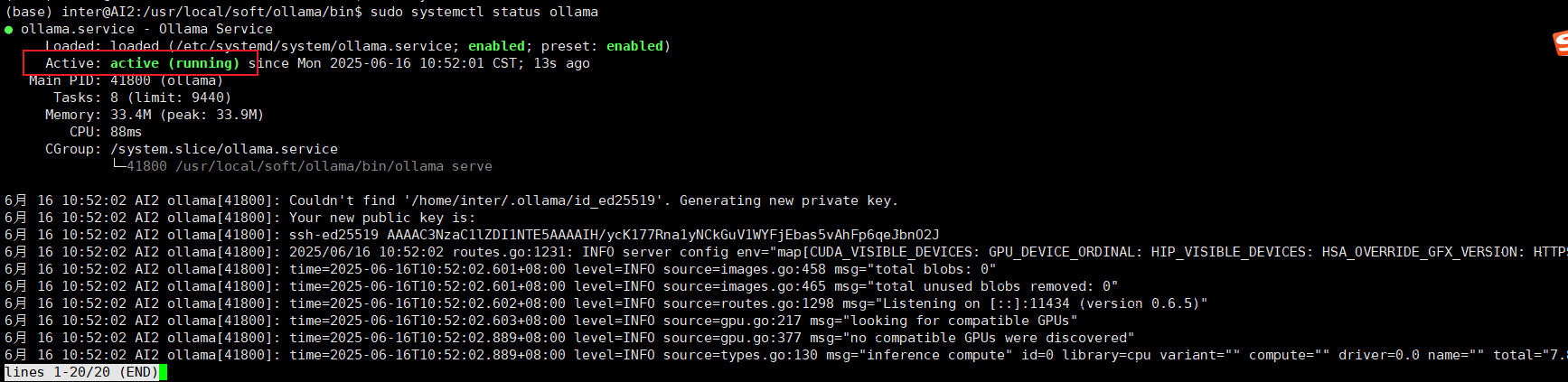

启动Ollama

输入以下命令启动ollama

sudo systemctl start ollama

查看Ollama启动状态

输入以下命令查看启动状态

sudo systemctl status ollama

ollama启动成功!

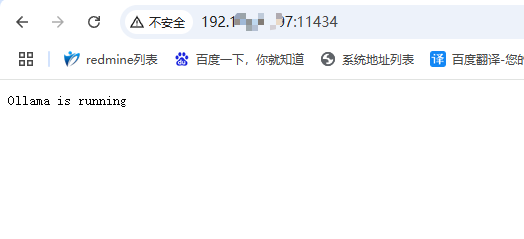

通过浏览器访问11434端口,可以看到返回信息:

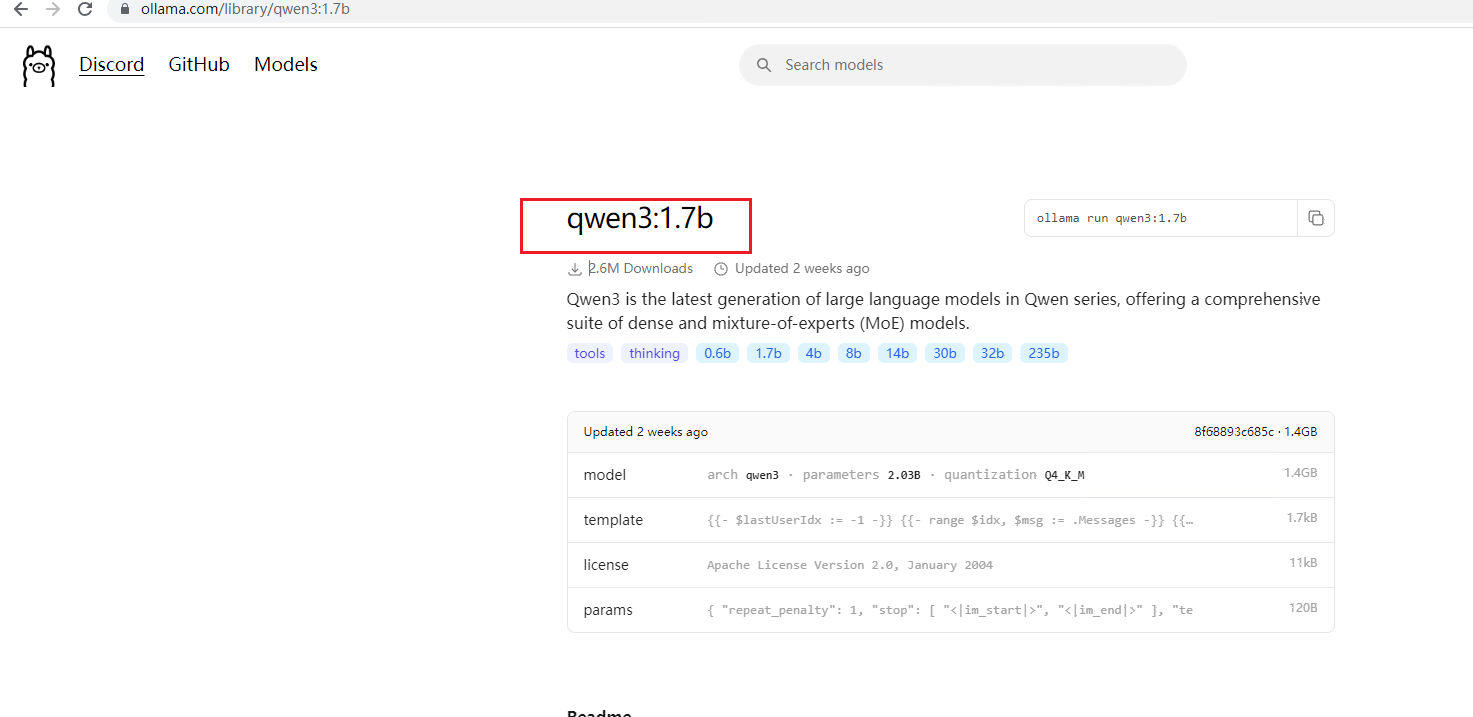

在ollama上安装LLM模型

查找模型

到ollama官网,找到想安装的模型,获取模型名称

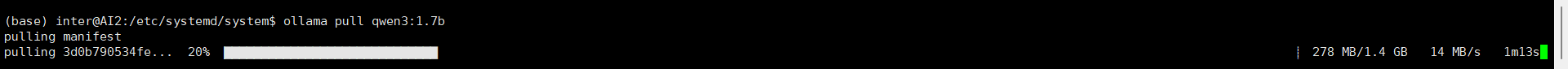

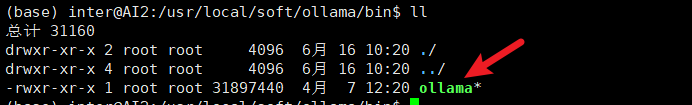

拉取模型

然后执行拉取模型的命令

ollama pull 模型名称

等待拉取完毕就可以了,拉取完成是这个样子的:

如果遇到找不到ollama的情况

![]()

配置一下环境变量,执行下面命令

echo 'export PATH="/usr/local/soft/ollama/bin:$PATH"' >> ~/.bashrc

source ~/.bashrc

注意:/usr/local/soft/ollama/bin是ollama解压后的bin目录,这个目录下有ollama

运行模型

使用命令运行模型

ollama run 模型名称

查询正在运行中的模型

ollama ps

ollama常用命令

查看已经下载的模型

ollama list

停止某个模型

ollama stop <model>

删除某个模型

ollama rm <model>

参考文章:

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)