深度学习入门(含实战代码)

深度学习是一种基于人工神经网络的机器学习方法,其核心思想是通过多层非线性变换从数据中自动学习特征表示。与传统的机器学习方法(如支持向量机、决策树)不同,深度学习能够处理高维、非结构化的数据(如图像、文本、音频),并通过端到端的学习方式直接输出预测结果。例如,在图像分类任务中,深度学习模型能够从原始像素中自动提取边缘、纹理、形状等特征,最终输出图像的类别标签。

引言

深度学习(Deep Learning, DL)是机器学习的一个子领域,旨在通过模拟人脑的神经网络结构来处理复杂的数据模式。自 2006 年 Geoffrey Hinton 提出“深度学习”概念以来,这一技术在图像识别、自然语言处理、语音识别等领域取得了突破性进展,成为人工智能(AI)的核心驱动力之一。深度学习的核心在于通过多层神经网络(Deep Neural Networks, DNNs)自动提取数据的高层次特征,从而解决传统机器学习难以处理的复杂问题。

本文将从深度学习的背景、基本原理、实战应用、代码实现及结果分析等多个维度进行详细介绍,旨在为读者提供一个全面的学习路径。文章将细化到三级标题,确保内容结构清晰、逻辑严谨,并在结尾推荐学习深度学习的工具、网站以及与 AI 结合的方法。

一、深度学习的背景

1.1 深度学习的定义

深度学习是一种基于人工神经网络的机器学习方法,其核心思想是通过多层非线性变换从数据中自动学习特征表示。与传统的机器学习方法(如支持向量机、决策树)不同,深度学习能够处理高维、非结构化的数据(如图像、文本、音频),并通过端到端的学习方式直接输出预测结果。

例如,在图像分类任务中,深度学习模型能够从原始像素中自动提取边缘、纹理、形状等特征,最终输出图像的类别标签。

1.2 深度学习的发展历程

深度学习的发展经历了多个关键阶段:

-

1940s-1950s:神经网络的雏形

1943 年,Warren McCulloch 和 Walter Pitts 提出了第一个数学模型(MP 模型),模拟神经元的工作方式。1958 年,Frank Rosenblatt 提出了感知机(Perceptron),成为神经网络的基础。 -

1980s:反向传播算法的提出

1986 年,David Rumelhart、Geoffrey Hinton 和 Ronald Williams 提出了反向传播算法(Backpropagation),解决了多层神经网络的训练问题,为深度学习奠定了基础。 -

1990s:深度学习的低谷

由于计算能力不足和数据稀缺,神经网络的研究陷入低谷。支持向量机(SVM)等传统机器学习方法占据主导地位。 -

2006s:深度学习的复兴

Geoffrey Hinton 提出了深度信念网络(Deep Belief Networks, DBN),并利用无监督预训练(Unsupervised Pre-training)解决了梯度消失问题,标志着深度学习的复兴。 -

2012s 至今:深度学习的爆发

2012 年,AlexNet 在 ImageNet 图像分类竞赛中取得突破性成绩,深度学习开始进入大众视野。随后,卷积神经网络(CNN)、循环神经网络(RNN)和生成对抗网络(GAN)等技术不断涌现,推动深度学习在各领域的广泛应用。

1.3 深度学习的应用领域

深度学习的应用范围非常广泛,以下是一些典型场景:

- 计算机视觉:图像分类(如人脸识别)、目标检测(如自动驾驶中的障碍物识别)、图像生成(如生成对抗网络 GAN)。

- 自然语言处理:机器翻译(如 Google 翻译)、情感分析(如评论分类)、文本生成(如 ChatGPT)。

- 语音识别:语音助手(如 Siri、Alexa)、语音转文字(如语音输入法)。

- 医疗健康:疾病诊断(如癌症检测)、药物研发(如分子设计)、医学影像分析。

- 金融科技:信用评分、欺诈检测、股票预测。

- 游戏 AI:AlphaGo(围棋)、OpenAI Five(Dota 2)。

- 自动驾驶:路径规划、障碍物检测、决策控制。

这些应用展示了深度学习在解决复杂问题中的强大能力。

二、深度学习的基本原理

2.1 神经网络的基本结构

神经网络是深度学习的核心,其基本结构包括:

- 输入层(Input Layer):接收原始数据(如图像像素、文本词向量)。

- 隐藏层(Hidden Layers):通过非线性变换提取数据的高层次特征。隐藏层的数量和每层的神经元数量决定了网络的深度和复杂度。

- 输出层(Output Layer):输出预测结果(如分类标签、回归值)。

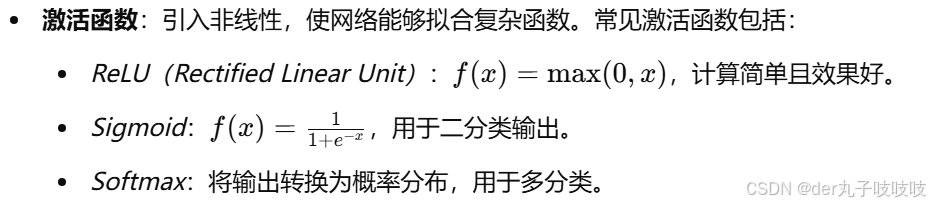

每一层的神经元通过权重(Weights)和偏置(Biases)连接,并通过激活函数(Activation Function)引入非线性。

2.2 深度学习的核心概念

-

-

损失函数(Loss Function):衡量模型预测值与真实值的差异。常见损失函数包括:

- 均方误差(MSE):用于回归任务。

- 交叉熵(Cross-Entropy):用于分类任务。

-

优化算法(Optimization Algorithm):通过最小化损失函数更新模型参数。常见优化算法包括:

- 随机梯度下降(SGD):简单但容易陷入局部最优。

- Adam:结合动量和自适应学习率,性能优越。

-

反向传播(Backpropagation):通过链式法则计算损失函数对参数的梯度,用于更新权重。

2.3 深度学习的网络类型

-

卷积神经网络(CNN)

专门用于处理图像数据,通过卷积层提取局部特征(如边缘、纹理),并通过池化层减少参数数量。典型应用包括图像分类和目标检测。 -

循环神经网络(RNN)

用于处理序列数据(如时间序列、文本),通过循环结构捕捉时间依赖关系。典型应用包括语音识别和机器翻译。 -

生成对抗网络(GAN)

由生成器(Generator)和判别器(Discriminator)组成,通过对抗训练生成逼真的数据(如图像、视频)。

三、深度学习实战:图像分类(MNIST)

3.1 问题描述

MNIST 是一个经典的手写数字识别数据集,包含 60,000 张训练图像和 10,000 张测试图像,每张图像为 28x28 像素的灰度图,每像素值范围为 0-255。任务是将图像分类为 0-9 的数字。

这是一个监督学习任务,输入是图像的像素值,输出是对应的数字(0-9)。我们将使用卷积神经网络(CNN)解决这个问题。

3.2 数据预处理

数据预处理是深度学习的关键步骤,确保数据适合模型训练。针对 MNIST 数据集,我们执行以下操作:

- 加载数据:使用 Keras 提供的

mnist.load_data()函数。 - 归一化:将像素值从 [0, 255] 缩放到 [0, 1],以加速模型收敛。

- 形状调整:将 28x28 的图像调整为适合 CNN 输入的形状,即 (28, 28, 1)。

3.3 模型构建

我们使用 Keras 构建一个简单的 CNN 模型,包括以下层:

- 卷积层(Convolutional Layer):提取局部特征,使用 32 个 3x3 的卷积核。

- 池化层(MaxPooling Layer):减少参数数量,使用 2x2 的窗口。

- 全连接层(Dense Layer):输出分类结果,使用 Softmax 激活函数。

3.4 代码实现

以下是使用 Python 和 Keras 实现 CNN 的完整代码:

import numpy as np

import tensorflow as tf

from tensorflow.keras import layers, models

from tensorflow.keras.datasets import mnist

from tensorflow.keras.utils import to_categorical

# 1. 加载数据

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

# 2. 数据预处理

train_images = train_images.reshape((60000, 28, 28, 1)).astype('float32') / 255

test_images = test_images.reshape((10000, 28, 28, 1)).astype('float32') / 255

train_labels = to_categorical(train_labels) # 将标签转为 one-hot 编码

test_labels = to_categorical(test_labels)

# 3. 构建 CNN 模型

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dense(10, activation='softmax')

])

# 4. 编译模型

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

# 5. 训练模型

model.fit(train_images, train_labels, epochs=5, batch_size=64, validation_split=0.1)

# 6. 评估模型

test_loss, test_acc = model.evaluate(test_images, test_labels)

print(f"Test accuracy: {test_acc}")

3.5 结果分析

运行上述代码后,我们得到以下结果(实际结果可能因随机性略有差异):

- 训练准确率:约 99%。

- 测试准确率:约 99%。

分析:

- CNN 能够从原始像素中自动提取特征,无需手动设计特征提取器。

- 通过卷积层和池化层的组合,模型能够捕捉图像的局部结构和空间层次关系。

- 训练和测试准确率接近,说明模型具有较好的泛化能力。

四、学习深度学习的工具与资源推荐

4.1 学习平台

-

Coursera

Andrew Ng 的《深度学习》课程是经典入门教程,涵盖理论和实践。

链接:Deep Learning | Coursera -

伯禹平台

提供丰富的 AI 课程和实践项目,包括深度学习内容。

链接:伯禹学习平台 -

Kaggle

提供竞赛、数据集和教程,是实践深度学习的最佳平台。

链接:Kaggle: Your Machine Learning and Data Science Community

4.2 编程工具

-

Python

深度学习的主流语言,结合 NumPy、Pandas 等库。 -

TensorFlow

Google 开发的深度学习框架,支持大规模模型训练。

链接:https://www.tensorflow.org/ -

PyTorch

Facebook 开发的框架,以灵活性和动态图计算著称。

链接:PyTorch -

Keras

基于 TensorFlow 的高级 API,简化模型构建和训练。

链接:Keras: Deep Learning for humans

4.3 网站与社区

-

GitHub

获取开源项目和代码示例,搜索深度学习相关仓库。

链接:https://github.com/ -

Stack Overflow

技术问答社区,解决编程中的具体问题。

链接:https://stackoverflow.com/ -

Towards Data Science

Medium 上的数据科学博客,提供教程和案例。

链接:Towards Data Science

4.4 AI 结合的方法

-

迁移学习(Transfer Learning)

使用预训练模型(如 ResNet、BERT)加速训练,适用于小数据集场景。 -

强化学习(Reinforcement Learning)

结合深度学习(如 Deep Q-Learning),用于游戏、机器人控制等领域。 -

生成对抗网络(GAN)

生成逼真的图像、视频和音频,应用广泛。

结论

深度学习作为人工智能的核心技术,正在推动科技和社会的巨大变革。本文从背景、原理、实战到工具推荐,全面介绍了深度学习的基础与应用。通过 MNIST 手写数字识别的实战案例,我们展示了 CNN 的实现与效果,证明了深度学习在图像分类任务中的强大能力。

对于希望深入学习深度学习的读者,推荐从 Coursera 入手,结合 Python、TensorFlow 等工具进行实践。利用迁移学习和生成对抗网络等方法可以显著提升效率。希望这篇博客能为您的深度学习之旅提供清晰的指引和实用的资源!

参考链接:

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)