告别服务器繁忙焦虑,国产云平台阿里云+DeepSeek可以解决你的问题

目前,迅易科技早已获得阿里云的资质,只要您通过迅易实现阿里云PAI部署DeepSeek,2000万Tokens满血版DeepSeek让您体验到爽,解锁国产最强AI DeepSeek的隐藏通道,告别服务器繁忙焦虑。在Model Gallery页面的模型列表中,单击找到并点击需要部署的模型卡片,例如“DeepSeek-R1-Distill-Qwen-7B”模型,进入模型详情页面。硬件成本高到离谱,部署

随着DeepSeek爆火,导致 “服务器繁忙”是大家频繁遇见的问题,官网挤不进去,本地部署设备成本高昂,难道我们就只能望 “模” 兴叹?不,今天小编就给大家带来逆天改命的解决方案!

首先解释一下,为什么不选择本地部署?硬件成本高到离谱,部署十分复杂,从安装 Ollama 到调试模型参数,小白直接被劝退,真心建议大家可以考虑上云部署!

作为企业数字化转型的关键伙伴,迅易科技的强大生态伙伴——微软云、阿里云等国内外主流厂商均已接入DeepSeek,上次给大家总结了全球主流云平台接入Deepseek的特点。最近,小编也帮大家体验了各种云上部署方式。目前,迅易科技可以帮您实现阿里云PAI部署DeepSeek,还有2000万Tokens满血版DeepSeek助您体验到爽,解锁国产最强AI DeepSeek的隐藏通道,告别服务器繁忙焦虑。(详细请看下文)

今天,首先给大家分享如何在阿里云PAI Model Gallery一键部署DeepSeek-V3、DeepSeek-R1。具体部署操作如下:

一、进入Model Gallery页面

登录PAI控制台,在顶部左上角根据实际情况选择地域。并在左侧导航栏选择工作空间列表,单击指定工作空间名称,进入对应工作空间内。最后在左侧导航栏选择快速开始>Model Gallery。

二、进入DeepSeek模型详情页

在Model Gallery页面的模型列表中,单击找到并点击需要部署的模型卡片,例如“DeepSeek-R1-Distill-Qwen-7B”模型,进入模型详情页面。

三、一键部署DeepSeek模型生成服务

单击右上角部署:目前DeepSeek-R1支持采用vLLM加速部署;DeepSeek-V3 支持vLLM加速部署以及Web应用部署;DeepSeek-R1蒸馏小模型支持采用BladeLLM(阿里云PAI自研高性能推理框架)和vLLM加速部署。选择部署方式和部署资源后,即可一键部署服务,生成一个PAI-EAS服务。

部署成功后,在服务页面可以点击“查看调用信息”获取调用的Endpoint和Token,想了解服务调用方式可以点击预训练模型链接,返回模型介绍页查看调用方式说明。

为了更高性价比地实现DeepSeek系列模型与现有业务的高效融合,本教程部署的模型为蒸馏过后的DeepSeek-R1-Distill-Qwen-7B。基于 DeepSeek-R1 的推理能力,通过蒸馏技术将推理模式迁移到较小的 Qwen 模型上,从而在保持高效性能的同时降低了计算成本。同时,阿里云PAI Model Gallery也提供 DeepSeek-R1、DeepSeek-V3原始模型的一键部署。

四、如何获得DeepSeek体验资格

目前,阿里云百炼在DeepSeek-V3、DeepSeek-R1满血版可享各100万免费Tokens,蒸馏版1元最高可享受200万tokens,即日起,所有用户可直接使用。

小编认为需要更高参数的企业用户,更高配置的云服务器阿里云人工智能平台PAI会更适合。只要通过迅易科技部署阿里云PAI,再额外赠送阿里云百炼 2000万Tokens 满血版DeepSeek体验额度。

同时,面对DeepSeek日益火爆的部署与拓展需求,迅易科技息基于与众多国内外主流云厂商紧密的合作伙伴关系,迅易科技向企业提供数字化服务,确保企业以快速本地化部署,并提供行业级AI应用开发解决方案。如果您想了解方案案例/产品资料信息,欢迎私聊小编。

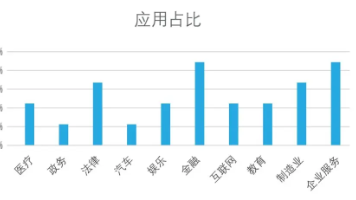

随着微软、阿里等巨头的加入,DeepSeek 开源生态已经形成了 “芯片 - 云平台 - 应用” 全链路。官方报告预测,2025 年将是 AI 应用落地元年,而云部署的低成本、高灵活性必将成为企业的首选。所以,大家赶紧跟上时代的步伐吧。

别再为本地部署掉头发了!无论是个人开发者还是企业,云平台 + DeepSeek 的组合才是性价比之王。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)