内涵:目标检测之DarkNet-DarkNet使用

目标检测-DarkNet使用引言1. DarkNet的安装2. Yolo的介绍2.1 与Focal Loss相比,性能领先2.2 以极低的代价实现速度与精度的trade-off2.3 产业界的广泛应用功能快捷键合理的创建标题,有助于目录的生成如何改变文本的样式插入链接与图片如何插入一段漂亮的代码片生成一个适合你的列表创建一个表格设定内容居中、居左、居右SmartyPants创建一个自定义列表如何创

目标检测-DarkNet使用

引言

该篇文章是目标检测专栏的第一篇文章,先从较为经典的DarkNet作为出发点。作为检测专栏的第一篇文章,本文的主要内容是DarkNet的应用,不会太涉及代码原理层面。后续会紧接着推出DarkNet核心代码解读与移植到Caffe&&Pytorch深度学习框架移植相关博文。

1. DarkNet的安装

DarkNet的安装相比Caffe来讲比较简单。由于篇幅限制和文章侧重点设计,在此不再赘述。具体可以参考DarkNet官网安装文档。若有任何问题,欢迎留言交流。

2 . Yolo的介绍

DarkNet的初接触者,可能会有这样的疑惑。DarkNet到底是像Caffe一样是一个深度学习框架,还是一个像AlexNet一样的卷积神经网络。答案是都是,看具体的使用场景。比如,我后续会推出的Yolov3从DarkNet移植到Caffe和Pytorch,此时DarkNet就是一种深度学习框架;在本文后续会提到的YOLOV3的改进主要在于多尺度训练和提出一种性能更优的主干网络DarkNet,此时它就指代一种CNN网络。但DarkNet作为深度学习框架的属性,只是YOLOV3作者为了实现自己的论文思想,重复造了下轮子,手撸了一个简易的深度学习框架,可以认为从出生起,就已经被淘汰,因为大部分应用都还是会将其移植到Caffe或这Pytorch来用。

总的来讲,Yolo的特点是实时且性能卓越。

On a Pascal Titan X it processes images at 30 FPS and has a mAP of

57.9% on COCO test-dev.

这样讲可能会有点抽象,可以从以下三个角度来直观的理解Yolo的强大之处。

2.1 与Focal Loss相比,性能领先

如图1所示,Yolov3-608相比RetinaNet-101-800(Focal Loss,关于Focal Loss请看我的这篇文章计划写,待写)在mAP几乎一样的情况下,快了近乎4倍。

2.2 以极低的代价实现速度与精度的trade-off

Moreover, you can easily tradeoff between speed and accuracy simply by

changing the size of the model, no retraining required!

如何理解无需重新训练,就可以实现速度和精度的tradeoff。可以通过官网的这句话来看到:

YOLOv3 uses a few tricks to improve training and increase performance,

including: multi-scale predictions, a better backbone classifier, and

more.

多尺度预测就意味着,可以通过随意调节前向网络的尺寸大小来改变网络的计算量,从而在一定程度上牺牲精度来提升速度。另一点,有趣的是,像诸如此类可以随意调节网络尺寸大小的网络,其网络名称也会以分辨率作为体现而不再以主干网络的层数来加以区分,eg 之前的可能诸如RetinaNet-50, RetinaNet-101,RetinaNet-101。

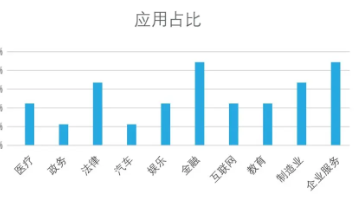

2.3 产业界的广泛应用

RT,目前产业界应该是应用最为广泛的一个检测网络。SSD和Faster Rcnn基本上已经无后续跟进。

3. 运行DarkNet

3.1 使用官方Pre-train模型检测目标

涉及到外网下载,速度可能会很慢,模型已经被我上传至百度云盘,需要的同学可以按照文章末尾的百度云盘链接1进行下载。

以上,在DarkNet安装成功之后以及获取官方预训练模型之后,就可以尝试先“画个框框”运行一把。

执行

./darknet detect cfg/yolov3.cfg yolov3.weights data/dog.jpg

注意:

4. 训练DarkNet

仅仅用官方的模型、网络和数据画个框,还不能算是入门。至少我们需要自己训练一把。第四节就是介绍使用公开数据集VOC训练模型的一个示例。重点理解训练所需要的标签格式。

4.1数据集准备

首先下载voc数据,可以从文章末尾的百度网盘链接2,进行下载:

解压缩包:

tar xf VOCtrainval_11-May-2012.tar

tar xf VOCtrainval_06-Nov-2007.tar

tar xf VOCtest_06-Nov-2007.tar

4.2标签制作

总的来讲,训练需要两个标签文件:

-

文件列表的txt

-

含有目标类别和坐标信息的txt

<object-class> <x> <y> <width> <height>

注: x, y, width, height是相对于原图坐标的归一化坐标,x和y是指目标坐标框中心。

这种通用的公开数据集,DarkNet已经提供了生成该格式文件的脚本工具"voc_label.py",获取并执行该脚本。

wget https://pjreddie.com/media/files/voc_label.py

python voc_label.py

VOC作为一个分类、检测和分割都适用的数据集,数据集的目录结构和txt比较多,对于检测任务来讲,我们只需要其中的部分信息即可。

它的输入有:

- ImageSets/Main/文件夹下的train.txt val.txt test.txt,用于提供训练和测试的文件路径列表。

- Annotations文件夹下的xml文件,用于提供生成目标类别和归一化坐标所需要的,图片宽高,检测坐标类别和坐标。

它的输出有:

- 与脚本同级目录下的5个txt

- labels文件夹下的类别-坐标txt

对于输出1,执行如下指令,将2007年份和2012年份,训练的文件列表进行合并

cat 2007_train.txt 2007_val.txt 2012_*.txt > train.txt

至此,训练图片文件列表和测试图片文件列表都已生成,分别为train.txt和2007_test.txt。该txt内部的内容大概是这样的情形:

对于输出2,每一个txt里面的类别和归一化坐标大概是这种情形:

至此数据集和标签已修改至训练框架所需格式

4.3 修改配置

修改数据配置文件:cfg/voc.data,将数据路径修改至自己的数据路径

classes= 20

train = /home/zht/data/train.txt

valid = /home/zht/data/2007_test.txt

names = data/voc.names

backup = backup

4.4 训练

开始训练

./darknet detector train cfg/voc.data cfg/yolov3-voc.cfg darknet53.conv.74

坑:在训练之前,先将yolov3-voc.cfg中的batchsize修改为训练模式,否则训练打印会全是nan。

训练log:

5. 百度云盘资源

1.预训练模型

链接:https://pan.baidu.com/s/1oK-E56TE5LOxZCiL7sK1JQ

提取码:x05j

2.VOC数据集

链接:https://pan.baidu.com/s/1oK-E56TE5LOxZCiL7sK1JQ

提取码:x05j

6. 参考

1. DarkNet官网

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)