循环神经网络

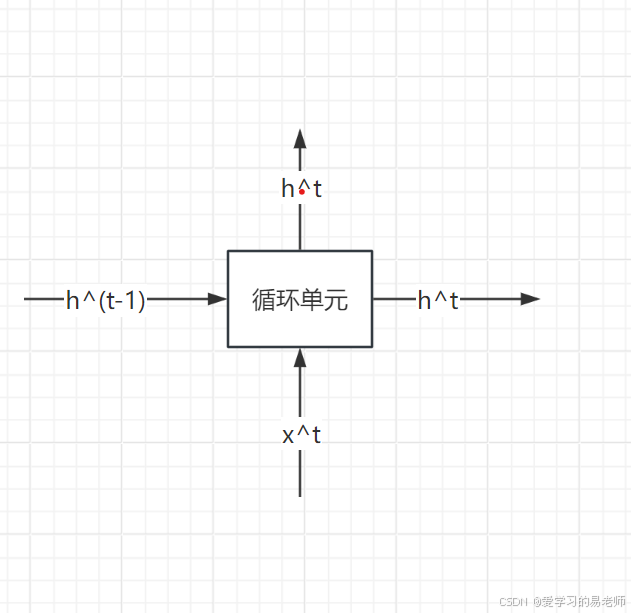

为了更形式化地理解RNN,我们可以通过公式来定义它。假设我们有一个序列输入,其中x^t表示时刻t的输入向量。初始状态:通常,我们会定义一个初始隐藏状态h^0,它可以是一个零向量或根据任务需要初始化的其他值。状态更新:对于每一个时间步t,循环单元的状态h^t由当前输入x^t和前一个时间步的隐藏状态h^(t-1)共同决定。这一更新过程通过一个循环体函数ghtgxtht−1htgxtht−1其中,g。

循环神经网络

在深度学习的广阔天地中,循环神经网络(Recurrent Neural Networks, RNNs)以其独特的时间建模能力脱颖而出,成为处理序列数据的利器。不同于传统的前馈神经网络,RNNs的核心魅力在于其“循环”机制,这一机制赋予了网络对时间序列数据的记忆与预测能力。今天,我们就来深入剖析RNNs,特别是它的基本组成单元——循环单元,以及如何通过数学公式来定义这一模型。

时间上的循环概念

RNN的“循环”并非指网络结构在空间上的重复,而是指在网络处理序列数据时,信息在时间维度上的传递与复用。想象一下,当我们阅读一篇文章或聆听一段音乐时,我们的理解是基于前文的积累,逐步构建起来的。RNN正是模拟了这种基于历史信息的处理方式,使得网络能够“记住”之前的信息,并将其应用于当前及未来的预测中。

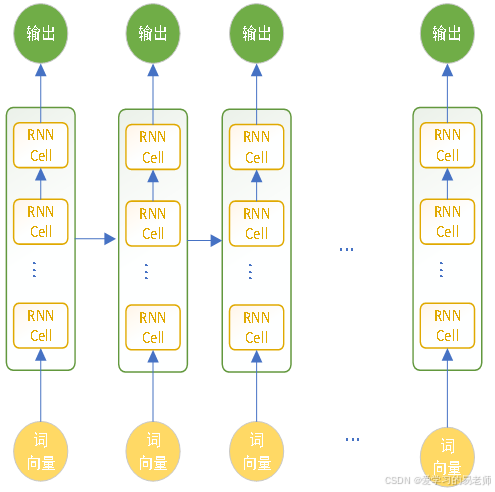

循环单元:构建RNN的基石

在RNN的架构中,循环单元是最为基础的组件。每个循环单元接收当前时刻的输入和上一时刻的隐藏状态,通过一系列计算后,输出当前时刻的隐藏状态和(或)输出值。这些循环单元在时间轴上依次排列,前一个单元的输出成为后一个单元的输入,从而形成了一个在时间维度上展开的链式结构。

- 简单RNN单元:通常使用一个线性层和一个激活函数(如tanh或ReLU)来更新隐藏状态。

- LSTM单元:引入了三个门(遗忘门、输入门和输出门)以及一个细胞状态,以更精细地控制信息的流动和存储。

- GRU单元:是LSTM的一个简化版本,它合并了某些门并简化了结构,同时保持了LSTM的大部分性能优势。

在RNNs中,循环单元在时间轴上依次展开,形成一个链式结构。每个时间步都有一个对应的循环单元,它们共享相同的参数(权重和偏置),这使得网络能够处理任意长度的序

时间步(Time Step)

时间步是处理序列数据时的一个基本概念,它代表了序列中的一个特定位置或时刻。可以把它看作时刻。

数学定义:揭开RNN的神秘面纱

为了更形式化地理解RNN,我们可以通过公式来定义它。假设我们有一个序列输入x = (x^0, x^1, x^2, ..., x^T),其中x^t表示时刻t的输入向量。RNN的状态更新和输出可以通过以下公式描述:

-

初始状态:通常,我们会定义一个初始隐藏状态

h^0,它可以是一个零向量或根据任务需要初始化的其他值。 -

状态更新:对于每一个时间步

t,循环单元的状态h^t由当前输入x^t和前一个时间步的隐藏状态h^(t-1)共同决定。这一更新过程通过一个循环体函数g实现,即:

ht=g(xt,ht−1)h^t= g(x^t, h^{t-1})ht=g(xt,ht−1)

其中,g通常是一个非线性函数,比如LSTM(长短期记忆网络)或GRU(门控循环单元)中的复杂操作。

-

输出生成:在每个时间步

t,可以根据隐藏状态h^t计算输出y^t。这通过一个输出函数f实现,即:

yt=f(ht)y^t = f(h^t)yt=f(ht)f可以是简单的线性变换后跟一个激活函数,或者是更复杂的结构,取决于具体任务。 -

整体表示:综合上述步骤,RNN的整体功能可以表示为从输入序列

x到输出序列y = (y^0, y^1, ..., y^T)的映射,其中每一步都涉及状态更新和输出生成。 注意每一个循环单元都是在不同的时刻,千问不要理解成他们在同一个空间。循环单元只有一个。

注意每一个循环单元都是在不同的时刻,千问不要理解成他们在同一个空间。循环单元只有一个。

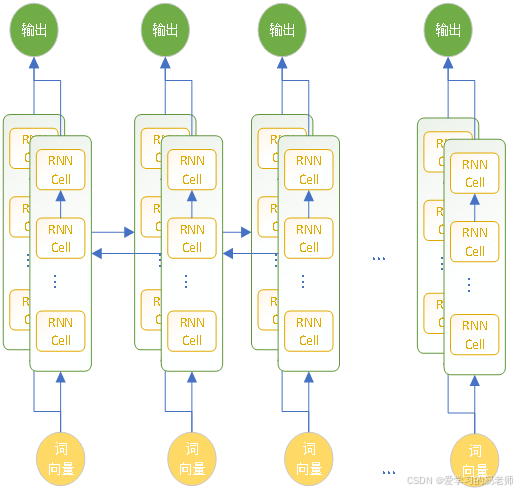

这里也是一样的循环单元只有一个,但是从正向循环后又向反向循环。

实践

以下为错误代码,请你查询资料调整,使之正常运行。

import paddle

import paddle.nn as nn

import paddle.optimizer as optim

import paddle.vision.transforms as T

import numpy as np

# 超参数

input_size = 100 # 输入的维度

embedding_dim = 50 # 词嵌入的维度

hidden_size = 50 # 隐藏层的维度

num_layers = 1 # RNN的层数

num_classes = 2 # 类别数量

num_epochs = 5 # 训练的轮数

batch_size = 16 # 批次大小

learning_rate = 0.001 # 学习率

# 简单的数据集(假设已经有预处理好的数据)

# 这里的X是输入数据,Y是标签

X = np.random.rand(1000, 10, input_size).astype('int64') # 样本数, 序列长度, 输入维度

Y = np.random.randint(0, num_classes, size=(1000,)).astype('int64')

# 创建数据集和数据加载器

dataset = paddle.io.TensorDataset((paddle.to_tensor(X), paddle.to_tensor(Y)))

train_loader = paddle.io.DataLoader(dataset, batch_size=batch_size, shuffle=True)

# 定义RNN模型

class RNNModel(nn.Layer):

def __init__(self, input_size, embedding_dim, hidden_size, num_layers, num_classes):

super(RNNModel, self).__init__()

self.embedding = nn.Embedding(input_size, embedding_dim)

self.rnn = nn.SimpleRNN(embedding_dim, hidden_size, num_layers=num_layers, time_major=True)

self.fc = nn.Linear(hidden_size, num_classes)

def forward(self, x):

x = self.embedding(x)

x, _ = self.rnn(x)

x = x[:, -1, :] # 取最后一个时间步的输出

x = self.fc(x)

return x

# 初始化模型和优化器

model = RNNModel(input_size, embedding_dim, hidden_size, num_layers, num_classes)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(parameters=model.parameters(), learning_rate=learning_rate)

# 训练模型

for epoch in range(num_epochs):

for batch_id, (data, labels) in enumerate(train_loader()):

outputs = model(data)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

optimizer.clear_grad()

if batch_id % 100 == 0:

print(f'Epoch [{epoch+1}/{num_epochs}], Batch [{batch_id}], Loss: {loss.numpy()}')

print('训练完成!')

正确答案:https://nextcloud.swjtuhc.top:1443/s/MWTnWMjyeacRqBA

问题

1.循环神经网络的有几个输入,几个输出,分别是什么?

2.循环神经网络的输入是一个序列吗?

3.循环神经网络在处理序列中每一个时间步的时候,其参数不变?

4.循环是指时间上的循环?

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)