deepseek离线本地化部署

下载完成后,双击安装包文件,按照安装向导的提示进行安装。默认安装路径为 C:\Users\<用户名>\AppData\Local\Programs\Ollama,如果需要更改安装路径,可以在安装过程中选择自定义安装目录。安装完成后,按下 Win+R 键,输入 CMD 并回车,打开命令提示符。在命令提示符中输入 ollama -v,如果显示 Ollama 的版本号(如 0.5.7),则说明安装成功。

下载 Ollama 安装包

访问 Ollama 官网:Ollama

安装 Ollama

下载完成后,双击安装包文件,按照安装向导的提示进行安装。

默认安装路径为 C:\Users\<用户名>\AppData\Local\Programs\Ollama,如果需要更改安装路径,可以在安装过程中选择自定义安装目录。

安装验证

安装完成后,按下 Win+R 键,输入 CMD 并回车,打开命令提示符。在命令提示符中输入 ollama -v,如果显示 Ollama 的版本号(如 0.5.7),则说明安装成功。

模型安装

进入ollama官网下载模型

选择适配你电脑的模型。参考下方表格

|

模型名称 |

参数量 |

原始显存需求 |

4bit量化显存需求 |

性能特点 |

|

DeepSeek-R1-671B |

671B |

1400GB |

- |

全方位高性能 |

|

DeepSeek-R1-Distill-Llama-70B |

70B |

140GB |

48GB |

推理能力强,通用性能较好 |

|

DeepSeek-R1-Distill-Qwen-32B |

32B |

64GB |

22GB |

推理能力优秀,通用性能中等 |

|

DeepSeek-R1-Distill-Qwen-14B |

14B |

28GB |

16GB |

推理能力较强,通用性能较弱 |

|

DeepSeek-R1-Distill-Qwen-7B |

7B |

14GB |

8GB |

适合低显存设备,性能有限 |

下载模型

在模型页面中,点击右侧的 “Run” 按钮,复制生成的命令

回到命令提示符,粘贴刚才复制的命令并回车,Ollama 将开始下载并安装所选模型。

安装成功:

安装完成后按Enter,进入测试阶段,发送一些指令问题,检测是否安装成功。

到这一步我们以及完成deepseek本地化部署了。

接下来我们加入Web UI进行操作简化处理。

前端交互

在Web UI文件里面

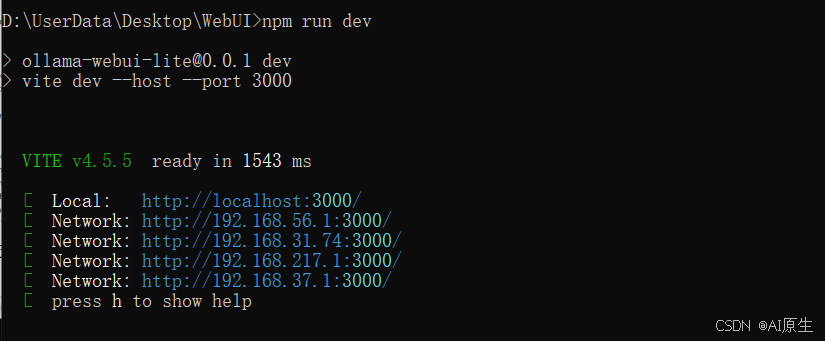

输入cmd进入终端,输入npm run dev启动界面

在本地浏览器输入启动后端ip地址和端口,进行前端交互页面。

选择我们所部署的deepseek模型

进行测试

模块拓展

如果想在同一个局域网里面使用,我们进行以下修改。

进入WebUI\src\lib\constants.ts文件里面,将ip地址改为我们的局域网地址

通过ipconfig进行查看

通过局域网ip进行登录,访问成功。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)