Docker容器本地私有化部署DeepSeek-R1大模型--基于国产操作系统

Docker容器本地私有化部署DeepSeek-R1大模型--基于国产操作系统

⚠申明: 未经许可,禁止以任何形式转载,若要引用,请标注链接地址。 全文共计3726字,阅读大概需要10分钟

🌈更多学习内容, 欢迎👏关注👀【文末】我的个人微信公众号:不懂开发的程序猿❗❗❗知识付费,🈲止白嫖,有需要请后台私信或【文末】个人微信公众号联系我

Docker容器本地私有化部署DeepSeek--基于国产操作系统

0.引言

2025年过年前后这段时间,深度求索公司开源的deepseek大语言模型屡次登顶热搜。公司领导过年期间发消息说,想要打造本地私有化的企业级知识库,因此根据现有工具链,在国产自研服务器(麒麟920操作系统,海思处理器arm64架构)搭建deepseek。

1. 启动Ollama

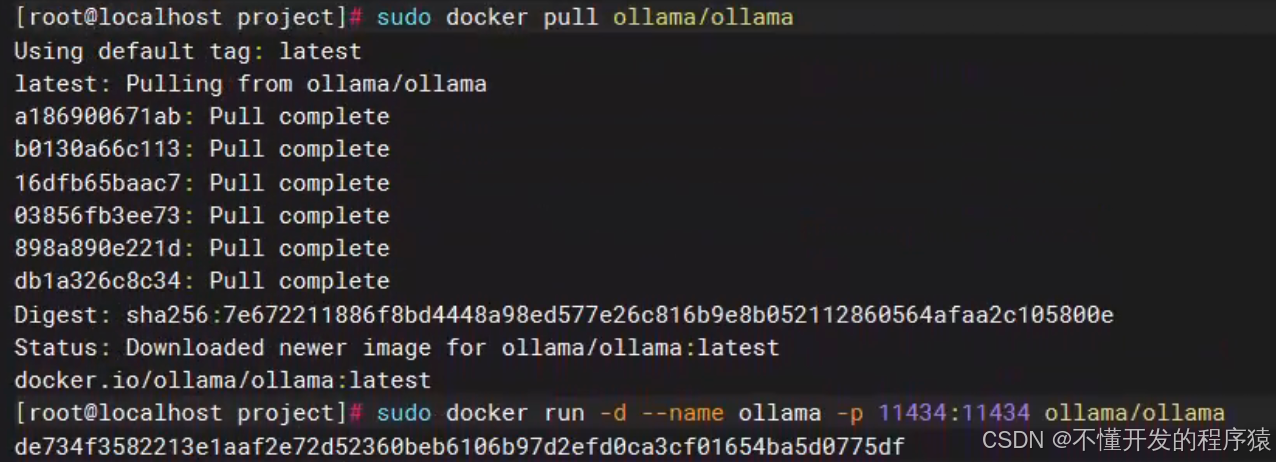

1 拉取 Ollama Docker 镜像:

sudo docker pull ollama/ollama

2 运行 Ollama 容器:

sudo docker run -d --name ollama -p 11434:11434 ollama/ollama

3 验证 Ollama 服务:

sudo docker logs ollama

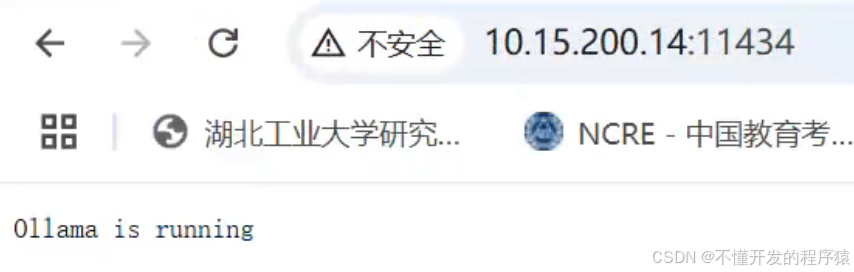

如何访问 Ollama 服务

由于 Ollama 服务在 Docker 容器中运行,您可以通过以下方式访问它:

1 本地访问:

◦ 如果您在同一台机器上运行 Ollama 容器,可以通过http://127.0.0.1:11434 访问 Ollama 服务。

◦ 如果您使用的是浏览器,直接在地址栏输入 http://localhost:11434。

2 远程访问:

◦ 如果您需要从其他机器访问 Ollama 服务,您需要确保宿主机的防火墙允许外部访问 11434 端口。

◦ 使用宿主机的 IP 地址(例如 http://<宿主机IP>:11434)来访问 Ollama 服务。

2. 运行deepseek-r1:8b大模型

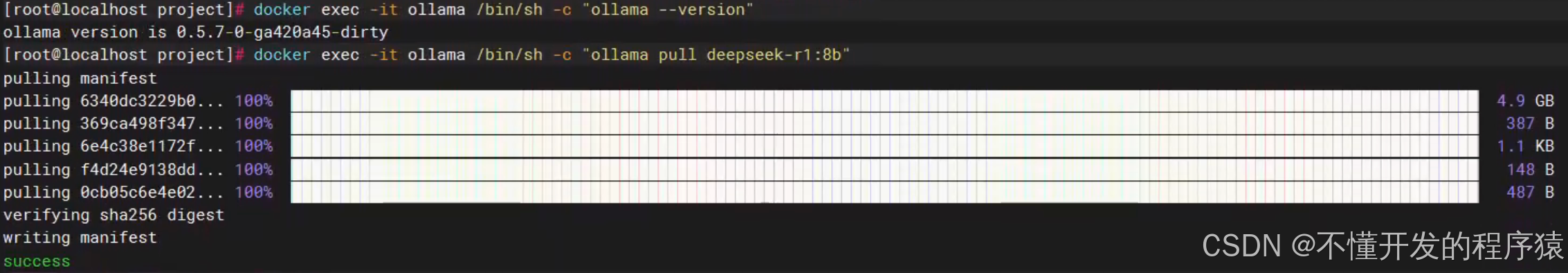

在 Docker 容器中运行 Ollama 时,您可以通过以下命令查看 Ollama 的版本:

docker exec -it ollama /bin/sh -c "ollama --version"

这将进入 Ollama 容器并执行 ollama --version 命令,显示 Ollama 的版本信息

运行大模型 ollama run deepseek-r1:8b

- 拉取模型

在运行模型之前,您需要先拉取模型。执行以下命令来下载 deepseek-r1:8b 模型:

docker exec -it ollama /bin/sh -c "ollama pull deepseek-r1:1.5b"

这将从 Ollama 的模型库中下载 deepseek-r1:8b 模型

- 运行模型

下载完成后,您可以使用以下命令运行模型:

docker exec -it ollama /bin/sh -c "ollama run deepseek-r1:1.5b"

docker exec -it ollama /bin/sh -c "ollama stop deepseek-r1:1.5b"

运行模型后,您可以在终端与模型进行交互,输入您的问题或任务,模型将提供相应的响应。

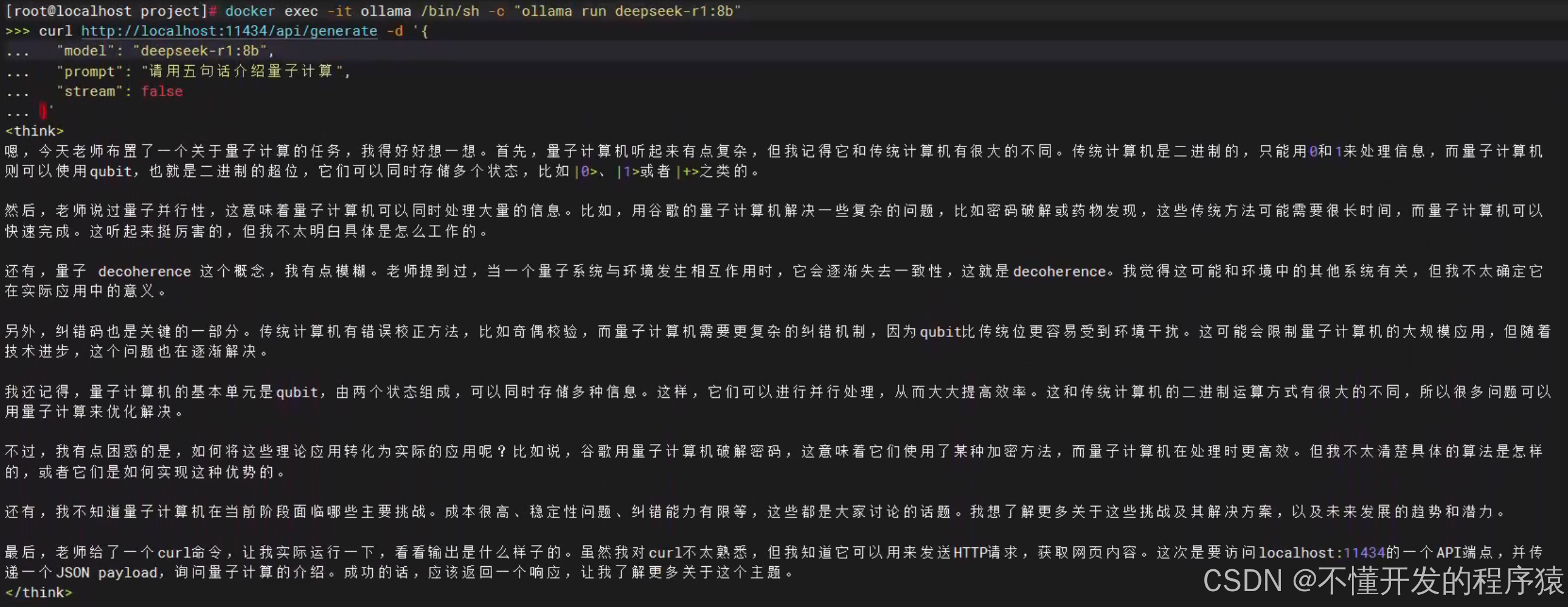

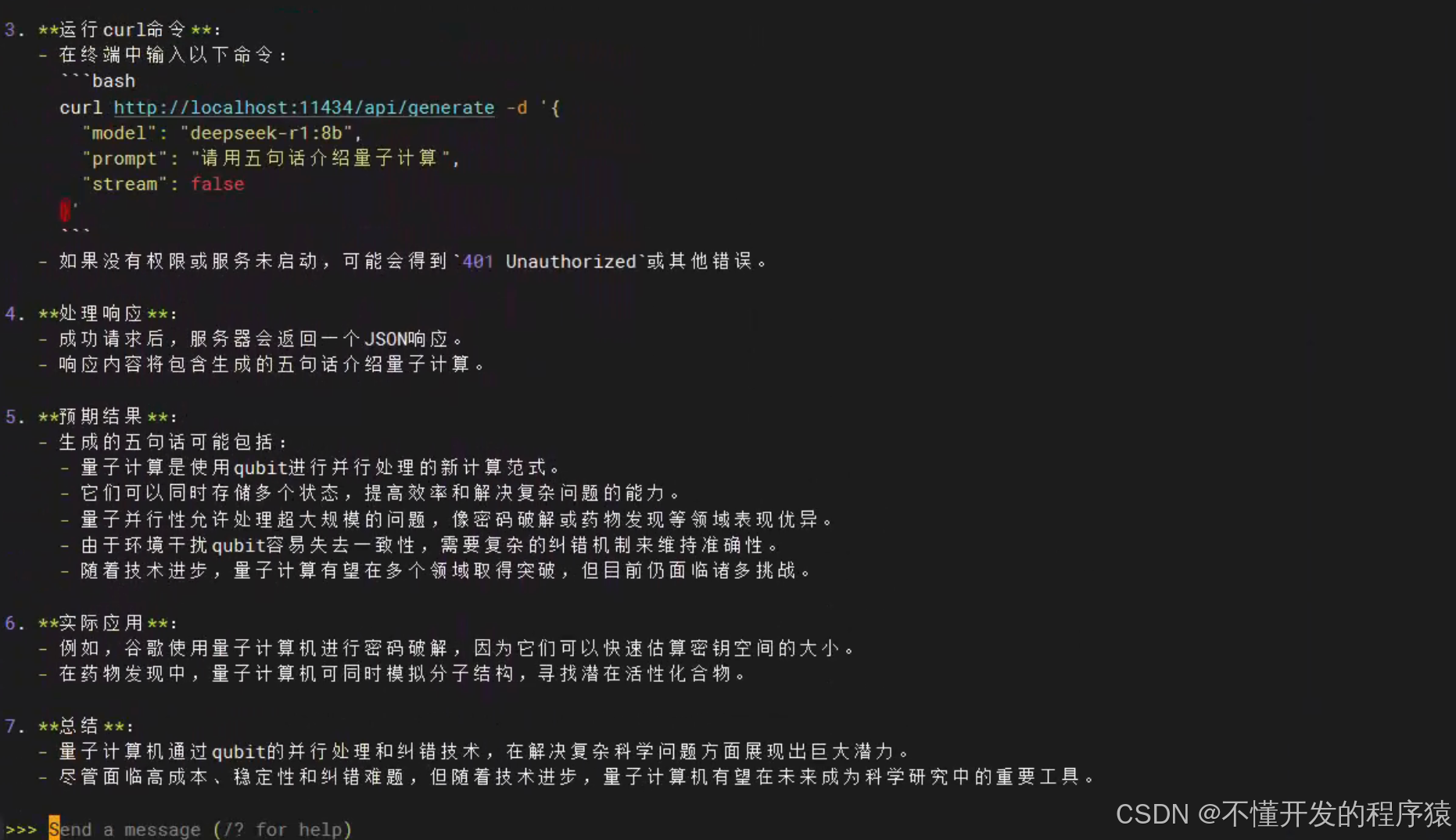

3.验证模型

您可以发送一个测试请求来验证模型是否正常运行。使用 curl 命令发送一个请求:

curl http://localhost:11434/api/generate -d '{

"model": "deepseek-r1:8b",

"prompt": "请用五句话介绍量子计算",

"stream": false

}'

如果模型正常运行,您将收到一个包含生成文本的 JSON 格式响应

4.其他常用命令

查看已安装的模型:

docker exec -it ollama /bin/sh -c "ollama list"

查看运行中的模型实例:

docker exec -it ollama /bin/sh -c "ollama ps"

删除模型:

docker exec -it ollama /bin/sh -c "ollama rm deepseek-r1:8b"

这些命令可以帮助您管理 Ollama 的模型和运行状态。

5.open webui

这里如果直接docker下载镜像,很慢。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 拉取 Open WebUI 镜像

先在本机上挂载VPN,下好images

docker pull ghcr.io/open-webui/open-webui:main

导出images

docker save ghcr.io/open-webui/open-webui > main.tar

上传到服务器,再load下images

docker load < main.tar

-

运行 Open WebUI 容器,并将其与 Ollama 服务连接

如果Ollama在本机电脑上运行,就用这个命令

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

参数说明:

• -d:后台运行容器。

• -p 3000:8080:将宿主机的 3000 端口映射到容器的 8080 端口。

• --add-host=host.docker.internal:host-gateway:添加主机映射,使容器能够访问宿主机上的 Ollama 服务。

• -v open-webui:/app/backend/data:将容器内的数据目录挂载到 Docker 卷 open-webui,确保数据持久化。

• --name open-webui:为容器命名为 open-webui。

• --restart always:设置容器在退出时自动重启。

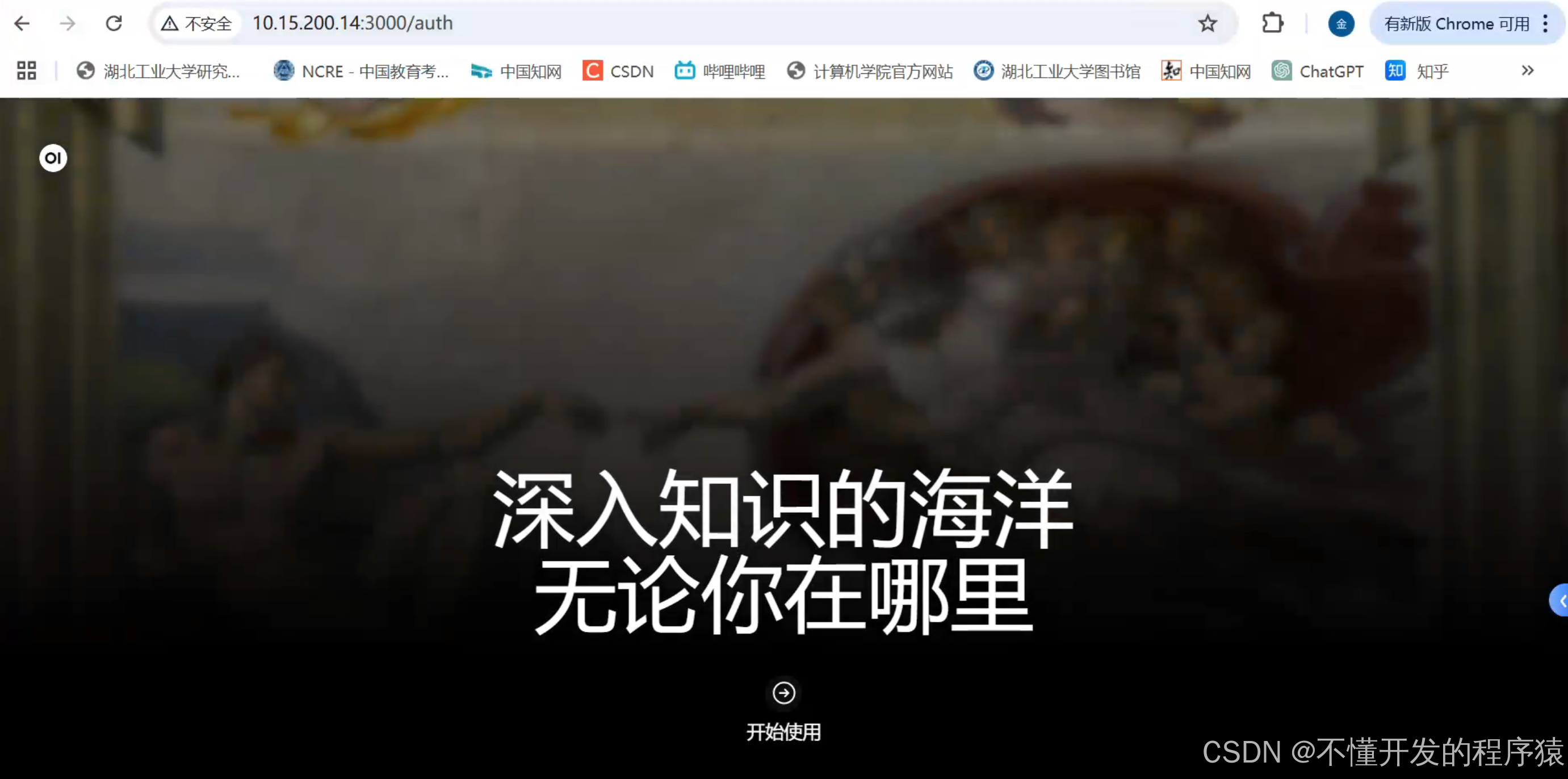

- 访问 Open WebUI

运行容器后,您可以通过浏览器访问 Open WebUI 的 Web 界面:

http://localhost:3000

-

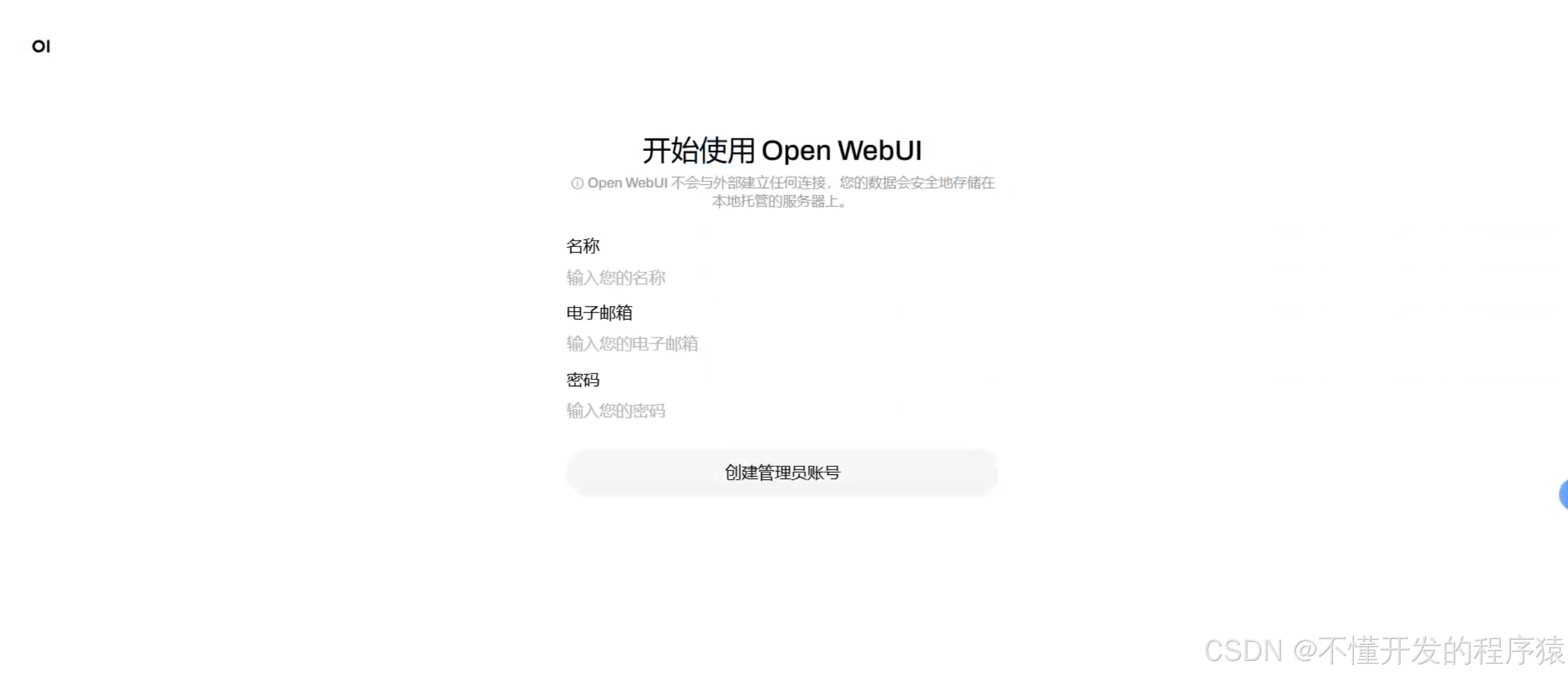

首次访问

首次访问时,您需要创建一个管理员账户。输入用户名和密码后,点击“Create Account”完成注册。 -

连接到 Ollama

在 Open WebUI 的设置页面中,确保 Ollama 的 API 地址正确。例如:

ollama_api_url: http://host.docker.internal:11434 -

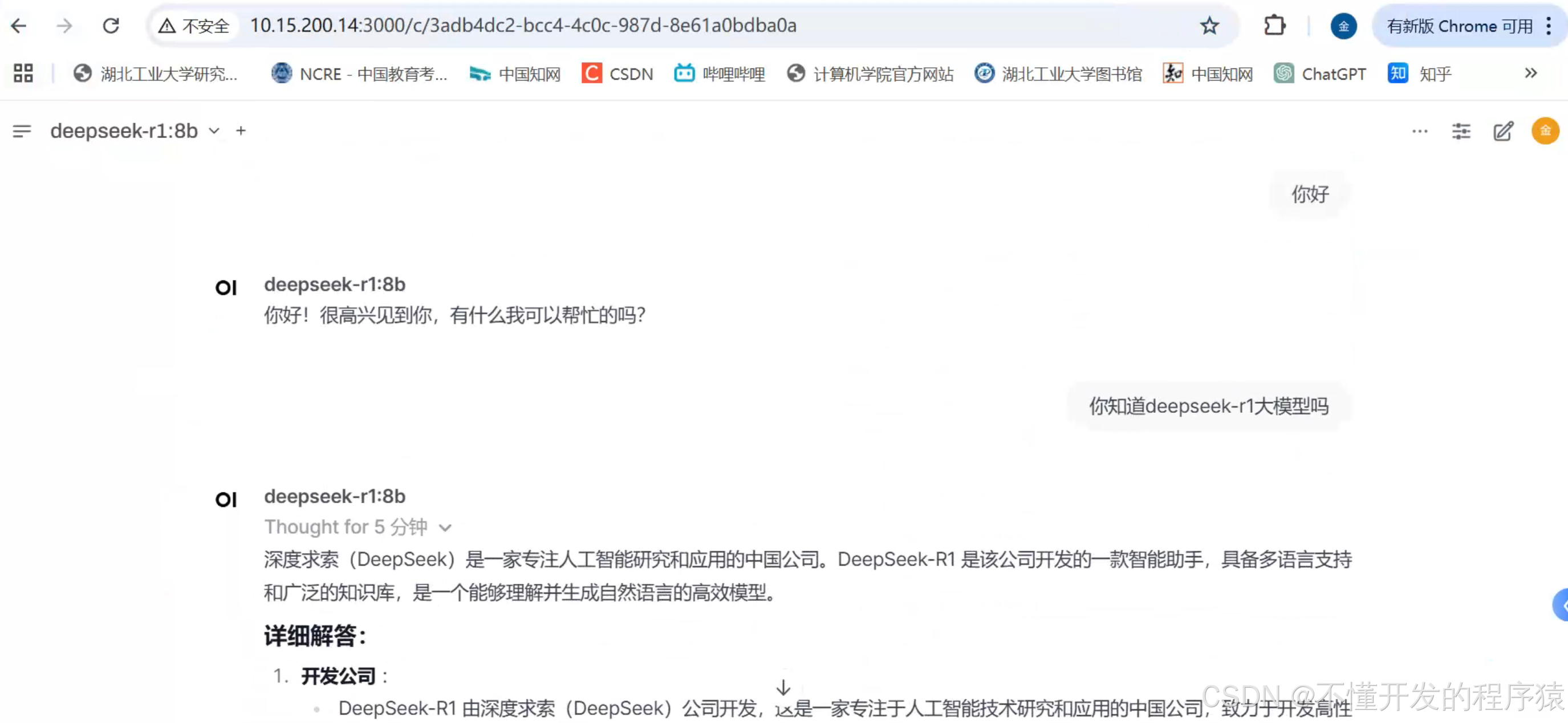

运行大模型

在 Open WebUI 中,您可以选择并运行不同的大模型。例如,运行 deepseek-r1:8b 模型:

1 在 Open WebUI 的界面中,选择模型 deepseek-r1:8b。

2 输入您的问题或指令,点击“Send”按钮,等待模型生成回复。

-

停止和删除容器

如果需要停止和删除 Open WebUI 容器,可以使用以下命令:

docker stop open-webui

docker rm open-webui

–end–

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)