自问世以来,DeepSeek迅速成为全球瞩目的焦点,这不仅归功于其卓越的技术表现,更在于其开源的开放策略和极具竞争力的低成本优势,从而在全球范围内掀起了一股AI应用的新浪潮。

DeepSeek-R1作为该系列中的明星产品,凭借其出色的推理能力,在多个权威基准测试中超越了当前顶尖的模型。这一技术上的重大突破,不仅标志着AI领域的一次显著进步,同时也为开发者提供了一个性价比极高的解决方案。特别值得一提的是,DeepSeek-R1通过大规模的强化学习训练,无需依赖传统的监督微调,即可在数学推理等高难度任务中展现出卓越的性能。

部署要求

本文将详细介绍如何快速部署Deepseek。要快速部署 DeepSeek,首先需要明确 DeepSeek 的具体用途和功能。DeepSeek 可能是一个深度学习模型、工具或平台,用于特定任务(如图像识别、自然语言处理等)。以下是一个通用的步骤指南,帮助普通人快速部署 DeepSeek,快速部署 DeepSeek 的关键在于:

- 明确需求。

- 准备好环境和依赖。

- 获取并配置模型。

- 测试和部署。

明确需求

确定 DeepSeek 的具体用途(如文本生成、图像分类等)。

了解 DeepSeek 的输入输出格式以及所需的硬件资源(如 GPU 或 CPU)。

硬件要求

- 一台服务器或高性能计算机(推荐使用云服务器)

软件要求

- 操作系统:Linux(推荐Ubuntu 20.04或更高版本)

- Docker:用于容器化部署

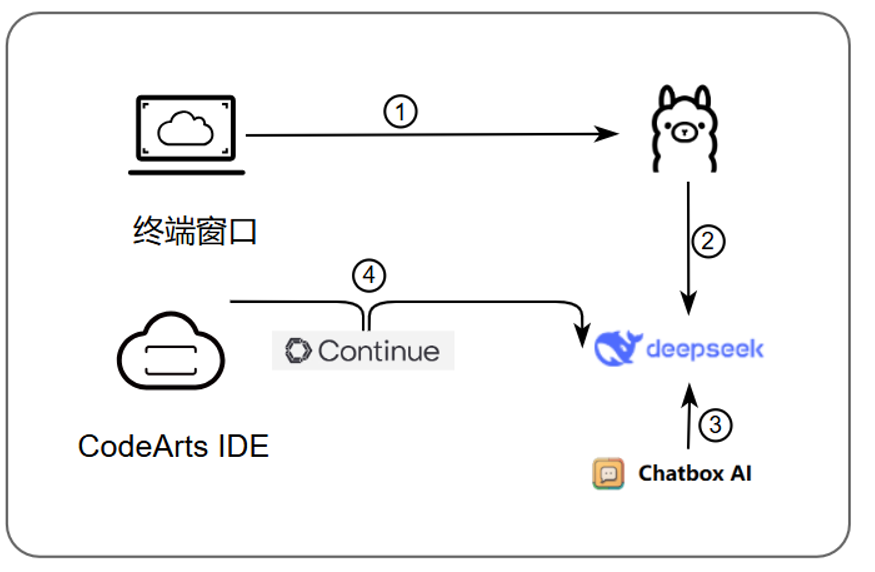

部署逻辑:

说明:

- 安装Ollama;

- 使用Ollama部署DeepSeek;

- ChatBox集成DeepSeek;

- CodeArts IDE集成DeepSeek。

部署DeepSeek步骤

1、安装Ollama

Ollama 是一款功能强大的开源工具,专为在本地运行、部署和管理大型语言模型(LLMs)而设计。它提供了简洁的命令行界面,使用户能够轻松下载、运行并与各种预训练的语言模型进行交互。Ollama 支持多种模型架构,非常适合希望在本地环境中使用 LLMs 的开发者和研究人员。

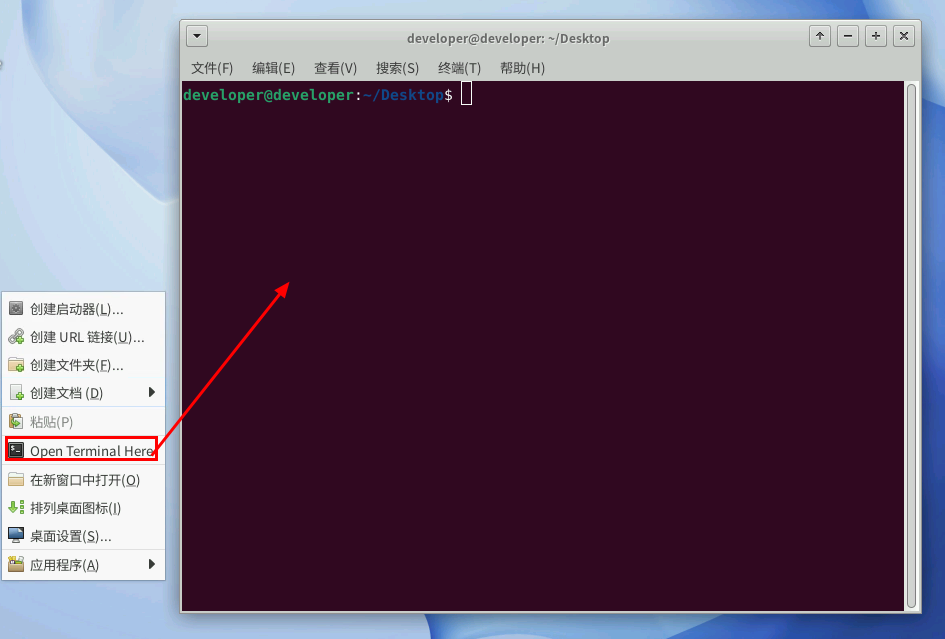

- 打开终端: 在云主机桌面上右键选择“Open Terminal Here”,打开命令终端窗口。

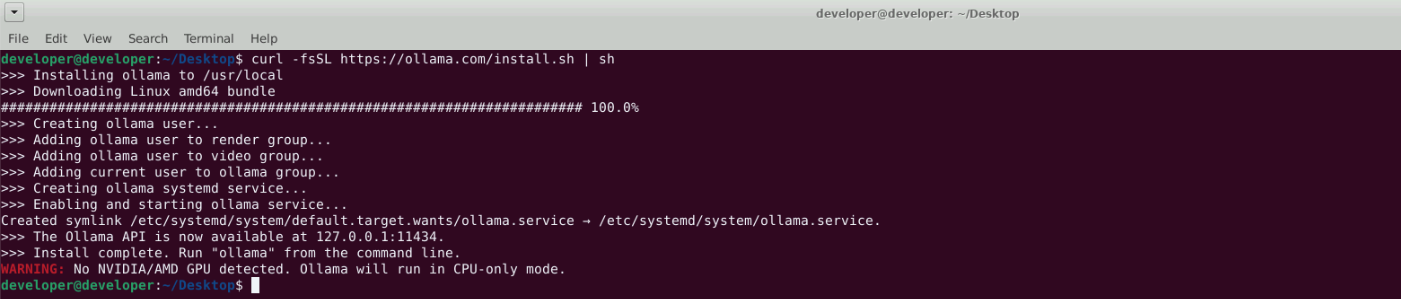

- 执行安装命令: 在终端中输入以下命令并回车:

2、部署DeepSeek

借助 Ollama,我们可以轻松部署 DeepSeek 大模型。以下步骤将指导您部署 deepseek-r1:1.5b 版本:

- 执行部署命令: 在终端中输入以下命令并回车:

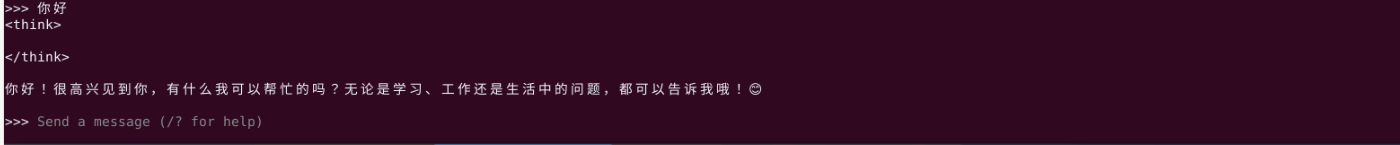

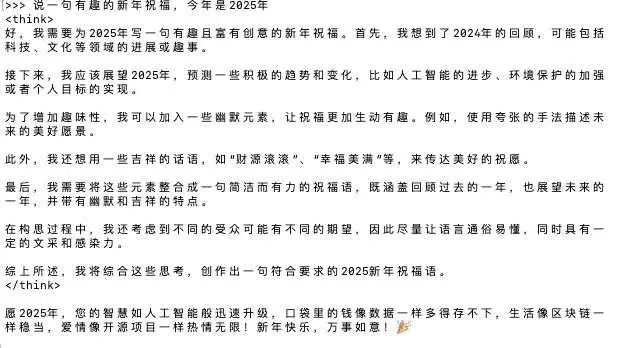

2.开始对话: 部署完成后,您可以直接在终端与 DeepSeek 大模型进行对话。

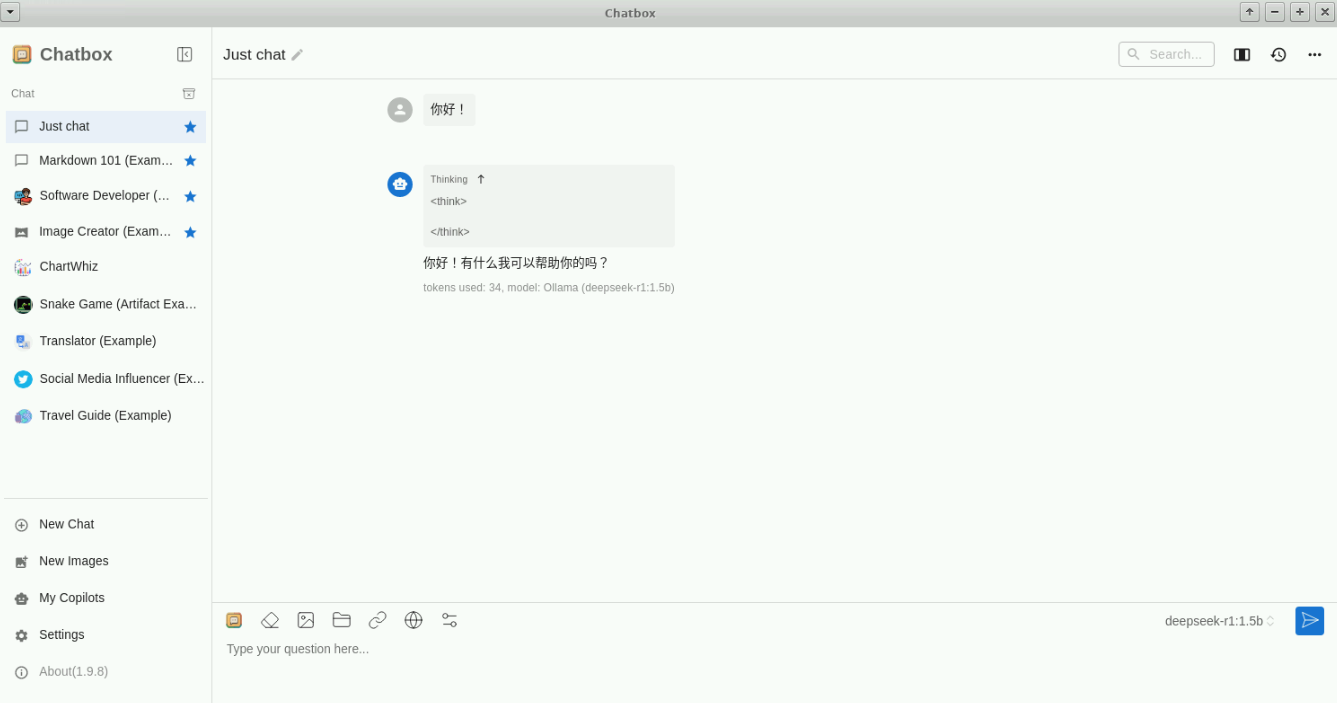

3、安装ChatBox

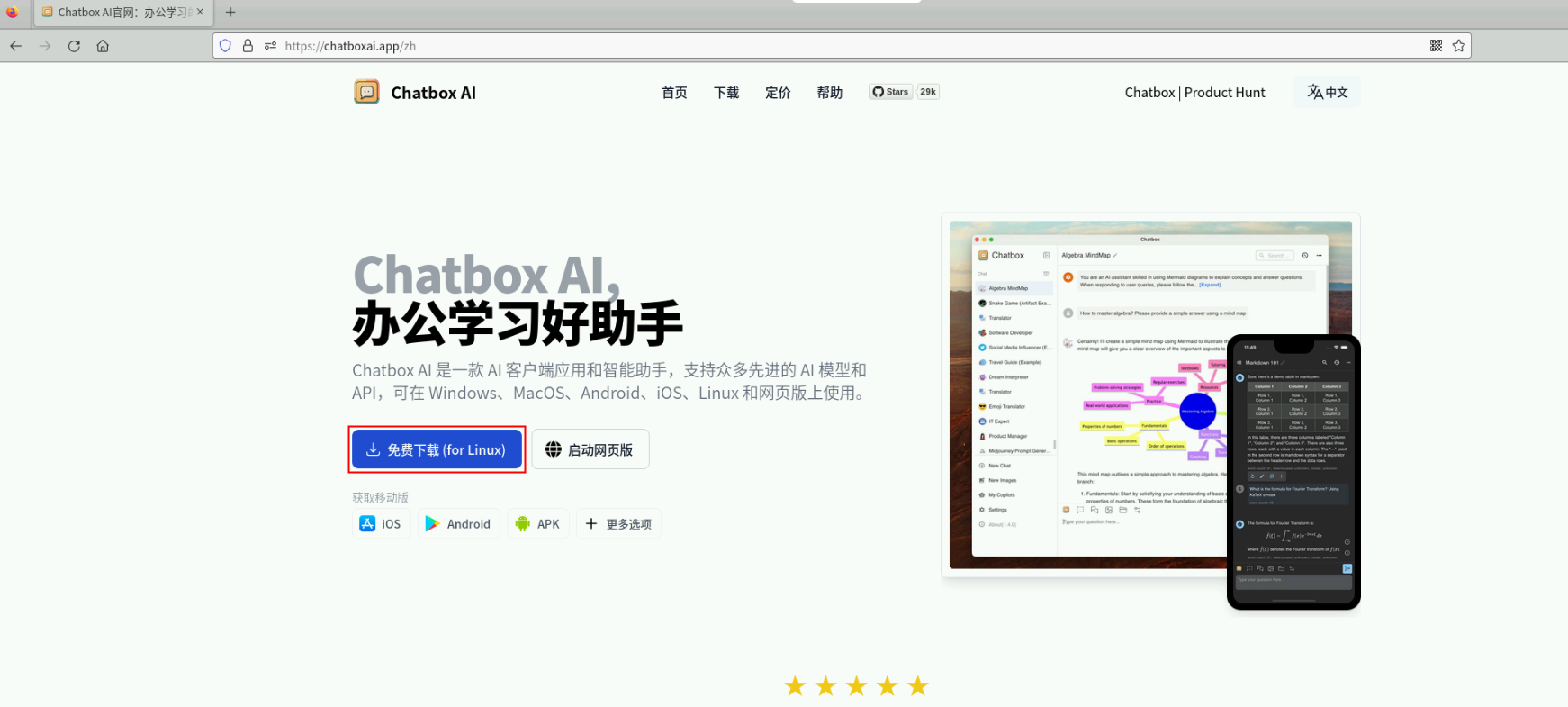

虽然通过终端可以与 DeepSeek 进行交互,但为了获得更直观和流畅的体验,我们可以使用可视化聊天工具,例如 Open WebUI 或 ChatBox。以下步骤将指导您安装并使用 ChatBox:浏览器下载ChatBox: https://chatboxai.app/zh 进入Chatboxai点击“免费下载”按钮下载适用于您系统的安装包。

打开下载文件所在目录,右键选择“Open Terminal Here”,在终端中输入以下命令并回车:

安装zlib 库:

安装 zlib 后,使用 find 命令查找 libz.so 文件:

设置 LD_LIBRARY_PATH:

安装libfuse.so.2库:

运行文件,运行应用时禁用沙盒:

配置 ChatBox

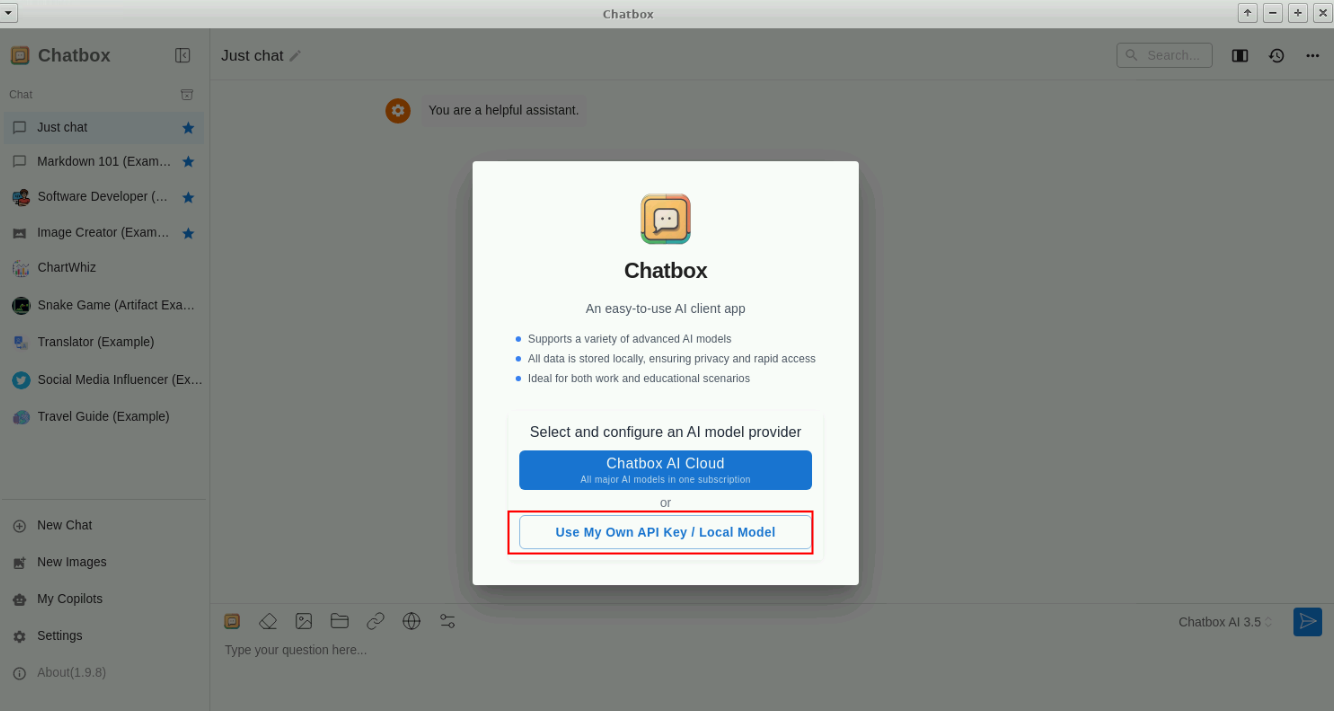

- 选择 API 类型: 首次打开 ChatBox 时,选择“使用自己的API Key或本地模型(Use My Own API Key/Local Model)”。

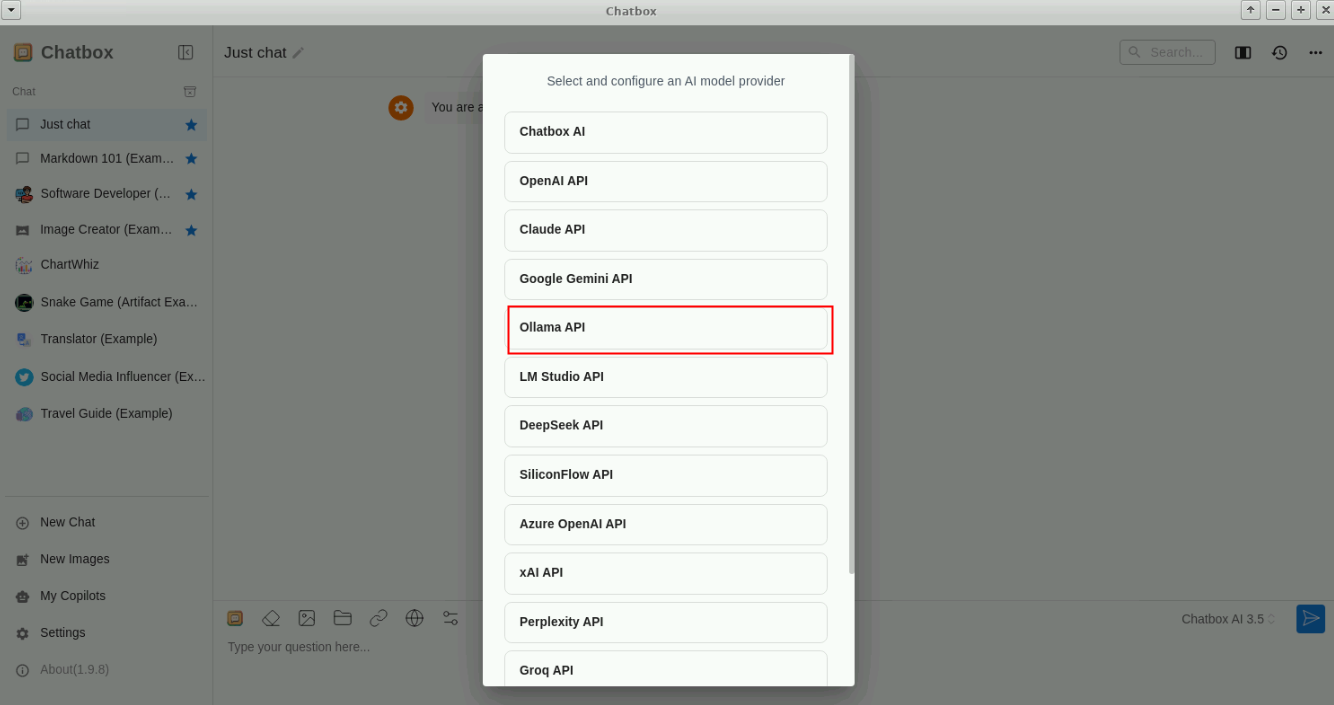

- 选择 Ollama API: 在新的标签页中选择 Ollama API。

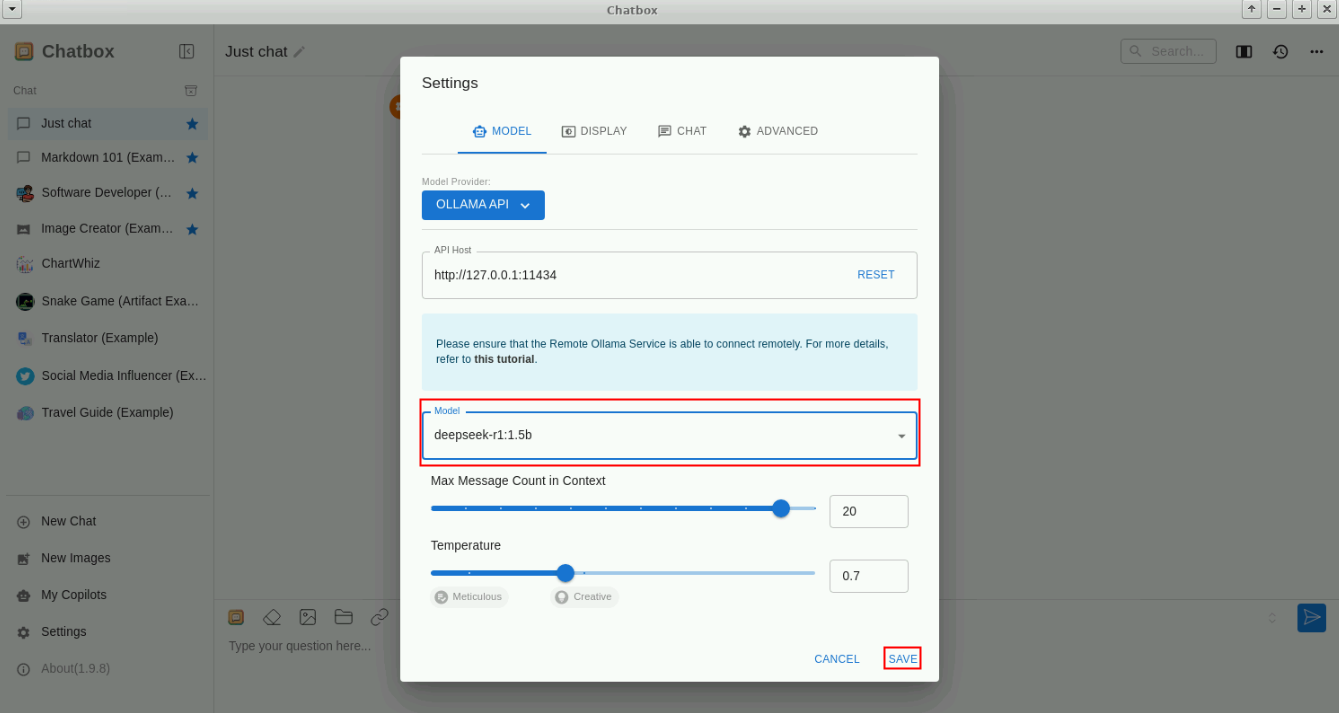

- 选择模型: 在模型列表中选择 deepseek-r1:1.5b,然后点击保存。

配置完成后,您就可以在 ChatBox 的对话框里与 DeepSeek 大模型进行对话了。

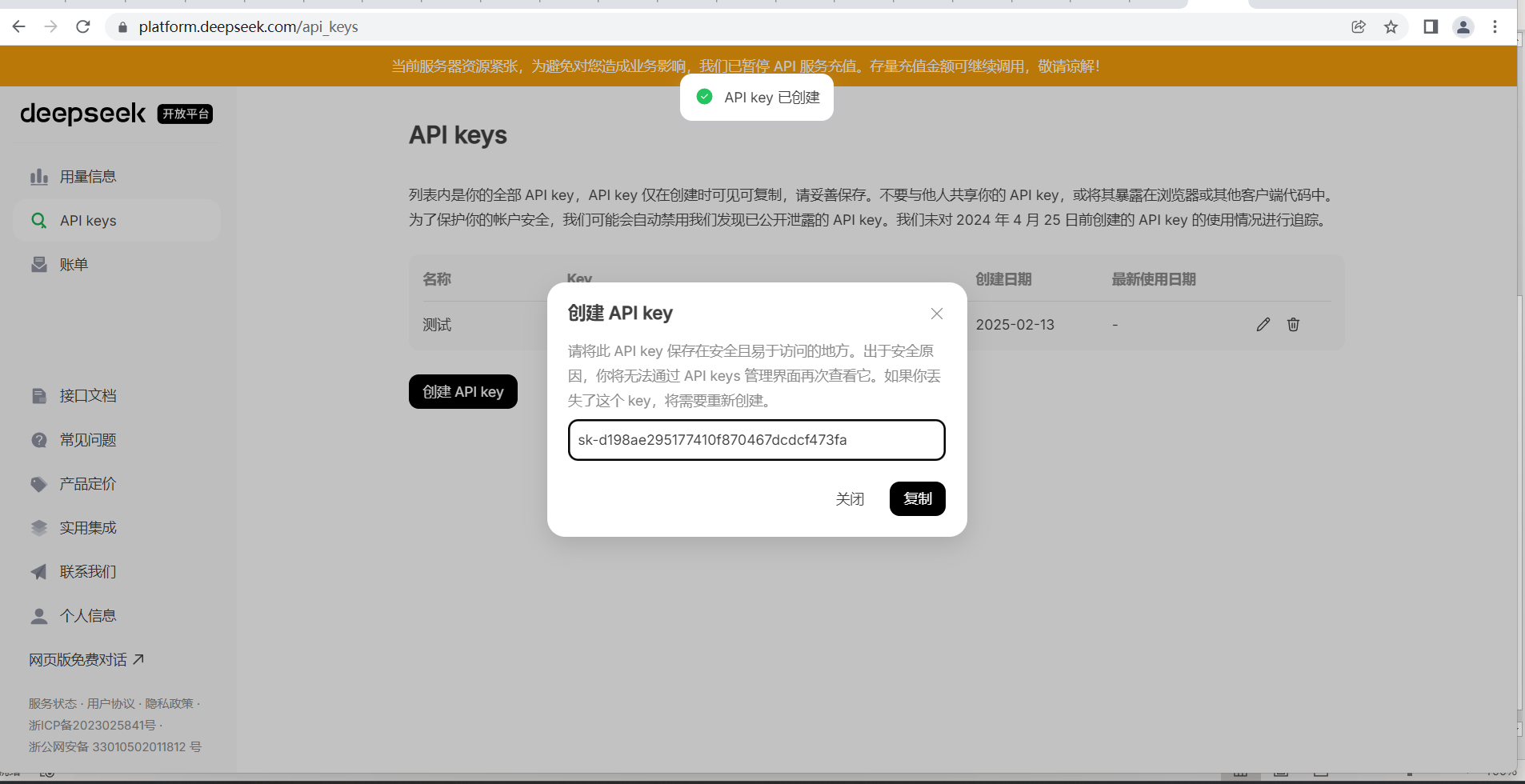

DeepSeek API秘钥

目前deepseek已经获得最牛的域名, AI.com

秘钥需要登录: https://platform.deepseek.com/sign_in

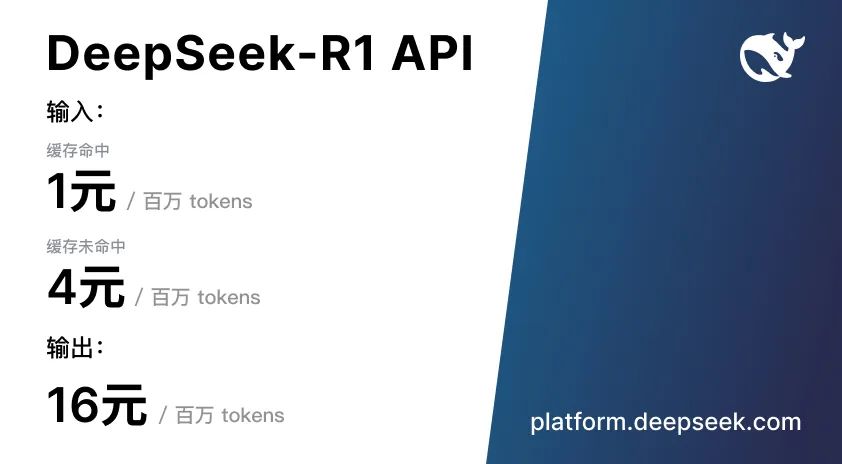

API 及定价

DeepSeek-R1 API 服务定价为每百万输入 tokens 1 元(缓存命中)/ 4 元(缓存未命中),每百万输出 tokens 16 元

Token 用量计算

token 是模型用来表示自然语言文本的基本单位,也是我们的计费单元,可以直观的理解为“字”或“词”;通常 1 个中文词语、1 个英文单词、1 个数字或 1 个符号计为 1 个 token。

一般情况下模型中 token 和字数的换算比例大致如下:

- 1 个英文字符 ≈ 0.3 个 token。

- 1 个中文字符 ≈ 0.6 个 token。

但因为不同模型的分词不同,所以换算比例也存在差异,每一次实际处理 token 数量以模型返回为准,您可以从返回结果的 usage 中查看。

本地部署

成功在本地部署DeepSeek AI助手后,您将能够在个人电脑上畅享其强大功能,无需担忧网络延迟和隐私泄露问题。

第一步:环境搭建(安装Ollama)

Ollama 是一款轻量级的AI模型运行框架,兼容多种开源模型,我们将利用它来运行DeepSeek。

重要提示: 近期DeepSeek热度高涨,网络上出现了许多仿冒诈骗网站。请务必通过官方渠道下载软件,警惕任何付费或转账要求。

- 获取 Ollama

- 前往 Ollama 官方网站。

- 根据您的操作系统选择相应的安装包(Windows 选择 .exe,Mac 选择 .dmg)。

- 下载完成后,按照提示完成安装:

- Windows:双击安装包,按照向导操作即可。

- Mac:将 Ollama 图标拖拽至 Applications 文件夹。

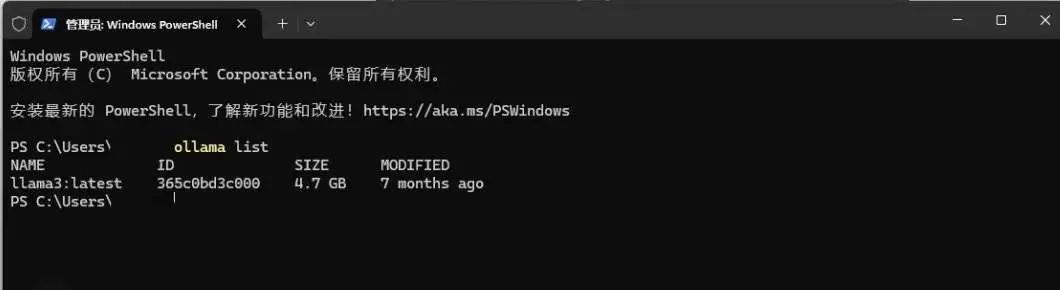

2. 验证安装

安装完成后,打开终端(Windows 按 Win + R 输入 cmd,Mac 直接打开 Terminal),然后输入:ollama list

输入以下命令:

如果终端显示类似 llama3 的模型名称,则说明安装成功。

注意事项

- 确保您的系统已更新至最新版本,以避免兼容性问题。

- 安装过程中,建议暂时关闭杀毒软件,防止其误报拦截。

- 保持网络连接稳定,下载过程可能需要传输超过 300MB 的数据。

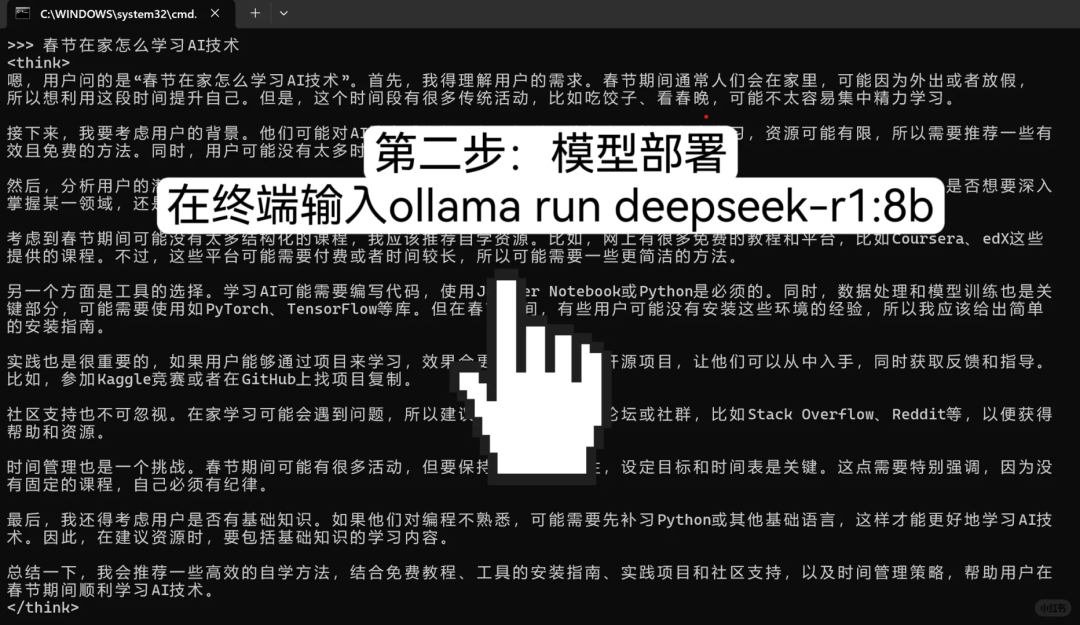

第二步:部署DeepSeek模型

DeepSeek 提供了多种参数版本,我们推荐:

- 普通用户: 选择 8B 版本,适用于日常对话、写作等场景。

- 高性能显卡用户(显存 16GB 以上): 可选择 16B 版本,体验更强大的性能。

- 获取并安装模型

- 访问 Ollama 模型库,搜索

deepseek-r1。 - 复制对应版本的安装命令,并在终端中运行:

(如果您选择 16B 版本,将 8b 替换为 16b)

首次运行时,系统会自动下载约 5GB 的模型文件,请耐心等待。

2.测试模型

安装完成后,在终端中输入:

如果模型能够成功回应,则说明部署成功!

如果模型成功回应,说明部署无误!

第三步:安装可视化界面(Chatbox AI)

虽然终端交互方便快捷,但如果您更倾向于使用类似ChatGPT的可视化界面,可以安装Chatbox AI。

1. 下载 Chatbox

- 访问 Chatbox 官网,下载对应系统的安装包

- 按照默认设置完成安装

2. 连接本地模型

- 打开 Chatbox,进入设置界面。

- 在模型设置中选择:

- API 类型:Ollama API

- 模型名称:deepseek-r1:8b

- 点击“检查连接”,如果状态正常,即可开始使用。

-

3. 进阶设置(可选)

- 温度值: 建议设置为 0.3-0.7,数值越低,AI 的回答越保守。

- 最大生成长度: 建议设置为 2048 tokens,以获得更丰富的回答。

- 连续对话模式: 开启后,可以使对话更加连贯自然。

第四步:优化交互和性能

为了让AI助手更好地为您服务,您可以尝试以下方法:

- 释放系统资源: 在运行AI程序时,尽量关闭其他占用大量内存的软件,例如大型游戏、视频编辑软件等,以确保AI能够获得充足的计算资源。

- 拆分复杂问题: 当您遇到复杂的问题时,可以尝试将其拆分成几个更小、更具体的问题,并逐步向AI提问。这样可以帮助AI更准确地理解您的需求,并提供更精准的答案。

- 尝试英文关键词: 在某些情况下,使用英文关键词进行搜索或提问,可能会获得更快的响应速度和更丰富的结果。

- 定期重启服务: 如果您使用的是Ollama等本地部署的AI服务,建议您定期重启服务,以释放内存并清除缓存,确保AI始终保持最佳运行状态。

总 结

学习 Deepseek 的部署和调用是一个非常有价值的过程,它不仅让我掌握了一项实用的技能,也为我打开了深度学习世界的大门。

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)