局域网运行 Ollama 本地 AI 模型

先到设置中修改语言为中文,然后修改ollama 的设置,ollama url 填写你的远程 ollama地址, 例如我的远程电脑的ip是 192.168.0.101 这里的值就是。安装chatbox后,打开设置(或者打开针对本模型的设置),然后选择模型提供方,选择ollama api,在添加远程服务的ip地址和端口。然后稍等一下,如果局域网没有配置错误,就会看到你远程运行的模型,选择其中一个,保存

局域网运行 Ollama 本地 AI 模型,让手机/平板/局域网 也能轻松访问!

概要

本文详细介绍了如何在 局域网内配置 Ollama 以实现远程访问,使手机、平板或其他电脑设备能够共享本地运行的 AI 模型服务。文章涵盖 Mac、Windows 和 Linux 平台的 Ollama 远程服务配置方法,包括如何使用 launchctl、系统环境变量或 systemd 配置远程访问。此外,还介绍了 网络连接方法,如使用 ipconfig 或 ifconfig 获取本机 IP 地址,并通过 http://[IP]:11434 连接远程 Ollama 服务。同时,文中提供了 Page Assist 浏览器插件 和 Chatbox 客户端 的配置指南,支持 Windows、macOS、iOS 和 Android 设备。本教程适用于个人开发者和小型团队,希望在本地快速搭建 私有 AI 服务。

2.2 Windows 配置 Ollama 远程服务

退出正在运行的 Ollama 应用。

打开 设置(Windows 11) 或 控制面板(Windows 10),搜索 环境变量。

编辑你的用户环境变量:

新建或编辑 OLLAMA_HOST,值设为 0.0.0.0

新建或编辑 OLLAMA_ORIGINS,值设为 *

保存设置并重新启动 Ollama。

如果你习惯命令行,使用命令行方式(可选)

2.3 Linux 配置 Ollama 远程服务

在 Linux 上,如果 Ollama 作为 systemd 服务运行,需要通过 systemctl 设置环境变量。

编辑 systemd 服务配置:

sudo systemctl edit ollama.service

Copy

在 [Service] 部分添加以下内容:

[Service]

Environment=“OLLAMA_HOST=0.0.0.0”

Environment=“OLLAMA_ORIGINS=*”

Copy

重新加载 systemd 并重启 Ollama:

sudo systemctl daemon-reload

sudo systemctl restart ollama

Copy

在linux通常更多的是使用 vLLM 或 llama.cpp,更适合生产环境并支持更高效的推理。

3. 获取 Ollama 服务 IP 地址

配置完成后,你可以在局域网内的其他设备上连接到 Ollama。

在本机终端运行以下命令获取 IP 地址:

ipconfig # Windows

ifconfig # macOS / Linux

Copy

通常,Ollama 服务的 IP 地址类似于 192.168.X.X,你可以在你的 客户端中或者插件中设置 API Host 为:

http://192.168.X.X:11434

Copy

4. 插件配置使用远程ollama

chrome 浏览器安装 paga assist 插件

先到设置中修改语言为中文,然后修改ollama 的设置,ollama url 填写你的远程 ollama地址, 例如我的远程电脑的ip是 192.168.0.101 这里的值就是

http://192.168.0.101:11434

Copy

alt text

然后你就可以在你的电脑上面使用局域网内使用ollama运行的大模型了。

5. 使用chatbox运行远程ollama

Ollama 支持多个 UI 界面(查看官方支持列表)。这里我们使用 Chatbox 来连接远程 Ollama。

安装chatbox后,打开设置(或者打开针对本模型的设置),然后选择模型提供方,选择ollama api,在添加远程服务的ip地址和端口

http://192.168.0.100:11434

Copy

然后稍等一下,如果局域网没有配置错误,就会看到你远程运行的模型,选择其中一个,保存。然后就可以在当前电脑使用远程模型了。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

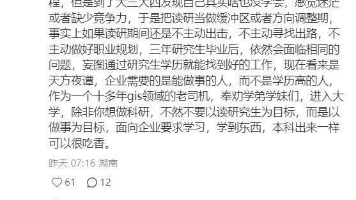

所有评论(0)