Ollama部署本地DeepSeek,Open WebUI可视化

本文介绍了使用Ollama和Open WebUI部署本地大模型DeepSeek的完整流程。首先通过Ollama官网自定义安装路径和模型目录,然后使用Docker Desktop部署Open WebUI可视化界面。详细说明了Open WebUI的初始设置步骤,包括创建管理员账户、语言设置,以及如何从Ollama导入模型(如deepseek-r1:7b)。最后提供了Ollama官方模型库的访问方式,帮

·

Ollama部署本地DeepSeek + Open WebUI可视化

本地部署 DeepSeek

Ollama:一站式 AI 模型管理与交互平台:

什么是 Ollama,Ollama 的核心功能,Ollama 的使用场景

Open WebUI:构建大模型与 Web 应用无缝对接的理想平台:

Open WebUI 简介,Open WebUI 应用场景,Open WebUI 与大模型结合的优势,Open WebUI 使用示例

1. Ollama 自定义安装

2. Ollama 可视化界面 Open WebUI 安装

Windows 中使用 Docker Desktop 部署 Open WebUI 做大模型可视化

3. Open WebUI 部署本地大模型

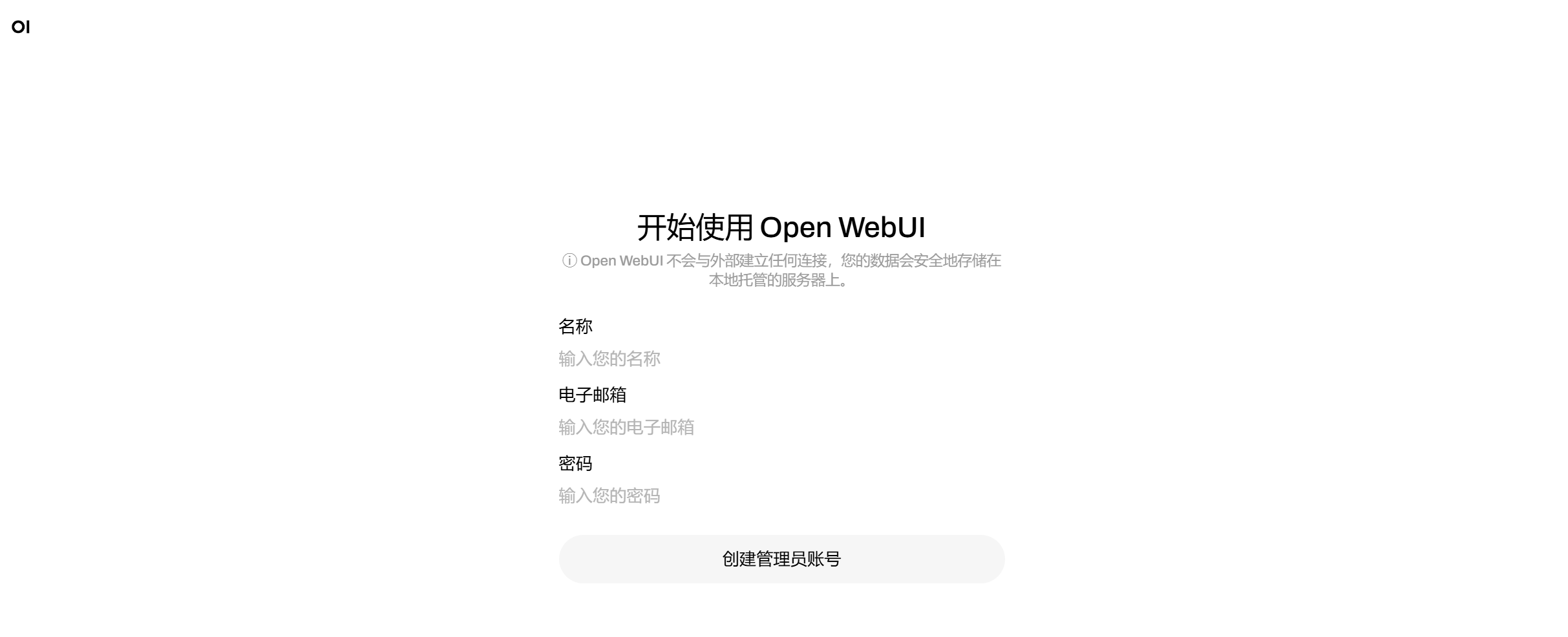

Docker Desktop 启动 Open WebUI 容器,点击开始使用,第一个创建的用户就是 Open WebUI 管理员用户

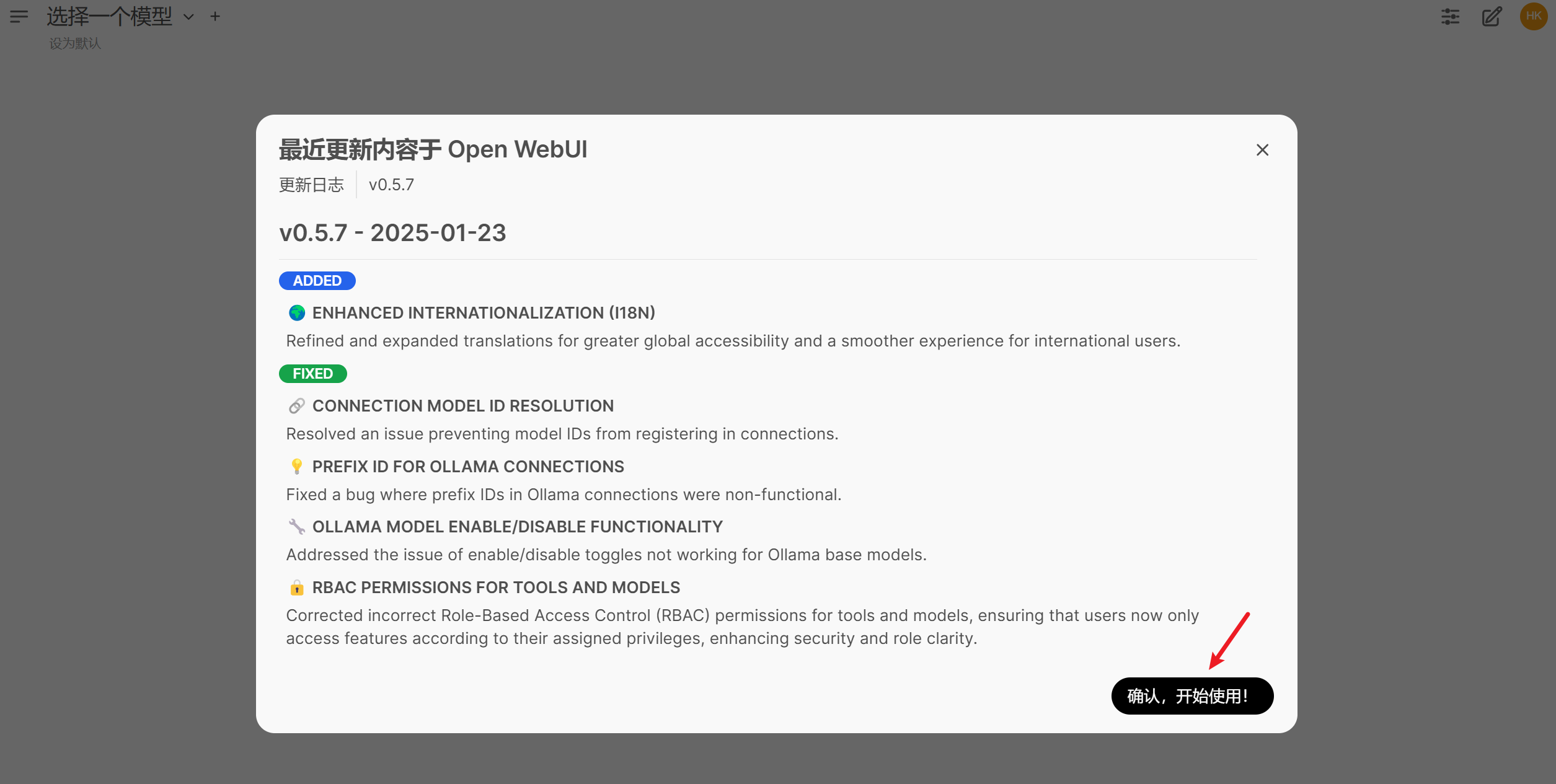

创建用户之后,点击 确认,开始使用! 即可

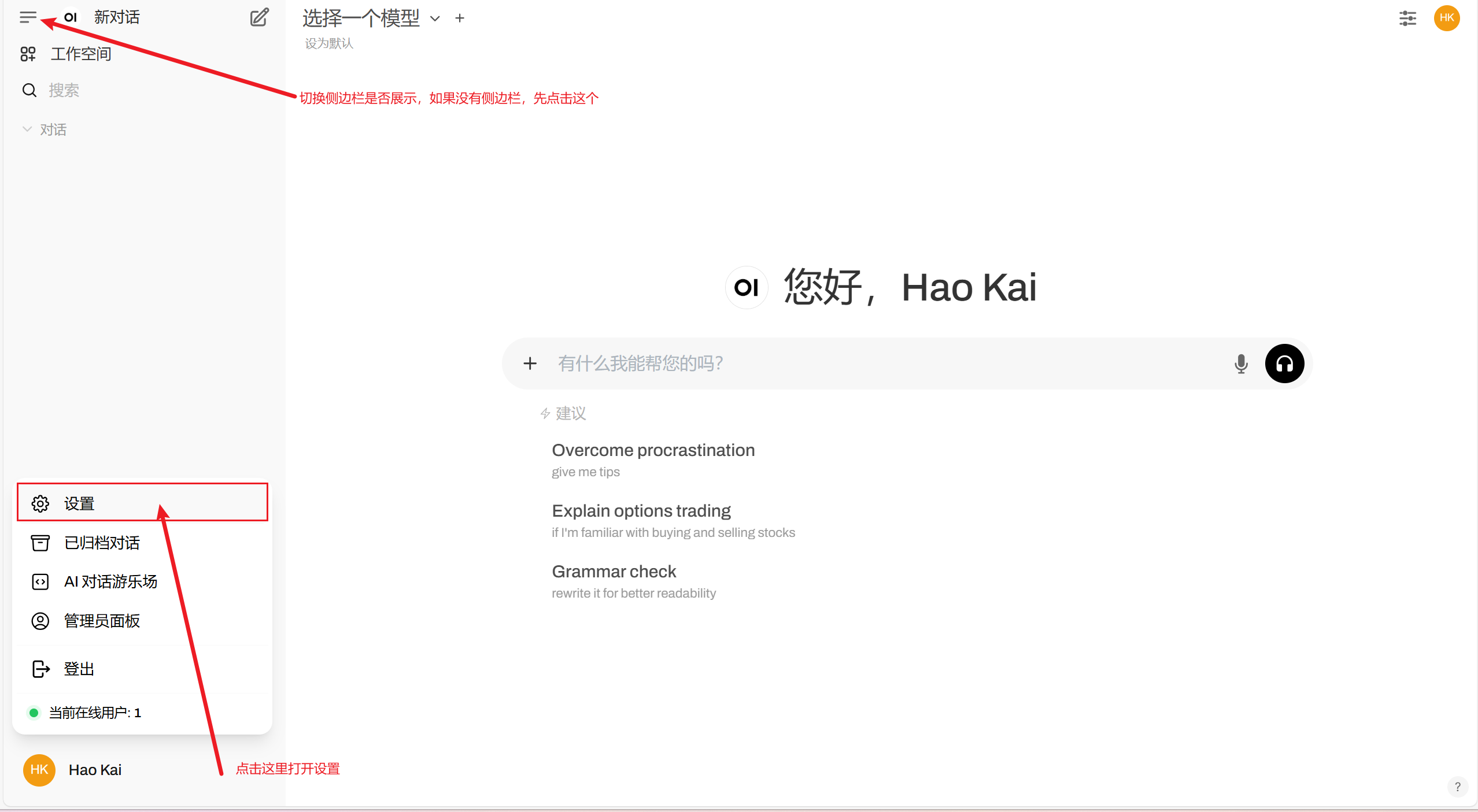

打开设置

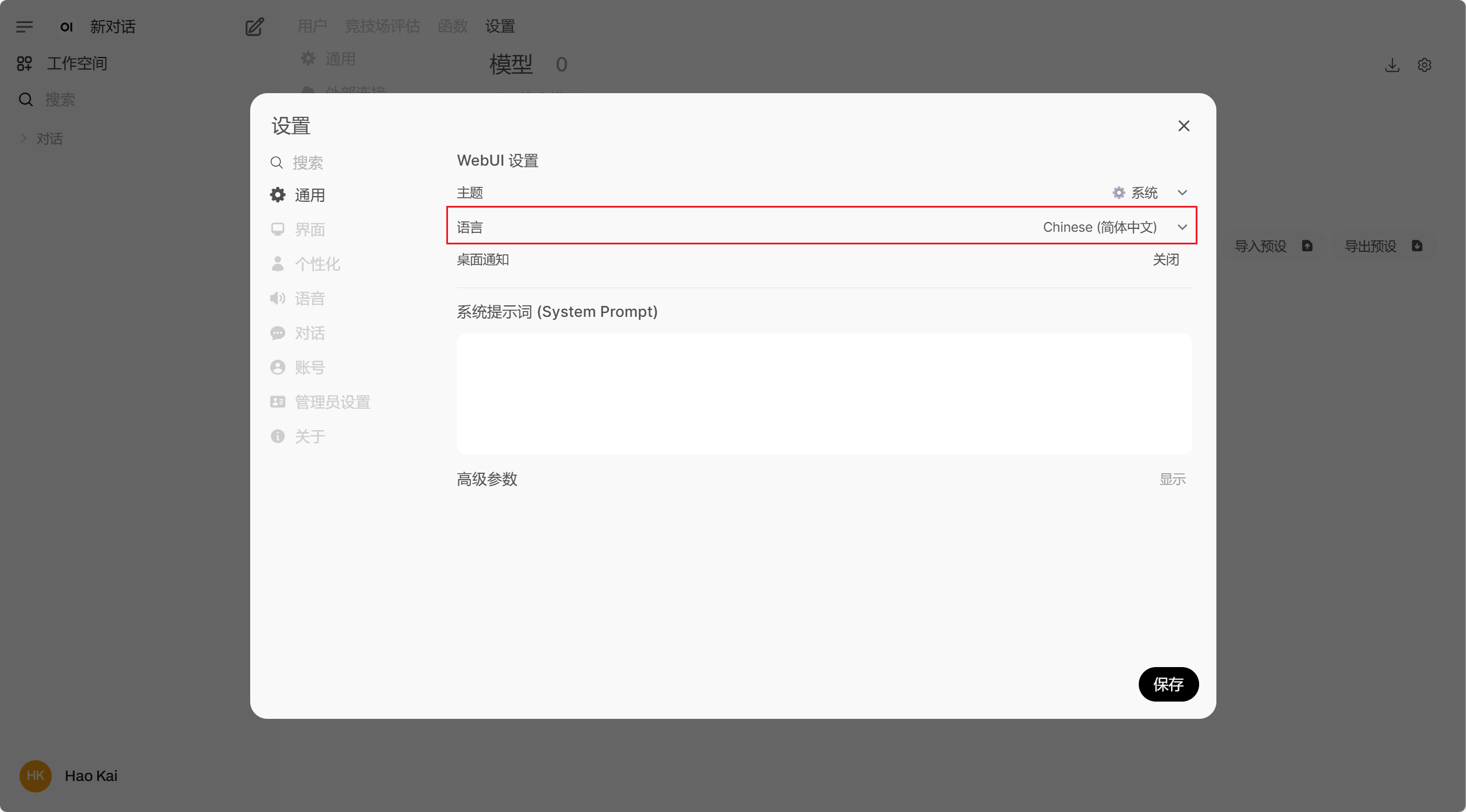

设置语言

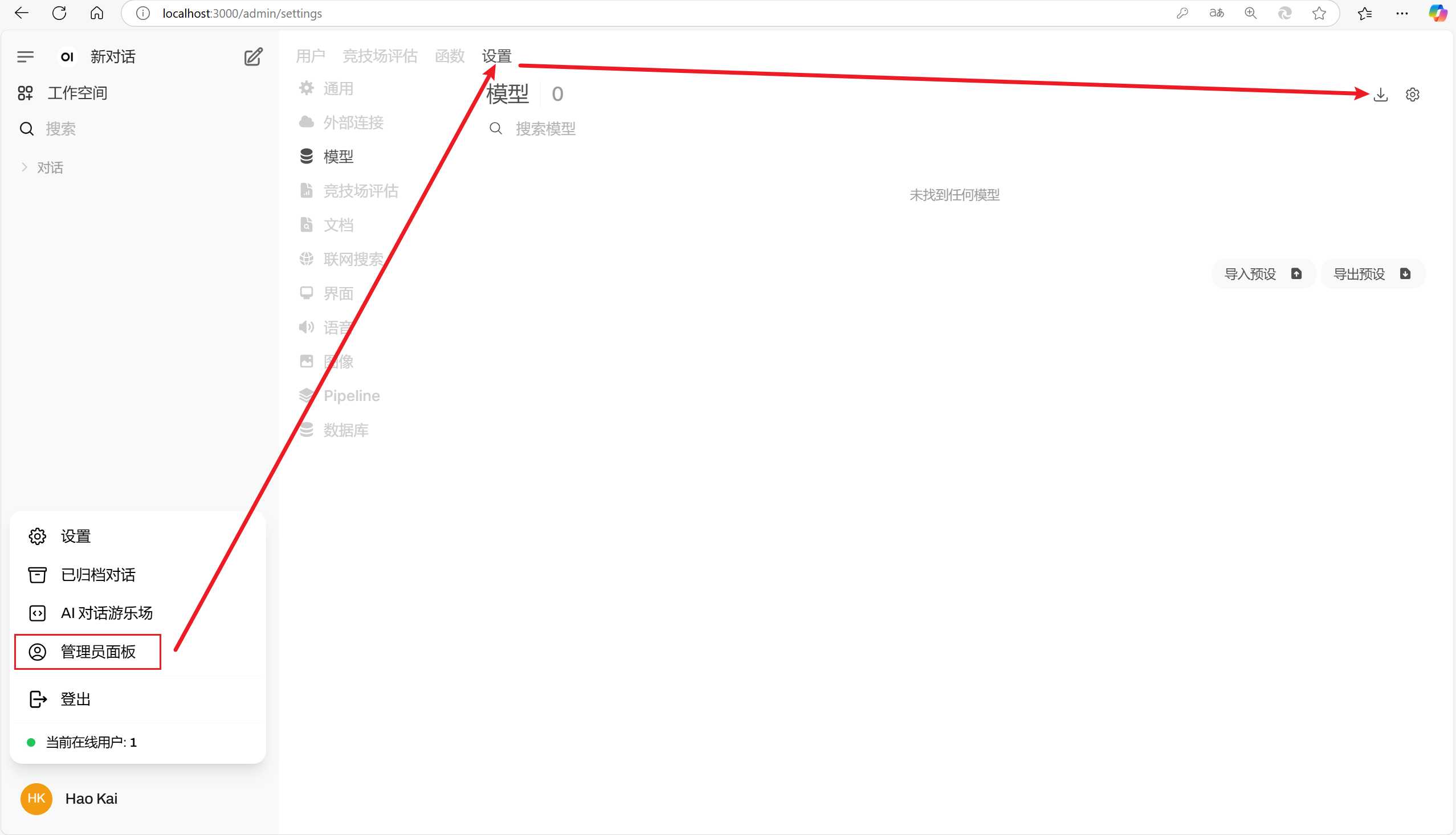

找到管理员面板,进入模型选项

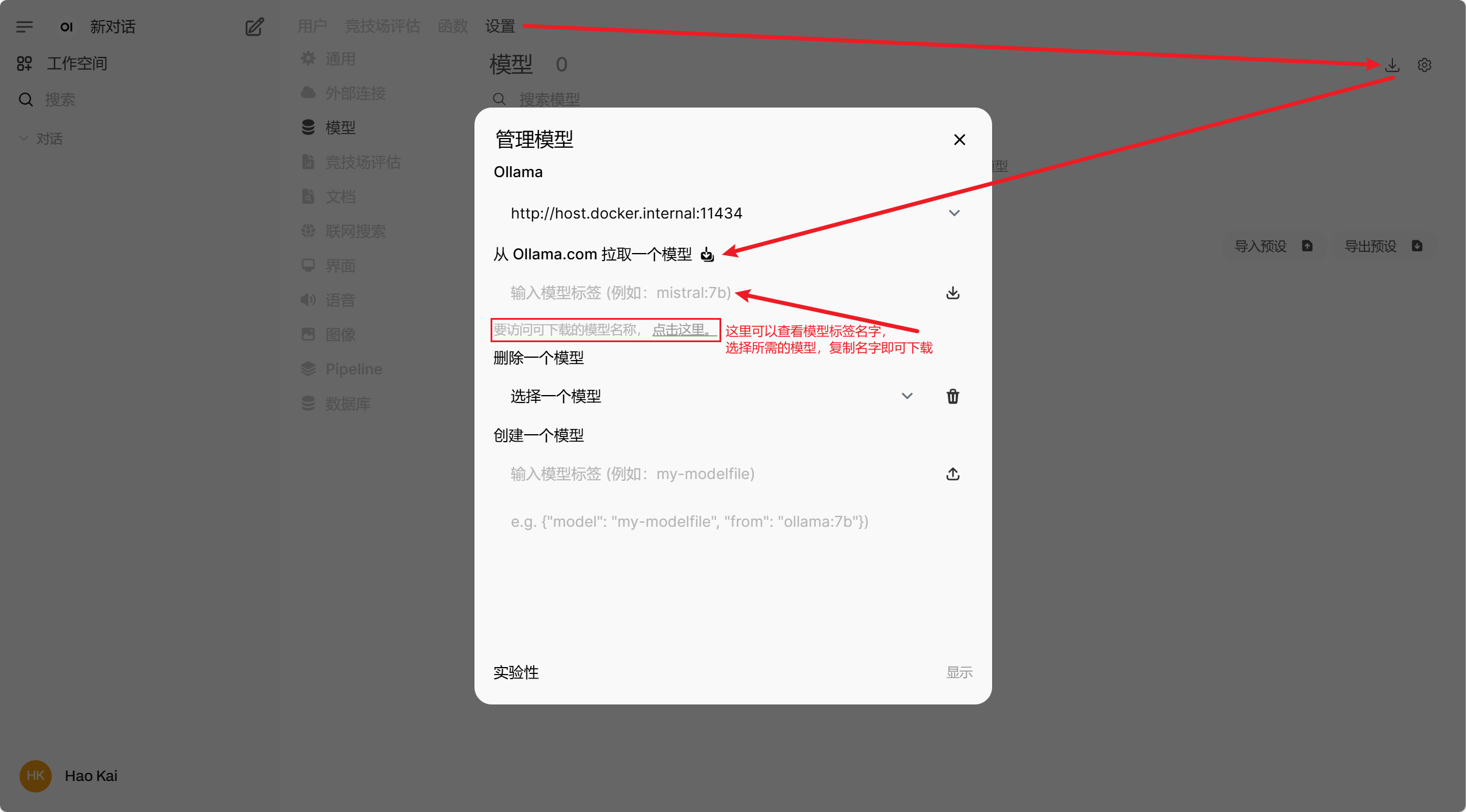

准备从 Ollama 导入模型

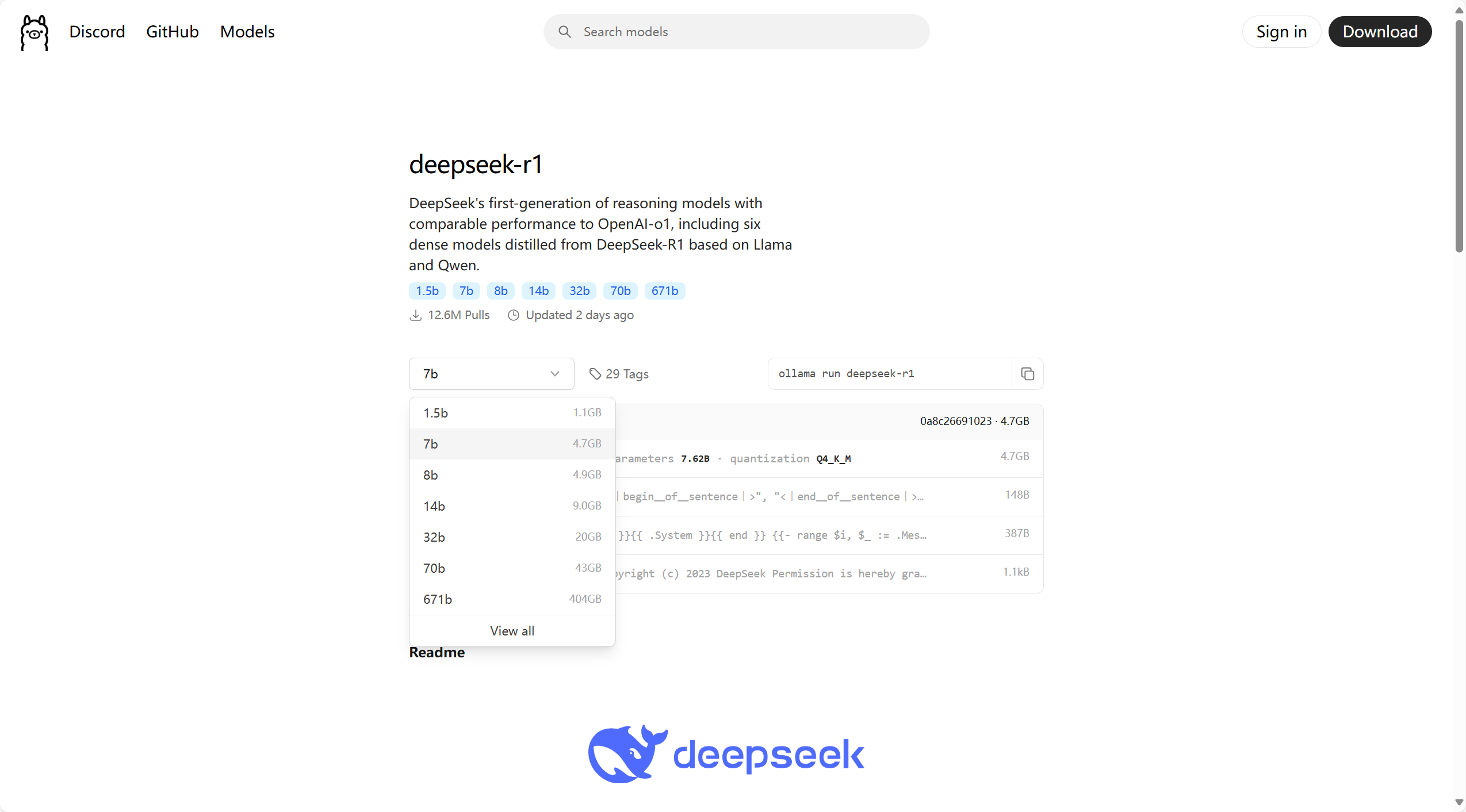

Ollama 访问可下载的模型名称:https://ollama.com/library

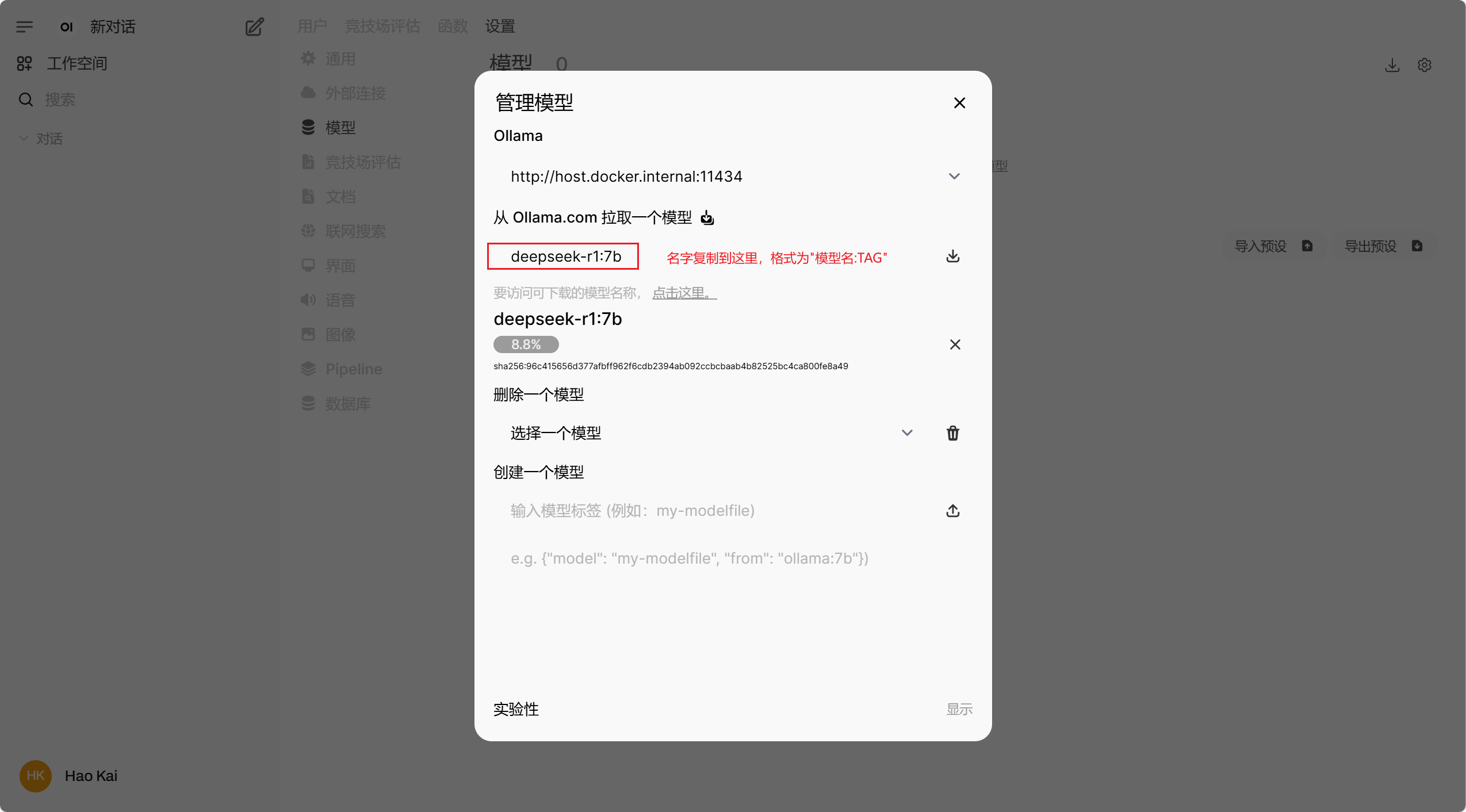

如 deepseek-r1 的 7b

将对应模型的名字复制到 Open WebUI 模型选项中,格式为 "模型名:TAG",如 deepseek-r1:7b

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)