大模型入门系列(二):大模型是怎么训练的

大模型(大规模预训练模型)的训练过程其实是一个复杂且系统化的工程,涉及数据处理、模型架构设计、分布式训练、优化策略等很多个环节。

大模型(大规模预训练模型)的训练过程是一个复杂且系统化的工程,涉及数据处理、模型架构设计、分布式训练、优化策略等多个关键环节。

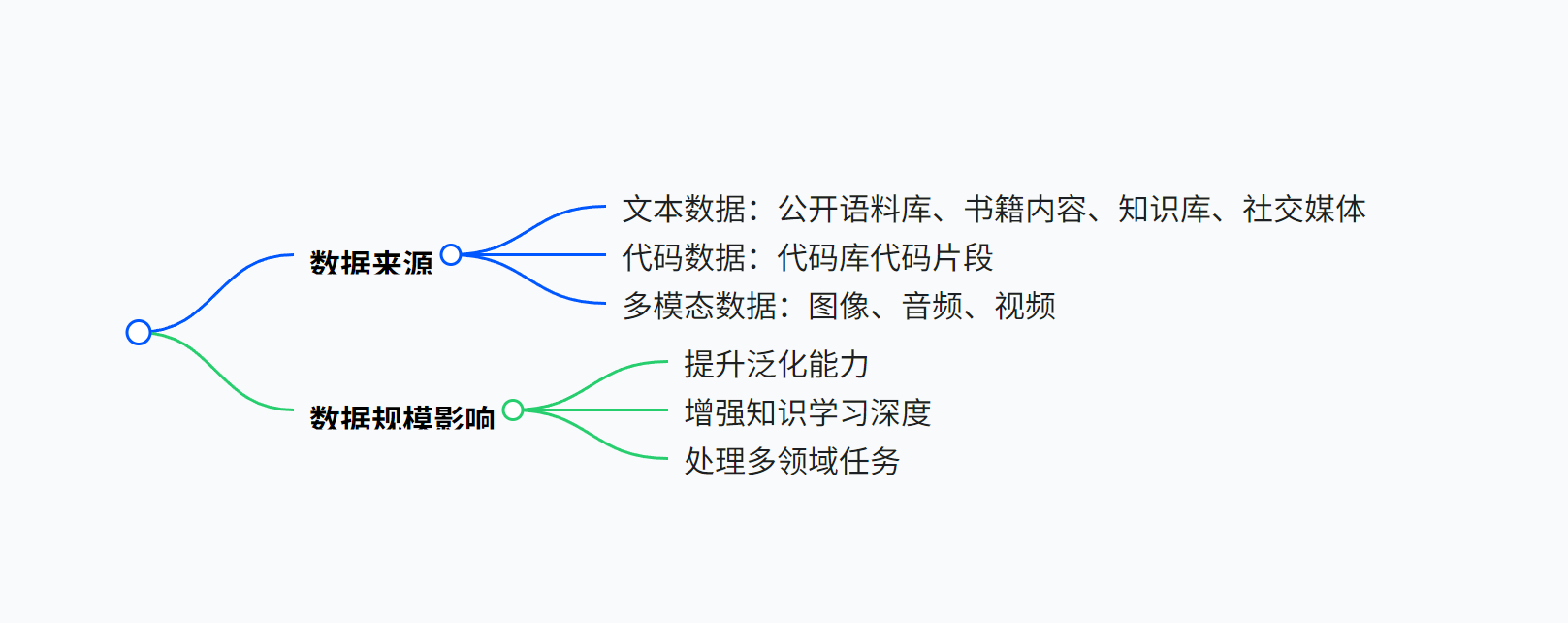

一、数据准备阶段(数据是大模型训练的基石)

-

多源数据:数据来源的多样性堪称大模型训练的基石。它涵盖了文本、图像、音频、视频等多种数据类型,从新闻资讯、社交媒体到学术文献,从日常拍摄的照片到专业影视素材,从大众流行音乐到各类演讲实录,这些来源广泛、形式各异的数据,为大模型的训练注入了丰富的知识与信息,是模型得以学习复杂模式、理解多元场景,进而生成高质量、多样化输出的根本所在 。

- 公开语料库如 Common Crawl,像一座巨大的知识宝库,包含了海量的、非结构化的、多语言的网页数据集,超过 8 年的网络爬虫数据集,拥有PB级规模;

- Books3 则聚焦于丰富的书籍内容,包含近20万本书,为模型提供深度知识。

- 知识库 Wikidata 以结构化的形式存储海量知识,助力模型理解实体关系。

- 社交媒体平台产生的实时、多元内容,能赋予模型对流行文化和日常语言的敏锐感知。

- 代码库中各类编程语言的代码片段,有助于模型掌握编程逻辑和语言规范。

- 多模态数据,例如图像与对应语音文本对,打破单一文本的局限,使模型向更全面的智能进化。

-

数据规模:数据规模在大模型训练中占据核心地位,对训练效果起着决定性作用。大规模的数据能够为模型提供丰富多样的特征和模式,从而助力模型学习到更广泛、更深入的知识。数据量越大,模型就越有可能捕捉到数据中的细微规律,增强其泛化能力,提升在各类复杂任务中的表现。

以典型的大模型 GPT-4 为例,其训练数据量飙升至令人惊叹的万亿级 Token。此前的 GPT-3 就已使用约 570GB 文本,这些数据并非单一维度的堆砌,而是广泛覆盖多语言,从全球通用的英语,到小语种方言,让模型具备跨越语言障碍的能力;同时涉足多领域,包括严谨的科学文献、优美的文学作品、日常的对话交流等,使模型能够在不同场景下灵活运用知识,满足多样化的用户需求。

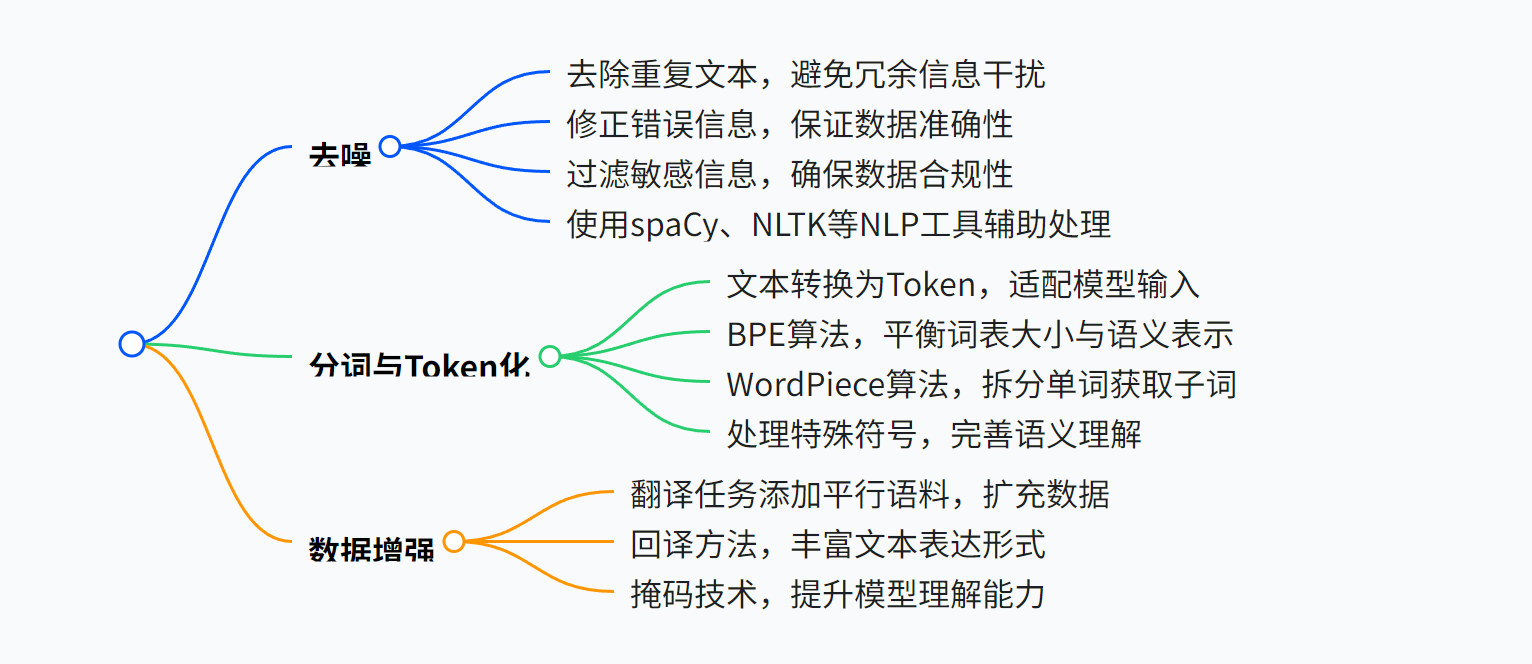

二、数据清洗与预处理(进一步夯实基础)

在大模型训练所涉及的海量原始数据中,往往充斥着各类噪声与瑕疵。数据清洗致力于识别并剔除那些错误、重复、缺失或异常的数据点,确保数据的准确性与一致性。而预处理则涵盖数据的标准化、归一化、编码转换等操作,其目的在于将原始数据转化为模型能够高效处理的格式,为后续的模型训练筑牢坚实的数据基础。

-

去噪:原始数据往往夹杂着大量杂质,严重影响模型训练效果。低质量内容如重复文本,不仅占用计算资源,还会干扰模型学习;错误信息可能误导模型产生偏差;敏感信息则存在隐私风险和伦理问题。为解决这些问题,常借助 NLP (自然语音处理)工具,如功能强大的 spaCy(一款用于自然语言处理(NLP)的开源软件库,由 Explosion AI 开发,支持多种自然语言处理任务,如词性标注、命名实体识别、依存句法分析等,能够帮助开发者高效处理文本数据),它能精准识别并过滤各类低质量内容;NLTK (自然语言工具包)也是常用利器,通过一系列算法和规则,对文本进行细致清洗,确保输入模型的数据纯净、可靠。

-

分词与 Token 化:自然语言对于模型而言难以直接理解,因此需要将文本转换为模型可处理的 Token。常见的 BPE(字节对编码)算法,通过不断合并高频字节对,逐步构建词汇表,有效处理词表外的新词汇;WordPiece 算法则基于词的子单元进行切分,在处理未知词(UNK)时表现出色。在这个过程中,还需妥善处理特殊符号,确保其在模型中的正确表示,从而让模型能够准确 “理解” 文本的含义。

-

数据增强:针对特定任务,提升数据的多样性至关重要。以翻译任务为例,添加平行语料,即不同语言表达相同含义的文本对,能显著增强模型的翻译能力。此外,回译方法通过将文本翻译为其他语言再译回,创造出语义相近但表述不同的新文本;掩码技术则通过随机遮蔽部分文本,让模型预测被遮蔽内容,促使模型学习到更丰富的语言知识和语义关联,进一步丰富训练数据,提升模型泛化能力。

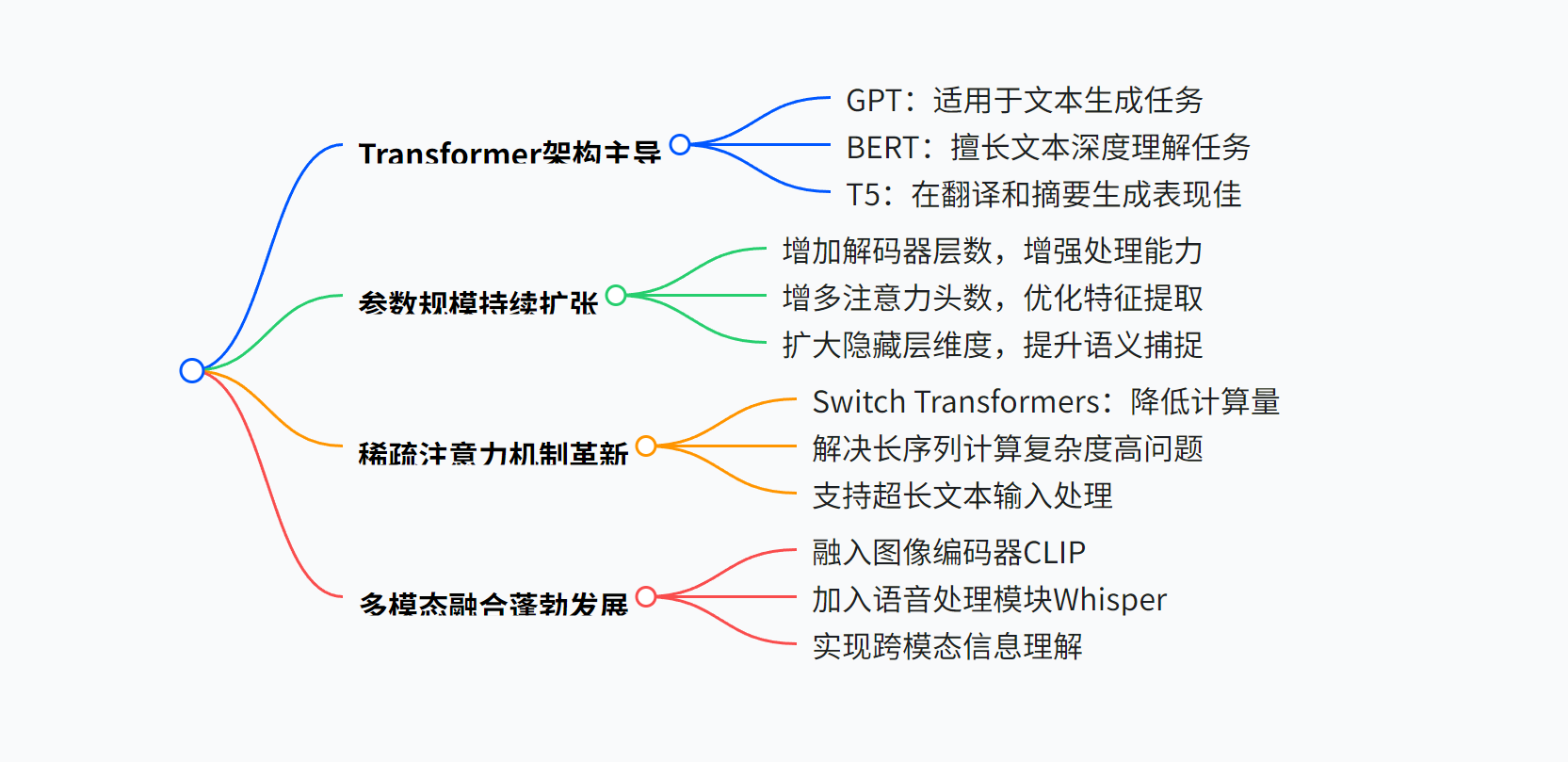

三、模型架构设计(决定着大模型的方向)

模型架构设计在大模型训练中占据着极为关键的地位,它决定了模型的整体框架与运行逻辑。从经典的 Transformer 架构衍生出的各种变体,到针对特定任务优化的独特结构,每一种架构都有着其独特的优势与适用场景。合理的架构设计不仅能够提升模型对数据特征的捕捉能力,还能在计算效率、参数规模控制等方面发挥重要作用。

- Transformer 架构主导:在当下大模型领域,以 GPT、BERT、T5 为代表的主流模型,均构建于 Transformer 架构之上。BERT 采用编码器结构,在自然语言处理任务里,擅长对文本的深度理解,如语义分析、文本分类等任务中表现卓越;GPT 则聚焦于解码器结构,能够依据给定提示,流畅生成高质量文本,无论是文章创作、对话回复;T5 创新性地采用编解码结构,在文本的翻译、摘要生成等任务中,充分发挥编解码协同的优势,展现出强大的适应性。

- 参数规模持续扩张:随着模型性能提升的需求,参数规模不断拓展。以 GPT-3 为例,其解码器层数多达 96 层,通过加深网络层次,增强模型对复杂语义关系的捕捉能力。注意力头数的增加,使得模型能从不同角度关注文本信息;隐藏层维度的提升同样关键,如 GPT-4 的参数规模飙升至 1.8 万亿,大幅扩充模型的 “记忆容量”。不过,在参数规模膨胀过程中,计算效率与性能之间的平衡成为亟待解决的难题,如何在有限计算资源下,发挥大规模参数的优势,是研究人员重点攻克的方向。

- 稀疏注意力机制革新:为破解长序列计算复杂度高的难题,稀疏注意力机制应运而生,典型代表如 Switch Transformers。它通过巧妙筛选关键信息,避免对长序列中所有元素进行全面计算,显著降低计算量。这一创新成果直接反映在模型处理文本长度上,例如 GPT-4,凭借类似优化,已能支持 32K+Token 的超长文本输入,为处理长篇文档、复杂对话场景提供可能。

- 多模态融合蓬勃发展:为赋予模型更全面的感知能力,多模态融合成为热门研究方向。像 CLIP 这样的图像编码器融入,使模型能将图像特征与文本信息关联,理解图像对应的语义描述;Whisper 等语音处理模块的加入,让模型可对语音数据进行分析处理。以 GPT-4V 为代表,实现了图像、文本、语音等多模态信息的跨模态理解,如能根据图像内容生成描述文本,或是理解语音指令并做出准确回应 。

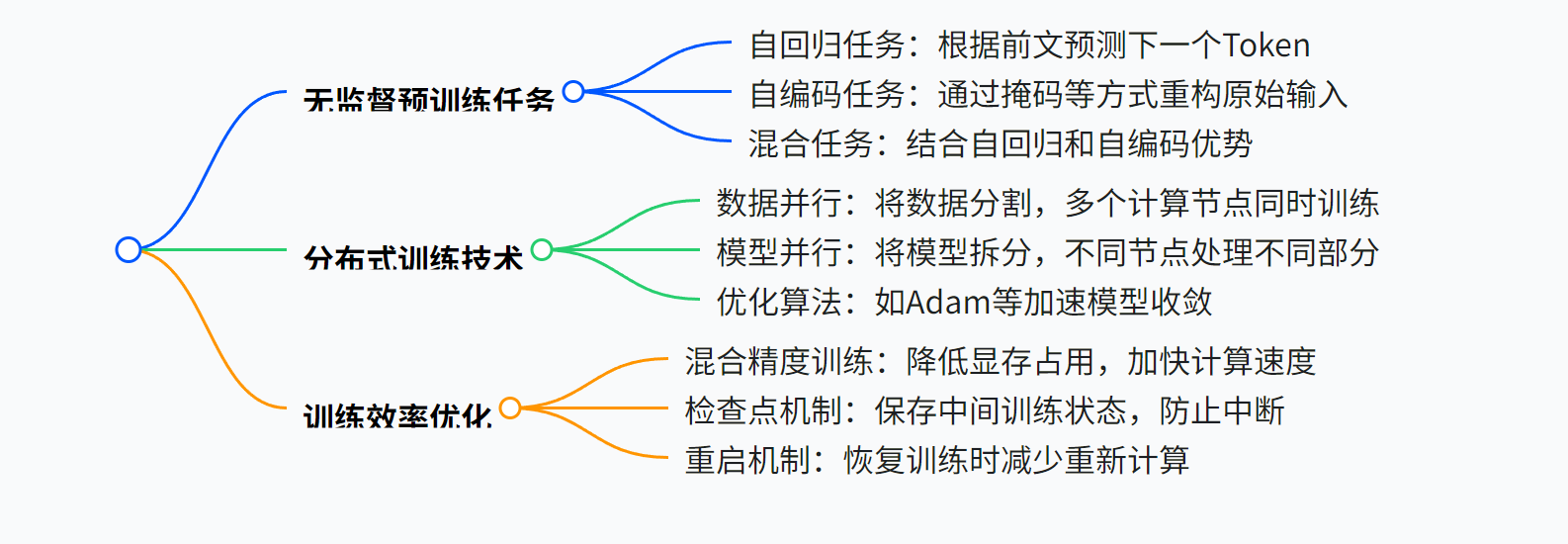

四、预训练阶段(核心环节,大模型开始成型)

- 无监督预训练任务

-

在大模型训练中占据关键地位。这类任务无需人工标注数据,通过让模型对海量无标签文本进行自主学习,挖掘文本中的潜在结构、语义关系以及语言模式。例如,模型可在大规模语料库中,学习词语的共现规律、句子的语法结构等,从而构建起对语言的基础理解能力。

-

自回归(AR,Autoregressive):以 GPT 系列模型为典型代表,自回归模型通过不断预测下一个 Token 来逐步构建文本,从而学习强大的生成能力。在训练过程中,模型基于前面已经生成的 Token,对下一个可能出现的 Token 进行概率预测,其损失函数通常采用交叉熵损失函数。这种损失函数能够有效衡量模型预测结果与真实标签之间的差异,通过最小化该损失,模型不断优化自身参数,提升生成文本的准确性与流畅性。例如,在生成一段连贯的故事时,模型会依据前文的情节、语言风格等信息,预测下一个最有可能出现的单词,以此类推完成整个文本的创作。

-

自编码(AE,Autoencoder):BERT 模型采用了自编码的方式进行训练,主要通过掩码语言模型(MLM)和下一句预测(NSP)两大任务来学习文本的语义表征。在 MLM 任务中,模型对输入文本中的部分 Token 进行掩码处理,然后尝试预测这些被掩码的 Token,以此促使模型理解文本中词汇之间的语义关系;而 NSP 任务则是判断两个句子在逻辑上是否具有先后承接关系,帮助模型学习句子间的连贯信息。例如,给定一段被掩码部分词汇的新闻报道,BERT 模型能利用上下文信息准确预测出被掩码的词汇,并且能够判断出两个句子是否属于同一新闻事件的不同描述部分。

-

混合任务:T5 模型创新性地结合了 “文本到文本” 框架,将所有自然语言处理任务统一转化为文本生成问题。以机器翻译任务为例,输入格式为 “translate English to French: X”,这里的 X 代表待翻译的英文文本,模型会依据输入指令,输出对应的法语译文。这种统一的框架使得 T5 模型无需针对不同任务设计复杂的结构调整,仅通过调整输入指令和输出目标,就能灵活应对如文本摘要、问答系统等多种任务。

2.分布式训练技术

在大模型训练中,由于数据量庞大、计算复杂度高,单机训练往往难以满足需求。分布式训练技术通过将训练任务拆分到多个计算节点上并行执行,极大地提升了训练效率。这些节点可以是同一数据中心内的多台服务器,也可以是分布在不同地理位置的计算资源。常见的分布式训练架构包括数据并行、模型并行和优化算法,它们各自适用于不同的场景,能够充分利用集群的计算能力,加速模型收敛,助力大模型从海量数据中高效学习。

-

数据并行:数据并行是一种常见的分布式训练策略,它将大规模训练数据均匀分片,分别分配到多个 GPU 或 TPU 等计算设备上。在训练过程中,每个设备基于各自所分到的数据计算梯度,随后通过同步或异步的方式更新模型的梯度。同步更新时,所有设备等待彼此完成梯度计算后,统一进行梯度更新,确保模型参数在每个训练步骤中保持一致;异步更新则允许设备在完成梯度计算后立即更新模型参数,无需等待其他设备,提升了训练效率,但可能会导致模型收敛的稳定性略有下降。Megatron - LM 便是采用数据并行技术的典型案例,通过高效的数据并行策略,能够在大规模数据集上快速训练超大规模的语言模型。

-

模型并行:模型并行侧重于将模型的不同层拆分到不同的计算设备上。例如在 MoE(混合专家模型)中,每个专家模块负责处理特定类型的输入数据,并且将这些专家模块分别部署在独立的硬件设备上。当输入数据进入模型时,不同的设备并行处理各自负责的模型层或专家模块,最后将处理结果进行汇总整合。这种方式能够充分利用不同设备的计算资源,有效解决因模型规模过大而导致单个设备无法承载的问题,同时加速模型的训练过程。

-

优化算法:在大模型训练中,AdamW、RMSprop 等优化器被广泛应用。AdamW 在经典 Adam 优化器的基础上,引入了权重衰减机制,能够有效防止模型过拟合。RMSprop 则通过自适应调整学习率,根据参数梯度的均方根来动态缩放学习率,使得模型在训练过程中能够更稳定地收敛。此外,结合学习率调度策略,如余弦退火调度,学习率会随着训练轮次呈余弦函数形式逐渐衰减,模拟物理退火过程,让模型在训练前期快速收敛,后期则精细调整参数;线性衰减调度则是按照线性规律逐步降低学习率,避免模型在训练后期因学习率过大而出现震荡,进一步提升模型的训练效果,减少过拟合风险。

3.训练效率优化

-

混合精度训练:混合精度训练技术利用 FP16(半精度浮点数)和 FP32(单精度浮点数)混合计算的方式来提升训练效率。在计算过程中,大部分矩阵乘法等运算采用 FP16 进行,因为 FP16 占用的显存仅为 FP32 的一半,这能显著减少模型训练过程中的显存占用,使得能够在相同硬件条件下处理更大规模的模型和数据。同时,为了保证计算精度,对于一些关键的计算步骤,如梯度计算等,仍使用 FP32。PyTorch 的 Amp 库为实现混合精度训练提供了便捷的工具,通过简单的代码调用,即可快速开启混合精度训练模式,加速模型训练进程。

-

检查点与重启机制:为了防止训练过程中因硬件故障、软件错误等意外情况导致训练中断而造成大量计算资源的浪费,大模型训练通常会采用检查点与重启机制。训练过程中,模型会定期保存当前的状态,包括模型参数、优化器状态、训练轮次等信息。当出现故障时,训练程序能够从最近保存的检查点中恢复训练,加载之前保存的模型状态,继续后续的训练步骤,避免了从训练起始点重新开始计算,大大节省了训练时间和资源。

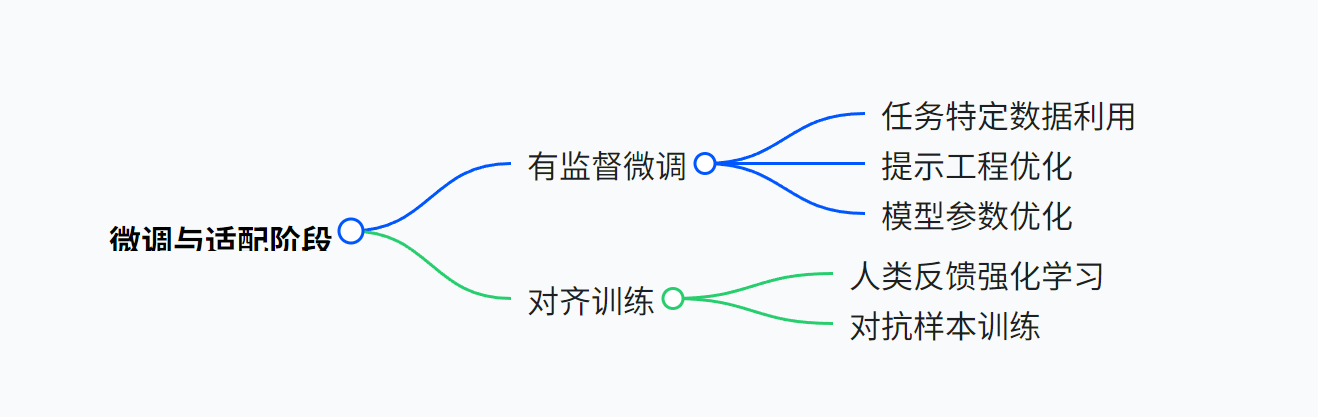

五、微调与适配阶段(大模型的优化)

1.有监督微调(SFT,Supervised Fine-Tuning)

作为大模型训练过程中的关键环节,有监督微调是在预训练模型的基础上,利用大量带有明确标注信息的数据集,通过反向传播算法对模型参数进行进一步优化的技术手段。在这一阶段,模型将学习数据中的特定模式与规律,以更好地适配下游的具体任务需求,如文本分类、情感分析、机器翻译等。

-

任务特定数据:针对下游任务,如问答、摘要等,运用标注数据对模型进行微调操作。在这一过程中,依据实际需求对模型的部分或全部参数展开调整,使得模型能够精准适配特定任务场景,从而有效提升任务执行的准确性与效率。

-

提示工程(Prompt Tuning):借助优化输入提示的方式来引导模型输出期望结果。例如构造 “请总结以下文本:{文本}” 这样的提示语,精准明确模型的任务。同时,为降低计算成本与训练复杂度,减少全量参数调整,可采用诸如 LoRA、QLoRA 等先进技术,在保障模型性能的前提下,显著提升提示优化的效能。

2.对齐训练(Alignment)

旨在让模型的输出与人类的价值观、期望以及特定应用场景的要求达成一致。通过精心设计训练流程与目标函数,促使模型理解并遵循人类所期望的行为模式与输出规范。

-

人类反馈强化学习(RLHF):以 ChatGPT 为典型代表,该方法借助人类标注的偏好数据,运用近端策略优化(PPO)算法对模型进行优化。在此过程中,模型通过不断试错与学习人类反馈,逐步调整自身参数,使得输出结果在符合伦理道德标准的同时,兼具逻辑合理性,并能精准契合用户的意图,极大地提升了用户体验。

-

对抗样本训练:着重增强模型对恶意输入,比如对抗性 Prompt 的抵抗能力与鲁棒性。通过在训练数据中人为引入精心构造的对抗样本,模拟真实场景下可能遭遇的攻击,让模型在训练过程中学会识别并应对此类恶意输入,确保在面对各种复杂甚至恶意的输入时,依然能够稳定、准确地输出结果,保障模型的安全性与可靠性。

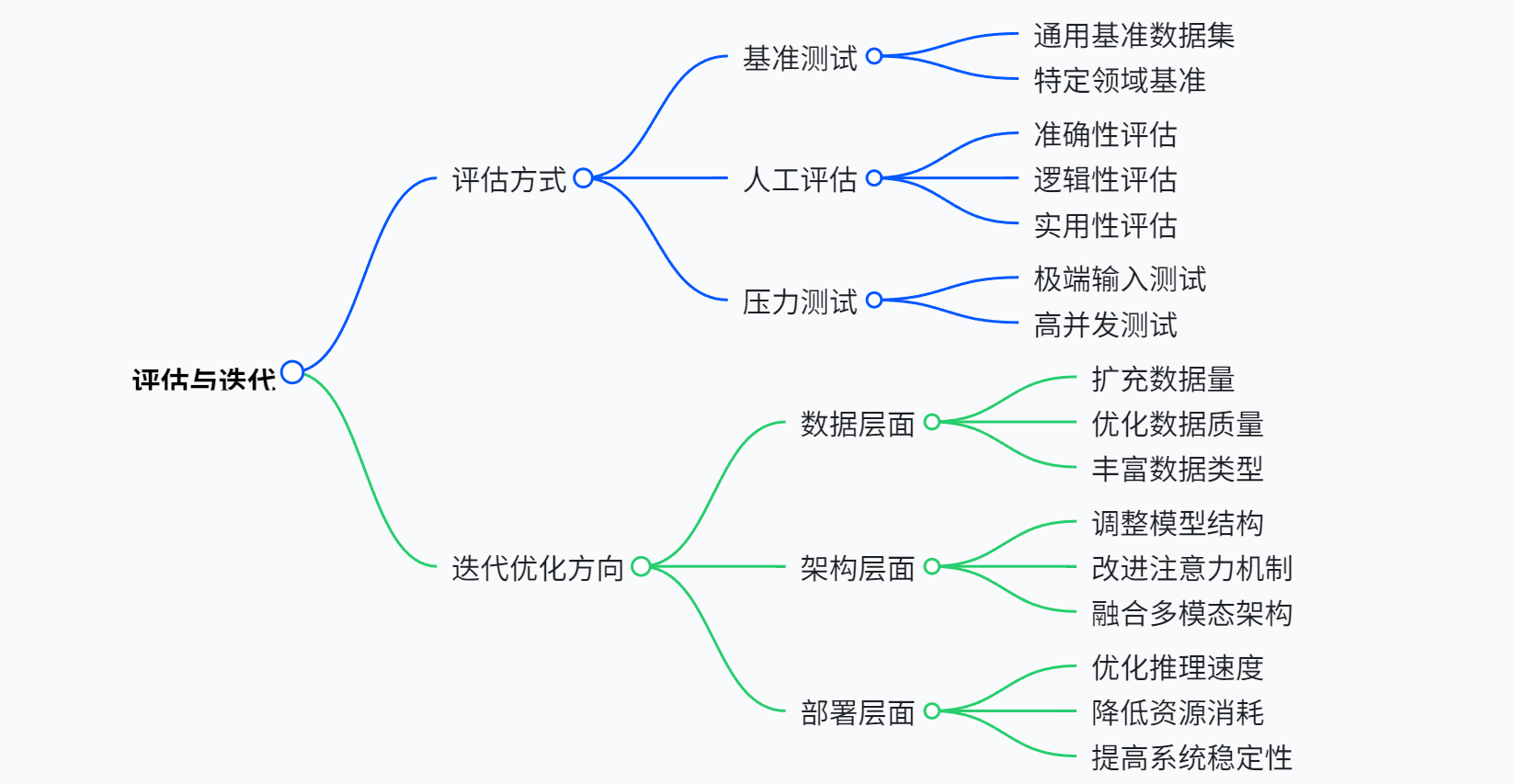

六、评估与迭代(判断大模型是否达到预期)

1.多维度评估

-

基准测试:借助 GLUE、SuperGLUE 这类自然语言领域的权威数据集,以及 MMLU 多任务数据集,对模型性能展开全面评估。通过在这些数据集上执行各类任务,从语言理解、语义分析等多个维度,精准量化模型的表现水平。

-

人工评估:组建专业素养过硬的团队,对模型生成内容进行严格审核。重点聚焦准确性,确保输出内容与客观事实相符;关注安全性,杜绝模型生成可能存在风险或有害的信息;强调相关性,避免出现偏见、传播错误信息等情况。

-

压力测试:模拟极端场景来考验模型,比如输入超长文本,测试模型处理长序列信息的能力;设置复杂的逻辑推理任务,检验模型的逻辑思维水平;安排代码生成任务,评估模型在编程领域的应用表现。

2.迭代优化

-

数据迭代:深入分析模型在不同领域的表现,针对薄弱领域,如科学文献、法律文本等专业性较强的领域,补充大量高质量数据,丰富模型的知识储备。同时,仔细排查并修复数据偏差,保证数据的均衡性与准确性。

-

架构改进:对模型架构进行优化调整,例如在注意力机制中引入旋转位置编码 RoPE,增强模型对位置信息的捕捉能力,提升序列建模效果;优化专家混合模型(MoE)的路由效率,让模型在处理不同任务时,能够更高效地调用合适的专家模块。

-

轻量化部署:运用量化技术,将模型精度调整至 8bit/4bit,在保证一定性能的前提下大幅减少存储需求;采用剪枝技术,去除模型中冗余的连接与参数,精简模型结构;借助知识蒸馏方法,如 DistilBERT,将大模型的知识迁移至小模型,使模型能够适应边缘设备有限的计算资源与存储条件。

写在最后

大模型训练是数据、算法、工程的深度融合,其核心在于通过超大规模无监督预训练捕捉通用知识,再通过微调适配具体任务。未来趋势包括更高效的训练范式、更强的多模态能力、以及与外部工具的深度结合,推动 AI 从 “通用智能” 向 “实用智能” 进化。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)