如何在ollama中导入并运行GGUF模型文件

在GGUF文件相同的位置创建一个Modelfile文件,使用文本编辑器写一句话表示GGUF模型文件的路径即可。GGUF文件是模型的量化文件,可以从Huggingface或者魔塔社区进行下载。SYSTEM “你是一个专业AI助手,请根据用户输入回答问题,不要编造信息。模型创建成功之后可以通过下面的命令查看。模型创建成功之后可以通过下面的命令查看。

如何在ollama中导入并运行GGUF模型文件

一、GGUF模型下载

GGUF文件是模型的量化文件,可以从Huggingface或者魔塔社区进行下载。

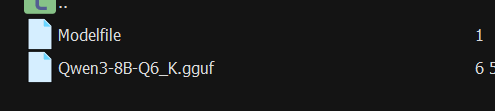

二、Modelfile文件创建

在GGUF文件相同的位置创建一个Modelfile文件,使用文本编辑器写一句话表示GGUF模型文件的路径即可。下面以Qwen3-8B为例:

FROM ./Qwen3-8B-Q6_K.gguf

三、Ollama创建模型

在终端命令中输入下面的命令运行,ollama中本地模型就创建成功了,其中Qwen3-8B是自己定义的模型名称,例如我的模型名称为Qwen3-8B,则命令为:

ollama create Qwen3-8B -f Modelfile

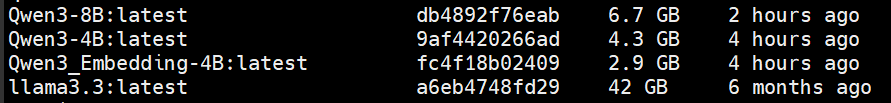

四、Ollama查看模型列表

模型创建成功之后可以通过下面的命令查看。

ollama list

五、Ollama运行模型

模型创建成功之后可以通过下面的命令查看。

ollama run Qwen3-8B

注:运行模型发现模型出现自问自答

原因是并不是所有 GGUF 都嵌入了聊天模板,而 ollama 使用的是通用{{ .Prompt }}模板,所以修改Modelfile的内容为:

FROM ./Qwen3-8B-Q6_K.gguf

SYSTEM “你是一个专业AI助手,请根据用户输入回答问题,不要编造信息 。”

TEMPLATE “”“<|im_start|>system

{{ .System }}

<|im_end|>

<|im_start|>user

{{ .Prompt }}

<|im_end|>

<|im_start|>assistant

“””

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)