LLM Studio本地部署deepseek的API调用,基于Python实现简易对话客户端

本教程将详细介绍如何使用LM Studio在本地部署DeepSeek大模型,并构建一个带图形界面的聊天应用。教程从模型导入到客户端开发,适合零基础用户跟随操作。

本教程将详细介绍如何使用LM Studio在本地部署DeepSeek大模型,并构建一个带图形界面的聊天应用。教程从模型导入到客户端开发,适合零基础用户跟随操作。

目录

本地部署:零基础本地部署DEEPSEEK大模型教程(LM Studio版)_lm studio部署deepseek-CSDN博客

本地部署:零基础本地部署DEEPSEEK大模型教程(LM Studio版)_lm studio部署deepseek-CSDN博客

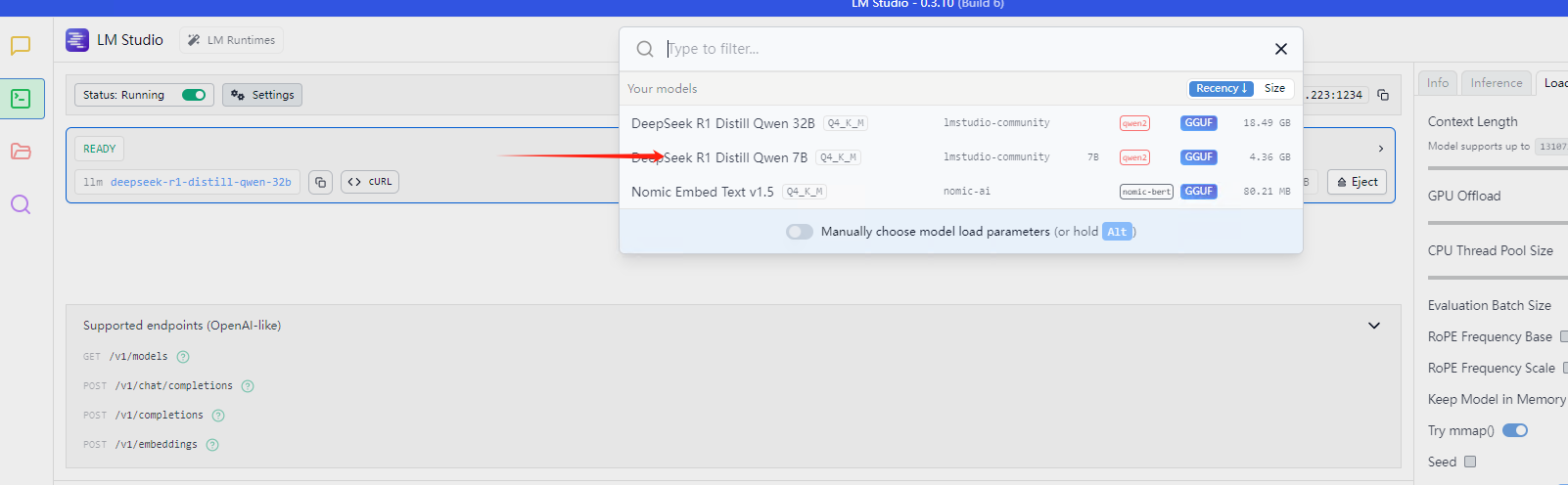

第一步:导入模型

-

在LM Studio的模型搜索栏中输入"deepseek"

-

选择适合你硬件配置的模型版本(如

deepseek-r1-distill-qwen-32b) -

点击下载按钮等待模型下载完成

注意事项:

-

模型文件较大(可能超过10GB),确保有足够的磁盘空间

-

下载速度取决于网络状况,可能需要较长时间

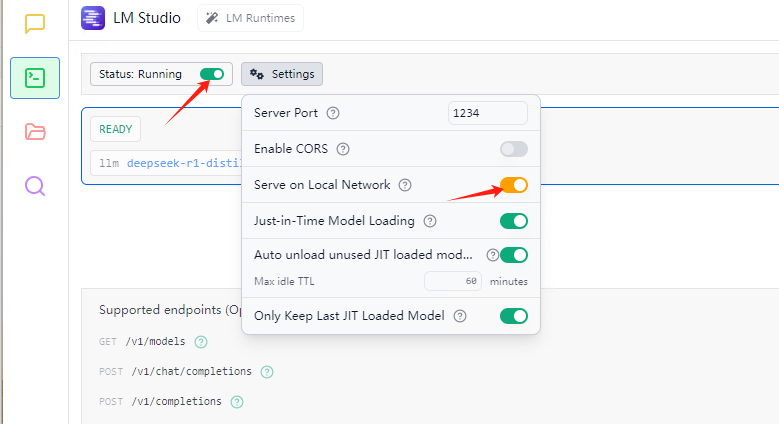

第二步 配置LLM Studio

-

在LM Studio左侧导航栏选择"Local Server"

-

确保"Enable API Server"选项已开启

-

记下API地址(通常是

http://localhost:1234)

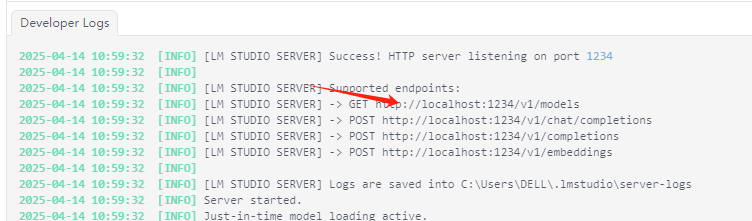

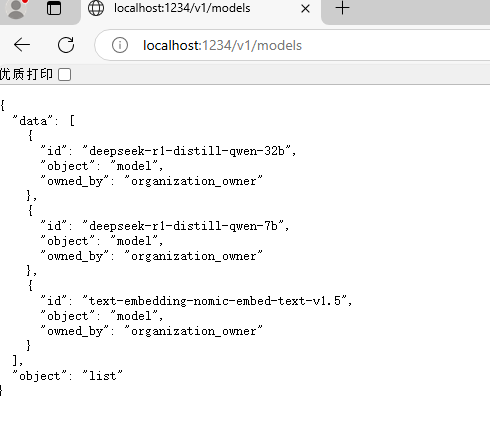

第三步 检验

复制http://localhost:1234/v1/modes

到浏览器,如果看到类似下面的响应,说明服务运行正常:

常见问题解决:

-

如果连接被拒绝,检查LM Studio是否正在运行且API服务已启用

-

确保防火墙没有阻止1234端口的访问

第四步 编写客户端代码进行测试

安装依赖

pip install tk requests PyPDF2 python-docx -i https://mirrors.aliyun.com/pypi/simple/客户端代码,以下是完整的GUI客户端代码,支持聊天和文件上传功能:

import tkinter as tk

from tkinter import ttk, filedialog, scrolledtext

import requests

import PyPDF2 # 用于读取 PDF

import docx # 用于读取 Word 文档

from threading import Thread

class DeepSeekChatApp:

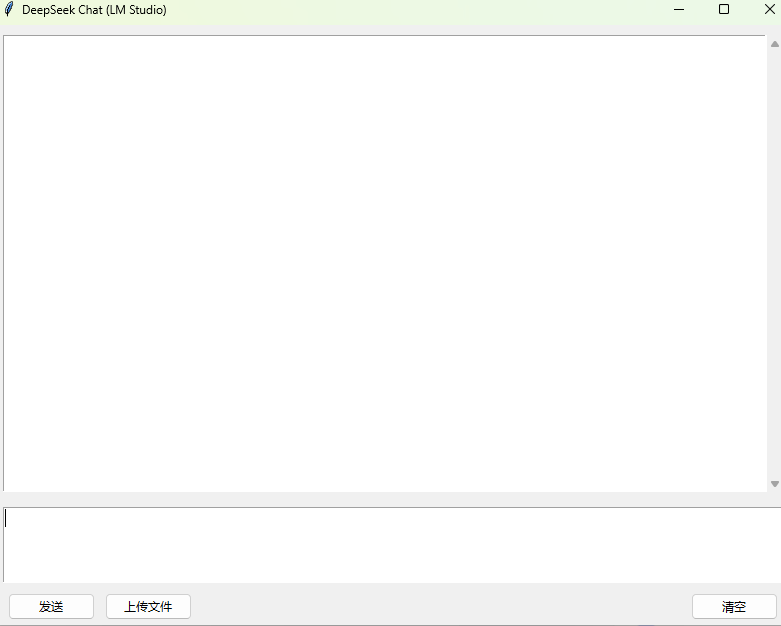

def __init__(self, root):

self.root = root

self.root.title("DeepSeek Chat (LM Studio)")

self.root.geometry("800x600")

# LM Studio API 配置

self.api_url = "http://10.80.32.223:1234/v1/chat/completions" # 替换为你的 LM Studio API 地址

self.headers = {"Content-Type": "application/json"}

self.model = "deepseek-r1-distill-qwen-32b" # 替换为你的模型名称

# 聊天记录显示

self.chat_display = scrolledtext.ScrolledText(

root, wrap=tk.WORD, state='disabled', font=("Arial", 12))

self.chat_display.pack(fill=tk.BOTH, expand=True, padx=10, pady=10)

# 用户输入框

self.user_input = tk.Text(root, height=4, font=("Arial", 12))

self.user_input.pack(fill=tk.X, padx=10, pady=5)

# 按钮框架

button_frame = tk.Frame(root)

button_frame.pack(fill=tk.X, padx=10, pady=5)

# 发送按钮

self.send_button = ttk.Button(

button_frame, text="发送", command=self.send_message)

self.send_button.pack(side=tk.LEFT, padx=5)

# 文件上传按钮

self.upload_button = ttk.Button(

button_frame, text="上传文件", command=self.upload_file)

self.upload_button.pack(side=tk.LEFT, padx=5)

# 清空聊天按钮

self.clear_button = ttk.Button(

button_frame, text="清空", command=self.clear_chat)

self.clear_button.pack(side=tk.RIGHT, padx=5)

# 初始化聊天历史

self.chat_history = []

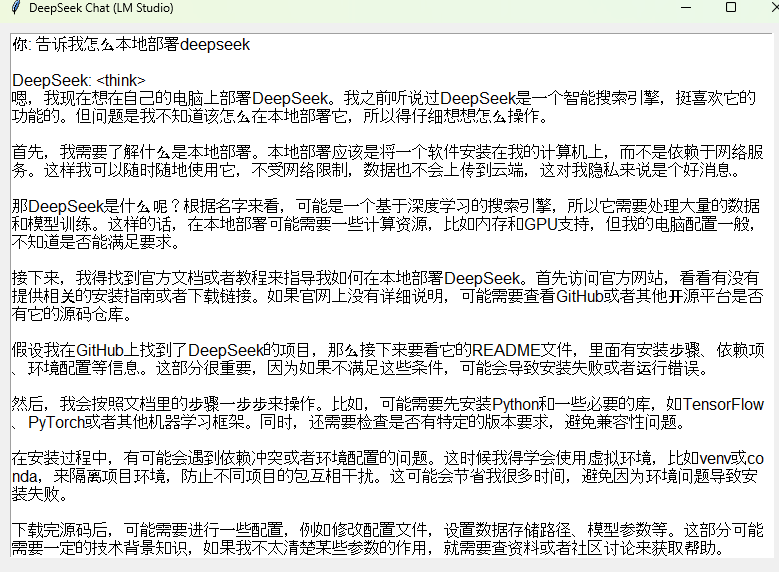

def send_message(self):

"""发送用户消息并获取 DeepSeek 的回复"""

user_message = self.user_input.get("1.0", tk.END).strip()

if not user_message:

return

# 更新聊天记录

self.update_chat_display("你", user_message)

self.user_input.delete("1.0", tk.END)

# 发送请求到 LM Studio API

self.chat_history.append({"role": "user", "content": user_message})

payload = {

"model": self.model,

"messages": self.chat_history,

"stream": False # 是否流式传输(LM Studio 可能不支持)

}

# 在新线程中发送请求,避免 GUI 卡顿

Thread(target=self.fetch_response, args=(payload,)).start()

def fetch_response(self, payload):

"""获取 DeepSeek 的回复"""

try:

response = requests.post(

self.api_url,

headers=self.headers,

json=payload,

timeout=200 # 60 秒超时

)

if response.status_code == 200:

assistant_reply = response.json()["choices"][0]["message"]["content"]

self.chat_history.append({"role": "assistant", "content": assistant_reply})

self.update_chat_display("DeepSeek", assistant_reply)

else:

error_msg = f"API 错误: {response.status_code} - {response.text}"

self.update_chat_display("系统", error_msg)

except Exception as e:

self.update_chat_display("系统", f"请求失败: {str(e)}")

def upload_file(self):

"""上传文件并读取内容"""

file_path = filedialog.askopenfilename(

filetypes=[("Text Files", "*.txt"), ("PDF Files", "*.pdf"), ("Word Files", "*.docx")])

if not file_path:

return

try:

content = ""

if file_path.endswith(".txt"):

with open(file_path, "r", encoding="utf-8") as f:

content = f.read()

elif file_path.endswith(".pdf"):

with open(file_path, "rb") as f:

pdf_reader = PyPDF2.PdfReader(f)

content = "\n".join([page.extract_text() for page in pdf_reader.pages])

elif file_path.endswith(".docx"):

doc = docx.Document(file_path)

content = "\n".join([para.text for para in doc.paragraphs])

self.update_chat_display("文件内容", f"已上传文件:\n{content}")

self.user_input.insert(tk.END, f"请总结以下内容:\n{content}") # 自动填充输入框

except Exception as e:

self.update_chat_display("系统", f"文件读取失败: {str(e)}")

def update_chat_display(self, sender, message):

"""更新聊天窗口"""

self.chat_display.config(state='normal')

self.chat_display.insert(tk.END, f"{sender}: {message}\n\n")

self.chat_display.config(state='disabled')

self.chat_display.see(tk.END) # 自动滚动到底部

def clear_chat(self):

"""清空聊天记录"""

self.chat_display.config(state='normal')

self.chat_display.delete("1.0", tk.END)

self.chat_display.config(state='disabled')

self.chat_history = []

if __name__ == "__main__":

root = tk.Tk()

app = DeepSeekChatApp(root)

root.mainloop()第五步 运行客户端脚本

注意:模型如果太大可能要响应很久,可以把超时时间设置长点,我这里设置的200s.

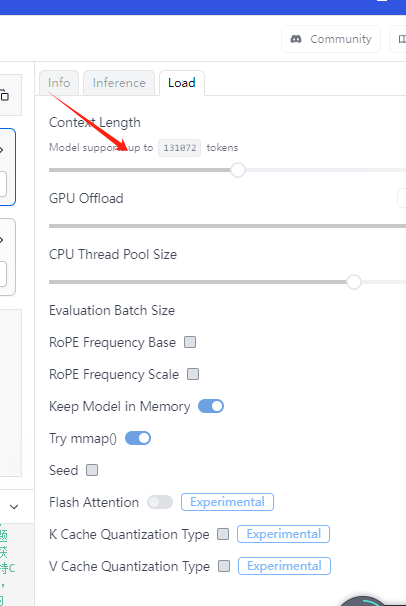

第六步 可调节参数

根据实际情况修改最大的文本长度,视GPU而定,如果太大系统会提示

常见问题及解决方案

1. 模型加载失败

现象: LM Studio无法加载模型或报内存错误

解决方案:

-

检查显卡驱动是否最新

-

尝试较小的模型版本

-

增加虚拟内存(Windows)或swap空间(Linux/Mac)

2. API请求超时

现象: 客户端报超时错误

解决方案:

-

增加代码中的

timeout值(如改为300秒) -

检查LM Studio是否正常工作

-

降低生成文本长度限制

3. 文件上传失败

现象: 文件内容读取错误

解决方案:

-

确保文件不是加密或受保护的

-

检查文件编码(特别是txt文件)

-

尝试用其他格式(如PDF转TXT)

4. 生成质量不佳

现象: 模型回复不相关或质量差

解决方案:

-

调整temperature参数(0.7左右通常较好)

-

检查提示词是否清晰明确

-

尝试不同的模型版本

5. 性能问题

现象: 响应速度慢

解决方案:

-

关闭其他占用GPU的程序

-

在LM Studio中降低"Context Length"设置

-

考虑使用量化版本模型

结语

通过本教程,你已经成功在本地部署了DeepSeek大模型并构建了一个功能完善的GUI客户端。这个方案特别适合需要隐私保护或离线使用的场景。随着模型的不断更新,你可以随时在LM Studio中下载最新版本,享受更强大的AI能力。

进阶建议:

-

尝试集成更多文件格式支持(如Excel、PPT)

-

添加对话历史保存/加载功能

-

实现流式输出,提升用户体验

-

探索模型微调功能,定制个性化AI助手

希望这篇教程对你有所帮助!如果在实施过程中遇到任何问题,欢迎在评论区留言讨论。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)