Ollama的自定义安装,配置环境变量与使用

这篇文章介绍了Ollama自定义安装和配置的方法。首先说明默认C盘安装会导致存储问题,建议安装到其他盘(如D:\Ollama)。安装步骤包括下载程序、指定安装目录和验证安装。其次讲解如何通过环境变量设置模型存储路径(如D:\Ollama\models),强调需重启电脑生效。最后演示基础使用方法:下载模型(如gemma3:1b)、交互对话、常用命令(查看/删除模型等)。全文提供了从安装到使用的完整指

Ollama介绍:Ollama 是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。它通过简化的命令行操作,让用户无需复杂配置即可调用诸如 DeepSeek、Qwen 等主流开源模型。

首先要明确下面3个问题:

1. 为什么要自定义安装Ollama? 答:因为默认安装路径在C盘,时间长了,指定报红

2. 为什么要配置环境变量? 答:因为模型的下载还是在C盘,所以要迁移到别的盘

3. 那Ollama怎么使用? 答:看我接下来的操作

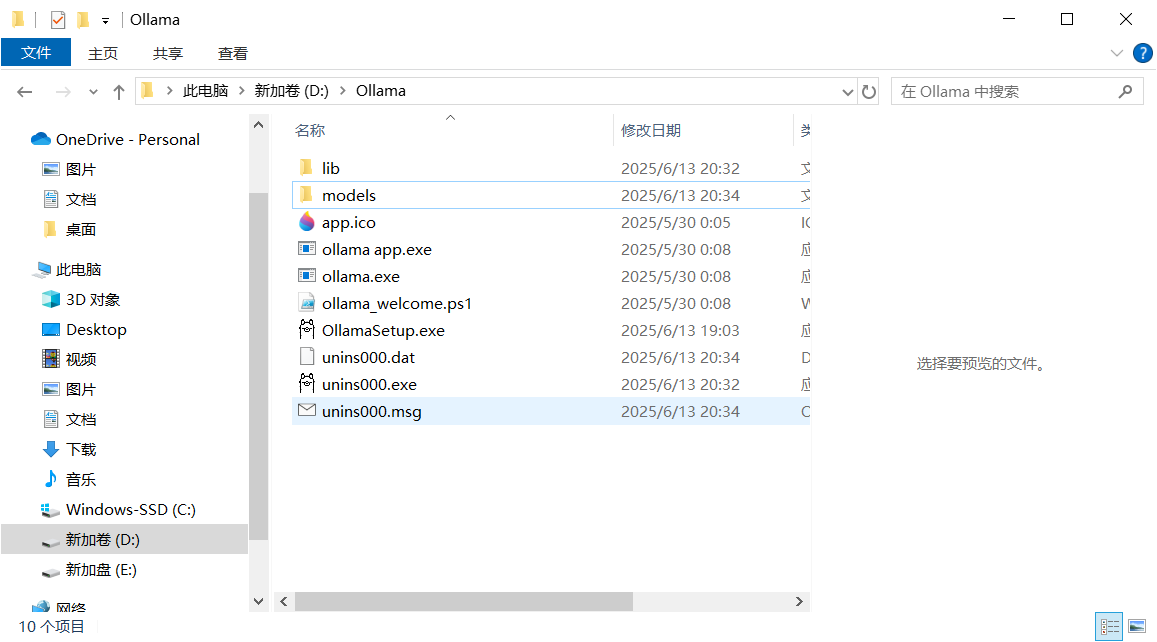

一、安装Ollama到指定的目录下,假如安装在"D:\Ollama"路径下,就需要提前创建好目录

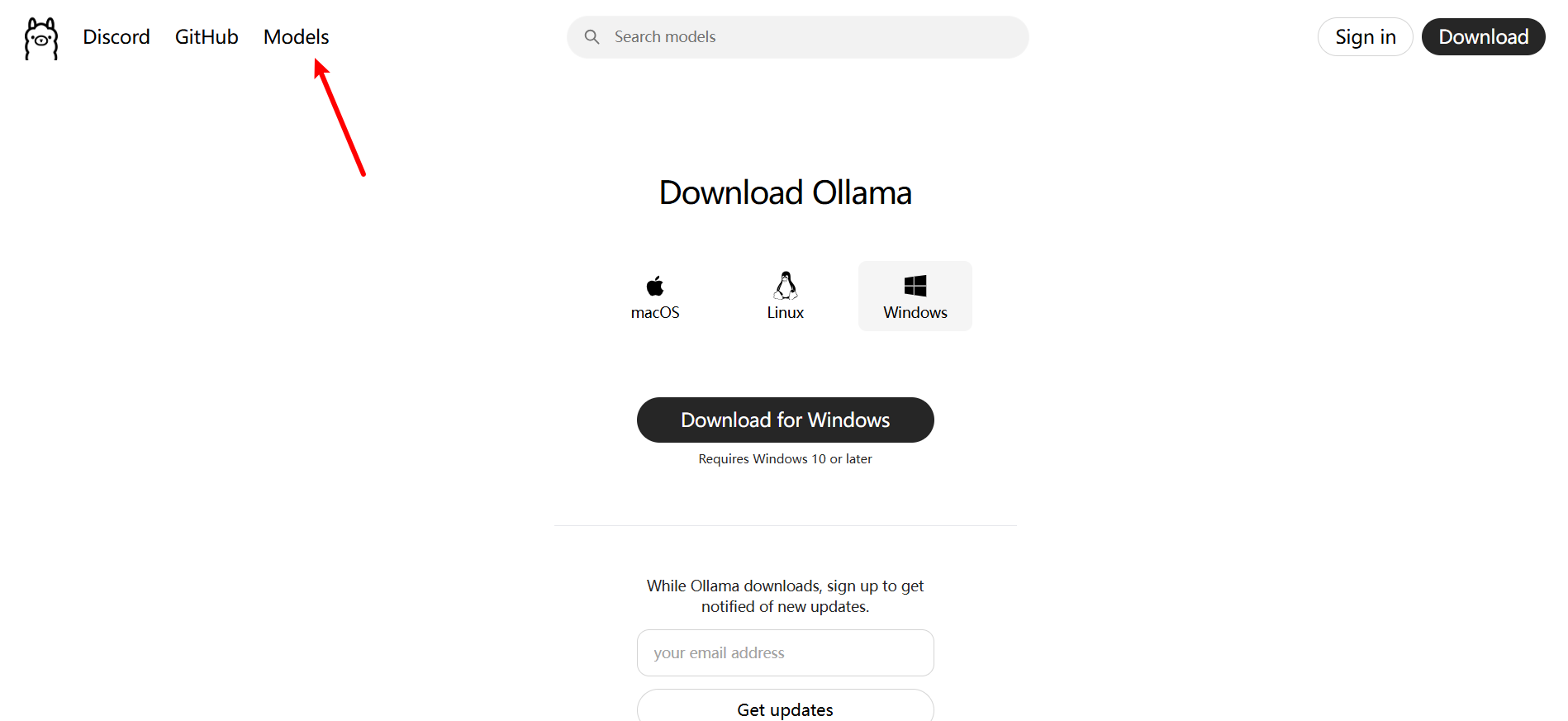

1. 点击官网Ollama,进行下载,如图:

点击Download下载,选择适合自己的版本:

点击"Download for Windows"下载Windows版本,如果下载的慢,可以使用"迅雷"下载

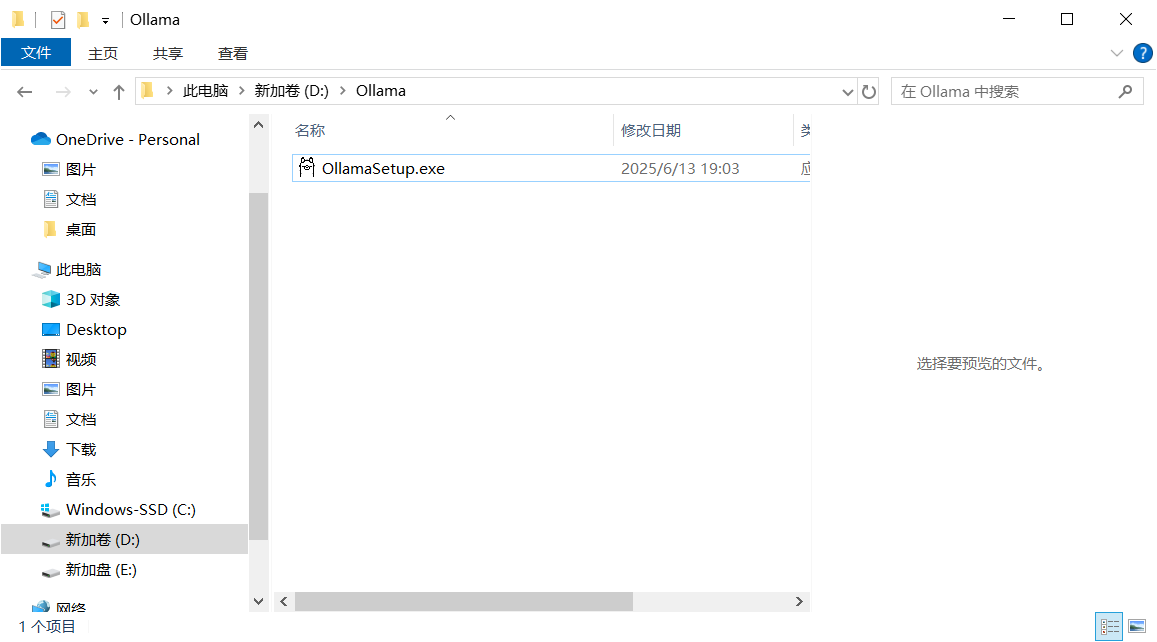

2. 将"OllamaSetup.exe"放在准备的"D:\Ollama"目录下

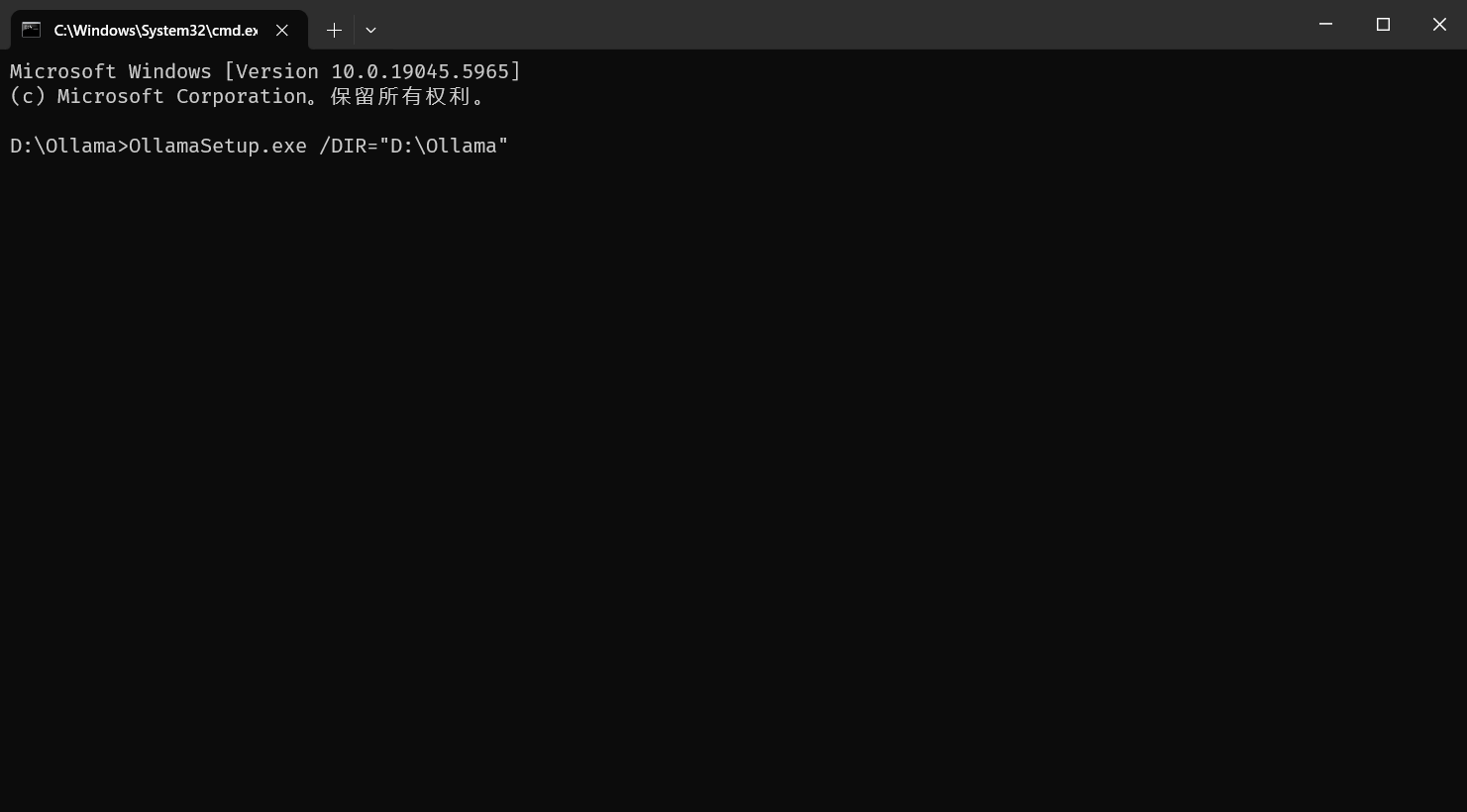

这里我使用了微软的Windows Terminal终端,接着通过cmd输入命令:

OllamaSetup.exe /DIR="D:\Ollama"

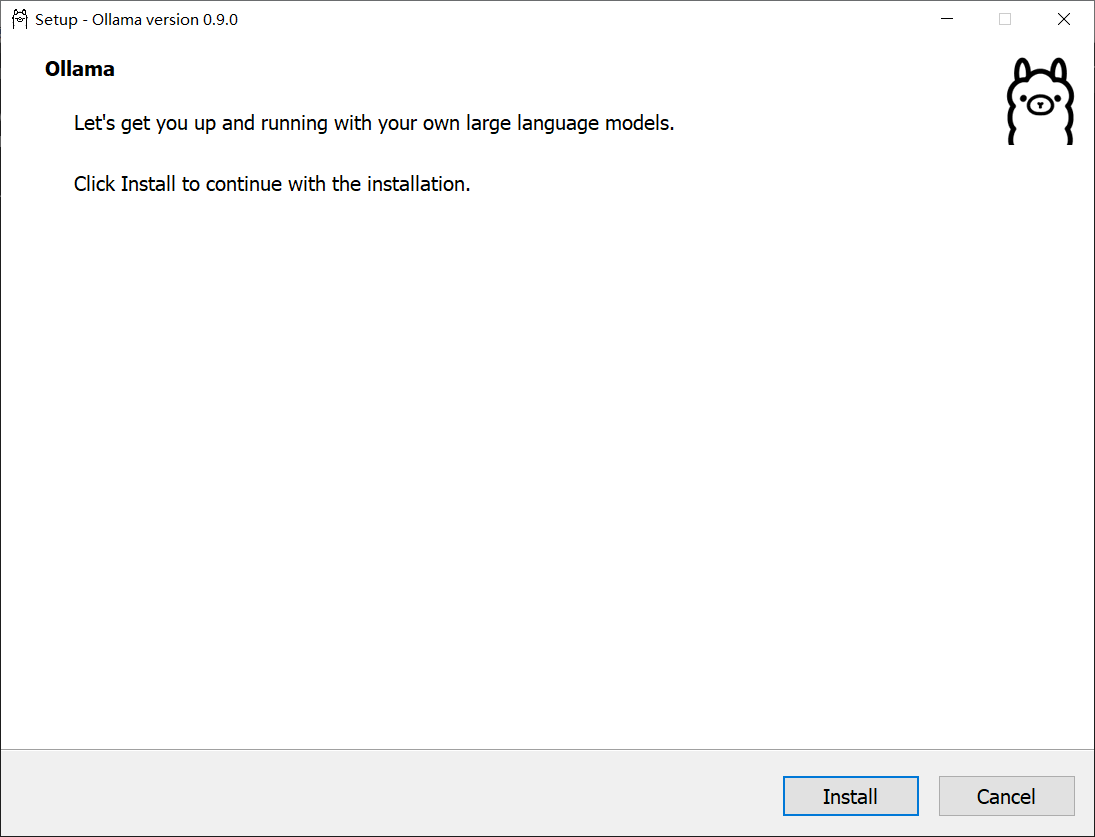

点击安装:

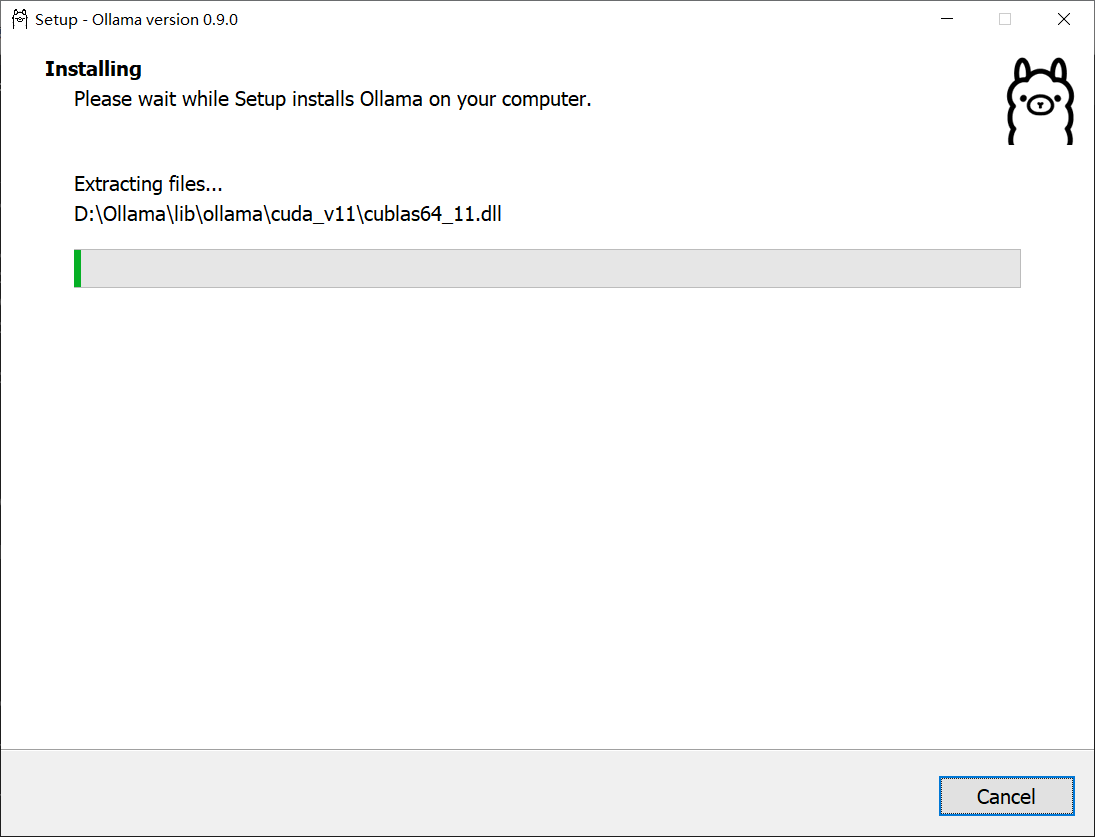

可以看到安装的目录在"D:\Ollama"下:

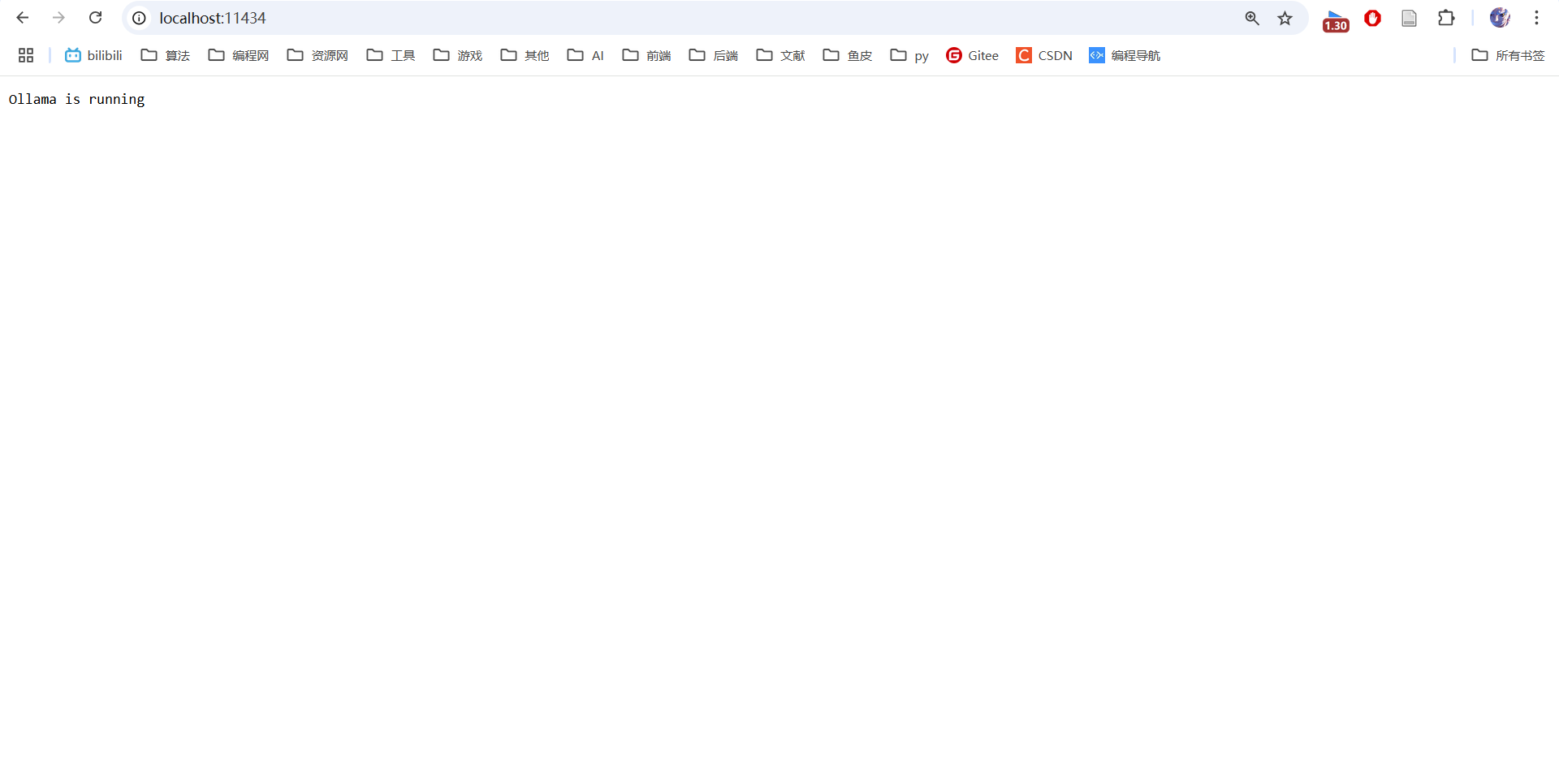

3. 检查是否安装成功,这里我提供2种常见方式:

3.1 在命令行输入:

ollama --version

3.2 浏览器地址栏输入:http://localhost:11434/

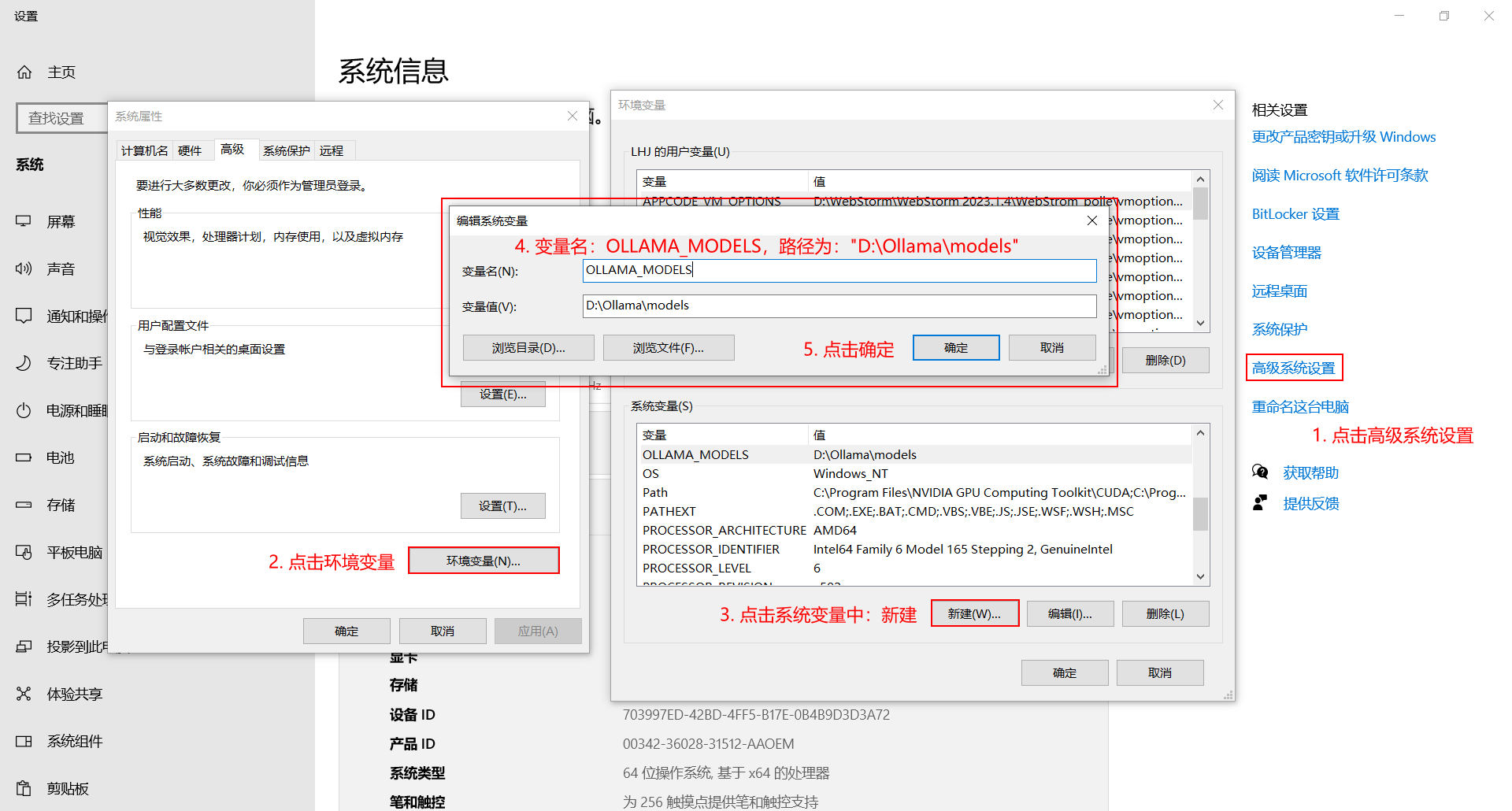

二、配置环境变量,使得每次下载的模型都在指定的目录下,可以将其转移到"D:\Ollama\models"

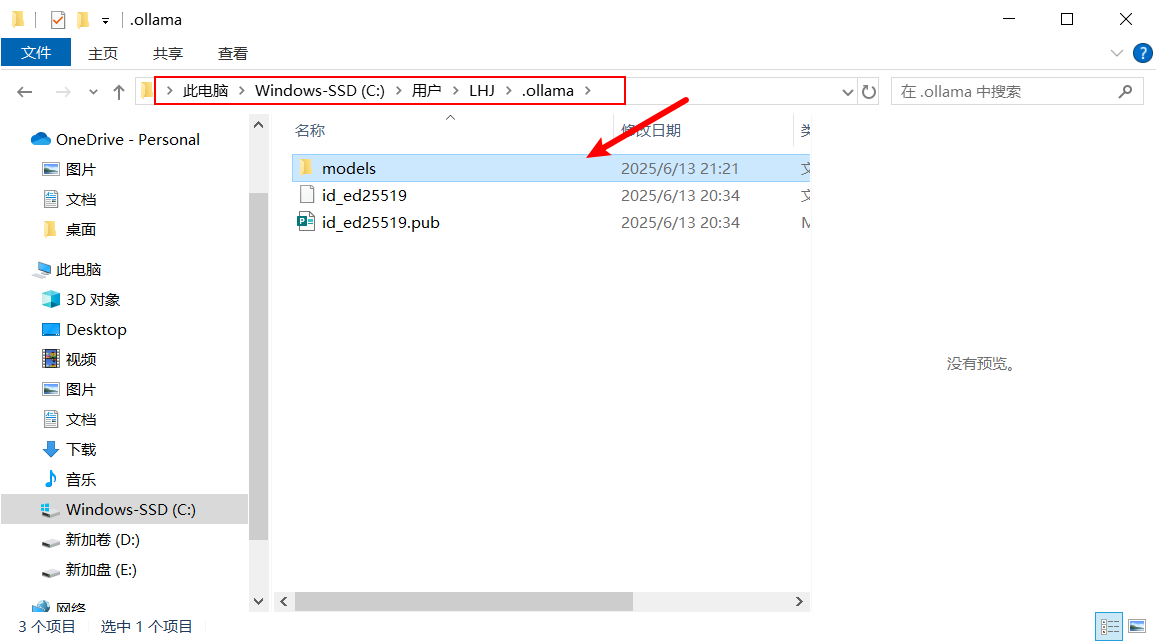

1. 找到如下目录的"models",将其剪切到"D:\Ollama",效果如第2个图:

2. 配置环境变量,指定模型下载的环境:

变量名:OLLAMA_MODELS

路径(变量值):D:\Ollama\models

3. 配置好环境变量后,一定要重启电脑!!!

三、Ollama的简单使用:

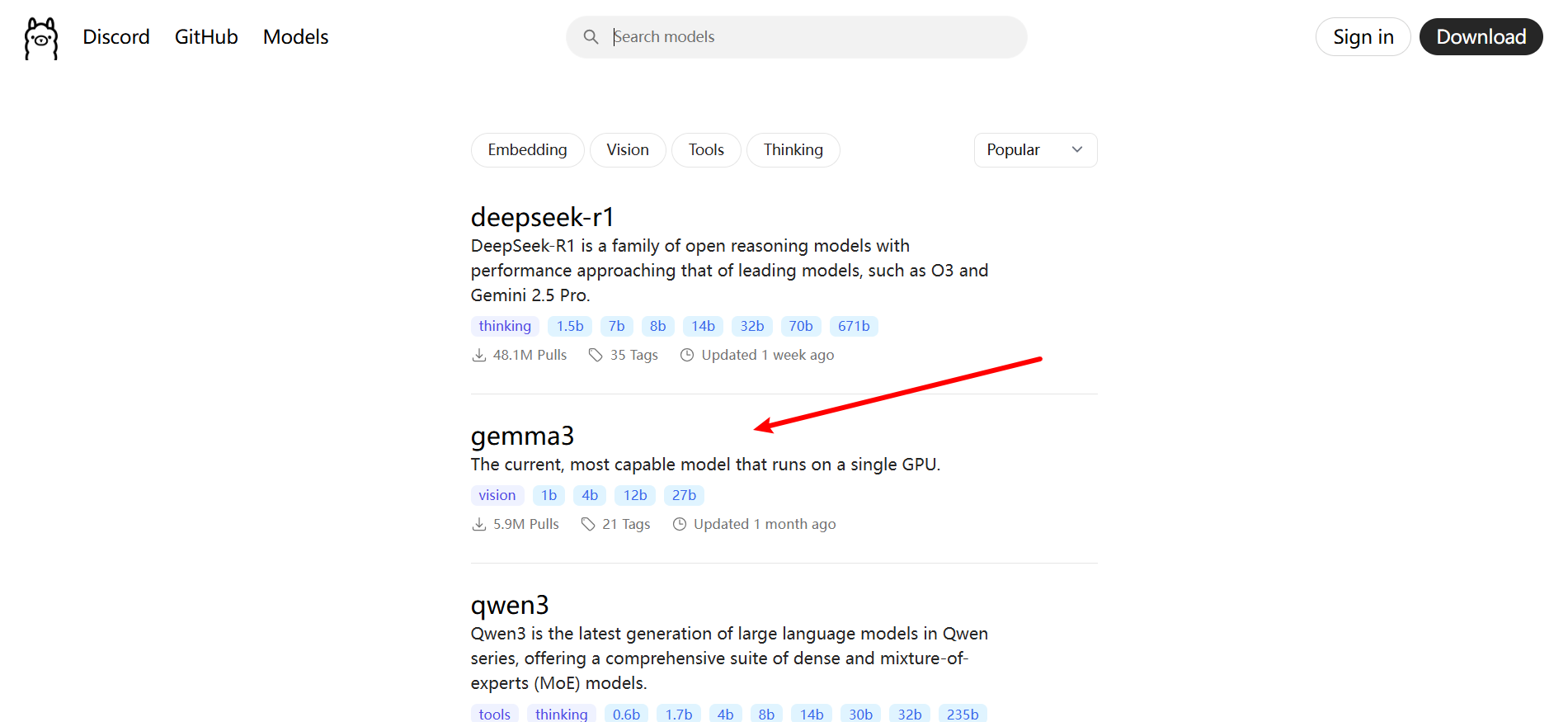

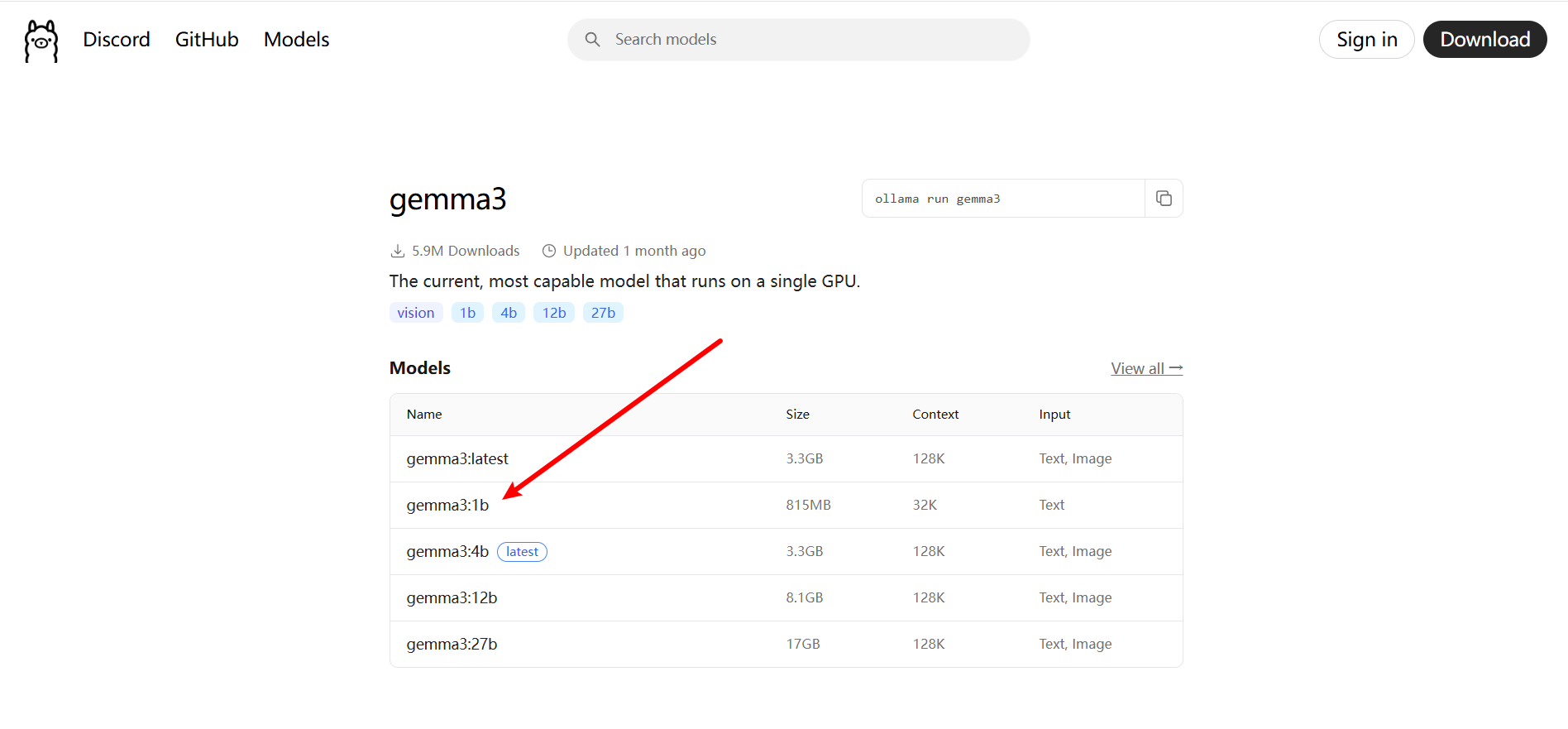

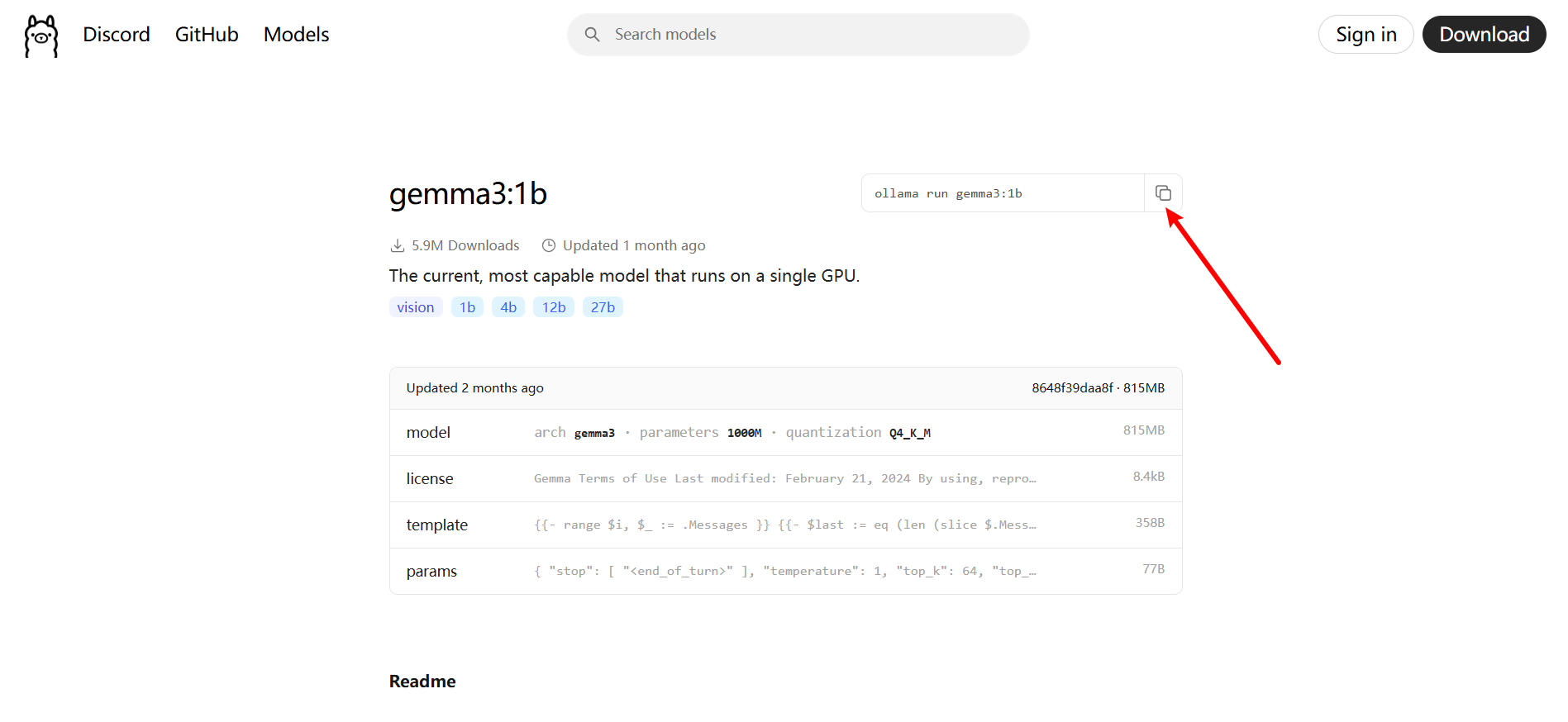

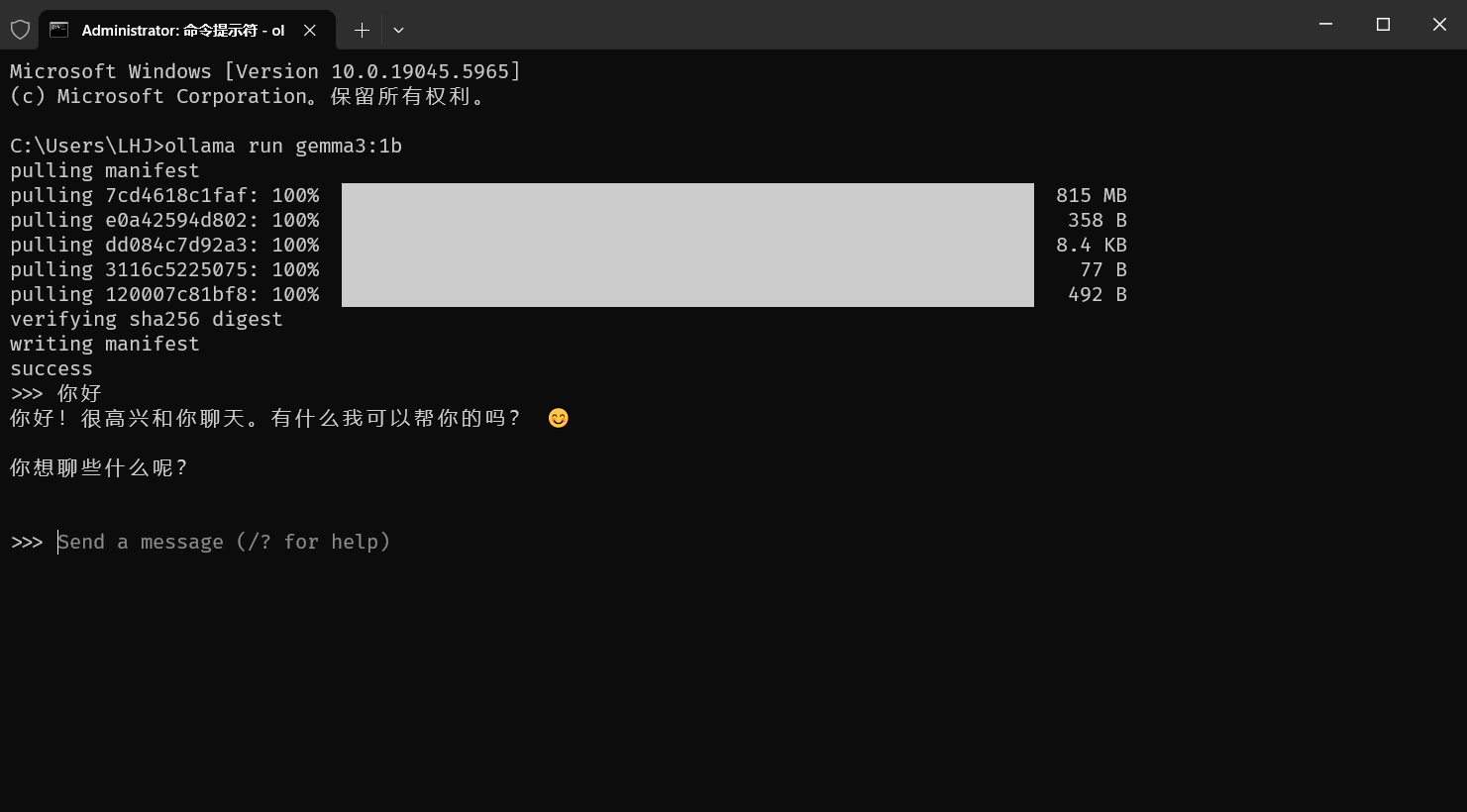

1. 下载模型,这里可以下载个简单的模型进行练习:gemma3:1b

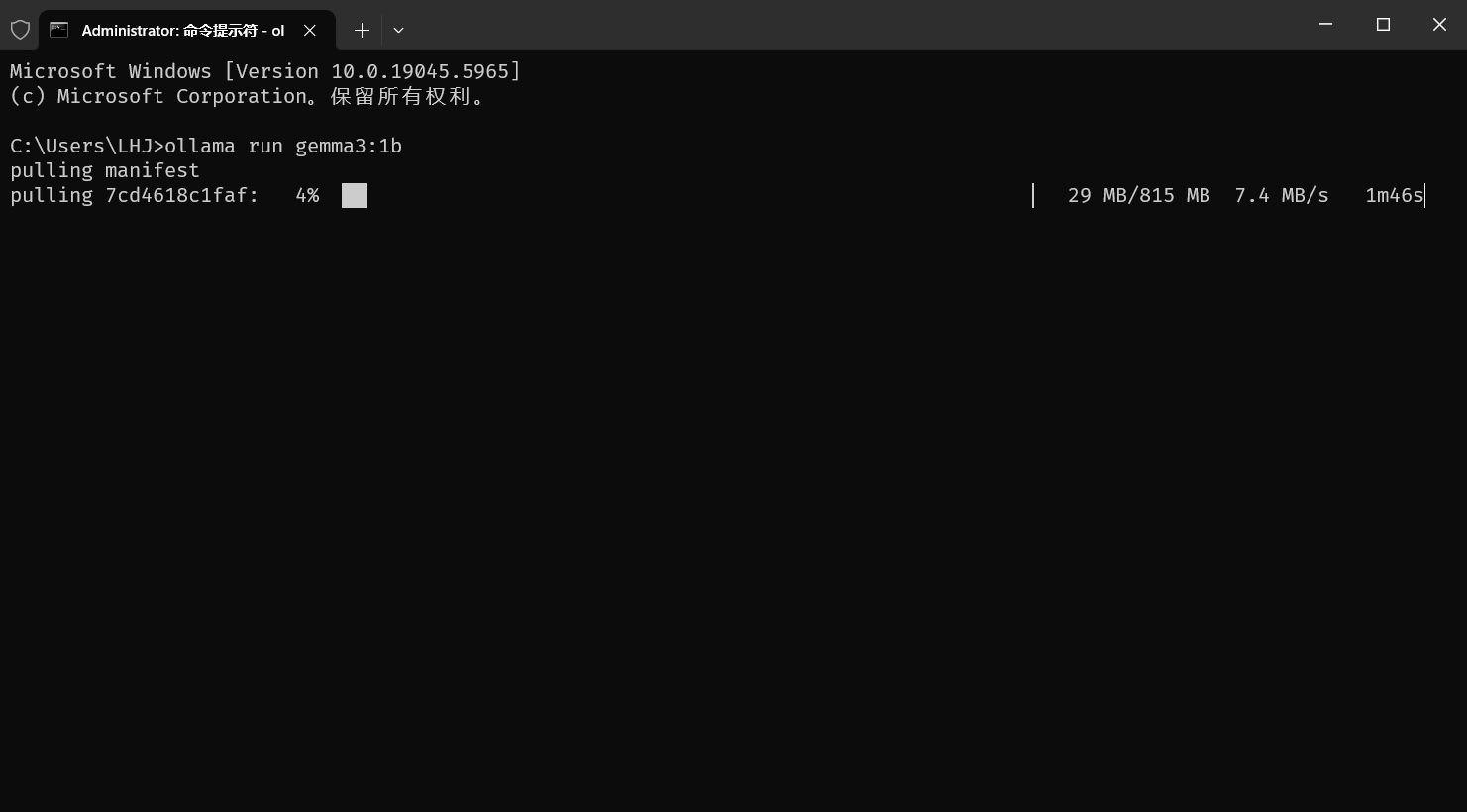

复制命令到cmd命令行,进行下载,(此时的命令行所在地址无所谓),等待下载完毕:

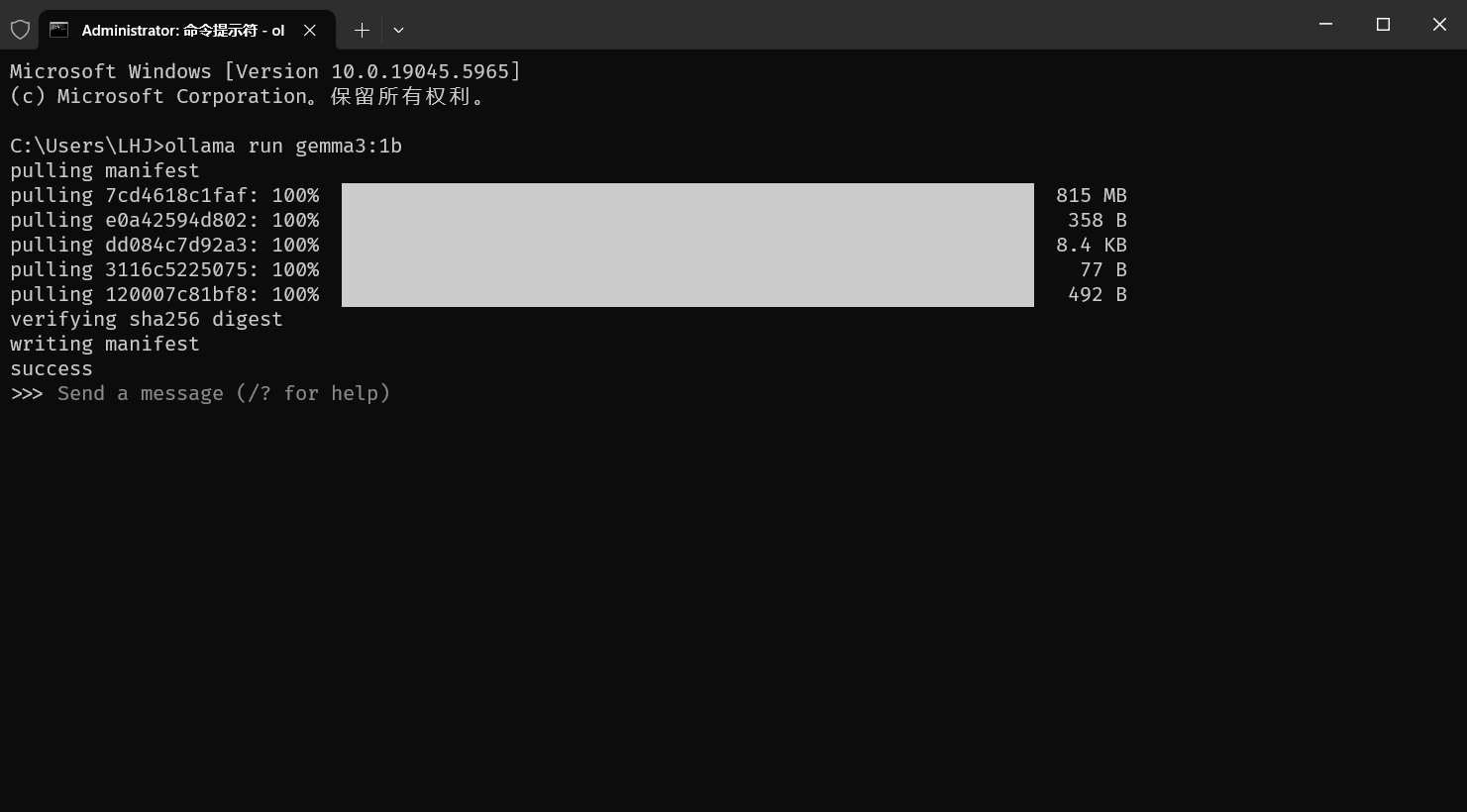

ollama run gemma3:1b

下载之后,自动进入模型中聊天:

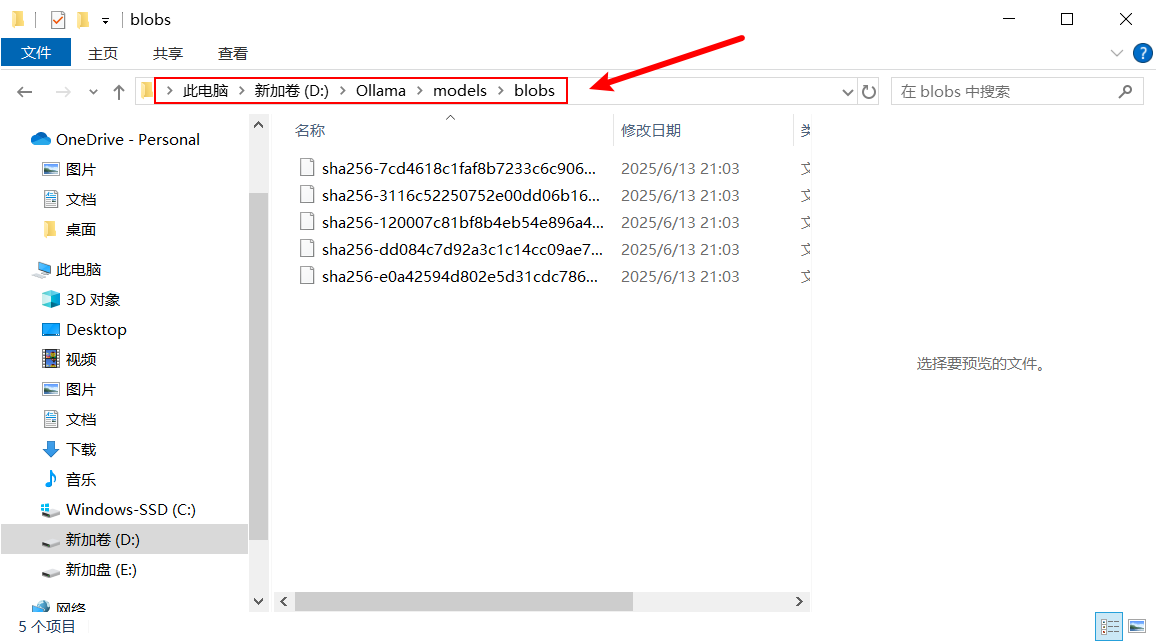

模型被下载到:"D:\Ollama\models\blobs"

2. 和模型聊天,比如输入:你好

3. 常用 ollama 命令的使用:

3.1 退出当前聊天:快捷键:"Ctrl + D"

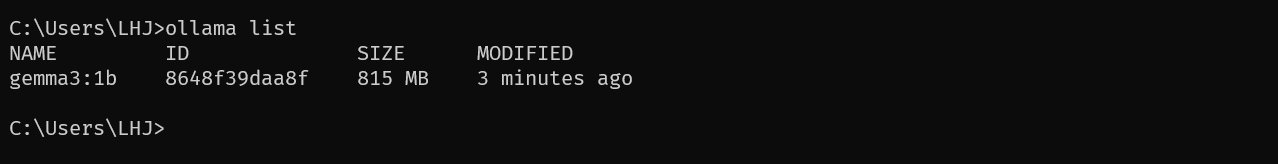

3.2 查看模型列表:

ollama list

3.3 删除模型:gemma3:1b

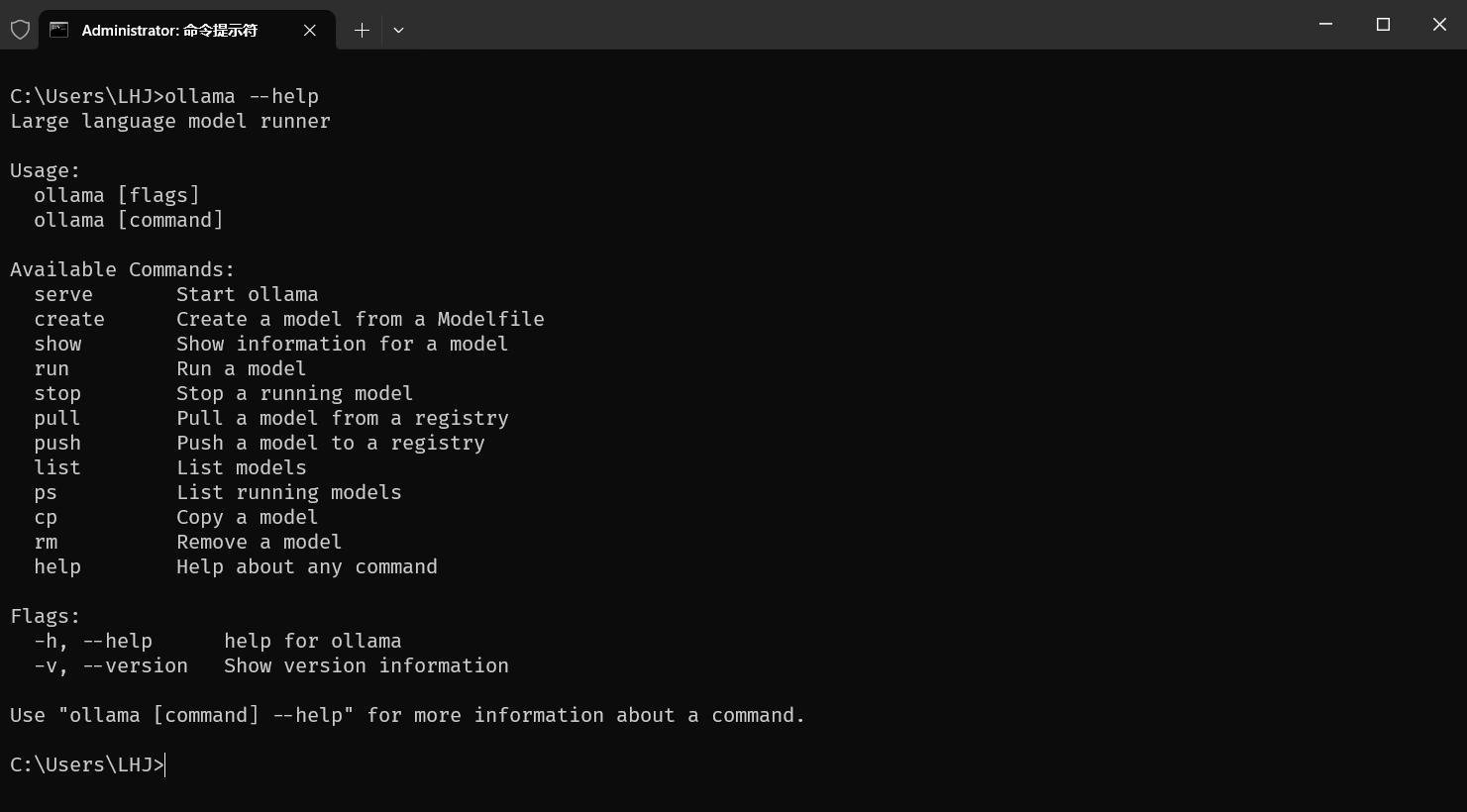

ollama rm gemma3:1b3.4 ollama的其他命令:

ollama --help

至此,关于 Ollama 的安装、配置、使用已讲解完毕。该框架的操作还是很容易上手滴。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)