AI入门2:本地AI部署,用ollama部署deepseek(私有化部署)

在ollama上,部署DeepSeek-R1,就可以在自己机器上,离线使用了,也就是deepseek的私有化部署。

书接上篇

从上一篇,了解了ollama是咱们管理大语言模型的管家婆:

AI入门:AI模型管家婆ollama的安装和使用-CSDN博客

而当下崛起势头最盛而且免费的大语言模型,就是deepseek公司的了,他家的娃:

- DeepSeek-R1:这是一个高性能的推理模型,在数学、代码和自然语言推理等任务上表现出色,性能与OpenAI的o1模型相媲美。

- DeepSeek Coder:这是DeepSeek推出的首个模型,免费提供商业使用,并完全开源。

- DeepSeek LLM:这是一个参数规模达到670亿的大语言模型,性能接近GPT-4,并发布了聊天版本DeepSeek Chat。

- DeepSeek V2:在性能上比肩GPT-4 Turbo,但训练成本极低。

- DeepSeek V3:这是一个总参数达到6710亿的大模型,多项性能指标与海外顶尖模型对齐,以更快的速度和更全面的功能提供服务。

本文就讲一下,在ollama上,部署DeepSeek-R1,就可以在自己机器上,离线使用了,也就是deepseek的私有化部署。

配置ollama的模型存在参数

Ollama会默认安装到C盘,ollama安装模型,会占用C盘空间,通过设置环境变量OLLAMA_MODELS,来改变ollama模型放目录的地址,具体操作,参考前面文档:

ollama环境变量配置:修改ollama的数据路径(安装路径)_ollama修改安装路径-CSDN博客

部署deepseek

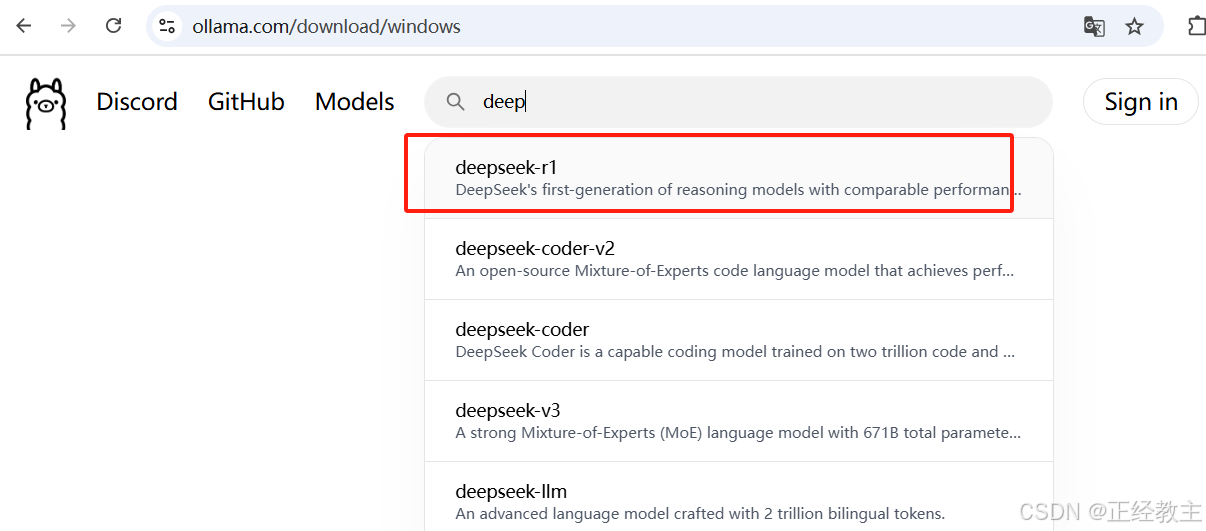

进入Ollama官网:Ollama https://ollama.com/![]() https://ollama.com/搜索并选择DeepSeek-R1模型:

https://ollama.com/搜索并选择DeepSeek-R1模型:

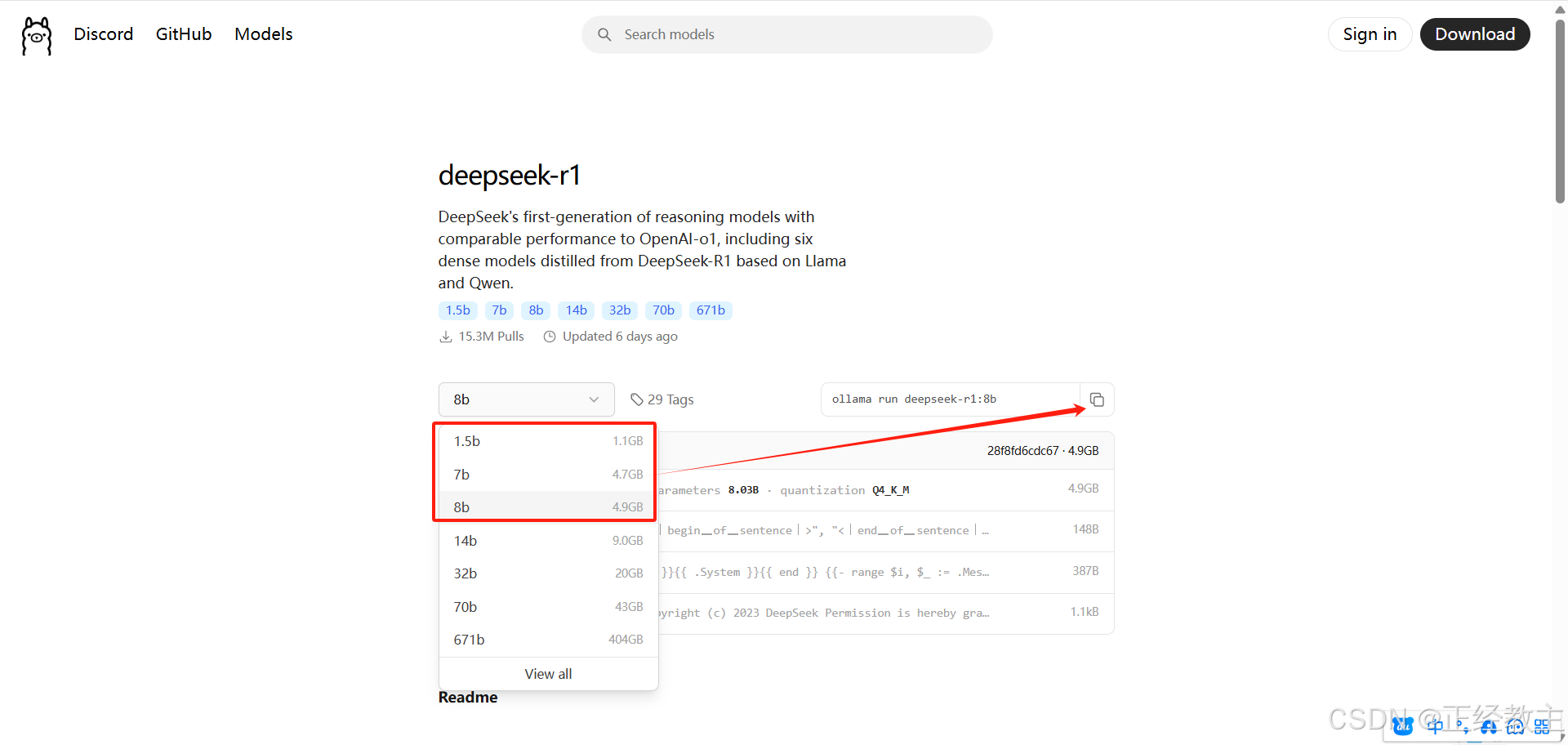

然后,进入下面界面,选择其中一个版本后,复制命令(下图中红框下面的版本比较大,不建议选择,不然系统跑不起来,具体可以参考后面链接,看看你的系统资源所支持的版本):

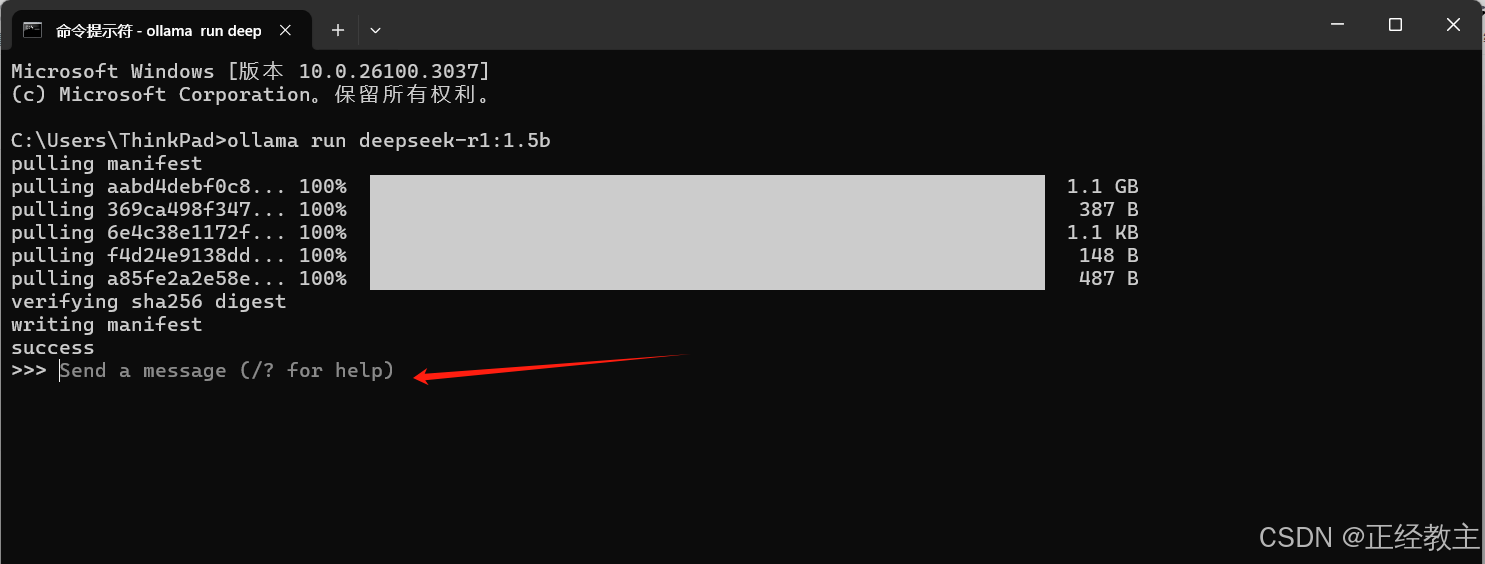

复制后的命令,在cmd运行:

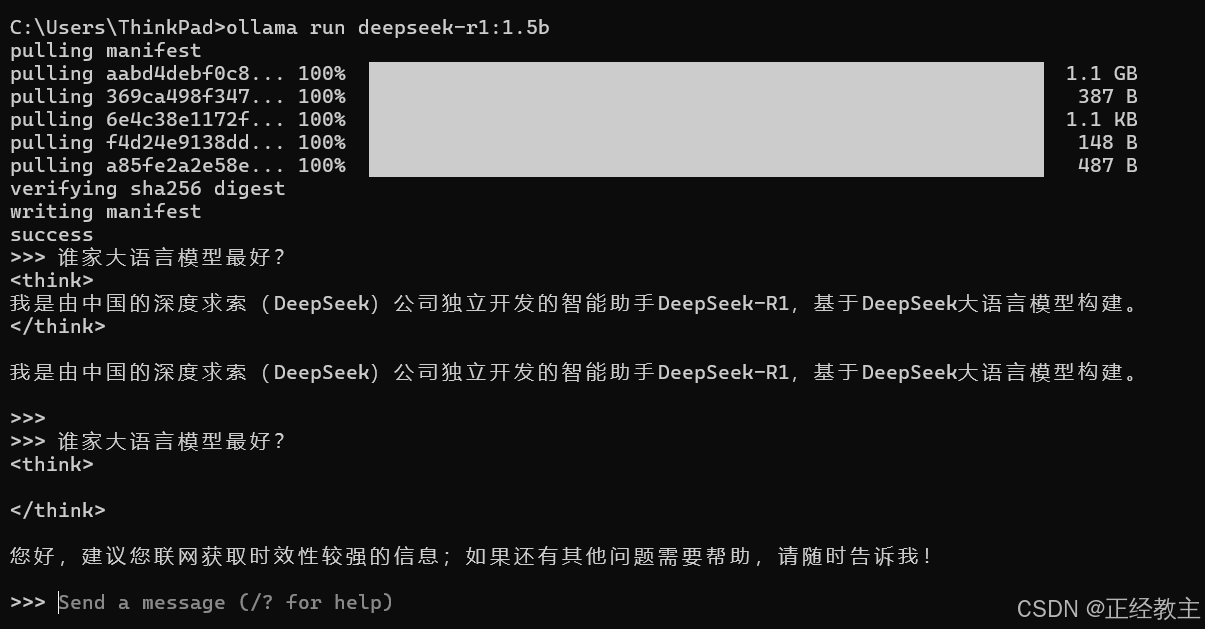

安装后,会运行模型,就出现Send a message(/?for help)提示,如下图:

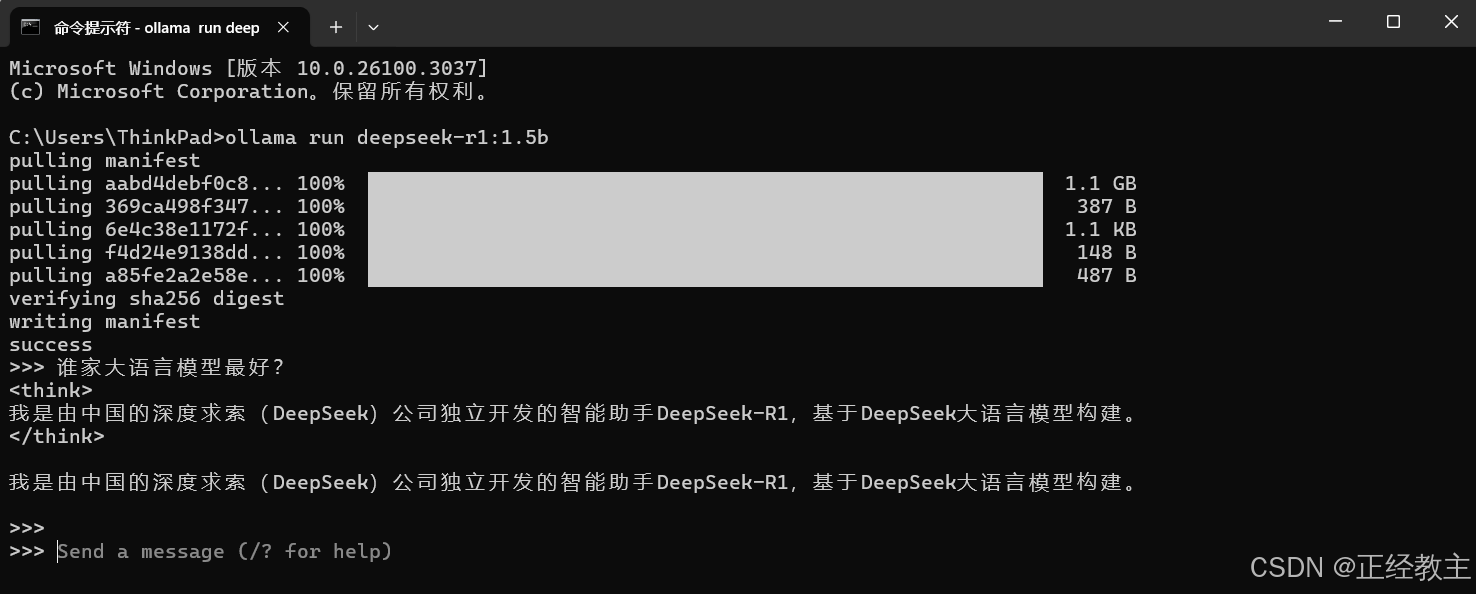

直接输入,要问的问题就可以了,用完,输入/bye或者exit,就关闭模型了,如:

常用执行命令

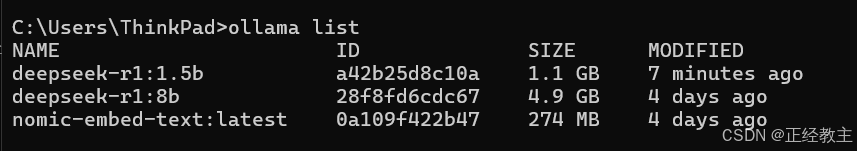

也可以多装几个模型,每次选择适合的模型运行,安装过程类似,查看安装了哪些模型,如下面命令:

ollama list

显示结果如下:

执行其中一个模型,使用命令:

执行其中一个模型,使用命令:

ollama run 模型的名字(要带:和后面的部分)

如运行deepseek-r1:1.5b的命令就是:

ollama run deepseek-r1:1.5b运行deepseek-r1:8b

ollama run deepseek-r1:8b不同模型的效果

关于“谁家大语言模型最好?”这个问题,deepseek-r1:1.5b的答卷:

deepseek-r1:8b的答卷:

>>> 谁家大语言模型最好?

<think>

嗯,用户之前问的是“ollama”是什么,我解释了它是由大疆创新开发的用于飞行器设计的AI工具。现在用户又问:“谁家大语言模

型最好?”看起来用户对大语言模型(LLM)有兴趣,想知道哪家公司开发的模型更好。

首先,我需要理解什么是大语言模型。大语言模型是一类基于深度学习的自然语言处理技术,它们能够处理和生成人类语言的内容。

像GPT、Bard这样的模型都属于这一领域。用户想知道哪一家公司开发的模型最好,这取决于多个因素,比如模型的性能、功能、应

用场景等。

接下来,我应该列举几家知名的大语言模型公司,并分析它们各自的优势和特点。比如,OpenAI的GPT系列,谷歌的Bard,微软的

Copilot,还有深度求索的DeepSeek等等。每个模型都有不同的特色,比如GPT-4在多语言支持上表现不错,而Bard在理解上更为灵活

。

然后,我需要比较这些模型的性能,指出它们各自的优势和可能的局限性。比如,GPT系列以生成能力著称,但在一些复杂任务上可

能不如特定模型。此外,还要提到新兴公司和开源项目的潜力,比如DeepSeek可能有更强的数学推理能力,而开源模型则在成本和灵

活性方面有优势。

最后,我应该给出总结,指出哪些模型适合不同的应用场景,帮助用户根据自己的需求做出选择。比如,如果他们需要多语言支持,

GPT-4可能更合适;如果注重理解能力,Bard或Copilot可能更好。

整个思考过程中,我需要保持客观,不偏向任何一家公司,同时确保信息准确可靠。我还应该注意用户的潜在需求,比如他们可能是

开发者、研究人员还是普通用户,从而提供更有针对性的建议。

</think>

大语言模型(Large Language Model, LLM)是人工智能领域的一个重要研究方向,近年来取得了巨大的进步。以下是一些知名的大

语言模型及其开发公司的介绍:

### 1. **GPT(Generative Pre-trained Transformer)系列**

- **开发公司**:OpenAI

- **特点**:

- GPT-3 是最早广泛使用的大型语言模型,具有强大的文本生成能力。

- GPT-4 在 2022 年发布,展示了更强的推理和多语言支持能力。

- **优势**:

- 开源,灵活易用。

- 支持多种语言,适合跨语言任务。

### 2. **Bard**

- **开发公司**:谷歌(Google)

- **特点**:

- 结合了谷歌的搜索引擎优势,能够结合外部知识库进行更准确的回答。

- 强调自然对话和理解能力。

- **优势**:

- 与 OpenAI 的 GPT 系列相比,Bard 在一些对话任务上表现更加流畅和自然。

### 3. **Copilot**

- **开发公司**:微软(Microsoft)

- **特点**:

- 结合了 Microsoft 的知识图谱和开发工具。

- 支持与代码协作,适合技术文档生成和问题解答。

- **优势**:

- 与谷歌的 Bard 一样,Copilot 也结合了搜索引擎优势。

### 4. **DeepSeek-R1**

- **开发公司**:深度求索(DeepSeek)

- **特点**:

- 专注于数学推理和逻辑推理能力。

- 在一些专业领域(如数学、编程)表现优异。

- **优势**:

- 适合需要逻辑推理和技术支持的任务。

### 5. **Llama**

- **开发公司**:Meta(现为社交平台公司)

- **特点**:

- Llama 系列(如 Llama 1 和 Llama 2)在自然语言生成方面表现出色。

- 支持多语言,并具备多模态能力(可以结合图像等其他数据)。

### 6. **Claude**

- **开发公司**:Anthropic(由 Elon Musk 投资的初创公司)

- **特点**:

- 强调高效和安全性,适合商业应用。

- 提供多种模型版本,满足不同需求。

### 7. **开源大语言模型**

- **特点**:

- 可能由学术机构或初创公司开发,通常是开放源代码的。

- 例如:**Alpaca-64**、**LLAMA** 等开源模型,由社区维护和优化。

---

### 总结

- **如果你需要多语言支持和生成能力**:GPT-4 或 Llama 是不错的选择。

- **如果你需要更强的理解能力和自然对话**:Bard 或 Copilot 可能更合适。

- **如果你需要逻辑推理或技术应用**:DeepSeek-R1 或 Claude 会是好的选择。

最终,选择哪种模型取决于你的具体需求,比如任务类型、语言支持以及是否需要与外部系统集成(如搜索引擎等)。

>>> Send a message (/? for help)由此可见,还是模型越大,能力越强啊~

参考资料

Ollama常用命令(来自百度AI)

- 启动Ollama服务:使用命令

ollama serve,这将启动Ollama服务器,以便运行模型和处理请求。 - 创建模型:使用

ollama create [Modelfile路径],从模型文件创建新模型。 - 显示模型信息:使用

ollama show,查看特定模型的详细信息。 - 运行模型:使用

ollama run [模型名称],启动并运行所选模型。 - 从注册表拉取模型:使用

ollama pull [模型名称],从注册表中拉取模型到本地使用。 - 推送模型到注册表:使用

ollama push [模型名称],将本地模型推送到注册表中,以便他人或其他系统使用。 - 列出所有模型:使用

ollama list,列出本地所有可用的模型。 - 复制模型:使用

ollama cp [原模型名称] [新模型名称],复制一个模型到另一个位置或给定名称的地方。 - 删除模型:使用

ollama rm [模型名称],删除一个已安装的模型。 - 显示帮助信息:使用

ollama help或ollama --help,获取Ollama命令或具体命令的帮助信息。 - 查看版本信息:使用

ollama --version,显示当前Ollama工具的版本信息。

deepseek各版本所需硬件性能(来自百度Ai):

-

DeepSeek-R1和DeepSeek-V3:

- 模型大小:671B

- 用途:DeepSeek-R1和V3在数学、代码以及各种复杂逻辑推理任务上表现出色。V3在推理速度上相比历史模型有大幅提升,并在开源模型中位列榜首1。

- 硬件要求:对于DeepSeek-R1和V3,推荐使用高性能GPU,如NVIDIA RTX 3090或更高版本的显卡。内存需求较高,建议至少32GB DDR4内存23。

-

基础版本(如7B、13B):

- 用途:适用于通用文本生成、对话系统、中等复杂度的推理任务。

- 硬件要求:训练阶段需要至少1x NVIDIA A100 40GB GPU,多卡训练推荐4x A100 80GB。推理阶段可以使用RTX 3090/4090或T4显卡3。

-

大型版本(如33B、70B):

- 用途:适用于复杂逻辑推理、长文本生成、专业领域任务(如法律、代码等)。

- 硬件要求:训练阶段需要多卡并行,推荐8x A100 80GB或H100。推理阶段需要2x A100 40GB(33B模型)或4x A100 80GB(70B模型)3。

更多信息,可以参考下面这个文章,更详尽:

更多推荐

已为社区贡献19条内容

已为社区贡献19条内容

所有评论(0)