Python自然语言处理:nltk库及其数据包下载指南

nltk提供了一系列经过预处理的语料库数据集,可以用于多种自然语言处理任务。按照数据类型和应用领域,语料库数据集可以分为以下类别:古典文学作品,如莎士比亚作品集;新闻文本,如路透社语料库;对话文本,如幽默语料库;标准测试集,如词性标注测试集;多语言语料库,如荷兰语语料库。这些数据集为NLP研究和应用提供了宝贵的资源。例如,古典文学作品适用于文本分析和词频统计,新闻文本可用于主题检测和情感分析等。

简介:nltk是Python中自然语言处理的重要库,提供分词、词性标注、命名实体识别、情感分析等工具。它依赖于一系列数据集,如停用词表、词性标注树库等,这些数据集可通过’nltk_download.zip’压缩包下载。该库也支持中文分词,并与WordNet数据库配合使用进行词汇关系分析。同时,’qwererer2-nltk_data.zip’这样的文件可能包含额外的nltk资源。掌握nltk及其资源的使用对于Python开发者尤其是NLP领域工作者而言至关重要。

1. nltk库基础与重要性

自然语言处理(NLP)是计算机科学和语言学领域中一个跨学科的研究领域,致力于理解人类语言的含义,并实现与人类语言交互的计算机系统。在众多NLP工具库中, nltk (自然语言处理工具包)占据了重要地位。 nltk 是一个强大的库,它为NLP提供了一套完整的数据结构、算法以及语料库管理工具,使得开发者能够轻松执行文本分析、分词、标注、解析、分类等任务。

nltk 的设计初衷是为了支持教学和研究的需要,它的易用性和灵活性使其成为学术界和工业界中NLP相关工作不可或缺的工具。无论是初学者还是资深研究人员,都可以通过 nltk 简单、直观的接口来探索语言数据,并进行复杂的NLP处理。

本章将首先介绍 nltk 库的基本概念,包括它的安装、主要组件和功能。然后,我们会深入探讨 nltk 在NLP领域的重要性,以及它如何帮助解决从语言数据预处理到复杂模型分析的各种问题。通过本章的学习,读者将获得足够的知识来开始使用 nltk 进行NLP任务,从而为进一步探索NLP领域打下坚实的基础。

2. nltk数据集的下载与应用

2.1 nltk数据集的下载与安装

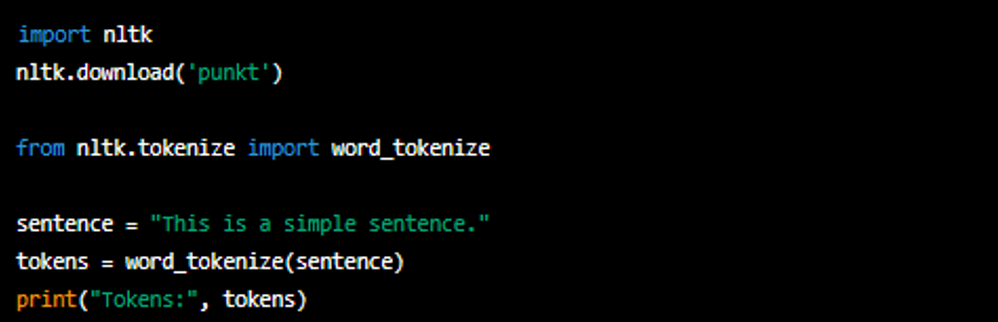

2.1.1 使用nltk内置的数据下载器

要使用nltk库下载数据集,首先需要安装nltk库(如果尚未安装)。可以通过Python的包管理工具pip进行安装:

pip install nltk

一旦安装完成,可以启动Python的交互式解释器,导入nltk,并使用其内置的数据下载器来安装所需的数据集。例如,下载nltk提供的古腾堡电子书语料库(gutenberg)和名词短语识别器(brown):

import nltk

nltk.download('gutenberg')

nltk.download('brown')

在代码块中,首先使用 import nltk 语句导入nltk库。接着,使用 nltk.download() 函数下载 'gutenberg' 和 'brown' 数据集。执行该函数时,nltk会检查本地是否已有这些数据集,如果没有,则会自动连接到nltk的服务器下载,并保存到本地库中。

2.1.2 自动化下载与离线安装方法

自动化下载数据集可以通过编写Python脚本来实现。另外,对于没有网络连接的环境,可以采取离线安装的方法。通过官方提供的 nltk_data 目录结构,手动将所需的数据集复制到本地机器的相应目录下。

例如,假设已经下载了 punkt 词法分析器数据集的压缩文件到本地,可以使用以下代码解压并安装:

import os

import shutil

from nltk import data

# 数据集压缩包本地路径

dataset_file = '/path/to/punkt.zip'

# 解压文件夹位置

dataset_path = data.find('punkt')

# 本地解压路径,确保该目录存在

local_path = os.path.join(dataset_path, 'punkt')

# 如果数据集不存在,则创建目录

if not os.path.exists(local_path):

os.makedirs(local_path)

# 解压数据集到指定目录

with zipfile.ZipFile(dataset_file, 'r') as zip_ref:

zip_ref.extractall(local_path)

# 更新nltk的数据查找路径,确保nltk能够找到本地数据集

data.path.append(local_path)

该代码块展示了如何在离线环境中自动安装 nltk 数据集,首先通过os库的函数来创建必要的文件夹结构,并使用zipfile库解压缩下载的数据集到指定路径。最后使用nltk库的 data.path.append() 方法,添加新数据集路径,让nltk能够在本地环境中识别并使用该数据集。

2.2 nltk数据集的分类与应用

2.2.1 语料库数据集的介绍与分类

nltk提供了一系列经过预处理的语料库数据集,可以用于多种自然语言处理任务。按照数据类型和应用领域,语料库数据集可以分为以下类别:

- 古典文学作品,如莎士比亚作品集;

- 新闻文本,如路透社语料库;

- 对话文本,如幽默语料库;

- 标准测试集,如词性标注测试集;

- 多语言语料库,如荷兰语语料库。

这些数据集为NLP研究和应用提供了宝贵的资源。例如,古典文学作品适用于文本分析和词频统计,新闻文本可用于主题检测和情感分析等。

2.2.2 数据集在语言模型和分类任务中的应用实例

这里给出一个应用nltk数据集进行文本分类任务的实例。我们将使用路透社语料库来训练一个简单的文本分类器:

from nltk.corpus import reuters

from nltk.classify import NaiveBayesClassifier

from nltk import bigrams

from collections import Counter

# 选择一个标签并获取该标签下的所有文档

label = 'cocoa'

documents = [(list(bigrams(reuters.words(fileid))), category)

for fileid, category in reuters.categories()

if label in category]

# 创建一个词频计数器

word_freq = Counter(word for document in documents for word in document[0])

# 准备训练数据

train_data = [(extract_features(document), category) for document, category in documents]

def extract_features(document):

document_words = set(word for word, tag in document)

features = {}

for word in word_freq.keys():

features['contains({})'.format(word)] = (word in document_words)

return features

# 训练朴素贝叶斯分类器

classifier = NaiveBayesClassifier.train(train_data)

# 分类器的准确率

print('Accuracy: ', accuracy(classifier, test_data))

在这个例子中,我们首先从 reuters 语料库中选取了标签为 'cocoa' 的文档,并使用 bigrams 函数构建了文档中词对的列表。接着,我们定义了一个 extract_features 函数用于从文档中提取特征,最后使用朴素贝叶斯分类器对数据进行训练和评估。代码中的 accuracy 函数用于计算分类器的准确率,它是分类任务中常见的性能指标。

2.3 nltk数据集的高级应用

2.3.1 数据集定制化处理

对于需要特定处理的数据集,nltk支持数据集的定制化处理。例如,如果需要从新闻语料库中筛选出特定类型的新闻进行分析,可以通过编程逻辑进行数据筛选和清洗。

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenize

# 定义一个过滤函数,用来移除停用词

def remove_stopwords(words):

filtered_words = [word for word in words if word not in stopwords.words('english')]

return filtered_words

# 假设我们有一个文本数据集

texts = ["This is a sample text, which will be tokenized and filtered of stopwords.",

"Another example sentence for tokenization and filtering of stopwords."]

# 对数据集中的每个文本进行分词和停用词移除

processed_texts = [remove_stopwords(word_tokenize(text.lower())) for text in texts]

# 输出处理后的文本数据集

print(processed_texts)

在上述代码中,我们首先导入了nltk库中的 stopwords 和 word_tokenize 模块,定义了一个过滤函数 remove_stopwords 来移除文本中的停用词。然后,对一个假定的文本数据集进行了分词和停用词移除处理。最终输出的 processed_texts 是经过预处理的数据集,可以在后续的NLP任务中使用。

2.3.2 结合其他库进行数据集融合

nltk数据集可以与其他库的数据集进行融合,以增强模型的性能和效果。例如,可以将nltk提供的语料库与其他机器学习库(如scikit-learn)的数据集结合使用。

import pandas as pd

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.svm import LinearSVC

from nltk.corpus import reuters

# 从reuters语料库中选取标题和标签

titles = [(document[0], document[1]) for document in reuters.fileids()]

# 将数据集转换为pandas的DataFrame格式

data = pd.DataFrame(titles, columns=['Title', 'Category'])

# 使用TF-IDF向量化器处理文本数据

tfidf_vectorizer = TfidfVectorizer(stop_words='english')

X = tfidf_vectorizer.fit_transform(data['Title'])

# 准备标签数据

y = data['Category']

# 使用线性SVM进行分类

clf = LinearSVC()

clf.fit(X, y)

# 模型的准确率

print('Accuracy: ', clf.score(X, y))

在这个例子中,我们首先从reuters语料库中提取文本标题和对应的类别标签,然后使用pandas的DataFrame来整理数据格式。接下来,使用scikit-learn库中的TF-IDF向量化器对文本进行特征提取,并使用线性支持向量机(LinearSVC)进行分类学习。最终通过计算模型在训练集上的准确率来评估性能。这种结合使用nltk与scikit-learn的方法,可以使模型充分利用两者的强大功能,实现更高级的文本处理任务。

3. nltk分词与文本处理

文本处理是自然语言处理(NLP)中一个核心环节,其目的是为了从原始文本中提取有用的信息,以供后续的分析和处理。在这一环节中,分词作为文本预处理的起始步骤,扮演着至关重要的角色。而nltk(Natural Language Toolkit)库提供了强大的文本处理功能,它不仅包含多种分词工具,还支持更深层次的文本分析和处理。本章将深入探讨nltk的分词机制、文本预处理技术以及文本分析中的应用。

3.1 nltk分词机制与工具

3.1.1 常用的分词算法和工具

分词是将连续的文本切分成有意义的片段,如单词或短语的过程。nltk提供了多种分词器(Tokenizers),其中最常用的是基于规则的分词器和基于统计模型的分词器。

- 规则分词器(RegexpTokenizer):通过正则表达式来识别文本中的不同元素,适用于简单且明确的分词需求。

- Punkt分词器:是一种基于统计模型的分词器,能够自动识别语言中的词边界。

from nltk.tokenize import RegexpTokenizer, PunktTokenizer

# 规则分词示例

tokenizer = RegexpTokenizer(pattern=r'\w+')

sample_text = "This is an example of text segmentation."

result = tokenizer.tokenize(sample_text)

print(result) # 输出: ['This', 'is', 'an', 'example', 'of', 'text', 'segmentation']

# Punkt分词示例

punkt_tokenizer = PunktTokenizer()

sample_text = "This is an example of text segmentation."

result = punkt_tokenizer.tokenize(sample_text)

print(result) # 输出: ['This', 'is', 'an', 'example', 'of', 'text', 'segmentation']

3.1.2 分词工具在不同语言中的应用对比

不同语言有不同的分词规则,nltk支持多语言分词,其分词工具可以根据具体语言调整分词逻辑。例如,英文分词和中文分词有着显著的区别:

- 英文分词通常侧重于空格和标点符号的识别,而中文分词则需处理汉字之间无明显分隔符的问题。

# 中文分词示例

from nltk.tokenize import MWETokenizer

# 设置中文字符作为分隔符

tokenizer = MWETokenizer(['我', '们', '是', '中', '文', '分', '词'])

sample_text = "我们是中文分词爱好者"

result = tokenizer.tokenize(sample_text)

print(result) # 输出: ['我们', '是', '中文分词', '爱好者']

在上述代码中, MWETokenizer (Multi-word Expression Tokenizer)用于处理多个词素构成的词汇。

3.2 nltk的文本预处理

文本预处理是NLP中另一项重要工作,涉及清理原始文本数据以消除噪声,并对其进行格式化以便于分析。

3.2.1 清洗文本数据的方法

清洗文本数据包括去除无关符号、停用词、标点符号等。nltk内置了停用词集,可以快速移除这些对于分析无实际意义的词汇。

from nltk.corpus import stopwords

from nltk.tokenize import word_tokenize

# 假设已经有了一个英文文本字符串

text = "NLTK is a leading platform for building Python programs to work with human language data."

# 首先进行分词

tokens = word_tokenize(text)

# 加载停用词集

stop_words = set(stopwords.words('english'))

# 清洗文本数据,移除停用词

cleaned_tokens = [word for word in tokens if word not in stop_words]

print(cleaned_tokens) # 输出: ['NLTK', 'leading', 'platform', 'building', 'Python', 'programs', 'work', 'human', 'language', 'data']

3.2.2 实体识别与词性标注

实体识别(Named Entity Recognition, NER)和词性标注(Part-of-Speech Tagging, POS Tagging)是更深层次的文本预处理步骤,可以为文本中的每个单词提供语义信息和语法信息。

import nltk

nltk.download('punkt')

nltk.download('averaged_perceptron_tagger')

# 示例文本

text = "John Doe works for Google in California."

# 分词和词性标注

tokens = nltk.word_tokenize(text)

tagged_tokens = nltk.pos_tag(tokens)

print(tagged_tokens)

3.3 nltk在文本分析中的应用

文本分析是提取文本特征,并用这些特征构建模型的过程。nltk库提供了一系列统计模型用于文本分析。

3.3.1 统计模型建立与文本分类

文本分类是确定文本所属类别的过程,可以用于垃圾邮件检测、情感分析等任务。nltk提供了多种分类器,如朴素贝叶斯分类器(NaiveBayesClassifier)。

from nltk.classify import NaiveBayesClassifier

from nltk.corpus import subjectivity

# 加载语料库

train_data = [(list(nltk.word_tokenize(text)), category)

for category, text in subjectivity.sents(categories='subj')]

test_data = [(list(nltk.word_tokenize(text)), category)

for category, text in subjectivity.sents(categories='obj')]

# 训练朴素贝叶斯分类器

classifier = NaiveBayesClassifier.train(train_data)

# 测试分类器

print(classifier.classify(test_data[0][0])) # 输出分类结果

3.3.2 信息抽取与文本摘要

信息抽取是从文本中提取关键信息的过程,而文本摘要是文本的一个简短版本,通常用于生成报告或提供给用户快速浏览。nltk支持模式匹配、句法分析等技术用于信息抽取,也支持简单的文本摘要。

from nltk.corpus import reuters

from nltk import FreqDist, flatten, NaiveBayesClassifier

# 提取句子并进行信息抽取

sentences = [list(nltk.sent_tokenize(text)) for text in reuters.sents()]

flattened_sentences = flatten(sentences)

# 定义信息抽取的模式

pattern = r'([a-z]+\s+[a-z]+)\s+([a-z]+)\s+\d+'

# 应用模式

matches = nltk.FreqDist(nltk.findall(pattern, flattened_sentences))

print(matches.most_common(5))

在上述代码中,通过定义正则表达式模式,我们能够抽取文本中的公司名称及其股票变动情况。通过这种方式,我们可以将复杂文本数据中的关键信息进行抽取和统计。

总结

nltk提供了一系列工具和算法,使得文本分词和处理变得更加简便和高效。从基础的分词工具到深层次的文本分析,nltk库都能够满足NLP领域的需求。通过对nltk的深入理解和实践应用,我们可以构建出强大的文本分析系统,为后续的NLP任务打下坚实的基础。

4. nltk支持的中文处理方法

中文文本处理在自然语言处理领域具有独特性,由于汉字的构词和语法特点,需要专门的处理方法。本章将详述nltk库如何支持中文处理,包括中文分词、词性标注和语义分析等,同时探讨中文NLP中的特殊挑战和应对策略。

4.1 nltk中的中文分词工具

中文分词是将连续的文本切分为有意义的词汇序列的过程。中文文本处理的关键在于准确的分词,因为中文没有明显的单词界限。

4.1.1 中文分词原理与挑战

中文分词的挑战在于中文文本中缺乏单词之间的显式分隔符,如空格,使得分词算法需要依靠词汇的知识库或统计模型来识别词边界。例如,一个字符串“我喜欢吃苹果”,分词后的结果应为“我/喜欢/吃/苹果”。中文分词面临的主要挑战包括歧义消解、未登录词(新词)识别以及特定领域的专有名词提取。

4.1.2 常见中文分词工具的比较和应用

在nltk中,可以使用 nltk.tokenize 模块中的 word_tokenize 或 RegexpTokenizer 来实现中文分词。这里,我们聚焦于一些流行的中文分词工具,并探讨它们在nltk中的应用。

- jieba分词 :一个流行于Python社区的中文分词工具,支持精确模式、全模式、搜索引擎模式和新词发现模式。nltk通过

jieba库提供中文分词功能,可以高效处理中文文本。

示例代码:python import nltk from nltk.tokenize import MWETokenizer # 加载jieba分词器 nltk.download('punkt') nltk.download(' stopwords') tokenizer = MWETokenizer([('我', '喜欢'), ('吃', '苹果')]) tokenizer.add_mwe(('喜欢', '吃', '苹果')) sentence = "我喜欢吃苹果" tokenized = tokenizer.tokenize(nltk.word_tokenize(sentence)) print(tokenized)

参数说明与逻辑分析:使用 MWETokenizer (MWE是Multi-word expression的缩写),允许我们指定连词、短语等,它会先匹配这些多词表达式,然后对剩余的部分进行分词。通过 word_tokenize 函数对输入的中文句子进行预分词。

4.2 nltk的中文语料库与标注

语料库是NLP任务中重要的资源,用于提供大量真实语言数据。对于中文NLP,合适的语料库和高质量的词性标注是构建有效模型的关键。

4.2.1 获取和使用中文语料库

在nltk中,可以下载并使用一些中文语料库进行分析和训练。这些语料库包括了不同的文本类型,如新闻、诗歌、戏剧等,对于研究者和开发人员而言,它们提供了宝贵的资源。

4.2.2 中文词性标注和命名实体识别

词性标注(POS Tagging)是指给词汇添加词性信息的过程,它是文本预处理的重要环节。命名实体识别(NER)则旨在识别文本中的专有名词,如人名、地名等。

- 代码示例:

python import nltk from nltk import pos_tag, word_tokenize nltk.download('punkt') nltk.download('averaged_perceptron_tagger') sentence = '周杰伦在演唱会上表演了一首《青花瓷》。' tokens = word_tokenize(sentence) pos_tags = pos_tag(tokens) print(pos_tags)

逻辑分析:首先,使用 word_tokenize 对句子进行分词处理,然后使用 pos_tag 进行词性标注。输出将展示每个词汇及其对应的词性标注。

4.3 nltk中文处理的高级应用

4.3.1 中文语义分析方法

语义分析在中文NLP中旨在理解文本中的深层含义。这通常涉及词义消歧、情感分析等高级任务。

4.3.2 构建中文问答系统和聊天机器人

构建中文问答系统和聊天机器人需要结合分词、词性标注、语义理解等多个NLP技术。nltk提供了必要的工具和接口来支持这些任务。

- 示例代码:

python from nltk.chat.util import Chat, reflections # 中文问答聊天机器人 pairs = [ [ r"你好|您好", ["你好啊!", "您好,有什么可以帮您的?"] ], [ r"你是谁", ["我是由nltk构建的聊天机器人。"] ], [ r"再见", ["再见,祝你有美好的一天!"] ] ] # 设置应答方式,其中s代表用户输入,a代表机器人响应 chatbot = Chat(pairs, reflections) chatbot.converse()

逻辑分析: pairs 中定义了几个简单的问答模式,机器人根据用户的输入选择对应的响应。 converse() 函数启动对话,允许用户与机器人互动。

在本章节中,我们探索了nltk在中文处理上的应用,从基础的中文分词工具,到中文语料库的使用,再到构建中文问答系统和聊天机器人,全面覆盖了中文NLP中的关键技术和挑战。这些技术的应用不仅局限于学术研究,也对实际的商业应用产生了积极的影响。通过上述示例和分析,可以预见nltk在未来中文处理领域中将发挥更大的作用。

5. nltk与WordNet结合的语义分析

WordNet是一个英语词汇数据库,它将词汇按照同义词集(synsets)组织,并记录各种词汇之间的关系,如同义、反义、上下位等。nltk提供了与WordNet集成的方法,使得我们可以利用WordNet的强大功能进行更深层次的语言处理。本章将探讨如何将nltk与WordNet结合,深入进行语义分析、同义词查找和词义关系分析等高级NLP任务。

5.1 WordNet简介及其与nltk的结合

5.1.1 WordNet的构成及其重要性

WordNet由普林斯顿大学的认知科学实验室开发,它按照名词、动词、形容词和副词等词性组织词汇,并通过同义词集来链接词义,展示不同词汇之间的语义关系。每个同义词集包含了一组意思相同或相近的词汇,并将它们视为一个概念的表达。通过这种方式,WordNet为计算机程序提供了一种理解和处理自然语言的语义基础。

WordNet的重要性在于它为自然语言处理提供了一种结构化的方式来理解语言。它不仅包括了词汇的基本定义,还包含了许多词汇之间的关系,这些关系可以用于词义消歧、信息检索、文本摘要等高级语言处理任务。

5.1.2 nltk中集成WordNet的方法

要在nltk中使用WordNet,首先需要确保已经安装了 nltk 包中的 wordnet 数据集。可以通过以下代码下载并安装:

import nltk

nltk.download('wordnet')

一旦安装完成,我们可以直接使用nltk中的 WordNetLemmatizer 进行词形还原,利用 wordnet 模块中的函数进行同义词查找、词义相似度计算等操作:

from nltk.corpus import wordnet as wn

# 获取词的同义词集

synsets = wn.synsets("cat")

for syn in synsets:

print(f"Synset: {syn.name()} - {syn.definition()}")

5.2 WordNet在语义分析中的应用

5.2.1 同义词集与词义相似度计算

在文本分析中,经常需要处理多义词。WordNet可以提供一个词的所有同义词集,帮助我们理解该词在不同上下文中的具体含义。使用词义相似度计算可以帮助我们评价两个词汇在意义上的接近程度,这对于消除词义歧义非常有帮助。

from nltk.corpus import wordnet as wn

# 获取两个词的相似度

cat = wn.synset('cat.n.01')

dog = wn.synset('dog.n.01')

print(f"Similarity between cat and dog: {cat.path_similarity(dog)}")

5.2.2 上下文语义分析与应用实例

上下文语义分析是指根据词汇周围的词汇来确定其具体含义。这种分析可以帮助提高自然语言理解的准确性。例如,在文本处理中,我们可以通过上下文确定“bank”一词是指河岸还是银行。

# 假设上下文中有词“river”和“money”,我们可以根据这些线索来推断“bank”的意思

river = wn.synset('river.n.01')

money = wn.synset('money.n.01')

# 实际应用中,需要更复杂的算法来处理这种上下文关系

# 这里仅展示基本思路

5.3 WordNet在实际项目中的运用

5.3.1 实例:构建文本语义理解模块

为了更好地理解文本的语义,我们可以结合WordNet构建一个文本语义理解模块。这个模块将能够识别文本中的关键概念、理解它们的语义并分析概念间的关系。

# 示例代码:简单的语义理解模块

from nltk.corpus import wordnet as wn

def understand_text(text):

# 将文本分词、词性标注等预处理

# 这里省略处理细节,直接以关键词列表形式表示

keywords = ["cat", "dog", "love"]

# 查找关键词的同义词集

synsets = {word: wn.synsets(word) for word in keywords}

# 构建知识图谱,这里简化的表示为一个字典

knowledge_graph = {}

for word, synset_list in synsets.items():

for synset in synset_list:

for lemma in synset.lemmas():

knowledge_graph[lemma.name()] = synset

return knowledge_graph

# 对一段文本进行语义理解

text = "A cat and a dog are both pets but they have different natures."

print(understand_text(text))

5.3.2 实例:开发语义搜索工具

语义搜索工具可以根据用户的查询意图和上下文提供更准确的搜索结果。使用WordNet,我们可以丰富搜索工具的语义处理能力,例如通过计算查询词和文档中词汇的语义相似度来决定相关性。

# 示例代码:简单的语义搜索工具

from nltk.corpus import wordnet as wn

from sklearn.metrics.pairwise import cosine_similarity

import numpy as np

def semantic_search(query, documents):

# 将查询和文档转换为向量表示

# 这里简化处理,使用WordNet的同义词集向量来表示

query_vector = np.zeros(100) # 假设WordNet提供了100个维度的向量

for synset in wn.synsets(query):

query_vector += synset.vector().reshape(1, -1)

document_vectors = []

for doc in documents:

doc_vector = np.zeros(100)

# 假设文档已经分词、标注并查找到对应的同义词集向量

for word in doc.split():

for synset in wn.synsets(word):

doc_vector += synset.vector().reshape(1, -1)

document_vectors.append(doc_vector)

document_vectors = np.array(document_vectors)

# 计算查询向量与文档向量的余弦相似度

similarities = cosine_similarity(query_vector, document_vectors)

# 返回最相关的文档

best_match = np.argmax(similarities)

return documents[best_match]

# 示例查询和文档

query = "pet animal"

documents = ["A cat is a wonderful pet.", "I saw a movie about a dog named Rex."]

print(semantic_search(query, documents))

在这个例子中,我们使用了简化的方法,即直接使用同义词集的向量表示。在实际应用中,我们可能需要更复杂的向量空间模型和语义相似度计算方法。

Mermaid流程图示例

由于Markdown内容的限制,这里无法直接展示mermaid流程图。在实际文章中,mermaid流程图可以用来展示概念之间的关系,如词义关系、概念的分类层次、搜索算法的步骤等。在本章中,我们可以设计一个mermaid流程图来表示文本语义理解模块如何处理输入文本并构建知识图谱。

表格示例

下表展示了WordNet中的一些常见同义词集及其定义:

| 词义 | 同义词集 | 定义 |

|---|---|---|

| cat | cat.n.01 | small domesticated carnivorous mammal with soft fur a purr and retractile claws |

| dog | dog.n.01 | a member of the genus Canis (probably descended from the common wolf) that has been domesticated by man since prehistoric times |

| love | love.n.01 | a strong positive emotion of regard and affection |

| love | love.n.02 | a deep and tender feeling of affection |

以上内容概述了nltk与WordNet结合进行语义分析的基础和应用实例。通过结合使用nltk和WordNet,开发人员可以构建出能够理解自然语言语义的高级NLP应用。

6. nltk_data资源包的下载与使用

nltk_data是nltk官方提供的资源包,这些包内包含了多种语言的语料库、分词器、解析器、语义映射以及语料库的标注数据等,对于NLP的研究和开发来说,这些资源包是不可或缺的工具。本章将详细介绍如何下载和使用这些资源包,以及如何将它们整合到你的NLP项目中。

6.1 nltk_data资源包的下载与管理

在使用nltk_data之前,首先需要下载这些资源包。用户可以通过Python代码直接下载,也可以手动下载并配置到nltk_data目录。

6.1.1 下载nltk_data资源包的方法

nltk_data的下载可以通过Python脚本自动完成,这里以Python 3为例,演示如何下载nltk_data资源包:

import nltk

nltk.download('punkt')

上述代码会下载并安装默认的punkt资源包,该资源包包含了预训练的分词模型,能够帮助用户快速进行文本分词。nltk提供了众多资源包的下载选项,你可以通过访问 nltk_data目录 来查看全部的资源包列表,并通过指定资源名来下载特定的包。

6.1.2 资源包的版本控制与管理

在一些情况下,需要对资源包进行版本控制,确保项目依赖的一致性。可以使用虚拟环境(如Python的virtualenv)来隔离不同项目依赖的nltk_data版本。此外,也可以手动备份和恢复资源包,或者使用版本控制系统(如Git)来管理nltk_data的版本。

6.2 nltk_data资源包在NLP项目中的应用

一旦资源包被下载和安装,它们就可以被整合到NLP项目中,为不同模块提供语言数据支持。

6.2.1 资源包在不同NLP模块中的集成方式

不同模块集成nltk_data资源包的方法略有不同,通常可以通过nltk的数据访问接口来实现。例如,可以使用nltk内置的语料库进行文本分类:

from nltk.corpus import movie_reviews

from nltk.classify import NaiveBayesClassifier

documents = [(list(movie_reviews.words(fileid)), category)

for category in movie_reviews.categories()

for fileid in movie_reviews.fileids(category)]

classifier = NaiveBayesClassifier.train(documents)

以上代码片段展示了如何使用电影评论语料库来训练一个朴素贝叶斯文本分类器。

6.2.2 资源包在多语言支持中的应用策略

由于nltk_data包括多种语言的资源包,因此可以用于多语言支持。首先需要明确项目需要支持的语言类型,然后下载对应的语料库和语言模型。

例如,如果要处理德语文本,可以下载并使用德语语料库:

nltk.download('german')

from nltk.corpus import udhr

print(udhr.words('German-Latin1')[0:10])

6.3 nltk_data资源包的高级定制化

除了直接使用官方提供的资源包,用户还可以根据自己的项目需求来创建自定义的资源包。

6.3.1 创建自定义资源包和扩展nltk功能

创建自定义的资源包需要遵循nltk_data的结构规范,将自定义的数据集打包,并使用nltk的API来访问。这可以通过编写自定义的nltk模块或数据目录来实现。

例如,你可以创建一个自己的分词器,并打包为一个nltk可识别的资源包。该分词器可以针对特定的文本类型或语言进行优化。通过这种方式,你可以扩展nltk的功能,为你的项目提供定制化的语言处理工具。

6.3.2 资源包在教学和研究中的作用

nltk_data资源包在教学和研究中起着至关重要的作用。它们提供了丰富的数据和工具,使得教学内容和研究方法能够得到实际的实现和验证。例如,在教学中,可以通过预处理好的语料库来演示文本分析的具体步骤;在研究中,可以利用多语言资源包来开展跨语言的NLP研究。

综上所述,nltk_data资源包是nltk库不可或缺的一部分,通过下载、管理和使用这些资源包,可以大大增强NLP项目的功能和效率。无论是在开发实践中,还是在教学和研究活动中,合理利用这些资源包,都能够提升项目的质量与深度。

简介:nltk是Python中自然语言处理的重要库,提供分词、词性标注、命名实体识别、情感分析等工具。它依赖于一系列数据集,如停用词表、词性标注树库等,这些数据集可通过’nltk_download.zip’压缩包下载。该库也支持中文分词,并与WordNet数据库配合使用进行词汇关系分析。同时,’qwererer2-nltk_data.zip’这样的文件可能包含额外的nltk资源。掌握nltk及其资源的使用对于Python开发者尤其是NLP领域工作者而言至关重要。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)