Chatbox 丝滑连接 Ollama 服务

Chatbox 是一个功能强大的桌面 AI 客户端应用程序,支持多种 AI 模型和 API,可在 Windows、Mac 和 Linux 等多个平台上运行。它是您在桌面端的终极 AI 助手。Chatbox 可以很好地与 Ollama 配合使用,让您能够访问强大的功能,如 Artifact 预览、文件分析、聊天管理和自定义提示词等。下面介绍下如何使用Chatbox 连接部署在矩池云的远程 Ollam

Chatbox 是一个功能强大的桌面 AI 客户端应用程序,支持多种 AI 模型和 API,可在 Windows、Mac 和 Linux 等多个平台上运行。它是您在桌面端的终极 AI 助手。

Chatbox 可以很好地与 Ollama 配合使用,让您能够访问强大的功能,如 Artifact 预览、文件分析、聊天管理和自定义提示词等。

下面介绍下如何使用Chatbox 连接部署在矩池云的远程 Ollama 服务

第一步:启动实例

矩池云提供了很多带Ollama的镜像,在镜像选择页面,点击热门镜像标签,从下拉列表中选择 Ollama,即可筛选出预装了Ollama的镜像:

这里我们选择 Ollama 0.3.12 镜像, 根据镜像介绍,这个模型预装了Ollama,但是开机后,需要手动启动服务。这个镜像在高级设置中自定义了11434端口用于对外提供Ollama服务:

第二步:启动Ollama服务

启动服务前,要先配置好服务的默认端口以及确保服务监听所有的网络接口(默认只监听 127.0.0.1,从外部无法访问服务)

# 设置监听地址和端口

export OLLAMA_HOST=0.0.0.0 # 监听所有网络接口,重要!!!

export OLLAMA_PORT=11434 # 默认端口

# 启动Ollama

ollama serve

# 查看已安装的模型列表

ollama list

# 测试模型

ollama run llama3.1:latest

# 方法2:使用 API 测试

curl -X POST http://localhost:11434/api/generate -d '{

"model": "llama3.1:latest",

"prompt": "你好,请介绍一下自己"

}'

第三步:配置Chatbox

首先测试下外部是否可以访问Ollama服务,从我的实例详情中获取11434的服务链接:

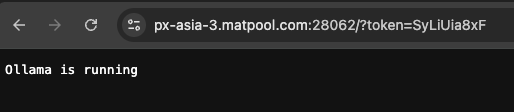

在浏览器中输入Ollama服务地址, 如果页面回复“Ollama is running”说明外部访问正常

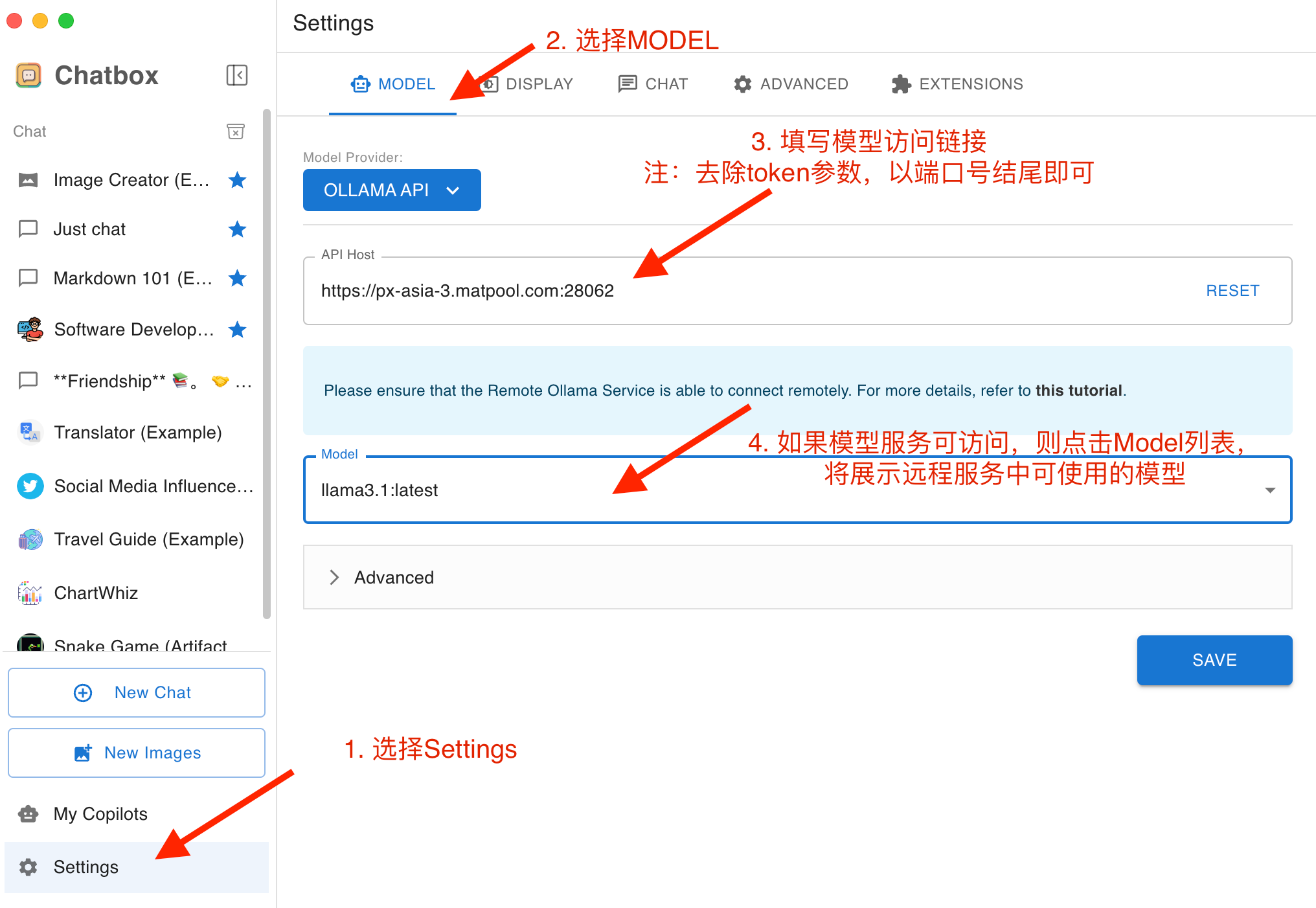

然后,我们打开Chatbox,点击Settings-Model,进行模型服务配置,注填写API Host的时候,要将Ollama服务地址中的token参数信息去除:

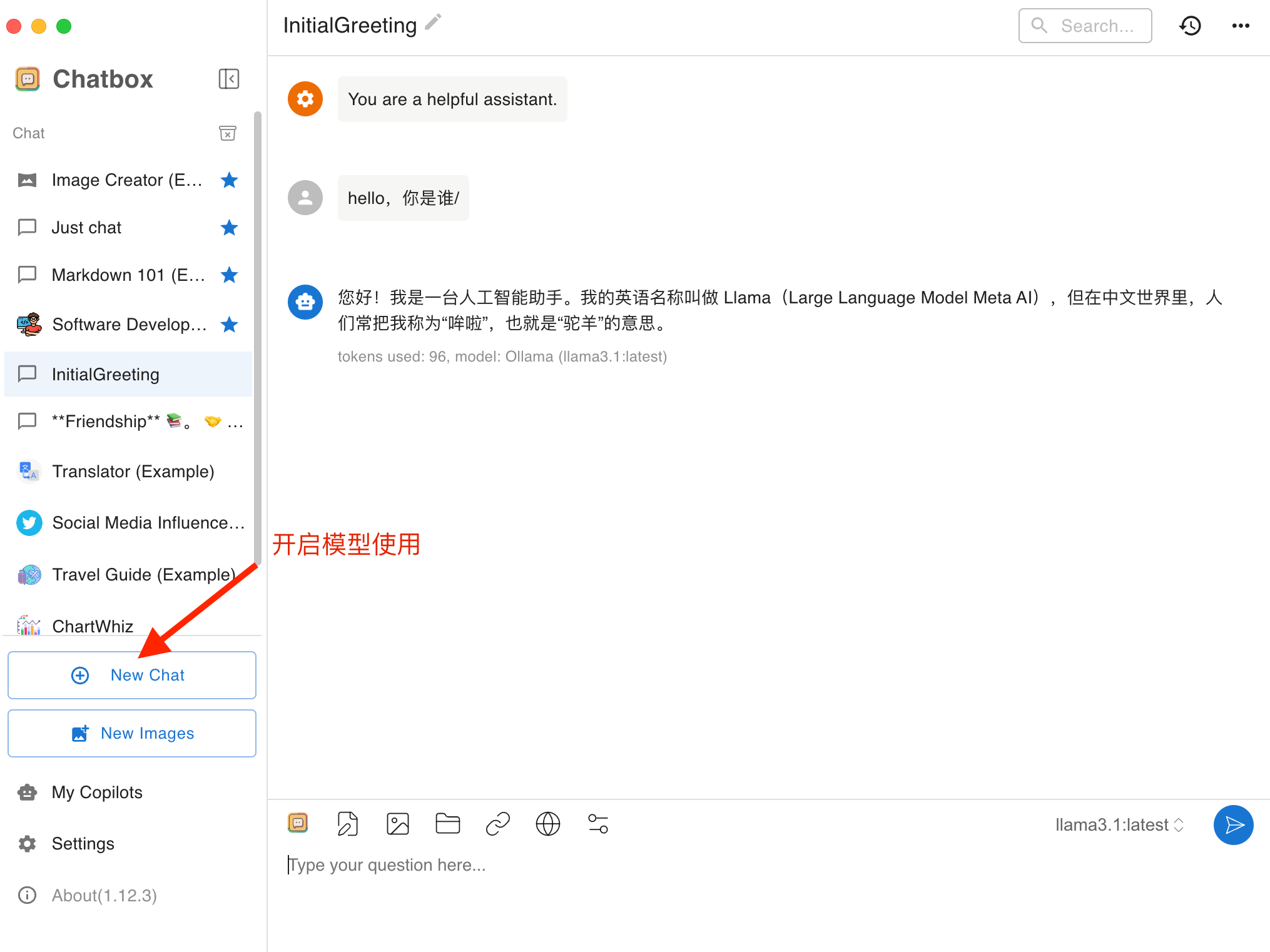

开启模型使用:

Q&A

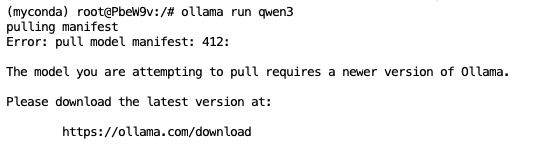

Ollama中找不到我要的模型怎么办?

如果找不到你想要的模型,首先在Ollama Library里边确认下有没有你想用的模型(https://ollama.com/library),如果有的话,则使用安装脚本重新更新下Ollama的版本:

curl -fsSL https://ollama.com/install.sh | sh

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)