2.1深度学习——从线性回归到深度神经网络的演变

虽然神经网络的基本结构受生物神经元的启发,但随着深度学习的发展,人工神经网络的设计和实现已经大大超越了生物神经元的模型。这种分层的结构使得神经网络能够处理更复杂的任务。通过多层的非线性变换,深度神经网络能够学习到输入数据的高层次特征,这使得它在处理复杂任务时具有巨大的优势。在最基本的神经网络模型中,输入层与输出层之间的连接非常简单,输入数据通过权重进行加权和求和,最后输出结果。现代深度学习中的神经

从线性回归到深度神经网络的演变

深度学习的核心思想是通过多层的神经网络来模拟复杂的映射关系,从而实现对高维数据的有效处理和理解。而深度神经网络的基础,实际上源于我们非常熟悉的线性回归模型。虽然线性回归和深度神经网络在形式上有很大区别,但它们之间有着紧密的联系。深入理解这一点,对于我们理解深度学习的本质非常重要。线性回归可以被看作是一个非常简单的神经网络,而深度神经网络则是由多个这样的简单神经网络组成的。

1. 线性回归的模型

线性回归是我们学习机器学习时最早接触到的模型之一,目标就是通过输入变量(特征)来预测一个连续的输出变量。在最简单的线性回归中,假设我们有多个输入特征 x1, x2, …, xd,输出为一个标量 y。线性回归的模型假设输出是输入特征的线性组合,具体来说,可以通过以下公式来表示:

y = w1 * x1 + w2 * x2 + … + wd * xd + b

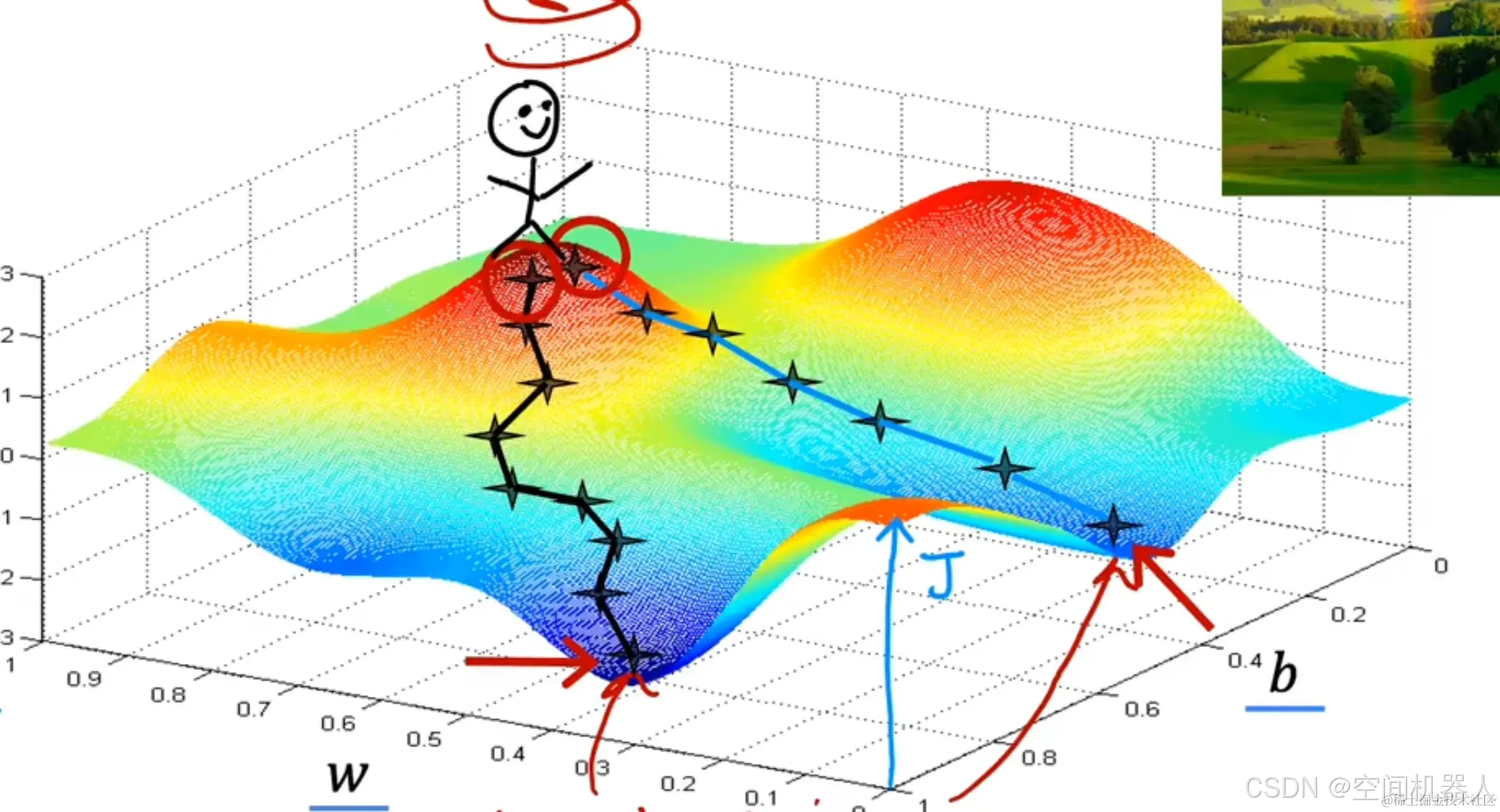

这里,w1, w2, …, wd 是每个输入特征的权重,b 是偏置项。通过调整这些权重和偏置,模型能够从数据中学习到最优的线性关系,进而对新的数据做出预测。尽管模型非常简单,但线性回归是许多复杂模型的基础,它帮助我们理解机器学习中的一些基本概念,如损失函数、优化过程等。

2. 线性回归与神经网络的关系

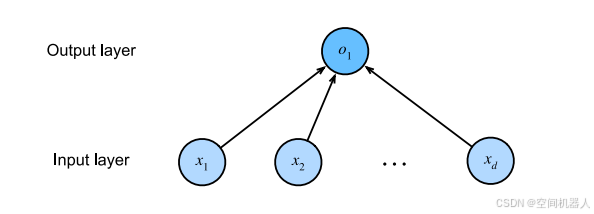

线性回归模型看似简单,但它其实可以用神经网络的语言来表达。神经网络的核心是通过多个神经元(或节点)进行计算,每个神经元通过接收输入并加权求和来计算输出。在最基本的神经网络模型中,输入层与输出层之间的连接非常简单,输入数据通过权重进行加权和求和,最后输出结果。

如果我们把线性回归看作神经网络模型,就可以发现它其实就是一个单层神经网络。在这个神经网络中,输入层包含了多个特征(x1, x2, …, xd),而输出层只有一个神经元,输出的结果就是预测值 y。这个神经元执行的操作就是对输入特征进行加权求和,并加上偏置项,这正是线性回归模型的核心思想。因此,线性回归可以看作是一个包含单个神经元的神经网络。

通过这种方式,我们可以将线性回归问题转化为神经网络问题,从而更加方便地利用神经网络的技术来求解。其实,很多时候我们使用神经网络时并不需要过多地关心其复杂性,像线性回归这样的简单网络就足以完成一些基本的任务。而随着网络层数的增加,神经网络就能够处理更为复杂的问题。

3. 神经网络的“层”结构

神经网络的一个重要特点就是它是由多层神经元构成的,每一层都能够学习到输入数据的不同特征。这种分层的结构使得神经网络能够处理更复杂的任务。一般来说,神经网络的第一层是输入层,接着是若干个隐藏层,最后是输出层。每一层神经元的输出都通过权重和偏置进行加权求和,并经过激活函数处理后传递到下一层。通过这样的方式,神经网络能够逐层提取数据中的特征,从而进行更加精准的预测。

在深度学习中,我们通常不直接用“线性回归”的概念来描述模型,而是把它看作是一个神经网络的特殊形式。线性回归的单层网络实际上就是一个非常浅的神经网络,只有输入层和输出层,而没有隐藏层。深度神经网络则是通过多层神经元的组合来实现复杂的特征学习和映射。随着层数的增加,网络能够学习到更加抽象和高层次的特征,最终实现对复杂任务的高效处理。

4. 神经网络的激活函数

虽然线性回归模型可以通过加权求和来得到结果,但神经网络通常需要引入激活函数来进行非线性变换。没有激活函数,神经网络只能表示线性关系,无法处理复杂的非线性问题。而激活函数的作用就是让神经网络能够学习到数据中的非线性特征,从而提高其表达能力。

常见的激活函数有 Sigmoid 函数、ReLU 函数和 Tanh 函数等。以 ReLU 为例,ReLU 函数的输出是输入的正部分,即:

ReLU(x) = max(0, x)

这种简单的非线性变换使得神经网络能够学习到数据中的非线性关系。而在深度学习中,神经网络的每一层都可能使用不同的激活函数,帮助模型从输入数据中提取不同的特征。

5. 从生物神经元到人工神经元

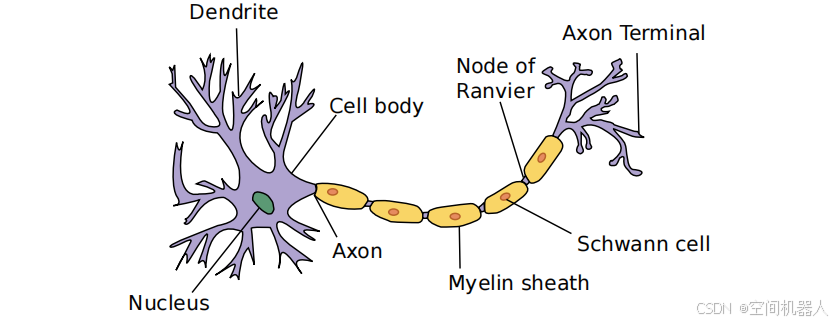

虽然神经网络的基本结构受生物神经元的启发,但随着深度学习的发展,人工神经网络的设计和实现已经大大超越了生物神经元的模型。最早的人工神经元模型是由沃伦·麦库洛奇和沃尔特·皮茨提出的,他们通过数学模型模拟了神经元的基本功能。生物神经元通过树突接收信号,将信号加权后通过细胞体进行处理,再通过轴突传递到其他神经元或目标细胞。而人工神经元则是通过接收输入信号、加权求和、并通过激活函数来产生输出,这个过程与生物神经元在某些方面是类似的。

然而,现代神经网络的设计已经不再直接借鉴生物学中的神经系统,而是更多地依赖于数学、统计学和计算机科学的理论。现代深度学习中的神经网络通常包含多个层,每一层都能够提取输入数据中的不同特征,而这些层的组合使得神经网络能够处理更复杂的任务。

6. 深度神经网络的优势

随着神经网络的层数不断增加,网络的表现力也在不断增强。通过多层的非线性变换,深度神经网络能够学习到输入数据的高层次特征,这使得它在处理复杂任务时具有巨大的优势。例如,深度神经网络在图像识别、语音识别、自然语言处理等领域取得了突破性的进展。相比于传统的机器学习方法,深度神经网络能够更好地从大规模数据中学习,自动提取特征,而无需手动设计特征。

然而,深度神经网络也面临着一些挑战。例如,训练深度神经网络需要大量的数据和计算资源,且容易出现过拟合问题。此外,神经网络的黑箱性质使得它在一些应用中缺乏可解释性,这也是当前研究的一大难题。

7. 结论

从线性回归到深度神经网络的转变,实际上是一个从简单到复杂、从线性到非线性的过程。线性回归虽然简单,但它为神经网络的理解和构建提供了基础。通过将线性回归看作一个单层神经网络,我们可以更加清楚地理解神经网络的基本结构,并逐步过渡到更复杂的深度神经网络。虽然现代深度学习已经不再直接借鉴生物神经元的工作机制,但其背后的思想和原理仍然受到神经科学的启发。随着技术的不断进步,深度神经网络将继续推动人工智能领域的发展,解决越来越复杂的问题。

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)