解决Ollama工具调用问题:使用LM Studio完美替代本地模型调用

本文介绍了使用LM Studio替代Ollama解决AutoGen项目中本地模型工具调用问题的方案。针对Ollama常见的工具调用失败、格式不一致等问题,LM Studio提供了更稳定的API接口和更好的兼容性。文章详细讲解了LM Studio的安装配置、本地端口暴露方法,并给出了AutoGen集成的代码示例。通过对比表展示了LM Studio在工具调用、资源占用等方面的优势,为开发者提供了一个更

·

解决Ollama工具调用问题:使用LM Studio完美替代本地模型调用

引言

在使用AutoGen进行多智能体开发时,很多开发者会遇到Ollama本地模型无法正常调用工具的问题。本文将详细介绍如何使用LM Studio作为替代方案,完美解决工具调用难题,让你的AutoGen项目更加稳定可靠。

问题背景

Ollama工具调用的常见问题

- 模型响应格式不一致

- 工具调用失败率高

- 本地资源占用过大

- 模型兼容性问题

为什么选择LM Studio

- 更好的工具调用支持

- 更稳定的API接口

- 更丰富的模型选择

- 更低的资源占用

LM Studio安装与配置

下载安装

LM Studio官方下载地址:https://www.lm-studio.me/#google_vignette

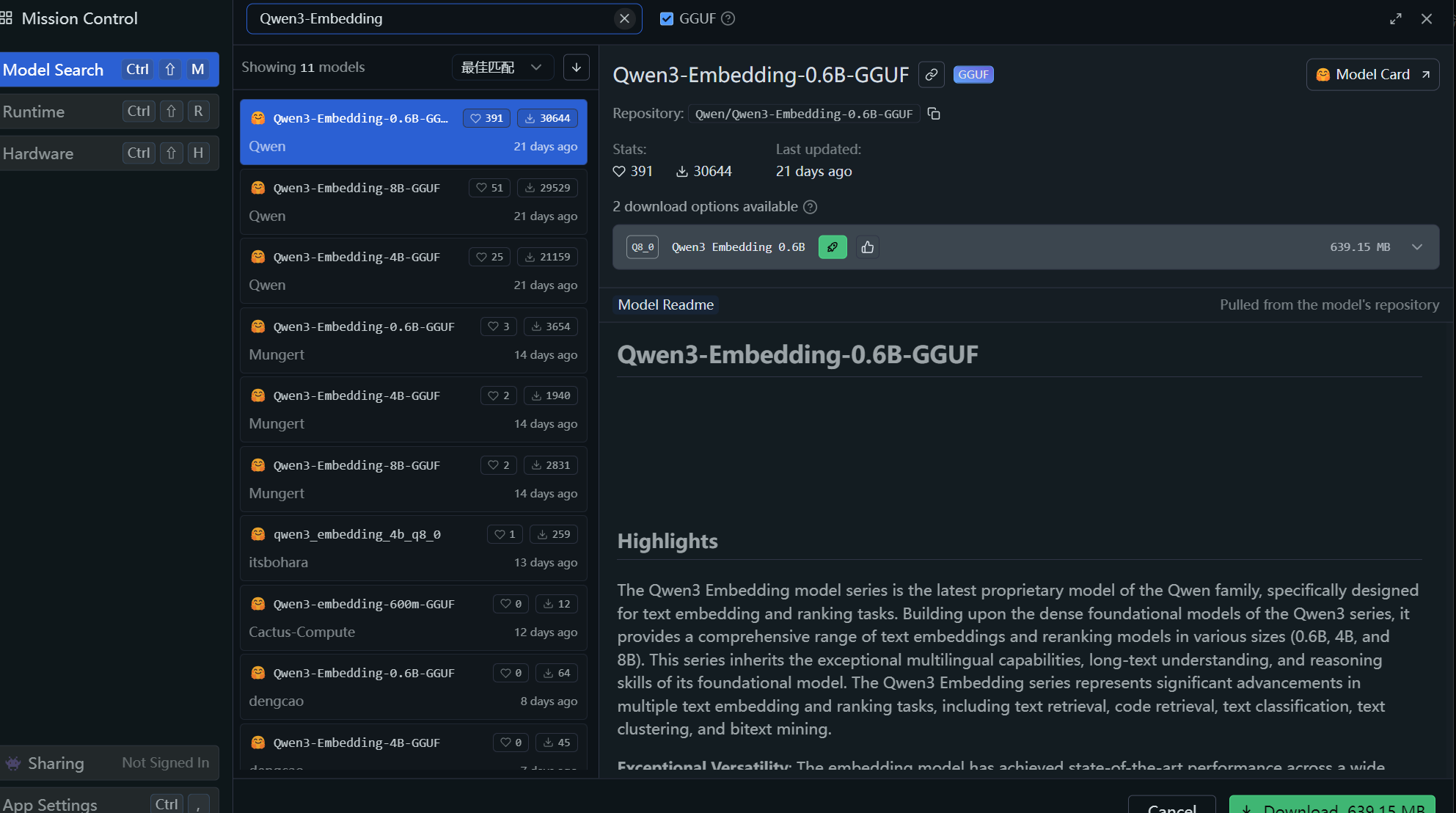

模型下载指南

本地端口暴露配置

参考教程

详细配置方法请参考:https://zhuanlan.zhihu.com/p/1899576951523509763

关键配置步骤

- 启动LM Studio

- 选择并加载模型

- 配置本地服务器

- 设置端口和参数

- 测试连接

AutoGen集成方案

在AutoGen中调用LM Studio

[在此处详细说明如何在AutoGen中配置和使用LM Studio]

代码示例

该代码为关键代码。端口号可以自己调整

model_client = OpenAIChatCompletionClient(

model="qwen/qwen3-4b",

base_url="http://192.168.103.221:1234/v1",

api_key=123,

model_info={

"family": "LM_stduio", # 添加这个字段来解决KeyError

"vision": False,

"function_calling": True,

"json_output": False,

"structured_output": True,

}

)

优势对比

| 特性 | Ollama | LM Studio |

|---|---|---|

| 工具调用稳定性 | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| 模型兼容性 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| 资源占用 | ⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

| 配置复杂度 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ |

| 社区支持 | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ |

总结

通过使用LM Studio替代Ollama,我们成功解决了工具调用的稳定性问题,为AutoGen项目提供了更加可靠的本地模型调用方案。希望本文能够帮助更多开发者解决类似问题。

参考资料

版权声明:本文为原创文章,转载请注明出处。

标签:#AutoGen #LMStudio #Ollama #AI工具调用 #本地模型 #多智能体

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)