深度学习(4)基础4 -- 神经网络架构&&激活函数&&过拟合处理

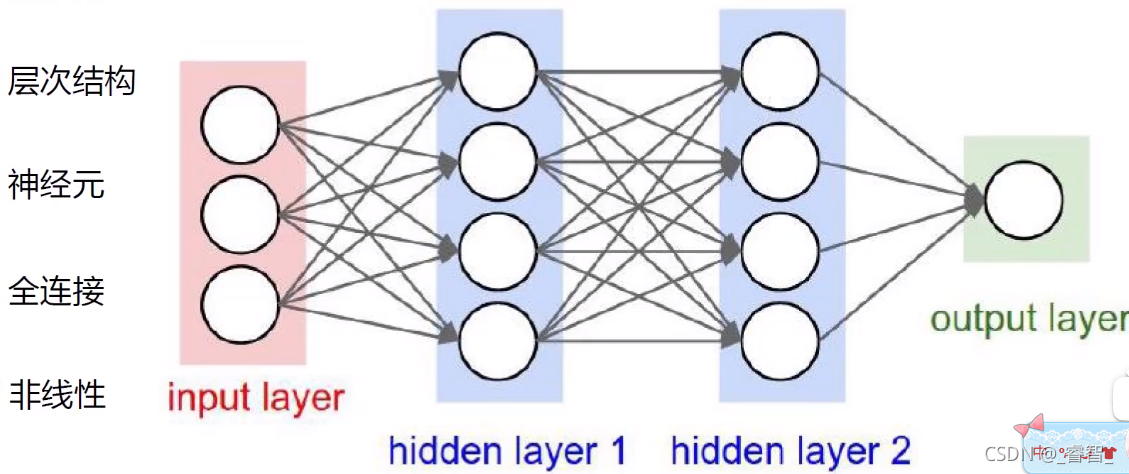

目录一、神经网络架构1、结构与意义2、过程1、输入数据,得到输入层2、得到隐藏层13、得到隐藏层24、得到输出层二、神经元数量一、神经网络架构1、结构与意义神经网络一层一层地处理。输入层(input layer)有多少个圈,代表输入数据多少。隐层没有特定的含义,它只是一个数值,便于计算机更好地认识,隐层和每个输入层全连接。2、过程1、输入数据,得到输入层2、得到隐藏层1先输入数据,通过输入层[1*

目录

一、神经网络架构

1、结构与意义

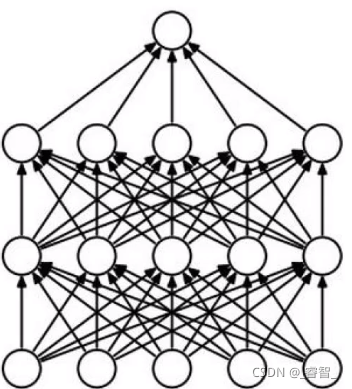

神经网络一层一层地处理。

输入层(input layer)有多少个圈,代表输入数据多少。

隐层没有特定的含义,它只是一个数值,便于计算机更好地认识,隐层和每个输入层全连接。

2、过程

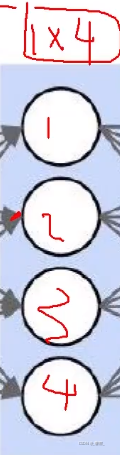

1、输入数据,得到输入层

2、得到隐藏层1

先输入数据,通过输入层[1*3],经过权重参数矩阵w1[3*4](3个参数变4个),把输入层的数据转转换一下。

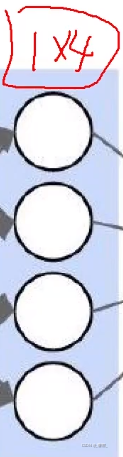

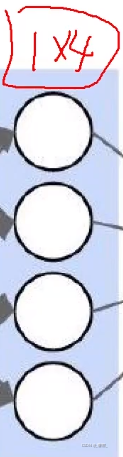

3、得到隐藏层2

再经过w2[4*4],把隐藏层1的结果再进行一次转换,得到w3

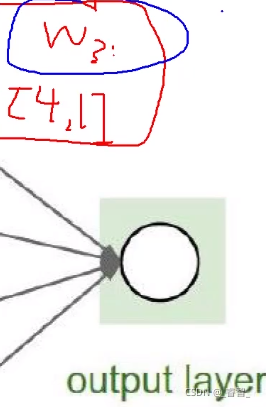

4、得到输出层

再经过w3[4,1],把隐藏层2的结果再进行一次转换,得到最终的输出层(output layer)

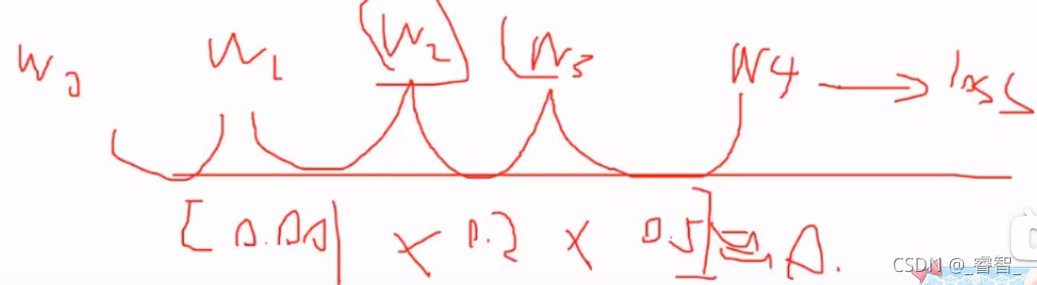

注:该过程为非线性计算,每一步需要单独进行操作,不能一步到位。(如果w4=w1*w2*w3,不能用w4直接代替w1、w2、w3的过程,需要一步一步组合:即分别把输入和w1组合,再把结果和w2组合、再把结果和w3组合,得到结果)

二、激活函数

激活函数概念

首先,前向传播和反向传播都需要激活函数。

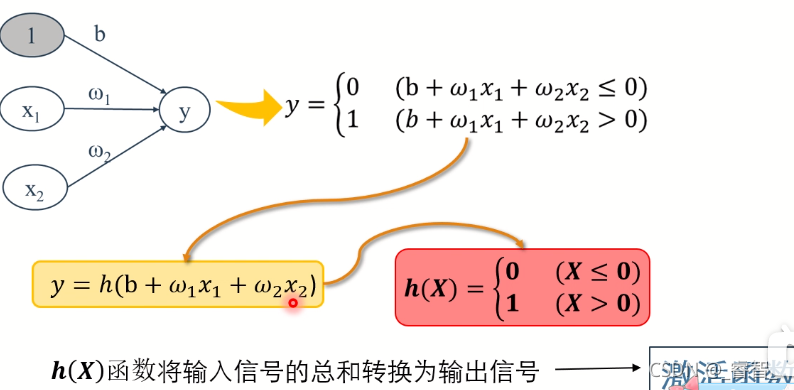

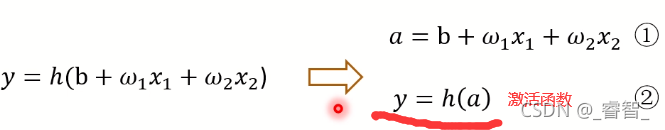

作用:在于决定如何激活输入信号的总和。

激活函数的选择

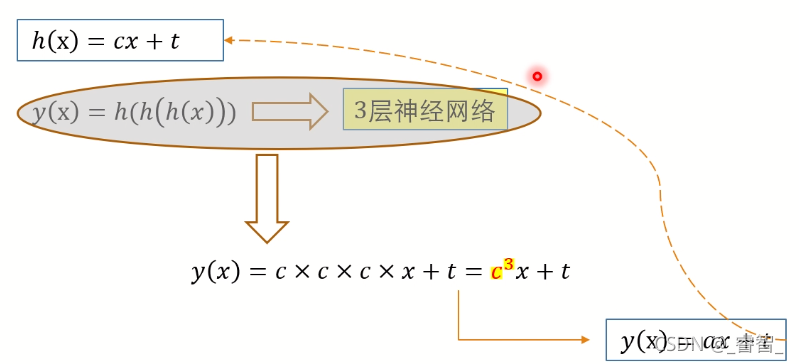

必须是非线性函数。

反例:(线性函数)

线性变换的话, 本质上没太大变化,还是一元一次函数。

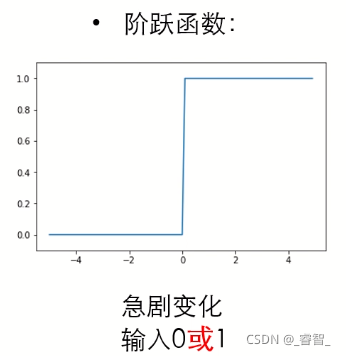

1、阶跃函数

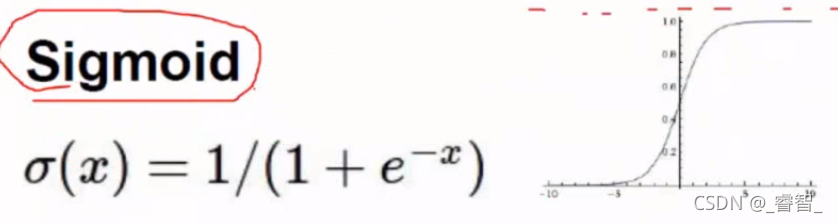

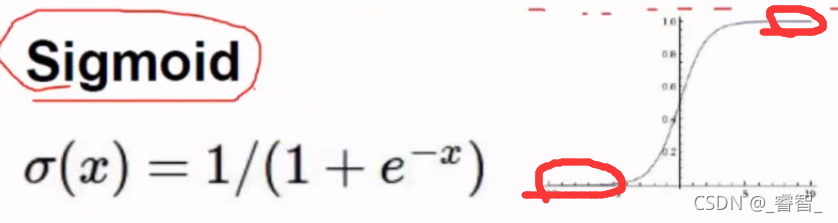

2、Sigmoid函数

梯度消失:

当x<-10或x>10时,其导数很小,当层数很多的时候,容易产生梯度消失现象。

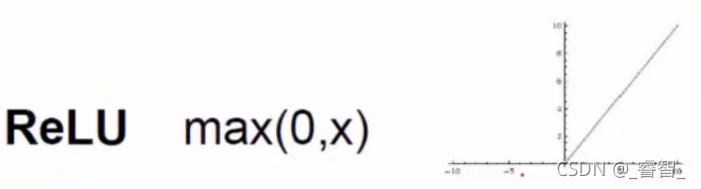

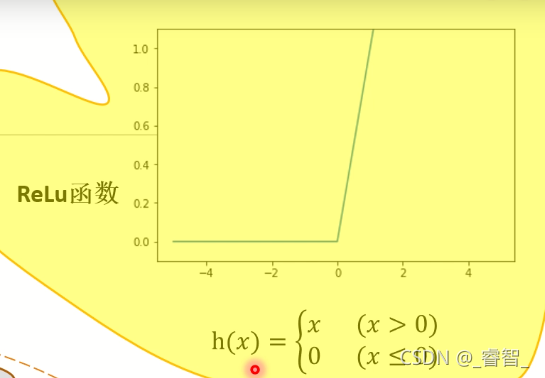

3、ReLU函数

该函数是当前最常用的激活函数,既能解决梯度消失的情况,求导又比较简单。

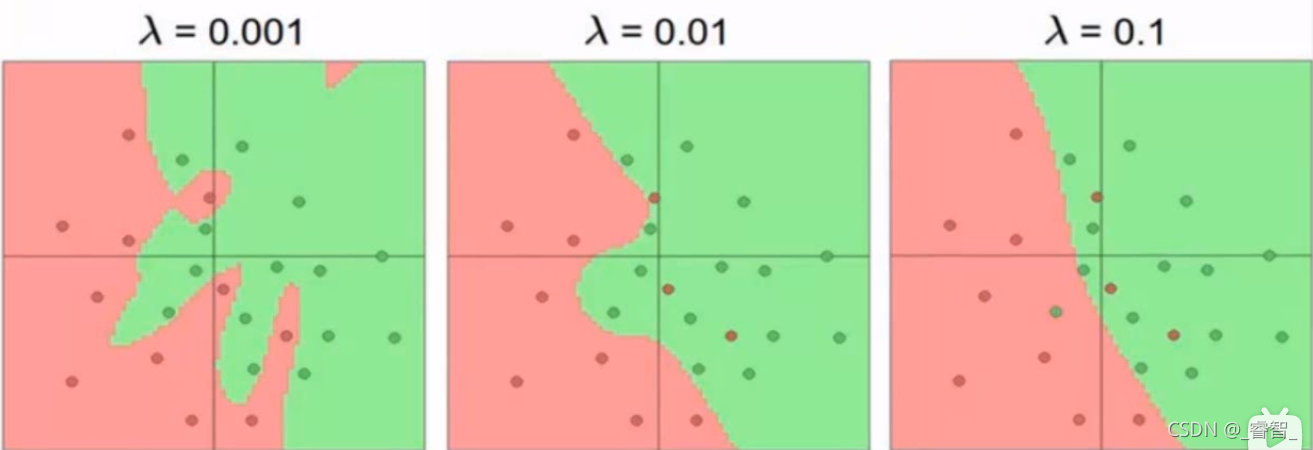

三、过拟合处理

有时候会出现过拟合现象,是我们不希望看到的情况。

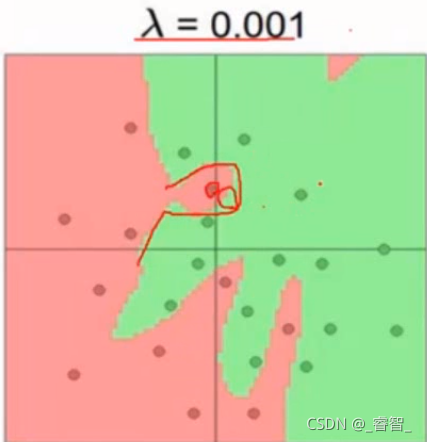

比如=0.001就是过拟合的情况:

在那个红圈的范围内,是绿色的可能性会更大。

要看的不是训练集,而是测试集的效果,我们希望它泛化能力越强越好。

过拟合解决方法:

1、正则化。

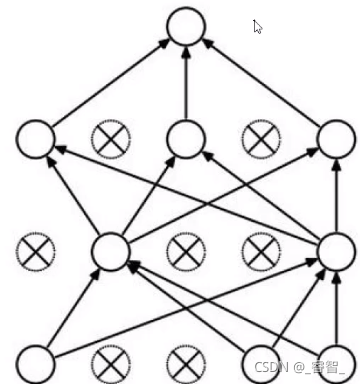

2、DROP-OUT:训练阶段损失一部分的神经元,防止过拟合。

(训练阶段每层抽取一部分神经元,测试不用管)

DROP-OUT:

更多推荐

已为社区贡献20条内容

已为社区贡献20条内容

所有评论(0)