卷积神经网络的基础知识笔记

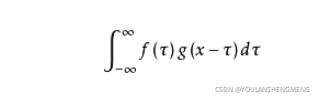

1,什么是卷积卷积的定义:卷积是两个变量在某范围内相乘后求和的结果

1,卷积

卷积的定义: 卷积是两个变量在某范围内相乘后求和的结果

卷积运算可划分为三种:Same卷积、Valid卷积、Full卷积(反卷积)。

Same卷积

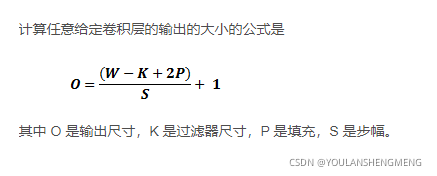

通过Padding填充0运算保证卷积前后特征图大小不变,即W1=W2、H1=H2。公式为:(W1-F+2P)/S+1 = W2

若令W1=W2则可计算填充0的P的值为多少。如,令F=3,S=1,W1=5,则计算P=1.

Valid卷积

不加入Padding运算,直接进行卷积运算,特征图会变小。公式为:(W1-F)/S+1=W2

如,令W1=5,F=3,S=1,则W2=3

Full卷积

实现反卷积运算的核心步骤是在特征图中padding 0,然后进行卷积运算使得特征图变大。公式为:(W1-F+2P)/S+1 = W2

如,令W1=5,F=3,P=2,S=1,则W2=7

2,反卷积(FCN反卷积)

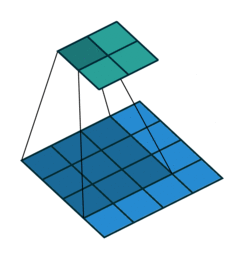

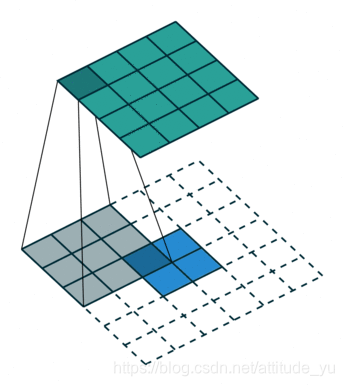

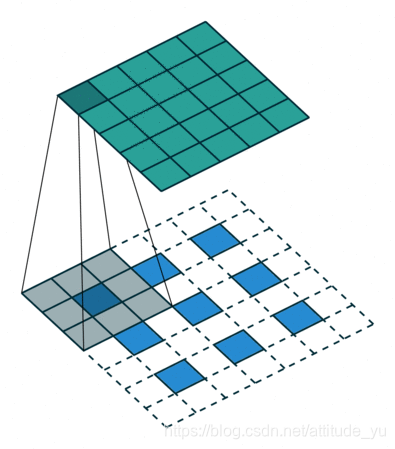

FCN反卷积 反卷积运算方式则不同于以上的Full卷积方式,而是首先对特征图各神经元之间进行0填充,即上池化;然后再进行卷积运算。计算公式为:(W1−1)×S-2×P+F=W2

通常卷积会造成分辨率降低,反卷积是卷积的逆向过程,就如卷积将4*4的变为2*2,反卷积的作用就是将2*2通过反卷积的作用,转换为4*4;

3,卷积神经网络和BP神经网络的区别

1)卷积神经网络中的神经元只与前一层中的部分神经元相连;

2)BP神经网络前后层的神经元是全连接的。就是每个神经元和前一个神经元都会连接

4,感受野

感受野就是某一层的输出结果的一个元素对应输入层的一个映射,即特征平面上的一个点对应的输入图像上的区域 ,感受野越大 ,得到的信息越多;

5,一层神经网络的参数量

卷积神经网络某一层的参数由输入的通道数N,输出通道数M和卷积核的尺寸r,这一层的参数数量为M*N*r*r;

6,卷积神经网络的结构

层级网络,数据包括输入层,卷积层,激活层,池化层,全连接层等

输入层:就是原始图像,非提取的信息,因此卷积神经网络是一个无监督的特征学习网络

数据输入层主要对原始图像数据进行预处理,基础的操作包括去均值、灰度归一化,数据增强等;

卷积层:就是特征提取层,一般卷积神经网络包含多个卷积层,一个卷积层可以有多个不同的卷积核。通过不同的多个卷积核对图像进行预处理,提取特征,每个卷积核会映射出新的特征平面。再通过非线性激活函数对卷积结果进行处理;

激活层:卷积神经网络需要激活层进行特征的选择和抑制;

池化层:用于降低特征平面分辨率及抽象特征,可以有效的压缩网络参数和数据,减少过拟合。池化层最主要的作用就是压缩图像同时保存图像的特征不变;

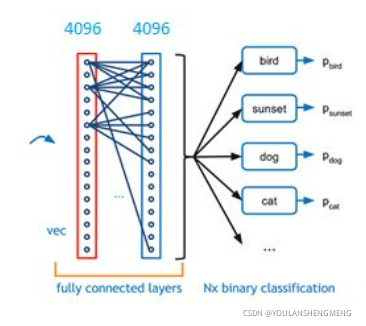

全连接层:是卷积神经网络的最后,具有卷积核和偏移量两个参数。(fully connected layers,FC)在整个卷积神经网络中起到“分类器”的作用,全连接层则起到将学到的“分布式特征表示”映射到样本标记空间的作用。在实际使用中,全连接层可由卷积操作实现:对前层是全连接的全连接层可以转化为卷积核为1x1的卷积;而前层是卷积层的全连接层可以转化为卷积核为hxw的全局卷积,h和w分别为前层卷积结果的高和宽;

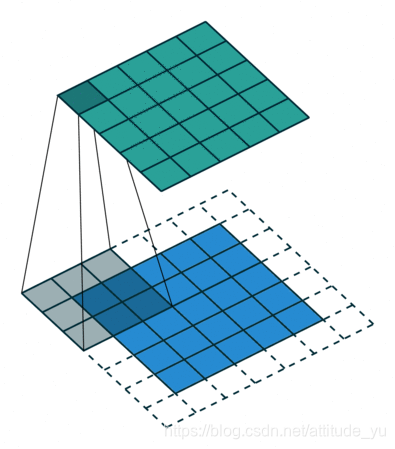

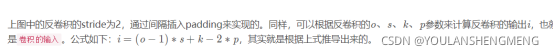

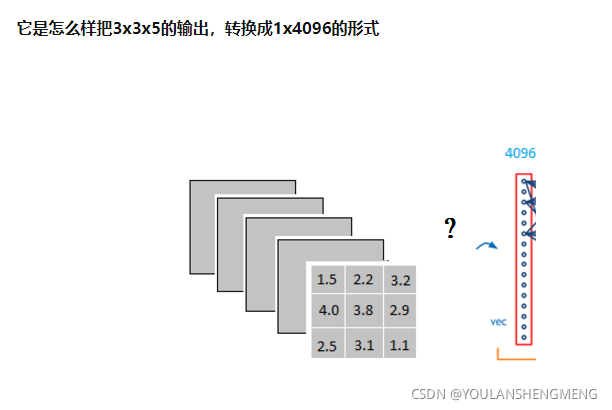

使用简单的卷积网络,但不推理,如3*3*5的卷积层输出层,怎样变成1*4096的形式

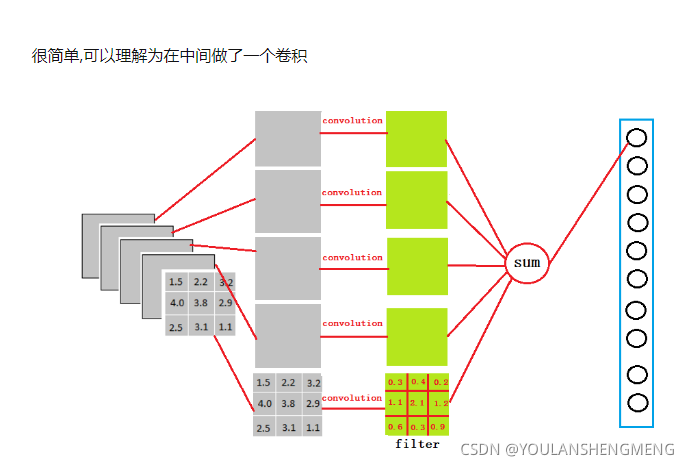

可以简单看做是下图的一个卷积方法

绿色的卷积核3x3x5,分别和灰色的5层卷积然后求和,放在全卷积的第一个位置。使用同理的方法,使用4096和3*3的卷积核,分别和5层卷积 求和填入一维的全卷积中;我们实际就是用一个3x3x5x4096的卷积层去卷积激活函数的输出,作用是大大减少特征位置对分类带来的影响

损失层:作用找到最小化损失函数的参数值,常用的是SGD(随机梯度下降)算法来调整权值,孙损失层的输入就是网络的输出和真实的标签值;

精度层:求分类精度使用,精度层的输入是网络的输出的标签和数据集真实的标签,主要是一个反应网络性能指标的一个评判;

上面的内容感谢博文;

Tensorflow反卷积(DeConv)实现原理+手写python代码实现反卷积(DeConv) - 简书h

还有言有三老师的书籍,这些笔记都是参考这两个老师。

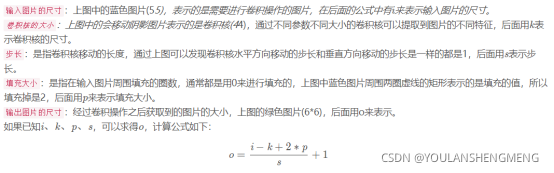

7.什么是权重共享

卷积核在进行计算的时候,如上图,滤波器中的参数是固定不变的,按照设定好的步数移动扫面完全部位置,参数(权重)共享就是说被扫描的像素全都共享这个滤波器中的权重进行计算。说白了就是所有被扫描的像素每一次都是用这个滤波器进行计算。

更多推荐

已为社区贡献25条内容

已为社区贡献25条内容

所有评论(0)