多智能体协同:是“群策群力”,还是“内耗加剧”?

当AI不再单打独斗,而是组成“团队”协同作战,我们是否真的迎来了智能跃迁的拐点?据IDC预测,到2027年,超过六成的大型企业将部署协作型智能体系统,预期可使关键业务流程效率提升50%以上。听上去,这似乎是一条通往更强大人工智能的“高速公路”。

当AI不再单打独斗,而是组成“团队”协同作战,我们是否真的迎来了智能跃迁的拐点?

近年来,一种全新的AI范式正在悄然崛起:让多个AI智能体像人类团队一样分工合作、共同决策。从谷歌、微软到一众AI初创公司,纷纷押注这一方向,宣称它将打破大模型的性能瓶颈,实现“1+1>2”的智能叠加。

据IDC预测,到2027年,超过六成的大型企业将部署协作型智能体系统,预期可使关键业务流程效率提升50%以上。听上去,这似乎是一条通往更强大人工智能的“高速公路”。

但现实真的如此顺畅吗?不少用户反馈,在处理复杂任务时,多智能体系统的响应速度反而变慢,资源消耗激增,最终输出的效果却并未带来质的飞跃。

为什么理论上更聪明的“团队”,在实践中却频频“掉链子”?

单兵作战 vs 团队协作:两种AI范式之争

目前主流的AI应用主要分为两类:单一智能体和多智能体协作系统。

像ChatGPT、Claude这类我们熟悉的AI助手,属于典型的“全能型选手”——一个模型包揽所有任务:理解问题、检索信息、生成内容、逻辑推理……它就像一把瑞士军刀,功能齐全,但能力上限受限于自身规模与训练数据。

这种模式结构简单、部署成本低,适合大多数通用场景。但一旦任务变得高度复杂,比如需要跨领域知识整合、实时反馈或多模态协同,单一智能体就容易“力不从心”,甚至因幻觉或错误累积导致整体失败。

于是,多智能体协作(Multi-Agent System, MAS)应运而生。

它的设计灵感来自人类社会的组织方式:不再依赖一个“全知全能”的大脑,而是构建一支由多个“专家”组成的AI团队。每个智能体专精某一领域,通过通信、协商与协同,共同完成复杂任务。

举个例子:一个看似自然流畅的数字人主播,背后其实是四个智能体的默契配合——

- 语音生成Agent:负责合成自然语音;

- 口型同步Agent:确保嘴型与发音精准匹配;

- 表情控制Agent:调节微表情传递情绪;

- 知识检索Agent:实时调用数据库回答问题。

它们各司其职,协同运作,最终呈现出远超单个模型能力的拟人化表现。

更重要的是,多智能体系统能将原本串行的任务并行化处理。例如在软件开发中,一个Agent写代码,另一个同步做单元测试,第三个自动生成文档——任务周期大幅压缩。

Anthropic的一项研究显示,采用“主控Agent+多个执行Agent”的架构后,系统整体性能比最强的单体模型高出近90%,而响应时间并未显著增加。

此外,多智能体还具备更强的容错性与可扩展性。某个Agent出错或被攻击,其他成员可接管任务,系统不至于完全瘫痪;需要新增功能时,只需“招聘”一个新的专家Agent加入即可,无需重构整个系统。

听起来,这像是AI进化的理想形态——一个去中心化、高鲁棒、可进化的智能生态。

但问题也随之而来:团队越大,管理越难。

协同的代价:当“专家团”变成“争吵群”

多智能体的优势有多耀眼,其潜在风险就有多隐蔽。

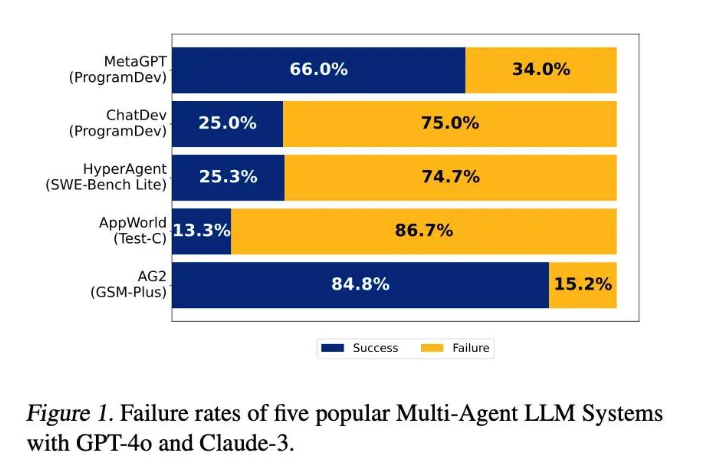

一篇名为《Why Do Multi-Agent LLM Systems Fail?》的研究论文,通过对7个主流多智能体框架、200多个任务的深入分析,揭示了一个令人警醒的现象:智能体数量越多,系统整体表现反而可能下降。

为什么会这样?

1. 目标失焦:各自为政,越努力越偏离

理想中,每个Agent都应朝着共同目标前进。但现实中,由于任务分解不当或理解偏差,智能体之间容易出现“盲人摸象”式的误判。

比如,一个负责撰写报告的Agent可能误解了用户需求,另一个负责数据验证的Agent又未能及时纠正,最终输出的结果看似逻辑完整,实则偏离核心诉求。研究发现,在极端情况下,多智能体系统的准确率甚至低于25%,还不如单个模型多次采样取优。

在数字人场景中,若语音与口型同步延迟超过80毫秒,观众就会产生“恐怖谷效应”——明明是虚拟形象,却因不协调的动作感到不适。

2. 沟通成本:信息越多,噪音越大

协作离不开沟通,但频繁的信息交换带来了高昂的算力开销。

传统多智能体辩论机制(MAD)依赖多轮显式消息传递,每个Agent不断发送状态更新、请求确认、反驳观点……这些交互产生的token消耗,往往是普通对话的4到15倍。

更糟的是,重复沟通不仅浪费资源,还可能引入矛盾信息。多个Agent对同一问题给出不同答案,系统陷入“内耗”,最终决策反而更加混乱。

3. 责任模糊:出了错,谁来背锅?

在单一智能体中,责任归属清晰:错了就是它的问题。但在多智能体系统中,错误往往是多个环节叠加的结果——是任务分配不合理?是某个Agent产生幻觉?还是仲裁机制失效?

这种“责任分散”现象,不仅增加了调试难度,也为安全攻击提供了可乘之机。黑客可能通过诱导某个边缘Agent输出错误信息,进而影响整个系统的判断,实现“以小博大”的渗透。

如何让AI团队真正“高效协同”?

既然问题重重,为何业界仍前赴后继地投入多智能体研发?

答案很明确:天花板更高。

单一智能体的能力提升依赖模型规模扩展,边际效益递减;而多智能体的瓶颈更多是工程问题——只要系统设计得当,就能持续优化。

那么,如何破解“协作悖论”,让AI团队既聪明又可控?

✅ 引入“管理者”:设立协调中枢

最有效的策略之一,是引入一个主控Agent(Coordinator Agent),负责任务分解、进度监控与冲突仲裁。

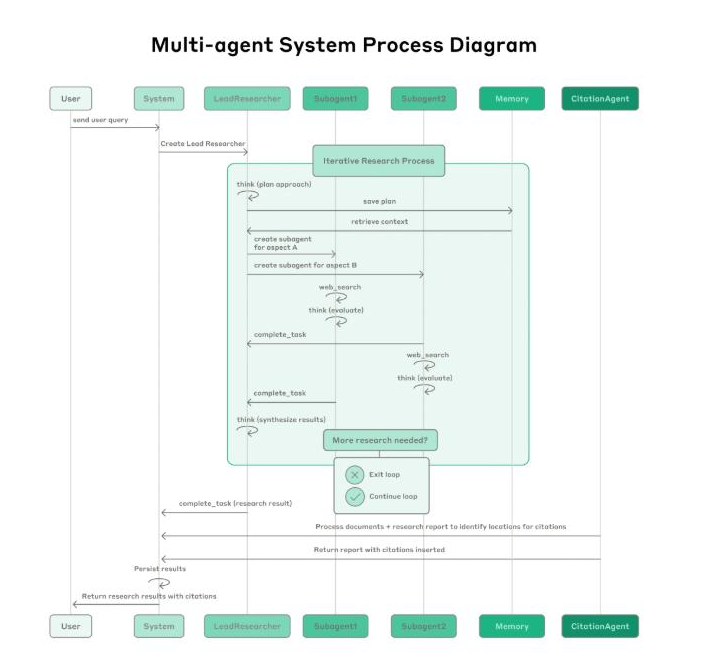

Anthropic在其研究系统中采用“主研-子代理”架构:由一个高能力Agent制定计划,再派生多个子Agent并行执行任务,最后汇总结果。这种方式有效避免了“群龙无首”的混乱,确保团队始终对齐目标。

✅ 建立“沟通标准”:统一语言,减少误解

为了让不同智能体高效协作,行业正在推动标准化通信协议,如MCP(Model Communication Protocol)、A2A(Agent-to-Agent)等。

这些协议就像AI世界的“通用语”,让不同框架、不同厂商的智能体可以无缝对接。例如,GenFlow 2.0已支持MCP协议,开发者可像搭积木一样,灵活组合各类功能模块,快速构建复杂应用。

✅ 加强“故障溯源”:打造AI“心理医生”

面对系统级错误,研究人员正开发自动化归因工具,能够快速定位问题源头——是哪个Agent出错?在哪一步发生偏差?这类工具如同“团队心理医生”,帮助系统实现自我诊断与修复。

同时,通过对抗训练和韧性设计,让系统在部分节点受损时仍能维持基本功能,提升整体鲁棒性。

不是所有任务,都需要“团队作战”

值得注意的是,多智能体并非万能解药。

对于简单、线性、目标明确的任务(如回答常识问题、生成短文案),使用单一智能体更经济高效。多智能体的价值,主要体现在以下场景:

- 高复杂度任务(如科研探索、战略决策)

- 多领域知识融合(如医疗诊断+药物研发)

- 高并发与并行处理需求(如自动化客服矩阵)

- 对容错性和安全性要求极高的系统

未来的技术趋势,是在分布式智能与集中式控制之间寻找平衡:既要释放每个智能体的自主性,又要通过规则、协议与协调机制,确保整体行为可控、可预测、可解释。

结语:从“个体智能”到“组织智能”

多智能体协作的本质,不是让AI变得更聪明,而是让它们学会“如何一起工作”。

这不仅是技术的升级,更是思维方式的转变——从追求“超级个体”,转向构建“高效组织”。

正如人类社会的文明进步,从来不是靠一个天才,而是靠无数个体在规则与协作中达成共识。

AI的未来,或许不在于谁更强大,而在于谁更能协同。

而我们要做的,不仅是训练更聪明的Agent,更是设计更智慧的“团队机制”。

毕竟,真正的智能,从来都不是孤独的闪耀,而是群体的共鸣。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)