当RAG遇上MCP...

随着基础模型能力的不断增强,现实世界中的应用场景对人工智能提出了更高的要求,推动其向更具上下文感知能力、依赖外部信息检索以及由智能智能体驱动的方向发展。为了满足这些需求,诸如检索增强生成(RAG)和MCP等关键技术正逐步成为构建现代AI系统的核心组成部分。检索增强生成(RAG)是一种结合语言模型与外部知识库的方法,使模型能够在生成回答之前,先通过向量搜索或语义搜索技术检索相关的文档内容。随后,这些

随着基础模型能力的不断增强,现实世界中的应用场景对人工智能提出了更高的要求,推动其向更具上下文感知能力、依赖外部信息检索以及由智能智能体驱动的方向发展。为了满足这些需求,诸如检索增强生成(RAG)和MCP等关键技术正逐步成为构建现代AI系统的核心组成部分。

1. 简要回顾

检索增强生成(RAG)是一种结合语言模型与外部知识库的方法,使模型能够在生成回答之前,先通过向量搜索或语义搜索技术检索相关的文档内容。随后,这些检索到的信息会被整合进提示词中,作为生成响应的依据。这种机制不仅有效缓解了模型在处理超出训练数据范围问题时的上下文长度限制,还显著降低了“幻觉”现象的发生概率,使输出更加准确且基于事实。

与此同时,MCP 提供了一种结构化的方式来编码 AI 智能体的动态上下文,特别适用于需要长时间运行、具备角色认知和工具理解能力的复杂任务。它帮助智能体维护自身身份、管理任务状态,并协调与外部环境的交互。可以将其视为围绕 RAG 查询所构建的一层轻量级协议,融合了元数据与推理状态,从而实现更灵活的记忆存储、上下文链接以及环境信息注入。这种设计大大增强了智能体系统的可扩展性和可控性,为未来智能化应用的发展提供了坚实的基础。

2.RAG-MCP的工作流程示意

这个流程展示了一个现代 AI 应用程序中,如何将用户的问题转化为一个结构清晰、有上下文支持的智能响应过程。整个流程可以分为以下几个关键步骤:

User Query

↓

Retriever → [Documents]

↓

MCP Formatter: {"role": "analyst", "task": "...", "context": [docs]}

↓

LLM (Gemini/Claude/GPT)

↓

Response grounded in context + protocol- 用户查询(User Query)用户提出一个自然语言问题或请求,例如“最近的财报显示公司收入增长了吗?”

- 检索器(Retriever)系统使用检索器从外部知识库(如数据库、文档库或网络资源)中查找与问题相关的文档或信息。这些文档可能包括最新的财报数据、市场分析报告等。

- MCP 格式化(MCP Formatter)MCP 是一种结构化的上下文管理机制。在此步骤中,系统将检索到的信息与用户的任务结合,并按照预定义的格式组织起来。例如:这一步确保了模型在生成答案时不仅了解问题本身,还清楚自己的角色和可用的信息来源。

- 角色(role):“分析师”——告诉模型它应该以专业视角回答问题;

- 任务(task):“分析收入变化趋势”;

- 上下文(context):包含检索到的相关文档内容。

- 大语言模型(LLM)处理经过格式化的输入被送入大型语言模型(如 Gemini、Claude 或 GPT),模型会基于提供的上下文和角色设定进行推理和生成。

- 响应生成(Response grounded in context + protocol)模型输出一个既符合用户需求,又建立在真实文档和结构化指令基础上的回答。这种响应是“有据可依”的,避免了传统模型可能出现的“幻觉”问题(即编造信息)。

该流程融合了检索增强生成(RAG) 和 智能体驱动的上下文管理(MCP),代表了一种先进的 AI 工作流设计方式。它不仅提升了模型回答问题的准确性,也增强了其在复杂业务场景下的实用性,例如企业决策支持、个性化客服、智能助手等领域。

3.实验: 最小化的RAG-MCP流水线

3.1. 安装依赖库

pip install sentence-transformers faiss-cpu openai3.2. 配置向量存储

from sentence_transformers import SentenceTransformer

import faiss

import numpy as np

# Documents to retrieve from

docs = [

"RAG uses retrieval to improve generation.",

"MCP is a protocol for embedding model behavior and task context.",

"LangChain and LlamaIndex offer RAG frameworks.",

"Vector stores allow semantic search over text."

]

# Create vector index

model = SentenceTransformer("all-MiniLM-L6-v2")

embeddings = model.encode(docs)

index = faiss.IndexFlatL2(embeddings.shape[1])

index.add(embeddings)3.3. 定义检索器

def retrieve_top_k(query, k=2):

query_vec = model.encode([query])

D, I = index.search(np.array(query_vec), k)

return [docs[i] for i in I[0]]3.4. 构建MCP 封装

def build_mcp_prompt(user_query, context_docs):

return f"""<MCP>

Role: Analyst Agent

Task: Answer user query with context-aware, grounded reasoning.

Context:

{"".join(f"- {doc}\n" for doc in context_docs)}

User Query:

{user_query}

Answer:"""3.5. 生成响应 (OpenAI示例)

import openai

openai.api_key = "your-openai-key"

def generate_with_openai(prompt):

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[{ "role": "user", "content": prompt }],

temperature=0.5

)

return response.choices[0].message["content"]3.6. 完整的流水线

query = "How does MCP help with AI agent context?"

retrieved = retrieve_top_k(query, k=2)

mcp_prompt = build_mcp_prompt(query, retrieved)

output = generate_with_openai(mcp_prompt)

print("🔍 MCP Prompt:\n", mcp_prompt)

print("\n💡 RAG-MCP Answer:\n", output)4.小结

RAG-MCP 构成了智能、工具驱动型人工智能智能体的核心之一。无论是借助 LangChain、LlamaIndex 等现成框架,还是自行开发编排系统,MCP 都能为 RAG(检索增强生成)流程引入清晰的结构化逻辑。这种结构不仅提升了智能体在处理复杂任务时的一致性和可控性,还增强了其决策过程的可解释性与整体能力,使 AI 智能体能够在多步骤、长周期的任务中表现得更加稳健和高效。

-

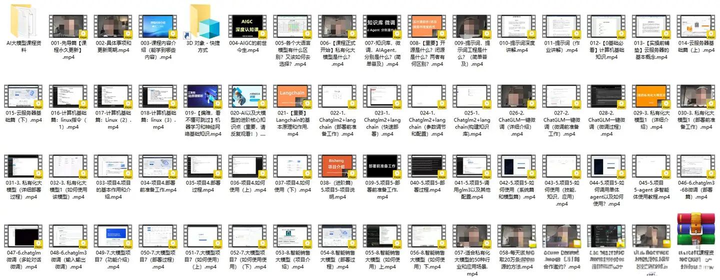

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

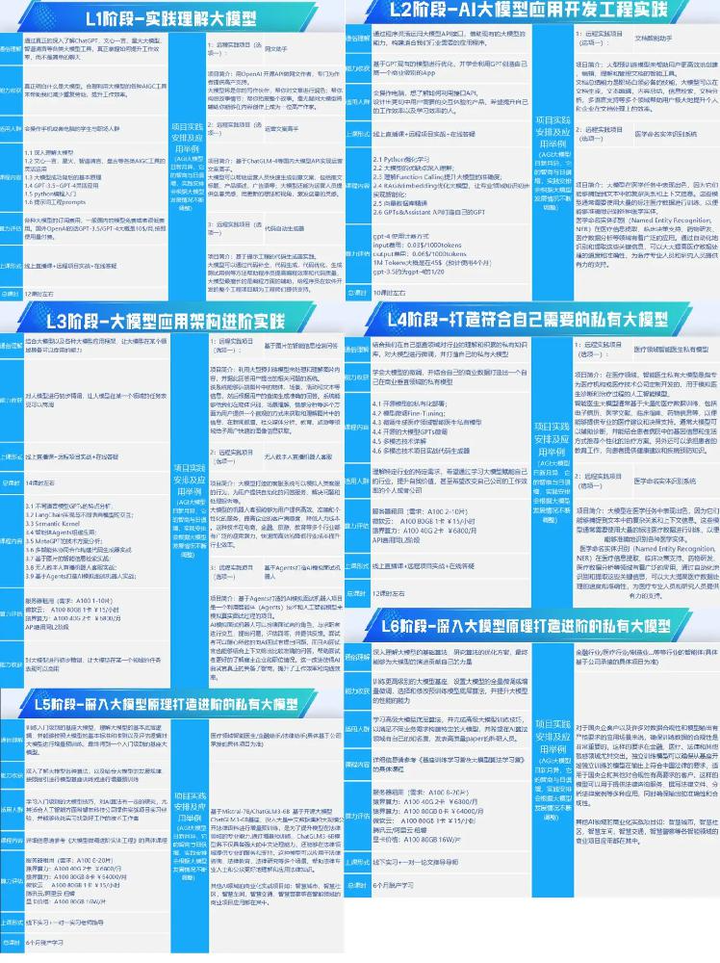

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

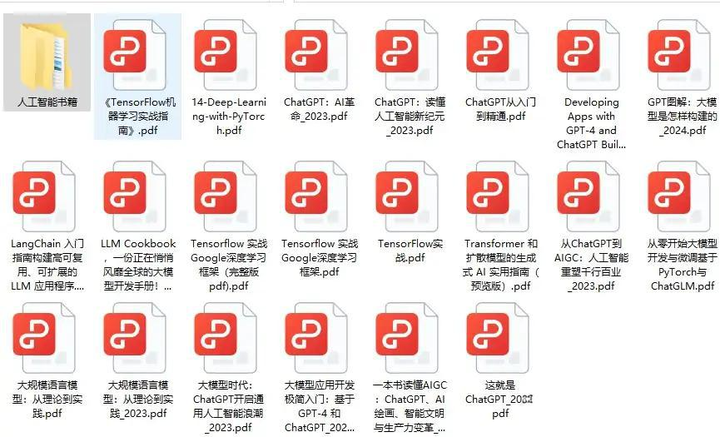

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

四、AI大模型商业化落地方案

因篇幅有限,仅展示部分资料,需要点击文章最下方名片即可前往获取

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)