LangChain 核心组件剖析:Models、Prompts、Chains 详解

随着人工智能技术的快速发展,大语言模型(LLMs)的应用场景日益广泛,但如何高效地集成、管理和优化这些模型,成为开发者和企业面临的重要挑战。LangChain作为一个开源框架,应运而生,旨在简化基于语言模型的应用程序开发流程。它通过模块化的设计,将复杂的AI任务分解为可管理的组件,使开发者能够更灵活地构建、调试和扩展AI应用。自推出以来,LangChain迅速在开发者社区中获得了广泛关注,其生态不

LangChain 概述与核心组件简介

随着人工智能技术的快速发展,大语言模型(LLMs)的应用场景日益广泛,但如何高效地集成、管理和优化这些模型,成为开发者和企业面临的重要挑战。LangChain作为一个开源框架,应运而生,旨在简化基于语言模型的应用程序开发流程。它通过模块化的设计,将复杂的AI任务分解为可管理的组件,使开发者能够更灵活地构建、调试和扩展AI应用。自推出以来,LangChain迅速在开发者社区中获得了广泛关注,其生态不断丰富,支持多种模型和工具集成,成为推动AI应用落地的重要基础设施。截至2025年,LangChain已迭代至v0.2.x版本,新增了对多模态模型(如GPT-4V和Claude 3)的原生支持,并在实时流式处理和低代码配置方面进行了重大增强,被广泛应用于金融、医疗、教育等行业的智能化解决方案中,全球开发者社区贡献了超过500个扩展工具,进一步加速了AI代理技术的普及与创新。

LangChain的核心思想是将AI应用开发抽象为三个基本组件:Models、Prompts和Chains。这三个组件相互协作,形成一个高效的工作流,使开发者能够专注于业务逻辑,而不必深入底层技术细节。Models组件负责处理与各种语言模型的交互,包括大型语言模型(如GPT系列)和嵌入模型,它提供了统一的接口来调用不同供应商的模型,并处理输入输出的标准化。Prompts组件则专注于设计和管理提示词(prompts),通过模板化和动态生成的方式,确保模型接收的指令清晰、有效,从而提高响应的准确性和相关性。Chains组件作为“粘合剂”,将Models和Promots组合成完整的任务流程,支持顺序执行、条件分支和自定义逻辑,使得复杂AI应用(如多轮对话系统或数据分析管道)的构建变得简单而高效。

这三个组件的相互关系可以看作是一个协同工作的管道:Prompts为Models提供结构化的输入,Models生成原始输出,而Chains则负责将这些输出进一步处理、组合或传递给其他组件。这种设计不仅提升了开发效率,还增强了应用的可维护性和可扩展性。例如,在构建一个智能客服机器人时,开发者可以使用Prompts设计用户查询的模板,通过Models获取初步响应,再利用Chains将多个响应组合成连贯的对话流。这种模块化方式使得调试和优化变得更加直观,开发者可以独立调整每个组件,而不影响整体架构。

LangChain的重要性在于它降低了AI应用的门槛,让非专家也能快速上手。同时,它为高级用户提供了深度定制的空间,支持集成外部API、数据库和自定义逻辑。随着AI技术的演进,LangChain持续更新,适应新的模型和行业需求,例如在多模态处理和实时应用方面的扩展。其开源特性也鼓励社区贡献,推动了工具和插件的多样化发展。

尽管LangChain的核心组件看似简单,但其背后的设计哲学体现了现代软件工程的模块化和复用原则。通过将复杂任务分解为可管理的部分,它不仅提升了开发效率,还为AI应用的创新提供了坚实基础。在接下来的章节中,我们将深入剖析Models、Prompts和Chains的具体功能、实现技巧和实际应用案例,帮助读者全面掌握这一强大框架。

Models 组件深度解析

在LangChain框架中,Models组件是构建AI应用的核心基础之一,它负责与各种语言模型进行交互,为上层组件(如Prompts和Chains)提供模型调用能力。Models组件不仅支持大型语言模型(LLMs),还涵盖嵌入模型(Embedding Models)等多类模型,并提供了统一的接口来集成外部模型、处理输出以及优化性能。下面我们从功能、类型、集成方法、输出处理和性能优化几个方面进行深度解析。

Models 组件的功能

Models组件的主要功能是抽象化模型调用过程,使开发者能够通过一致的API与不同类型的模型交互,而无需关注底层实现的差异。无论是OpenAI的GPT-4-turbo、Anthropic的Claude 3,还是开源的Llama 3或嵌入模型,Models组件均提供了标准化接入方式。此外,它还支持模型输出的解析、错误处理以及异步调用,从而提升开发效率和应用的鲁棒性。

例如,通过Models组件,开发者可以轻松切换不同模型提供商,而无需重写大量代码。这种设计符合LangChain的模块化理念,使得AI应用更加灵活和可扩展。

类型:LLMs 与嵌入模型

Models组件主要分为两大类型:大型语言模型(LLMs)和嵌入模型(Embedding Models)。LLMs用于生成文本、回答问题或执行其他自然语言处理任务,而嵌入模型则将文本转换为数值向量,常用于相似性计算、检索或分类任务。

在LLMs中,LangChain支持多种模型,包括:

- 通用LLMs:如OpenAI的GPT-4-turbo、Anthropic的Claude 3,以及Meta的Llama 3。这些模型适用于对话生成、内容创作等场景。

- 专用LLMs:一些领域特定模型,如代码生成模型(例如DeepSeek Coder)或医疗问答模型,可通过LangChain集成。

嵌入模型则包括OpenAI的text-embedding-3-large、BGE Large等,它们将文本转换为高维向量,用于语义搜索或推荐系统。

选择模型时,开发者需考虑多个因素:任务类型(生成vs.嵌入)、模型性能(延迟、准确性)、成本(API调用费用)以及合规性(数据隐私)。例如,对于高吞吐量的生产环境,可能优先选择低延迟的模型,而对质量要求极高的场景,则可能选用最新版本的LLMs。

集成外部模型

LangChain提供了灵活的机制来集成外部模型,无论是通过API调用云端模型,还是本地部署开源模型。集成过程通常通过LangChain的模型类(如OpenAI、HuggingFacePipeline)实现,开发者只需配置模型参数(如API密钥、模型名称)即可快速接入。

以下是一个集成OpenAI GPT-4-turbo模型的代码示例,展示了如何初始化并调用模型:

from langchain.llms import OpenAI

# 初始化OpenAI模型,指定模型名称和API密钥

llm = OpenAI(model_name="gpt-4-turbo", openai_api_key="your_api_key")

# 调用模型生成文本

response = llm("请解释LangChain的Models组件。")

print(response)

对于本地模型,例如使用Hugging Face的Transformers库,可以通过以下方式集成:

from langchain.llms import HuggingFacePipeline

from transformers import pipeline

# 创建本地模型管道

hf_pipeline = pipeline("text-generation", model="Llama-3-8B")

llm = HuggingFacePipeline(pipeline=hf_pipeline)

# 调用本地模型

response = llm("LangChain是什么?")

print(response)

这种集成方式不仅简化了代码,还允许开发者在不同模型间无缝切换,例如通过环境变量或配置文件动态选择模型提供商。

处理模型输出

Models组件提供了丰富的工具来处理和解析模型输出,包括文本生成、结构化输出(如JSON)以及错误处理。例如,对于生成任务,输出通常是字符串,但LangChain支持通过解析器(Output Parsers)将输出转换为特定格式,如列表或字典,这在与Chains组件结合时尤为有用。

以下示例演示了如何使用输出解析器处理模型响应:

from langchain.output_parsers import StructuredOutputParser, ResponseSchema

from langchain.llms import OpenAI

# 定义输出结构

response_schemas = [

ResponseSchema(name="summary", description="生成的摘要"),

ResponseSchema(name="keywords", description="关键词列表")

]

parser = StructuredOutputParser.from_response_schemas(response_schemas)

# 初始化模型并生成带格式的提示

llm = OpenAI(model_name="gpt-4-turbo")

prompt = "生成一段关于AI的摘要,并提取关键词。输出格式为:{format_instructions}"

response = llm(prompt.format(format_instructions=parser.get_format_instructions()))

# 解析输出

parsed_output = parser.parse(response)

print(parsed_output)

对于错误处理,Models组件内置了重试机制和异常捕获,例如当API调用失败时,自动进行重试或回退到备用模型,这增强了应用的稳定性。

优化性能

性能优化是Models组件的重要方面,涉及延迟降低、吞吐量提升和成本控制。LangChain提供了多种策略来优化模型调用:

- 缓存机制:通过集成缓存(如InMemoryCache或RedisCache),避免重复调用相同输入,减少延迟和成本。例如,可以使用

langchain.cache模块启用缓存:from langchain.cache import InMemoryCache from langchain.llms import OpenAI import langchain langchain.llm_cache = InMemoryCache() llm = OpenAI() # 第一次调用会请求模型,后续相同输入从缓存读取 response1 = llm("什么是AI?") response2 = llm("什么是AI?") # 从缓存获取 - 异步调用:对于高并发场景,Models组件支持异步操作,通过

async方法提升吞吐量。例如:import asyncio from langchain.llms import OpenAI llm = OpenAI() async def generate_async(): response = await llm.agenerate(["问题1", "问题2"]) print(response) asyncio.run(generate_async()) - 批处理:通过批量调用模型,减少API请求次数,从而优化性能。以下示例展示了批处理的使用:

from langchain.llms import OpenAI llm = OpenAI() responses = llm.generate(["输入1", "输入2", "输入3"]) for res in responses.generations: print(res[0].text) - 边缘计算集成:结合边缘设备部署轻量化模型,减少云端调用延迟,适用于实时性要求高的场景,如IoT设备或移动应用。

- 模型选择与调参:根据任务需求调整模型参数,如温度(temperature)控制生成随机性,max_tokens限制输出长度,以平衡质量与效率。

通过这些优化手段,开发者可以构建高性能的AI应用,适应不同场景的需求,从实验环境到生产部署。

总之,Models组件作为LangChain的核心,提供了强大而灵活的模型管理能力。通过理解其功能、类型和优化策略,开发者可以更高效地利用各种AI模型,为构建复杂应用奠定基础。在后续章节中,我们将探讨如何与Prompts组件结合,进一步优化输入设计以提升模型表现。

Prompts 组件详解与应用技巧

在LangChain框架中,Prompts组件是连接用户意图与AI模型输出的关键桥梁。它负责将用户的自然语言指令转化为模型可理解的结构化输入,从而引导模型生成符合预期的响应。与传统的直接输入不同,Prompts通过模板化和参数化的方式,使得提示词的设计更加灵活、可复用,同时能够适应多样化的应用场景。

Prompts的核心作用在于标准化和优化与模型的交互过程。通过预定义的模板,开发者可以避免重复编写相似的提示词,同时确保输入的一致性和质量。例如,在构建一个问答系统时,可以设计一个包含问题上下文和用户查询的模板,模型基于此生成精确答案。这不仅提高了开发效率,还显著提升了AI应用的响应准确性和可控性。

设计高效的提示词需要遵循几个基本原则。首先是明确性:提示词应当清晰、无歧义,直接指明模型需要执行的任务。模糊的提示容易导致模型输出偏离预期。例如,在文本摘要任务中,“总结以下文章”比“处理这段文字”更有效。其次是上下文完整性:合理的提示应包含足够的背景信息,帮助模型理解任务的全貌。例如,在代码生成中,提供编程语言、功能需求和输入输出示例,能够显著改善生成结果。最后是适应性:提示词应具备一定的灵活性,能够通过变量动态调整内容,适应不同的输入数据。

LangChain通过PromptTemplate类实现了提示词的模板化。开发者可以创建包含变量的模板,并在运行时注入具体值。例如,一个简单的提示模板可能是:“请将以下文本翻译为{language}:{text}”。通过传入不同的language和text参数,同一模板可以用于多语言翻译任务。这种设计不仅减少了代码冗余,还使得提示词的维护和迭代更加便捷。

除了基础模板,LangChain还支持更复杂的提示结构,如Few-shot Prompting(少样本提示)。通过在模板中嵌入示例,模型能够更快地理解任务模式。例如,在情感分析中,可以先提供几个标注好的正负面评论样本,再要求模型对新评论进行分类。这种方式特别适用于模型在零样本设置下表现不佳的任务。

构建高质量提示词时,常见的挑战包括提示过于冗长、缺乏重点或逻辑混乱。这些问题可能导致模型忽略关键指令或产生无关输出。优化技巧包括:精简语言,移除冗余信息;使用分隔符或标记突出重要部分;以及通过迭代测试调整提示结构。例如,在多次试验中对比不同版本的提示词,选择效果最佳的一个。

另一个进阶技巧是采用链式提示(Chaining Prompts),将复杂任务分解为多个子步骤,每个步骤使用专门的提示词。例如,在数据分析任务中,可以先用一个提示提取关键指标,再用另一个提示生成可视化建议。这种方式能够降低单次提示的复杂度,提高最终输出的质量。

尽管提示词设计具有较强的经验性,但一些通用策略能够帮助开发者快速上手。例如,优先使用指令式语言(如“请列出”、“总结以下”),避免开放式问题;在需要创造性输出的任务中,可以适当增加提示的开放性,但需通过约束条件防止偏离主题。此外,结合模型的特性和训练数据分布进行调整,也能进一步优化效果。

在实际应用中,提示词的有效性高度依赖于具体模型和任务。因此,持续测试和反馈循环至关重要。LangChain提供了与评估工具的集成,允许开发者量化提示词性能,并根据结果进行优化。例如,通过自动化测试框架对比不同提示词的准确率、响应时间等指标。

随着AI技术的发展,提示工程(Prompt Engineering)逐渐成为一门专业领域。2025年以来,AI工具自动优化提示的技术迅速发展,例如通过强化学习动态调整提示结构,或使用元提示(Meta-Prompts)让模型自我优化输入指令。这些工具能够分析历史交互数据,自动识别低效提示模式并生成改进版本,大幅降低了人工调优的成本。例如,某些平台现在提供实时提示分析功能,能够检测到模糊指令并建议更具体的替代方案。

一个常见的错误案例是,开发者设计了一个过于开放的提示,如“写一些关于人工智能的内容”,导致模型生成泛泛而谈、缺乏焦点的输出。修正步骤包括:首先,将提示具体化为“撰写一篇关于人工智能在2025年医疗领域应用的短文,重点介绍诊断辅助技术”;其次,通过A/B测试对比不同版本的提示效果;最后,结合模型反馈迭代优化,例如添加约束条件如“字数控制在300字以内,包含实际案例”。

尽管自动化工具提升了效率,核心原则仍未改变:理解模型能力、明确任务目标、并通过结构化设计实现高效交互。开发者应结合最新工具和传统方法,持续优化提示词设计,以充分发挥AI模型的潜力。

Chains 组件:构建复杂AI工作流

Chains 组件的核心概念

Chains 是 LangChain 框架中用于连接多个步骤的核心机制,其本质是将不同的组件(如 Models 和 Prompts)组织成有序的工作流,以实现复杂的 AI 任务自动化。通过 Chains,开发者可以灵活地定义输入输出的传递路径,将大语言模型(LLM)的单一调用扩展为多步推理或任务组合,从而提升应用的智能化水平和效率。

在实际应用中,Chains 能够处理需要多轮交互或依赖上下文的任务,例如问答系统、内容生成、数据转换等。其设计思想借鉴了函数式编程中的管道(pipeline)模式,每一步的输出可以作为下一步的输入,形成连贯的处理链条。这种结构不仅提高了代码的可读性和复用性,还使得调试和优化变得更加直观。

主要类型:顺序链、自定义链与增强型TransformChain

根据任务复杂度和灵活性需求,Chains 主要分为三种类型:顺序链(Sequential Chains)、自定义链(Custom Chains)以及2025年LangChain推出的增强型TransformChain。

顺序链是最基础的链类型,按照预定义的顺序依次执行各个组件。例如,一个典型的文本摘要任务可能包含以下步骤:首先通过 Prompts 组件生成摘要指令,然后调用 Models 组件执行摘要生成,最后对输出进行后处理(如过滤或格式化)。顺序链的优势在于结构简单、易于实现,适用于线性任务流。

以下是一个使用顺序链的代码示例,实现多轮对话场景:

from langchain.chains import LLMChain, SequentialChain

from langchain.llms import OpenAI

from langchain.prompts import PromptTemplate

# 初始化大语言模型

llm = OpenAI(model_name="gpt-4o", temperature=0.7)

# 定义第一个提示词模板:生成用户问题

prompt1 = PromptTemplate(

input_variables=["topic"],

template="生成一个关于{topic}的开放性问题。"

)

# 定义第二个提示词模板:生成问题答案

prompt2 = PromptTemplate(

input_variables=["question"],

template="回答以下问题:{question}"

)

# 创建两个链

chain1 = LLMChain(llm=llm, prompt=prompt1, output_key="question")

chain2 = LLMChain(llm=llm, prompt=prompt2, output_key="answer")

# 组合成顺序链

overall_chain = SequentialChain(

chains=[chain1, chain2],

input_variables=["topic"],

output_variables=["question", "answer"]

)

# 执行链

result = overall_chain.run("人工智能伦理")

print(result)

自定义链则提供了更高的灵活性,允许开发者通过继承基类或组合低层级操作来定义复杂逻辑。例如,在处理需要条件分支或循环的任务时(如多轮对话管理或动态推理),自定义链可以通过覆盖 _call 方法实现特定行为。以下是一个自定义链的示例,用于实现带条件判断的文本处理:

from langchain.chains.base import Chain

from typing import Dict, List

class ConditionalChain(Chain):

@property

def input_keys(self) -> List[str]:

return ["input_text"]

@property

def output_keys(self) -> List[str]:

return ["output_text"]

def _call(self, inputs: Dict[str, str]) -> Dict[str, str]:

text = inputs["input_text"]

if len(text) > 100:

# 调用模型进行摘要

summary_prompt = PromptTemplate(

template="将以下文本摘要至50字以内:{text}",

input_variables=["text"]

)

chain = LLMChain(llm=llm, prompt=summary_prompt)

result = chain.run(text=text)

else:

result = text

return {"output_text": result}

增强型TransformChain是2025年版本的重要更新,它在原有TransformChain基础上增加了动态参数调整和实时性能监控能力。新版TransformChain支持自动优化数据处理流程,并内置了性能指标收集功能,帮助开发者实时跟踪链的执行效率。

from langchain.chains import EnhancedTransformChain

from langchain.monitoring import PerformanceTracker

def data_enrichment_transform(inputs: Dict) -> Dict:

# 动态数据处理逻辑

enriched_data = enhance_data(inputs["raw_data"])

# 性能监控

PerformanceTracker.log_metric("processing_time", get_processing_time())

return {"enriched_data": enriched_data}

enhanced_chain = EnhancedTransformChain(

input_variables=["raw_data"],

output_variables=["enriched_data"],

transform=data_enrichment_transform,

enable_monitoring=True # 启用性能监控

)

实现方式与步骤指南

构建一个完整的 Chain 通常包含以下步骤:

- 定义组件:首先明确任务所需的 Models 和 Prompts。例如,选择适合的 LLM(如 GPT-4o 或 Claude 3),设计提示词模板以标准化输入输出。

- 创建子链:使用

LLMChain将模型和提示词封装为可执行单元。每个子链负责一个原子任务,如文本生成、分类或转换。 - 组合链:通过

SequentialChain或自定义类将子链连接起来。需要特别注意输入输出变量的匹配,确保数据流正确传递。 - 测试与迭代:运行示例输入,检查中间结果和最终输出,根据性能调整提示词或链结构。建议使用LangChain 2025版本新增的调试工具进行实时性能分析。

以下是一个完整示例,演示如何构建一个自动化内容生成工作流,该工作流首先生成文章大纲,再基于大纲撰写正文:

from langchain.chains import SimpleSequentialChain

# 生成大纲的提示词和链

outline_prompt = PromptTemplate(

input_variables=["topic"],

template="为关于{topic}的文章生成一个大纲,包含3个主要部分。"

)

outline_chain = LLMChain(llm=llm, prompt=outline_prompt)

# 生成正文的提示词和链

content_prompt = PromptTemplate(

input_variables=["outline"],

template="根据以下大纲撰写文章正文:{outline}"

)

content_chain = LLMChain(llm=llm, prompt=content_prompt)

# 组合为简单顺序链

full_chain = SimpleSequentialChain(chains=[outline_chain, content_chain])

# 执行

result = full_chain.run("可持续能源的发展")

print(result)

最佳实践与注意事项

在实际开发中,高效使用 Chains 需要注意以下几点:

- 模块化设计:将复杂任务拆解为多个子链,每个子链专注于单一功能,便于调试和复用。

- 错误处理:在自定义链中集成异常捕获机制,例如处理模型调用失败或输出格式错误。

- 性能监控与优化:利用2025版本新增的性能监控功能,实时跟踪链执行指标。避免不必要的链调用,可以通过缓存中间结果或使用异步执行提升效率。建议设置执行时间阈值,对超时任务自动终止或降级处理。

- 提示词工程:确保提示词清晰明确,减少模型歧义。例如,在多步任务中,使用上下文变量(如

{previous_output})传递信息。

此外,对于需要动态分支或循环的任务,可以结合 LangChain 的增强型 TransformChain 或其他工具链(如 APIChain)实现更高级的集成。例如,以下代码展示了如何在外链中调用外部 API 获取数据后再进行模型处理:

from langchain.chains import EnhancedTransformChain

def api_call_transform(inputs: Dict) -> Dict:

# 模拟API调用(实际应用中替换为真实API)

data = fetch_data_from_api(inputs["query"])

return {"api_data": data}

api_chain = EnhancedTransformChain(

input_variables=["query"],

output_variables=["api_data"],

transform=api_call_transform,

enable_monitoring=True

)

# 将API链与LLM链组合

overall_chain = SequentialChain(

chains=[api_chain, content_chain],

input_variables=["query"],

output_variables=["api_data", "output_text"]

)

通过上述方法和示例,开发者可以充分利用 Chains 组件构建强大而灵活的 AI 工作流,从而满足多样化应用场景的需求。

组件交互与实战演练

在LangChain框架中,Models、Prompts和Chains三大组件并非孤立存在,而是通过高度协同的方式构建出强大的AI应用。它们之间的交互构成了LangChain的核心工作流:Models提供基础AI能力,Prompts优化输入引导模型输出,Chains则负责将多个步骤串联成完整任务流程。下面我们通过一个聊天机器人项目的实战演练,具体展示这三者如何协同工作,并分享关键的调试与优化技巧。

组件协同工作原理解析

Models作为底层能力提供者,接收经过Prompts结构化处理的输入文本,生成高质量的响应。Prompts在这里扮演"引导者"角色,通过模板化设计将用户查询转化为模型更易理解的格式。Chains则作为"组织者",将多个模型调用和提示词处理步骤串联起来,形成端到端的解决方案。

以OpenAI的GPT-4模型为例,当用户输入"帮我总结这篇文章的主要内容"时,Prompts组件会将这个简单指令转化为结构化的提示模板:“请用不超过200字总结以下文章的核心内容:[文章文本]”。Models组件接收这个优化后的提示,生成摘要结果。如果任务更复杂,比如需要先检索相关文档再生成摘要,Chains就会协调多个步骤的顺序执行。

实战演练:构建智能客服聊天机器人

我们通过一个完整的客服聊天机器人案例,演示三大组件的整合应用。这个机器人需要处理产品咨询、订单查询和投诉建议三类任务。

首先定义核心模型组件:

from langchain.llms import OpenAI

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

# 初始化模型

llm = OpenAI(model_name="gpt-4", temperature=0.7)

接下来设计针对不同任务的提示模板。Prompts组件的关键是提供足够的上下文和明确的指令:

# 产品咨询提示模板

product_prompt = PromptTemplate(

input_variables=["user_query", "product_info"],

template="你是一名客服专员。根据以下产品信息:{product_info},回答用户问题:{user_query}。回答要专业且友好,不超过150字。"

)

# 订单查询提示模板

order_prompt = PromptTemplate(

input_variables=["user_query", "order_data"],

template="用户查询订单状态:{user_query}。现有订单数据:{order_data}。请准确回复订单状态,包含预计送达时间。"

)

然后用Chains组件组合这些元素,创建处理不同场景的链:

# 创建业务处理链

product_chain = LLMChain(llm=llm, prompt=product_prompt)

order_chain = LLMChain(llm=llm, prompt=order_prompt)

# 构建路由逻辑,根据用户输入选择不同的链

def route_query(user_input, context_data):

if "产品" in user_input or "功能" in user_input:

return product_chain.run(user_query=user_input, product_info=context_data["product_info"])

elif "订单" in user_input or "配送" in user_input:

return order_chain.run(user_query=user_input, order_data=context_data["order_data"])

else:

return "抱歉,我暂时无法处理这个请求,请联系人工客服。"

调试与优化技巧

在组件交互过程中,常见的调试挑战包括提示词效果不佳、模型响应不一致或链式调用错误。以下是一些实用技巧:

提示词优化方面:使用LangChain的PromptTemplate的partial功能进行A/B测试。例如,可以准备两个版本的提示词,通过少量测试查询比较哪个版本获得更准确的响应。记录每次提示词修改后的性能指标,如响应相关性和用户满意度。

模型调用优化:通过设置合适的temperature参数(0.7-0.9适合创意任务,0.2-0.5适合确定性任务)和控制max_tokens来平衡响应质量与速度。对于成本敏感的场景,可以配置模型的缓存策略,避免重复处理相同或相似的查询。

链式调用监控:使用LangChain的callbacks功能记录每个链节点的输入输出,当复杂链出现问题时,可以快速定位到具体出错的环节。例如:

from langchain.callbacks import FileCallbackHandler

handler = FileCallbackHandler('chain_log.json')

product_chain.run(..., callbacks=[handler])

性能优化实践:对于高频查询,可以实现响应缓存机制,将常见问题及答案缓存起来,减少模型调用次数。同时,对于可以并行处理的独立步骤,使用LangChain的Parallelize功能加速处理。

在真实部署中,还需要考虑错误处理和降级方案。例如当主要模型API不可用时,可以自动切换到备用模型;当链中某个组件失败时,提供友好的错误回复而不是直接抛出异常。

通过持续监控系统表现,收集用户反馈,并迭代优化提示词设计和链结构,可以不断提升聊天机器人的性能。这种基于LangChain组件协同的开发模式,不仅适用于客服机器人,同样可以扩展到知识管理、数据分析等多种应用场景,为构建复杂AI系统提供了可靠框架。

常见挑战与解决方案

在使用LangChain构建AI应用的过程中,开发者可能会遇到各种挑战,尤其是在处理Models、Prompts和Chains三大核心组件时。这些问题不仅影响开发效率,还可能直接导致应用性能下降或功能失效。以下是一些常见挑战及其基于经验的解决方案和预防措施。

模型延迟与响应不稳定

模型延迟是使用LangChain时最常遇到的问题之一,尤其是在集成外部大语言模型(LLMs)或嵌入模型时。高延迟会直接影响用户体验,尤其是在实时交互场景如聊天机器人或数据分析工具中。

解决方案:

- 模型选择优化:优先选择低延迟且稳定的模型提供商,例如通过LangChain集成的OpenAI或Hugging Face模型时,可以对比不同模型的响应时间。对于非实时任务,可以考虑使用异步处理或批处理来减少延迟影响。

- 缓存机制:对频繁使用的查询或提示词结果进行缓存,避免重复调用模型。LangChain支持通过Memory组件实现会话状态的缓存,从而减少不必要的模型请求。

- 超时与重试策略:在代码中设置合理的超时时间和自动重试机制,以应对临时性的网络波动或模型服务不稳定。

预防措施:

在项目设计阶段就评估模型的延迟表现,通过压力测试模拟高并发场景。同时,保持对模型服务商API更新和状态页面的关注,及时调整配置。

提示词(Prompts)无效或输出质量低下

无效的提示词是导致AI响应不符合预期的常见原因。这可能由于提示词设计不清晰、缺乏上下文或模板化错误导致。

解决方案:

- 结构化提示词设计:使用LangChain的PromptTemplate功能,确保提示词具有明确的指令和上下文。例如,通过few-shot learning方式提供示例,引导模型生成更准确的输出。

- 动态提示词优化:根据用户输入或会话状态动态调整提示词内容。例如,在多轮对话中,通过Chain组件的memory功能保留历史上下文,避免提示词断裂或信息丢失。

- A/B测试与迭代:对不同的提示词版本进行测试,利用LangChain的日志和评估工具分析输出质量,逐步优化提示词设计。

预防措施:

在开发过程中建立提示词版本管理机制,定期审查和更新提示词模板。同时,结合人工评估或自动化测试工具(如LangChain提供的评估链)验证提示词的有效性。

Chains构建错误与工作流中断

Chains组件负责组合多个步骤(如调用模型、处理提示词),但在复杂工作流中,链可能会由于组件配置错误、依赖缺失或异常处理不足而中断。

解决方案:

- 逐步调试与日志记录:利用LangChain的verbose模式输出详细执行日志,逐步检查链中每个组件的输入和输出。对于自定义链,确保异常处理机制健全,避免单点失败导致整个工作流崩溃。

- 依赖管理:明确链中各个组件的依赖关系,例如确保Prompts的输出格式与Models的输入要求匹配。使用LangChain的SequentialChain或TransformChain时,验证数据流的一致性。

- 回退机制:为关键链步骤设置备选方案,例如当主模型调用失败时自动切换到备用模型或本地处理逻辑。

预防措施:

在链设计阶段采用模块化思维,将复杂工作流拆分为可测试的子链。通过单元测试和集成测试覆盖常见用例和边缘情况,确保链的鲁棒性。

组件协同与数据流问题

Models、Prompts和Chains之间的协同工作可能出现数据格式不匹配、上下文丢失或资源竞争等问题,尤其在多模型或多链场景中。

解决方案:

- 数据标准化:在使用多个模型或链时,统一数据交换格式(如JSON或特定数据结构),利用LangChain的解析工具(如OutputParser)处理模型输出,确保下游组件能够正确解析。

- 上下文管理:通过LangChain的Memory组件(如ConversationBufferMemory)维护跨链的会话状态,避免上下文断裂。对于长期依赖,考虑外部存储(如数据库)持久化关键数据。

- 资源优化:监控链执行过程中的资源使用情况(如API调用次数、内存占用),通过批处理或异步调用减少冗余操作。例如,在嵌入模型处理大量文本时,使用向量数据库缓存结果。

预防措施:

在项目初期定义清晰的数据流和组件接口规范,使用LangChain的调试工具(如callback handlers)实时跟踪执行过程。定期进行性能分析和优化,避免资源瓶颈。

安全与合规风险

在集成外部模型或处理用户数据时,可能面临数据泄露、提示词注入或合规性问题。

解决方案:

- 输入过滤与验证:对用户输入进行严格过滤,防止恶意提示词注入攻击。使用LangChain的输入清洗功能或自定义安全层拦截异常输入。

- 数据脱敏:在调用外部模型API前,对敏感信息(如个人身份信息)进行脱敏处理,或选择符合数据合规要求的模型服务商(如支持本地部署的模型)。

- 合规检查:确保应用符合相关法规(如GDPR或行业特定标准),在使用LangChain组件时查阅官方文档中的安全最佳实践,并定期更新依赖库以修复已知漏洞。

预防措施:

将安全评估纳入开发流程的每个阶段,通过代码审查和渗透测试识别潜在风险。同时,保持与LangChain社区的安全更新同步,及时应用补丁和改进方案。

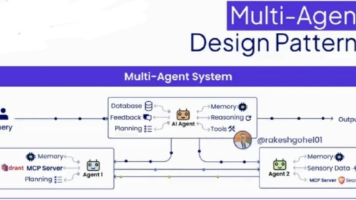

未来展望与学习资源

随着LangChain在AI应用开发领域的持续演进,其核心组件Models、Prompts和Chains的协同作用正推动更智能、高效的代理系统发展。展望未来,我们可以预见几个关键趋势:首先,模型集成将更加灵活,支持多模态输入输出和实时动态推理,使AI代理能够适应复杂任务场景,如自动驾驶中的实时决策或多模态内容生成。其次,提示工程(Prompt Engineering)将进一步系统化和自动化,结合可解释AI技术提升生成内容的可控性、透明度及伦理合规性。最后,链式工作流(Chains)将向自优化和自适应方向发展,借助强化学习、元学习技术动态调整组件间协作逻辑,显著减少人工配置需求。

这些进步不仅会深化LangChain在聊天机器人、数据分析及自动化流程等领域的应用,还将加速其在教育个性化辅导、医疗诊断辅助、金融智能投顾等垂直行业的落地,推动AI代理成为下一代人机协同的核心基础设施。然而,技术演进也面临模型偏差治理、提示注入安全、能源效率和多模态一致性等挑战,需要开发者社区与科研机构持续协作攻关。

为帮助读者深入学习和实践,以下精选资源值得重点关注:

- 官方文档与教程:LangChain官方文档(https://langchain.readthedocs.io/)提供全面指南,2025年新增的实时协作教程(https://langchain.readthedocs.io/en/latest/real_time_collab.html)和多模态代理案例库,适合不同阶段用户系统学习。

- 社区与论坛:GitHub仓库(https://github.com/langchain-ai/langchain)保持高频更新,2025年新推出的LangChain Discord专项频道和全球开发者峰会(LangChain Summit 2025)是获取前沿洞察和实战经验的优质平台。

- 在线课程与书籍:Coursera专项课程《Advanced LangChain: Multi-Agent Systems》(2025)新增实时项目实战,最新开源书《LangChain for Production》系统讲解部署优化与规模化实践。

- 实验项目与工具:Hugging Face Spaces和Google Colab提供2025新集成的链式工作流模板库,开源项目如AutoGPT及LangServe支持快速原型开发和云端集成。

持续学习是应对AI领域高速发展的关键,建议通过实战项目——如构建跨文档检索问答链或实时多模态情感分析代理——强化应用能力。积极参与社区贡献、开源项目合作及全球黑客松(如2025 LangChain Hackathon),将有效提升技术视野。未来,LangChain生态将进一步与AutoML、联邦学习等工具融合,为开发者开启更广阔的智能代理创新空间。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)