大数据应用之Spark环境安装与配置完全解析

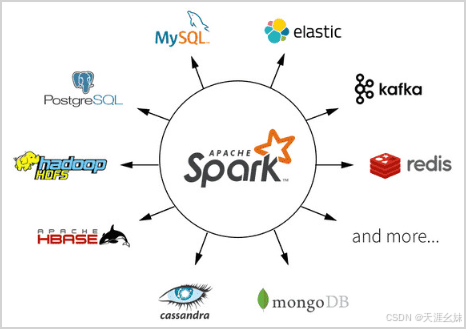

Spark由Apache公司开源,与Hadoop配合使用获得更高性能与易用性,是专为大规模数据处理而设计的快速通用的计算引擎 ,现在形成一个高速发展的广泛生态系统。Spark具有速度快、易用性、通用性及生态丰富的特点,可用它来完成各种各样的运算,包括 SQL 查询、文本处理、机器学习等。

Spark由Apache公司开源,与Hadoop配合使用获得更高性能与易用性,是专为大规模数据处理而设计的快速通用的计算引擎 ,现在形成一个高速发展的广泛生态系统。

Spark具有速度快、易用性、通用性及生态丰富的特点,可用它来完成各种各样的运算,包括 SQL 查询、文本处理、机器学习等。

一、Spark安装准备

提示:安装Spark之前需要安装JDK、Hadoop、Scala。

本次安装版本: JDK1.8,Hadoop3.4.0, Scala2.13.14,Spark3.5.1

1.1 JDK与Hadoop3.4.0安装

1. JDK官网下载

官网下载地址(需要oracle账号) Java Downloads | Oracle

参考本站:Java前后端开发环境安装与配置完整版_java安装-CSDN博客

2. Hadoop安装与配置

参考本站:大数据应用之Hadoop环境安装与配置完全解析-CSDN博客

1.2 Scala安装

1. Scala官网下载2.13.14

Scala 2.13.14 | The Scala Programming Language (scala-lang.org)

2. Scala安装

点击msi文件安装,按提示安装到D:\programd\scala2.13下

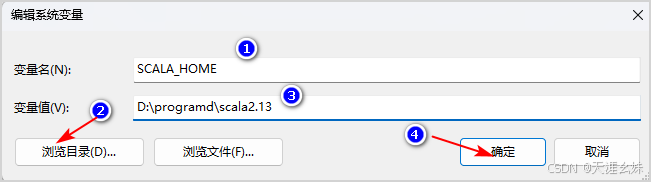

3. 系统环境变量设置,此电脑图标右击->高级系统设置->环境变量->系统变量

(1)设置系统环境变量: %SCALA_HOME%

(2)系统环境变量Path添加%SCALA_HOME%\bin

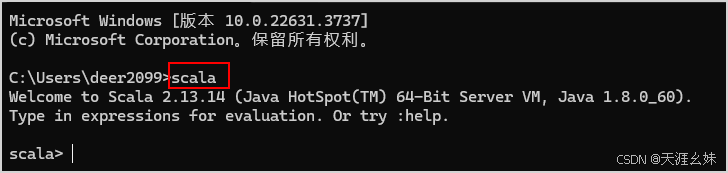

(3)验证Scala是否安装成功

为了验证Scala是否安装成功,开启一个新的cmd窗口,输入Scala

二、Spark安装与配置

先创建好文件夹: D:\programd\bigdata\spark-3.5.1-hd3

1. Spark官网下载sprk-3.5.1-bin-hadoop3.tgz

官网地址: Index of /dist/spark/spark-3.5.1 (apache.org)https://archive.apache.org/dist/spark/spark-3.5.1/spark-3.5.1-bin-hadoop3.tgz

2. Spark安装

解压sprk-3.5.1-bin-hadoop3.tgz,并解压后的文件夹中所有文件复制到D:\programd\bigdata\spark-3.5.1-hd3下。

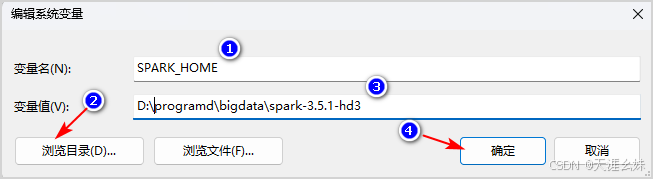

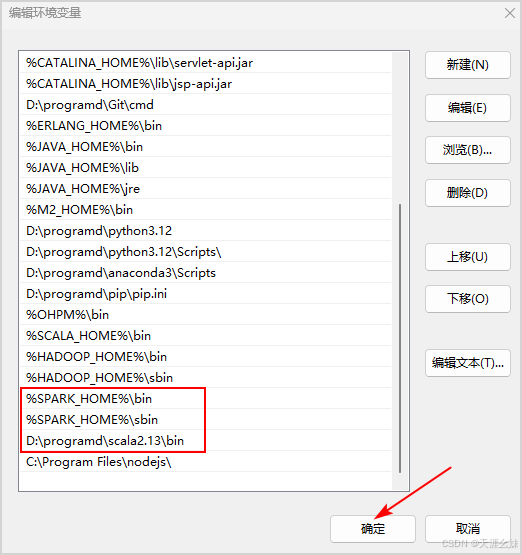

3. 设置spark的环境变量

(1)创建spark系统变量SPARK_HOME

(2)设置环境变量Path,配置以下三行内容,如图所示

%SPARK_HOME%\bin

%SPARK_HOME%\sbin

D:\programd\scala2.13

4. 修改Spark 在windows下的配置文件

配置文件名为:spark-defaults.conf(也可以不设置,直接使用默认配置)

在D:\programd\bigdata\spark-3.5.1-hd3\conf 下。如果文件不存在, 则复制一份spark-defaults.conf.template文件,并改名为spark-defaults.conf文件。

记事本打开spark-defaults.conf文件,在其中添加如下内容:

# 配置Master节点的主机名,单机用localhost即可

spark.master.ip=localhost

# WorkNode分出几核给spark,这里一个就可以

spark.worker.cores=1

# WorkNode使用的Spark实例,一般一个就行

spark.worker.instances=1

# WorkNode分出多少内存给spark使用

spark.worker.memory=1G

# 指定spark运行时的端口号

spark.worker.port=88885. 验证Spark是否安装成功

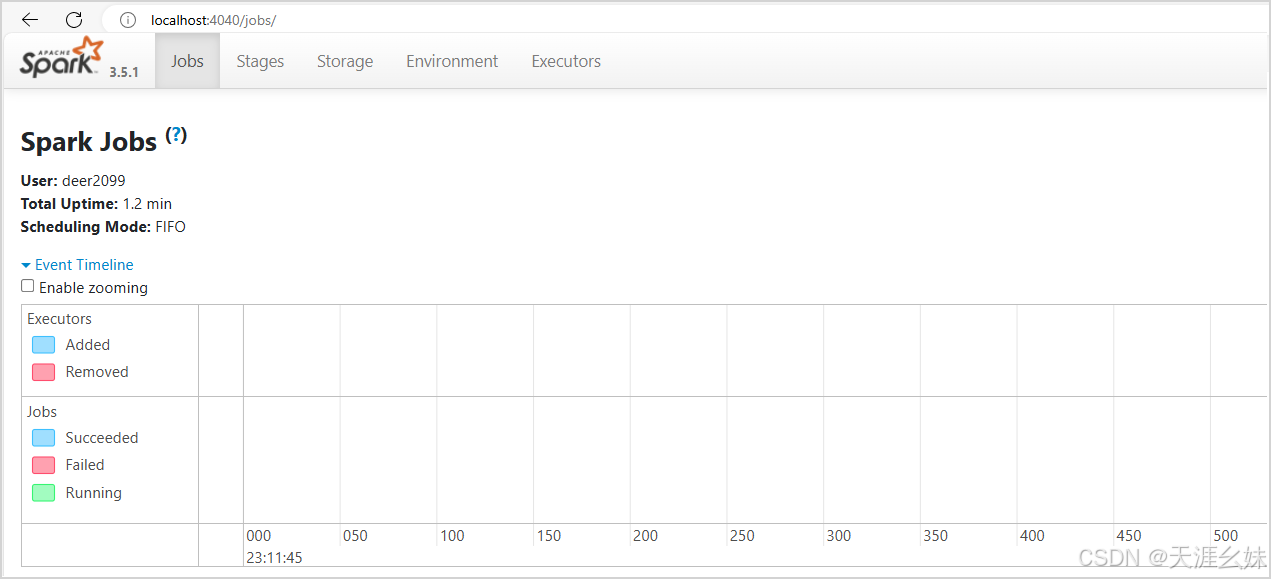

为了验证Spark是否安装成功,开启一个新的cmd窗口, 输入:spark-shell,管理端口号4040

6. 启动Spark-UI

7. Spark更多配置参考

// 在启动Spark shell时设置端口

$ ./bin/ spark-shell --conf spark.ui.port=5080

// 或者在代码中设置

val conf = new SparkConf()

conf.set("spark.ui.port", "4040")

val sc = new SparkContext(conf)

// Linux中UI打开方式

需要在Linux中安装Spark集群:http://localhost:5080/

更多精彩内容请关注本站其他内容!!!

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)