【大数据】mac M1 安装配置 spark, hadoop, scala, java, maven 教程

在 Users/XXX路径下创建 env 文件, 将解压后的文件移动到 env 路径下。注意,此处的python3,可以换成你自己环境的 python命令,具体操作如下。然后按 esc 键退出编辑模式,输入:wq保存退出。执行命令检查 spark 是否正常。类似上面,解压后移动到env 下面。检查 hadoop 命令是否可用。按 insert 进入编辑模式。检查 scala 是否可用。在刚才下载的

·

Spark

下载

解压

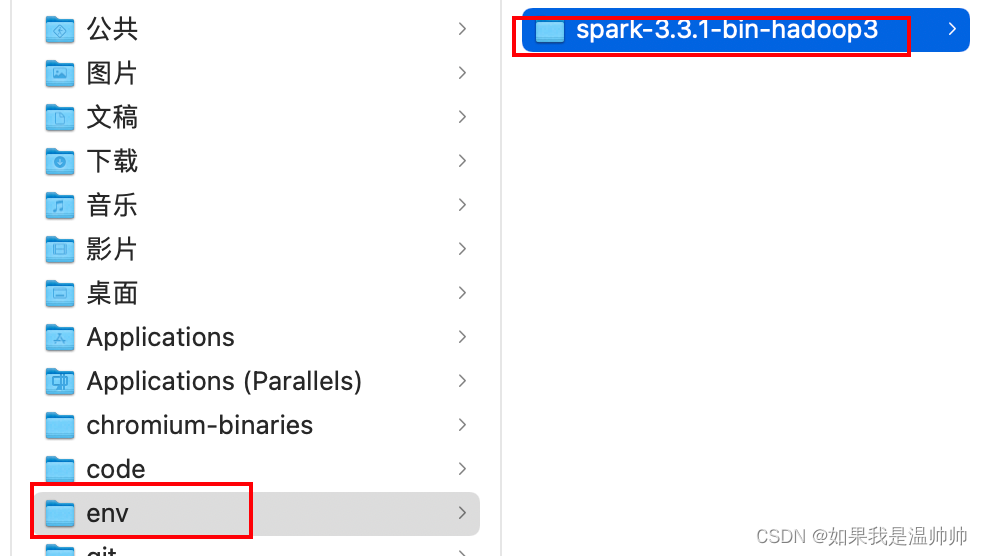

在 Users/XXX路径下创建 env 文件, 将解压后的文件移动到 env 路径下

配置环境变量

打开终端

sudo vi ~/.bash_profile

按 insert 进入编辑模式

将下面内容复制粘贴进去

#spark

export SPARK_HOME=/Users/wenxiaoyu/env/spark-3.3.1-bin-hadoop3

export PATH=$PATH:$SPARK_HOME/bin

export PYSPARK_PYTHON=python3

注意,此处的python3,可以换成你自己环境的 python命令,具体操作如下

然后按 esc 键退出编辑模式,输入 :wq 保存退出

source ~/.bash_profile

刷新环境变量

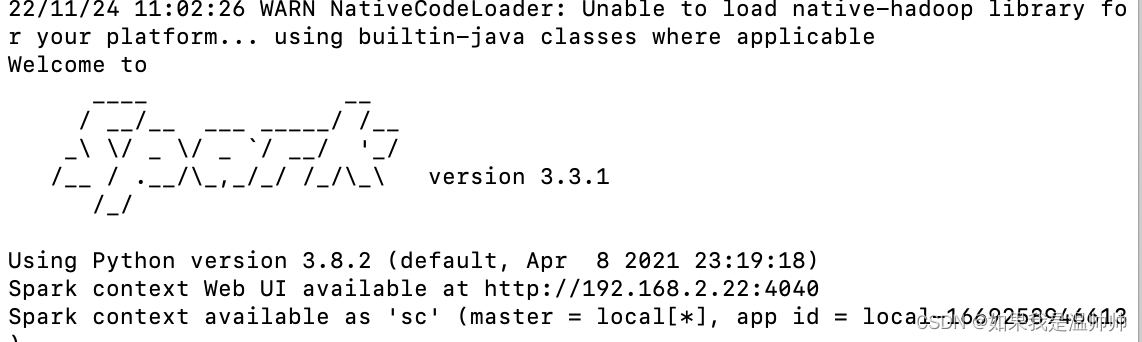

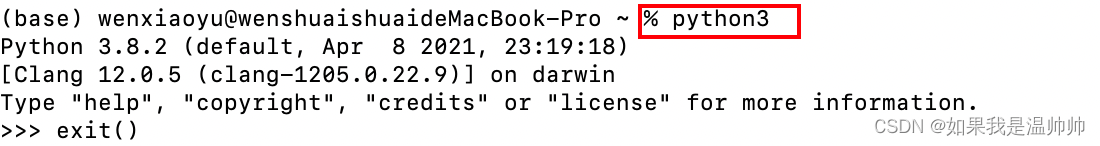

pyspark

执行命令检查 spark 是否正常

hadoop

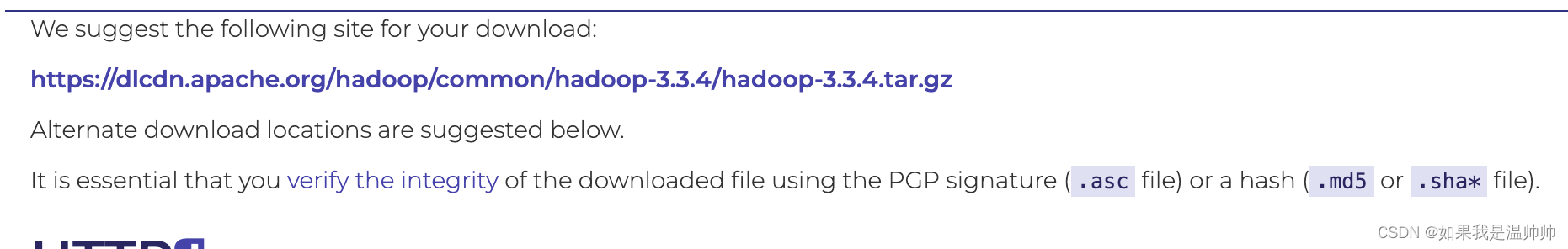

下载

解压

类似上面,解压后移动到env 下面

配置环境变量

sudo vi ~/.bash_profile

同上,进入编辑模式

#hadoop

export HADOOP_HOME=/Users/wenxiaoyu/env/hadoop-3.3.4

export HADOOP_INSTALL=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

然后刷新

source ~/.bash_profile

hadoop

检查 hadoop 命令是否可用

scala

下载cs

brew install coursier/formulas/coursier && cs setup

配置环境变量

在刚才下载的时候输入 y

刷新

source ~/.bash_profile

下载 scala

cs install scala:3.2.1 && cs install scalac:3.2.1

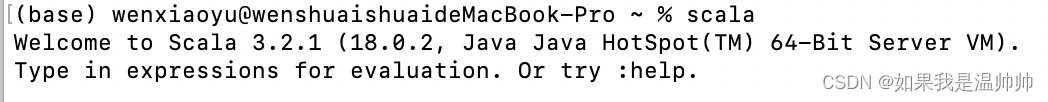

检查 scala 是否可用

scala

java

环境变量配置

# JDK

JAVA_HOME=/Library/Java/JavaVirtualMachines/jdk-18.0.2.jdk/Contents/Home

PATH=$JAVA_HOME/bin:$PATH:.

CLASSPATH=$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar:.

export JAVA_HOME

export CLASSPATH

export PATH

maven

环境变量配置

# mvn java development

M2_HOME=/usr/local/Cellar/maven/3.8.6

PATH=$M2_HOME/bin:$PATH:.

export M2_HOME

export PATH

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)