PNP机器人论文解读:华盛顿大学&ALLEN人工智能研究院—RoboEval 机器人操作与结构化和可扩展评估的结合

例如,同一类机器人抓取任务,在不同实验室可能采用不同的数据集、不同的评估指标,导致研究成果之间缺乏可比性,也难以实现大规模推广与复用。作者提出了一套结构化(Structured)且可扩展(Scalable)的评估框架,旨在通过统一的任务分解方式、标准化的指标体系和大规模自动化测试环境,为机器人操作的算法研究提供更加客观、公正、可重复的基准。这一研究为未来的算法开发、实验对比和学科发展提供了统一的参

PNP机器人论文解读:华盛顿大学&ALLEN人工智能研究院—RoboEval 机器人操作与结构化和可扩展评估的结合

1

部分:研究背景与问题提出

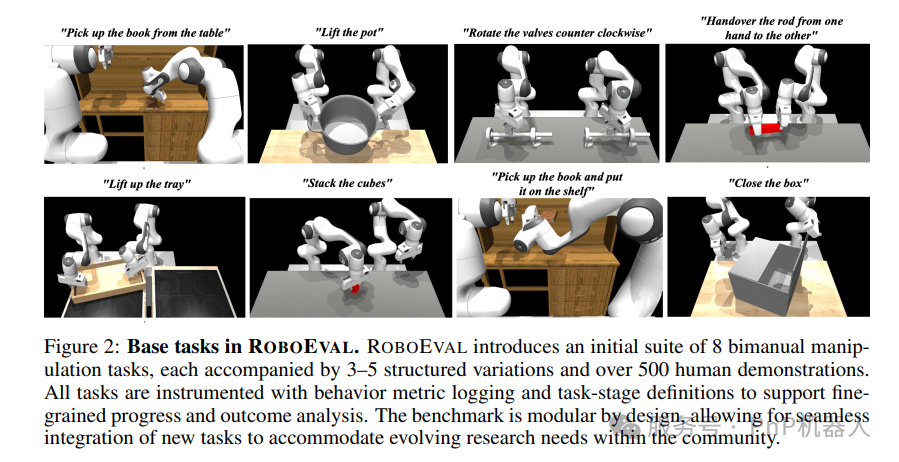

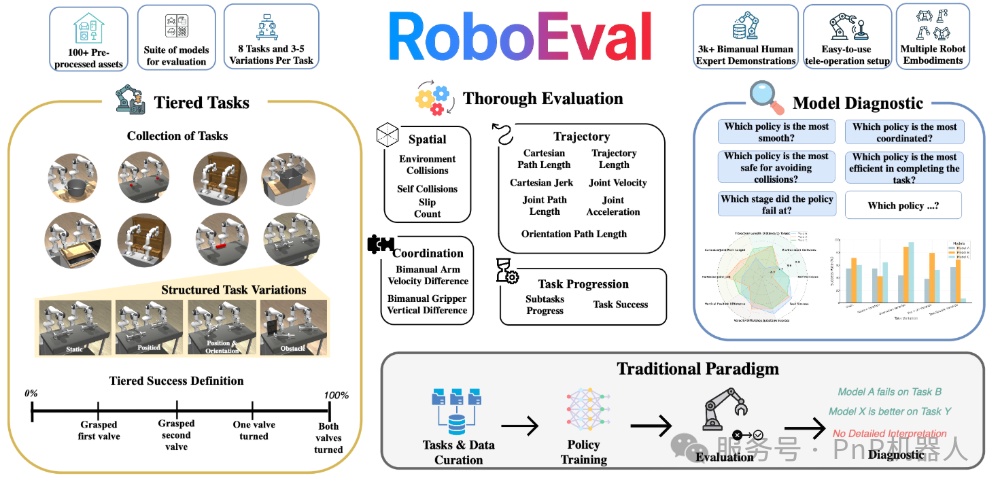

近年来,随着机器人操作(Robotic Manipulation)研究的快速发展,如何建立科学、系统且可扩展的评价体系逐渐成为学术界和产业界的核心关注点。传统的机器人操作研究主要集中在算法优化、感知精度提升以及控制策略改进上,但往往忽视了评价标准的不统一与不可扩展性。例如,同一类机器人抓取任务,在不同实验室可能采用不同的数据集、不同的评估指标,导致研究成果之间缺乏可比性,也难以实现大规模推广与复用。

论文《Where Robotic Manipulation Meets Structured and Scalable Evaluation》正是针对这一核心痛点展开的研究。作者提出了一套结构化(Structured)且可扩展(Scalable)的评估框架,旨在通过统一的任务分解方式、标准化的指标体系和大规模自动化测试环境,为机器人操作的算法研究提供更加客观、公正、可重复的基准。

在研究背景中,作者特别强调了三个挑战:

-

任务复杂性:机器人操作任务从单一物体抓取到复杂场景中的多物体协作,其复杂度呈指数级增长。如何定义合理的任务层次结构是评估的关键。

-

指标碎片化:当前研究多采用成功率、抓取稳定性或路径长度作为单一指标,缺乏系统的多维度评价。

-

可扩展性不足:实验数据多依赖人工采集与标注,难以适配大规模任务库,限制了算法在复杂现实环境中的推广。

为应对上述挑战,论文提出了一种结构化任务划分 + 自动化评估框架的思路。通过在虚拟仿真与现实世界中建立一致的任务库,利用分层指标体系和可扩展的测试流程,作者试图在机器人操作研究中引入类似于自然语言处理(NLP)和计算机视觉(CV)领域的“标准化基准测试”的机制。

这种研究方向不仅是对机器人学基础问题的回应,也是推动机器人学迈向大规模、标准化发展的一次尝试。换句话说,正如ImageNet推动了视觉领域的深度学习革命,作者希望通过这一工作为机器人操作建立类似的“评价基石”,以便不同算法和模型可以在统一框架下进行公平比较和快速迭代。

2

部分:研究方法与框架设计

作者提出的结构化与可扩展评价框架,核心在于任务结构指标标准化两大方面。

1. 任务结构化(Structured Tasks)

论文认为,任务本身应当被分解为不同的层级:

-

原子操作层(Atomic Actions):如抓取、移动、旋转、释放等基本操作。

-

组合任务层(Composite Tasks):由多个原子操作组合形成的复杂任务,例如“从桌上拿起一个杯子并放入柜子中”。

-

高层语义层(Semantic Goals):对应更接近人类描述的目标,如“整理桌面”或“准备一份早餐”。

通过分层设计,任务可以在不同粒度上被评价,从而既能反映低层次控制性能,也能体现高层次规划与语义理解能力。这种结构化方法类似于自然语言处理中的句法分解,保证了评估的灵活性与普适性。

2. 指标标准化(Standardized Metrics)

论文提出了一套多维度指标体系,涵盖:

-

成功率(Success Rate):任务是否完成。

-

效率(Efficiency):完成任务所需时间、路径长度、能耗等。

-

稳健性(Robustness):在不同扰动、噪声条件下是否仍能完成任务。

-

泛化性(Generalization):面对新物体、新场景时的迁移表现。

-

可解释性(Interpretability):模型在执行任务时的决策是否可追踪和分析。

这些指标通过标准化定义,使得不同实验结果能够直接对比,避免因实验设置差异导致的结果不可复现。

3. 自动化测试与可扩展性(Automation & Scalability)

为实现规模化,作者利用虚拟仿真环境(如MuJoCo、Isaac Gym)结合现实测试平台,构建了混合评估管线。其特点包括:

-

批量任务生成:通过程序化方式快速生成数千种操作场景。

-

自动化监控与记录:利用传感器与视觉系统自动采集执行结果。

-

结果对齐与存储:统一的数据存储格式保证跨任务的可比性。

这一框架保证了评估过程不再依赖过多人工干预,从而支持研究成果的快速复用和跨平台推广。

综上所述,该框架方法论的提出,使得机器人操作研究能够逐步迈向类似NLP领域GLUE、CV领域COCO那样的标准化基准,这对推动学科整体发展具有里程碑意义。

3

部分:实验设置与任务库构建

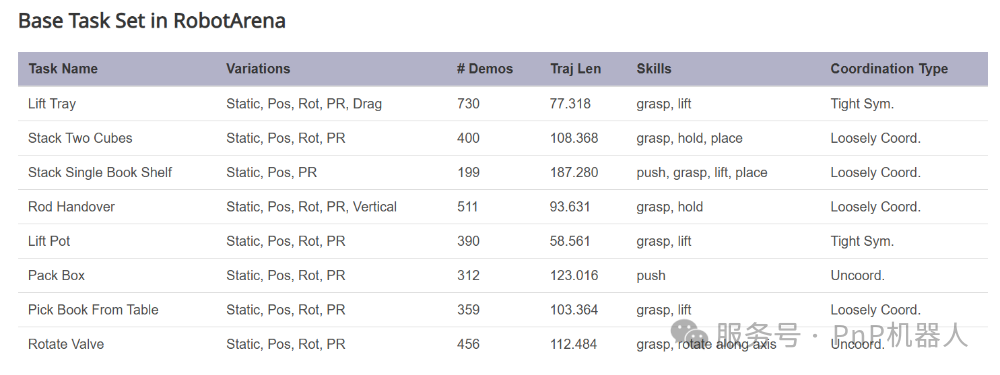

论文的实验部分主要集中在如何构建一个具备代表性和可扩展性的任务库,以及如何在其中进行系统化的评估。

1. 任务库设计原则

-

多样性(Diversity):涵盖单物体抓取、多物体操作、工具使用、柔性物体操控等任务类别。

-

渐进性(Progressivity):从简单到复杂逐步递进,方便研究算法在不同难度下的表现比较。

-

现实性(Realism):确保虚拟环境任务能够无缝迁移到现实机器人平台。

2. 仿真环境与现实平台结合

论文采用了仿真与真实环境的双重验证方式:

-

仿真环境:使用MuJoCo等物理引擎快速生成大量场景,并用于大规模算法评测。

-

现实平台:选用Franka高精度机械臂,在物理世界中复现关键任务,以验证评估结果的可信度。

PNP机器人,赞2

3. 评价流程设计

一个典型的实验流程包括:

-

任务定义:根据任务库描述生成操作场景。

-

算法执行:机器人模型按照策略执行操作。

-

数据采集:传感器自动记录执行轨迹、成功率、能耗等数据。

-

指标计算:基于标准化指标体系进行统计分析。

-

跨模型对比:不同算法在同一任务上的表现可以直接比较。

通过上述流程,论文实现了从单一任务验证到大规模实验对比的转变。这不仅提升了研究的科学性,也为未来机器人学的“benchmarking文化”奠定了基础。

4

部分:实验结果与对比分析

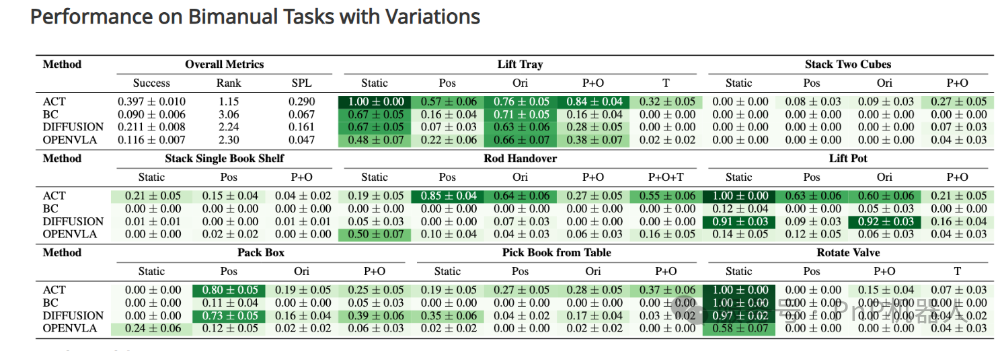

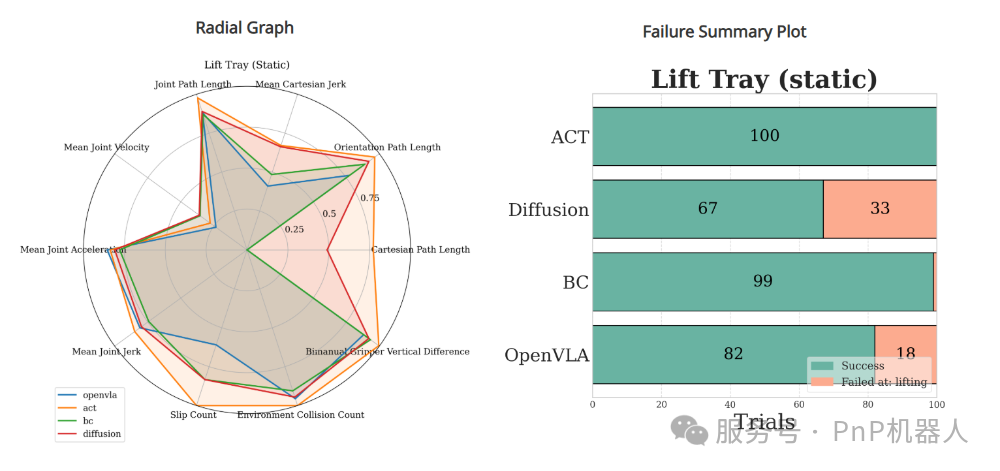

论文对多种主流机器人操作算法(包括强化学习、模仿学习、基于模型的方法和混合方法)在任务库中进行了系统对比。

1. 成功率表现

-

强化学习算法在单一物体抓取任务中表现优异,但在多物体协作任务中成功率显著下降。

-

模仿学习算法在常见任务中保持较高稳定性,但泛化能力有限。

-

基于模型的方法在复杂任务规划中具有优势,但训练成本高。

2. 效率与稳健性

-

强化学习模型在效率上往往欠缺,需要较多尝试才能完成任务。

-

模仿学习在效率上较好,但在有噪声的环境下表现不稳定。

-

混合方法在稳健性和效率之间取得了较好平衡。

3. 泛化性与扩展性

论文特别强调了泛化性实验:当机器人面对从未见过的物体或场景时,大多数方法性能急剧下降,说明当前研究仍存在明显瓶颈。

4. 综合比较

通过标准化指标的对比,论文得出了一个核心结论:单一算法难以在所有维度上取得优势,未来研究需要在跨任务泛化和鲁棒性方面重点突破。

5

部分:研究优势、不足与改进空间

优势

-

首次系统提出结构化评估框架,弥补了机器人操作领域长期缺乏统一评价基准的空白。

-

实验规模大,涵盖了多种任务类别与不同算法,验证结果具有较强代表性。

-

方法具备可扩展性,未来可在更多场景与平台中推广。

不足

-

任务库覆盖面仍有限:柔性物体操控、复杂人机协作任务等尚未充分涉及。

-

现实验证不足:尽管有部分现实测试,但仍以仿真为主,存在“仿真-现实差距”。

-

指标体系主观性:部分指标(如可解释性)缺乏严格的量化标准。

改进方向

-

扩展任务库,涵盖更多复杂任务类型。

-

加强现实机器人实验比例,缩小仿真-现实差距。

-

引入人类反馈与交互式指标,提升评价的多维度与可信度。

6

部分:未来展望与结论

未来,机器人操作的研究趋势将围绕以下几个方面展开:

-

大规模数据驱动:借鉴CV和NLP的经验,机器人学也将依赖大规模数据集与基准测试推动发展。

-

跨模态与大模型结合:视觉-语言模型(VLM)、世界模型(World Models)的发展将推动机器人具备更强的语义理解与推理能力。

-

人机协作与自适应能力:未来的机器人不仅要完成预定义任务,还需与人类灵活协作,应对复杂开放环境。

-

标准化与社区协作:类似ImageNet和GLUE的社区推动将在机器人学出现,加速整个领域的迭代。

论文最终结论是:结构化与可扩展评估框架是机器人操作走向成熟的关键步骤。 这一研究为未来的算法开发、实验对比和学科发展提供了统一的参照系,也为机器人真正走向大规模应用打下了坚实的基础。

7

总结

本文通详细阐述了研究背景、方法框架、实验设计、结果分析、优势不足以及未来展望。旨在帮助读者深入理解该研究对机器人学领域的贡献与意义。

文/PNP机器人 转载请申请

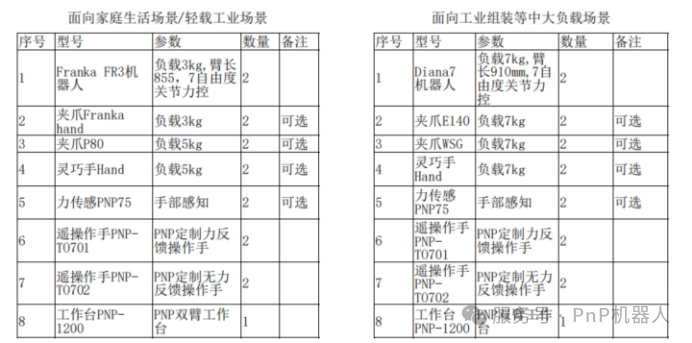

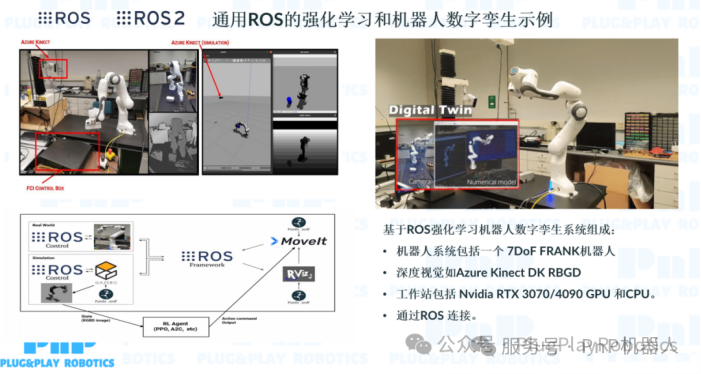

PNP机器人是德国FRANKA机器人卓越战略合作伙伴德国慕尼黑—PNP机器人成为Franka Robotics卓越战略伙伴,推动具身智能机器人全球生态

PNP机器人提供成套具身智能机器人操作和训练平台

更多推荐

已为社区贡献92条内容

已为社区贡献92条内容

所有评论(0)