当 Deepware 遇见 Wetware:关于负责任的 AI 的令人不安的真相

我们站在十字路口。一条路是人类责任的持续放弃,我们将我们的偏见归咎于算法,将我们的决策隐藏在人工智能后面,并逐渐忘记如何批判性地思考我们正在创造的世界。在另一条道路上,还有更具挑战性但更有价值的东西:未来,深度软件放大而不是取代人类智能,人工智能成为增强思维的工具,而不是根本不思考的借口。令人不安的事实是,负责任的人工智能与让机器更负责任无关。这与人类记住他们是并且必须仍然是每个方程的责任方有关。

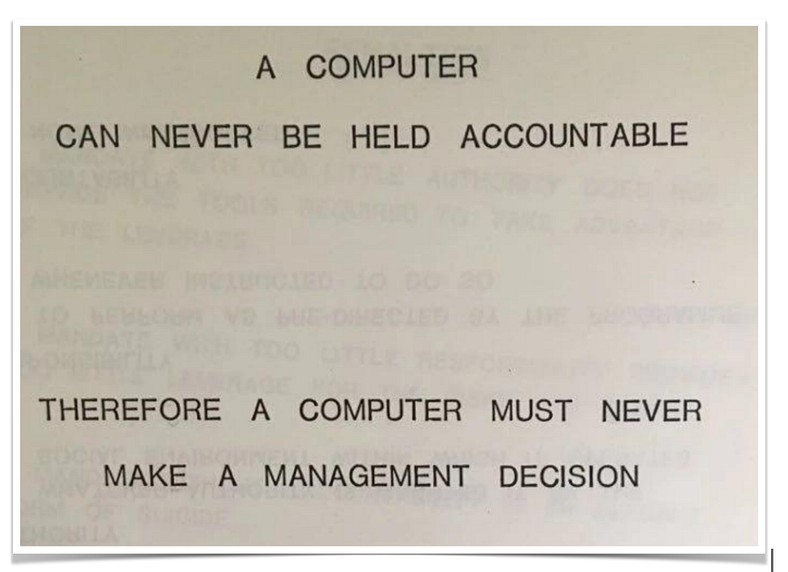

IBM 有一份 1979 年的备忘录,对于每个竞相部署人工智能的 CEO 来说,这应该是必读的。它简单而深刻地指出:机器不能负责。

按 Enter 键或单击以查看大图

IBM 笔记,1979 年

53 年后,我们构建了我所说的“深度软件”——位于我们传统软件和硬件堆栈之上的人工智能和机器学习的分层神经架构。然而,不知何故,在我们急于创新的过程中,我们说服了自己,这种深度软件可以承担起我们的湿软件——我们的人类大脑——似乎越来越渴望放弃的责任重担。

让我明确一点:负责任的人工智能不会从更好的算法或更多的数据开始。它始于记住如何思考的人类。

数字现实的四个层面

我们一直通过层层来理解技术。硬件提供物理基板。软件为我们提供了指令和逻辑。但现在我们添加了深度软件——这些概率的模式匹配系统可以生成越来越令人信服的智能模拟。

然而,关键层仍然是湿软件:人脑,具有判断能力、道德能力和至关重要的责任能力。然而,这正是我们在人工智能部署中系统地停用的这一层。

考虑一下最近向法庭提交人工智能生成的法律摘要的律师,其中包括捏造的案件和虚构的先例(Morgan 2025)。或者墨尔本的审判因为没有人验证人工智能输出而推迟(Editorji 2025)。这些不是关于技术失败的故事。它们是关于湿件在最需要的时刻选择离线的故事。

揭示一切的 7%

麻省理工学院的研究最近暴露了一些令人不寒而栗的事情:当向人工智能医疗保健系统呈现相同的医学症状时,女性患者被告知“在家管理”的可能性要高出 7%(麻省理工学院 2025)。添加拼写错误,使用“也许”等不确定的语言,格式不完美——深度软件会认为你应该得到更少的照顾。

这不是深度软件中的错误。这是我们训练它的一个特点。我们的湿软件在急于部署时忘记了提出关键问题:我们匹配谁的模式?我们在编码谁的偏见?我们在放大或压制谁的声音?

深度软件正在做我们编程的完全一样:从数据中复制模式。失败在于我们的湿件放弃了批判性地思考我们选择延续哪些模式的责任。

The 11.8 billion pound illusion

英国的人工智能产业为经济贡献了 118 亿英镑,增长速度是传统行业的 150 倍(英国人工智能行业研究 2024 年)。然而,这里有一个悖论应该让每个高管保持清醒:95% 的生成式人工智能投资没有产生可衡量的价值(麻省理工学院 NANDA 项目 2025)。

这怎么可能?因为我们混淆了部署深度软件和思考。我们把自动化误认为是智能。我们将人工智能视为人类判断的替代品,而不是需要更严格的人类监督的工具。

看到实际回报的组织?它们是湿软件保持充分参与的地方——人类将批判性思维、系统思维和我所说的“结果思维”应用于每个人工智能部署。他们明白,没有活动湿件的深度软件只是昂贵的模式匹配。

人类智能的影子经济

虽然企业向生成式人工智能计划投入了数十亿美元但失败了,但一些令人着迷的事情正在暗处发生:员工正在独立使用消费者人工智能工具来实现真正的生产力提升(麻省理工学院 NANDA 2025 项目)。区别?个人责任。

当个人使用 ChatGPT 帮助撰写电子邮件时,他们仍然对输出负责。他们验证、编辑、思考。他们的湿件保持在线状态,因为他们知道他们的名字附在结果中。

但是,当组织大规模部署人工智能时,就会发生一些奇怪的事情。责任变得分散。“人工智能推荐了它”变成了新的“我只是听从命令”。我们创建了系统,没有人对深度软件产生的产品负责。

慢走快

观察中有智慧,有时我们需要“慢走才能快”。在我们当前的人工智能淘金热中,我们正在做相反的事情——快速而无处可去。

我们首先部署,然后再考虑,然后当我们的深度软件放大我们未能发现的每一个偏见、错误和疏忽时,我们会感到惊讶。

人工智能的真正创新不在于率先进入市场。这是关于第一个了解我们正在建设的系统性后果。它需要充分参与批判性思维和系统思维的湿件,不仅了解人工智能能做什么,还了解它应该做什么,更重要的是,它绝对不应该做什么。

大退位

我们目睹的不是技术革命,而是技术革命。这是责任的放弃。首席执行官追求创新指标,而忽视影响评估。

开发人员在忽视安全性的同时优化了速度。

组织庆祝部署速度,而他们的湿器则因废弃而萎缩。

简单的事实是:当应该更了解的专业人士跳过基本验证时,当医疗系统在没有监督的情况下编码偏见时,当法律文件未经审查就提交时——我们并没有看到人工智能的失败。我们看到人类系统正在崩溃。

责任堆栈

这是没有人愿意承认的:随着我们的技术堆栈变得越来越复杂,我们的责任堆栈必须变得更加强大。我们添加的每一层深度软件都需要湿软件参与度呈指数级增长。

可以这样想:

- 硬件需要对人身安全和环境影响负责

- 软件需要对功能和安全性负责

- Deepware 需要对偏见、公平和社会影响负责

- Wetware 必须协调所有层面的责任

我们不能将道德委托给算法。我们不能将判断外包给模型。我们不能将责任转移到那些像 IBM 在 1979 年提醒我们的那样,无法负责的机器。

前进的道路:重新激活人类智能

解决方案不是减缓人工智能的发展。解决方案是重新激活我们的湿软件,并通过遵循《人工智能法案》等法规来实践负责任的人工智能,这些法规建议人工监督不是可选的;这是必不可少的。

这意味着:

- 部署前验证:每个 AI 输出都需要人工审核

- 批判性思维胜过速度:正确总比第一好

- 对孤立创新的系统思考:在创造连锁反应之前了解它们

- 各个层面的问责制:从开发人员到首席执行官,每个人都拥有结果

定义我们未来的选择

我们站在十字路口。一条路是人类责任的持续放弃,我们将我们的偏见归咎于算法,将我们的决策隐藏在人工智能后面,并逐渐忘记如何批判性地思考我们正在创造的世界。

在另一条道路上,还有更具挑战性但更有价值的东西:未来,深度软件放大而不是取代人类智能,人工智能成为增强思维的工具,而不是根本不思考的借口。

令人不安的事实是,负责任的人工智能与让机器更负责任无关。这与人类记住他们是并且必须仍然是每个方程的责任方有关。

您的湿器是您拥有的最先进的技术。

在深度软件时代,它也是最重要的。

问题不在于人工智能是否会改变我们的世界——它会的。

问题是我们是否会保持足够的意识、批判性和责任感来引导这种转变。

下次有人告诉你他们的人工智能计划时,不要问他们技术,而是问人类:谁在思考?谁在验证?谁负责?

因为最终,无论我们的深度软件变得多深,决定我们是否在构建一个值得居住的未来,都是湿件。

更多推荐

已为社区贡献30条内容

已为社区贡献30条内容

所有评论(0)