Python大数据之PySpark(一)SparkBase_spark学pyspark可以吗(1)

1-速度快2-非常好用3-通用性4-运行在很多地方Spark 框架模块了解。

·

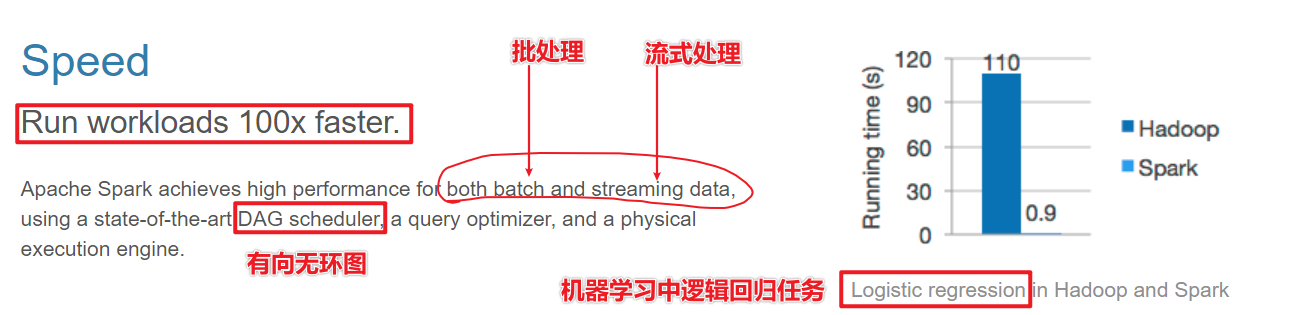

1-速度快

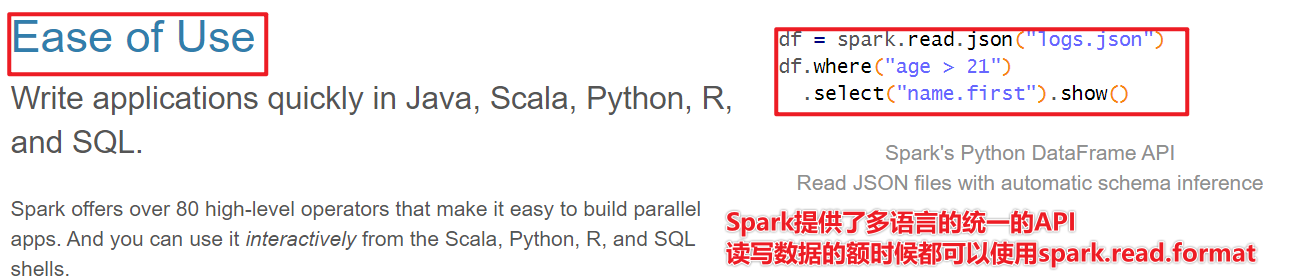

2-非常好用

3-通用性

4-运行在很多地方

Spark 框架模块了解

- Spark框架通信使用Netty框架,通信框架

- Spark数据结构:核心数据RDD(弹性 分布式Distrubyte 数据集dataset),DataFrame

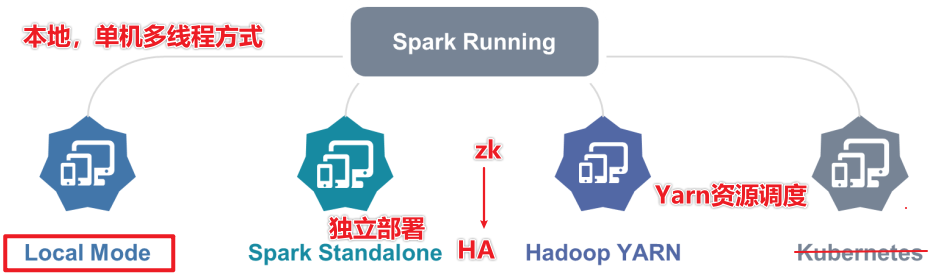

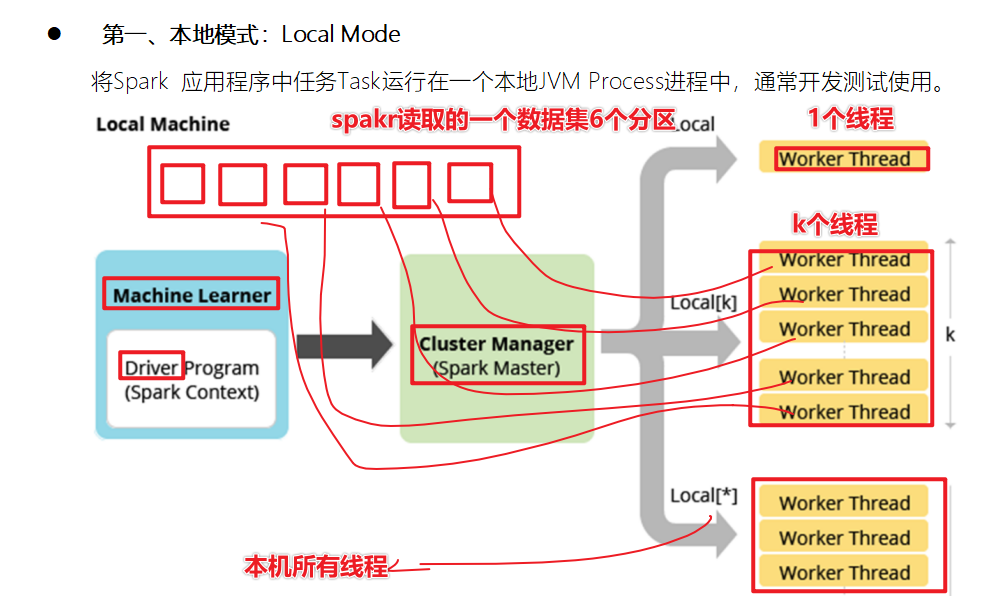

- Spark部署模式(环境搭建)

- local

- local 单个线程

- local[*] 本地所有线程

- local【k】 k个线程

- Spark的RDD有很多分区,基于线程执行分区数据计算,并行计算

- standalone

- StandaloneHA

- Yarn

Spark环境搭建-Local

基本原理

1-Spark的Local模式使用的是单机多线程的方式模拟线程执行Spark的计算任务

2-Spark的local[1] 1个线程执行计算 local[*]本地的所有线程模拟

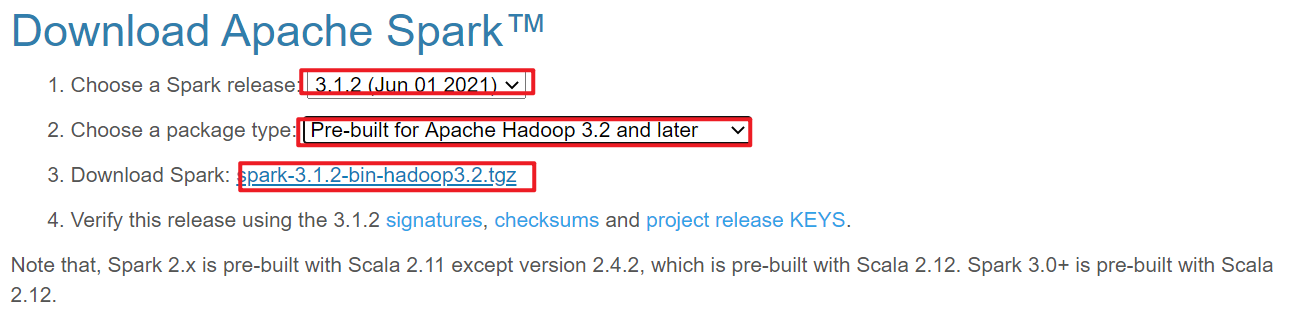

安装包下载

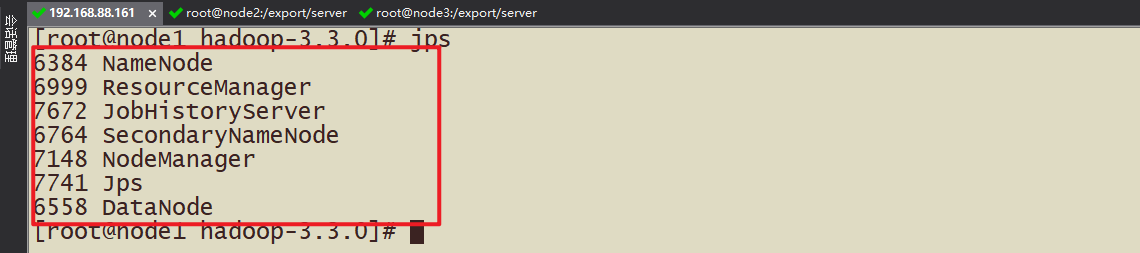

1-搞清楚版本,本机一定得搭建Hadoop集群(Hadoop3.3.0)

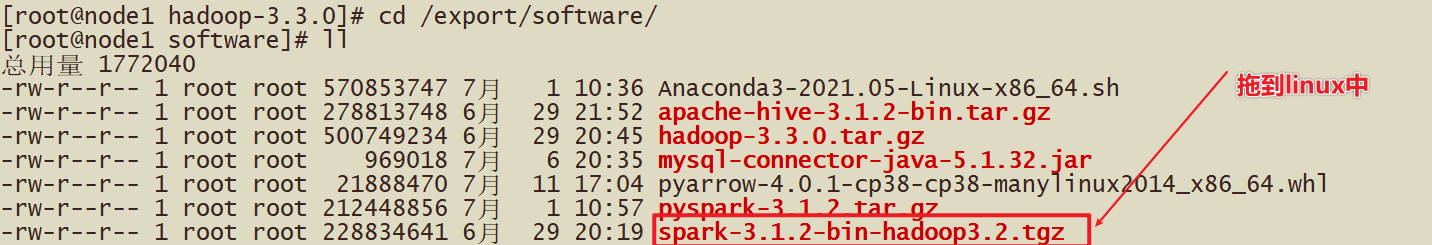

2-上传到Linux中,spark3.1.2-hadoop3.2-bin.tar.gz

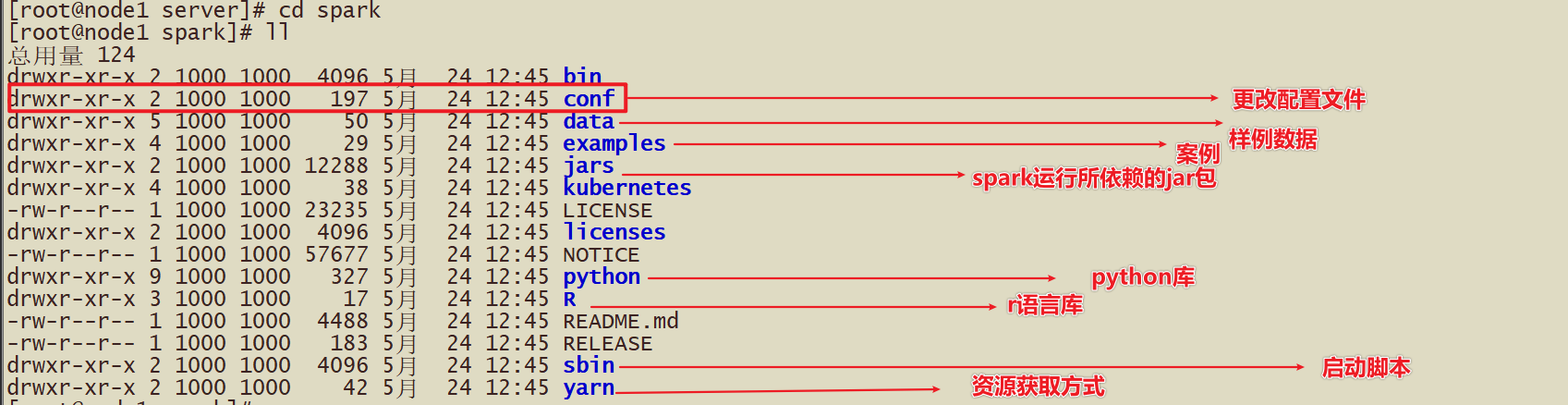

3-解压Spark的压缩包

tar -zxvf xxx.tar.gz -C /export/server

ln -s spark-3.1.2-bin-hadoop3.2/ /export/server/spark

4-更改配置文件

这里对于local模式,开箱即用

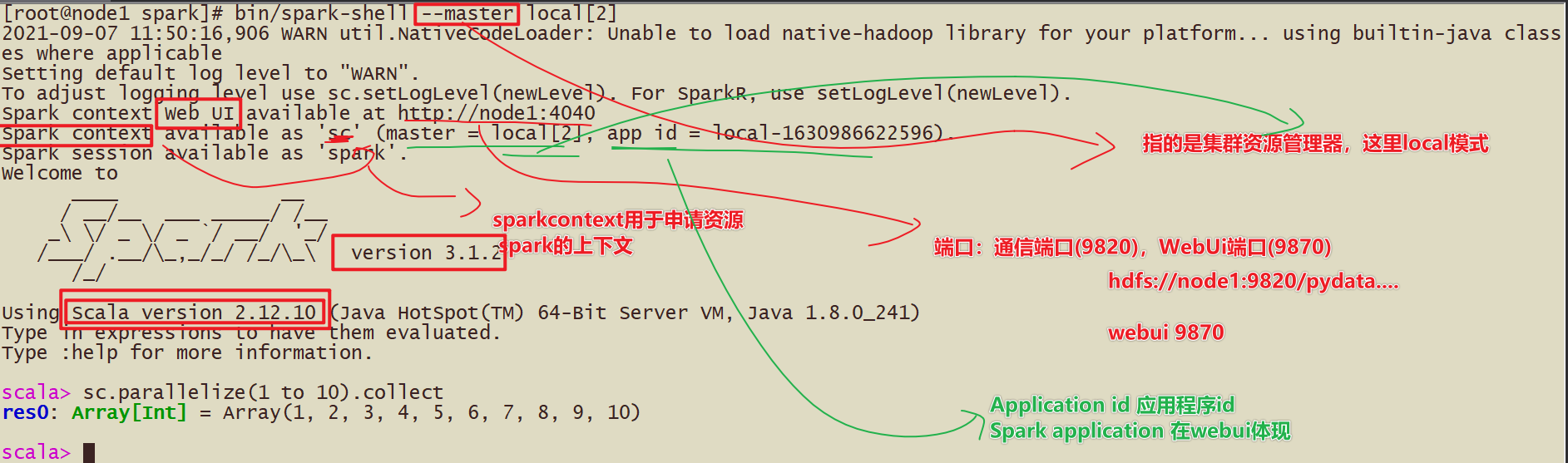

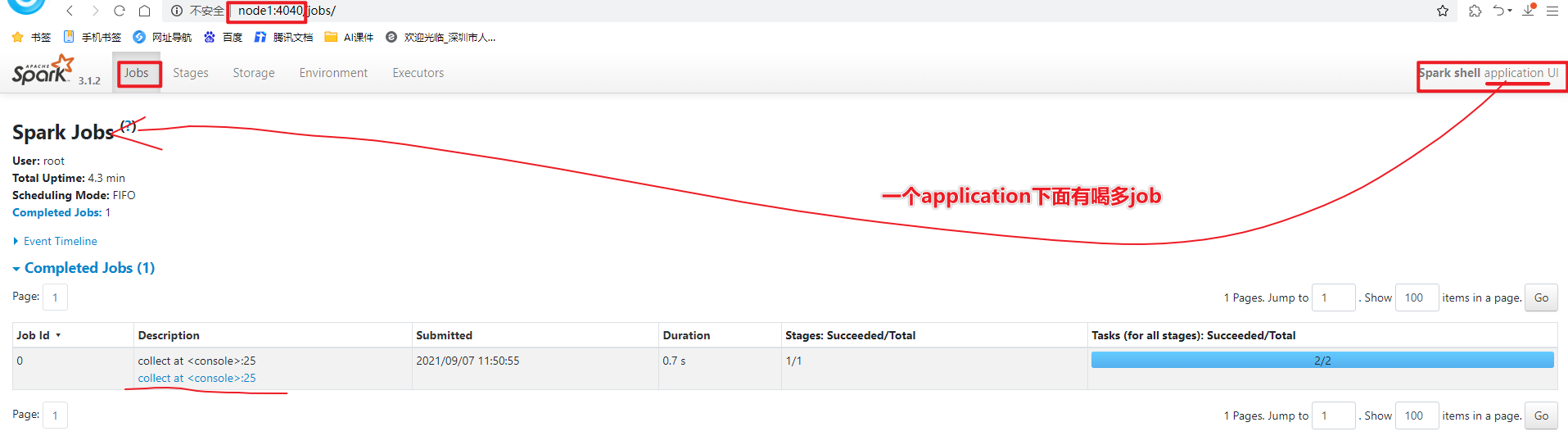

5-测试

spark-shell方式 使用scala语言

pyspark方式 使用python语言

上午回顾:

为什么要学习Spark?

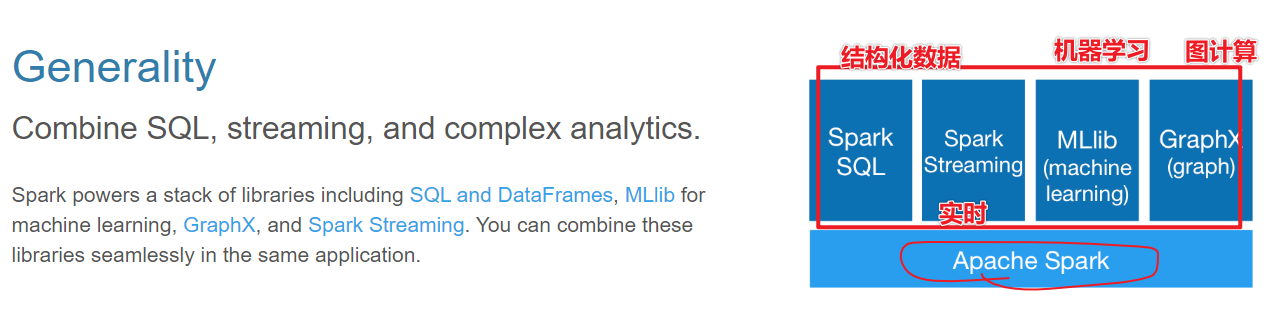

- 答案:首先Spark是基于Hadoop1.x改进的大规模数据的计算引擎,Spark提供了多种模块,比如机器学习,图计算

- 数据第三代计算引擎

什么是Spark?

- Spark是处理大规模数据的计算引擎

- 1-速度快,比Hadoop块100倍(机器学习算法) 2-易用性(spark.read.json) 3-通用性 4-run anywhere

Spark有哪些组件?

- 1-SparkCore—以RDD(弹性,分布式,数据集)为数据结构

- 2-SparkSQL----以DataFrame为数据结构

- 3-SparkStreaming----以Seq[RDD],DStream离散化流构建流式应用

- 4-结构化流structuredStreaming—DataFrame

- 5-SparkMllib,机器学习,以RDD或DataFrame为例

- 6-SparkGraphX,图计算,以RDPG弹性分布式属性图

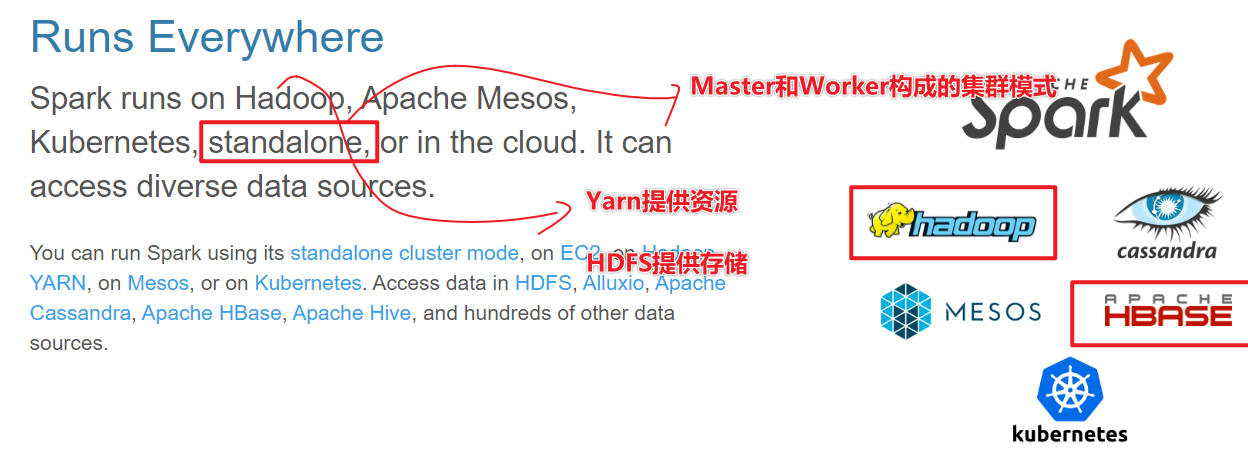

Spark有哪些部署方式?

- local模式

- standalone模式(独立部署模式)

- standaloneHA模式(高可用模式)

- Yarn模式(Hadoop中分布式资源调度框架)

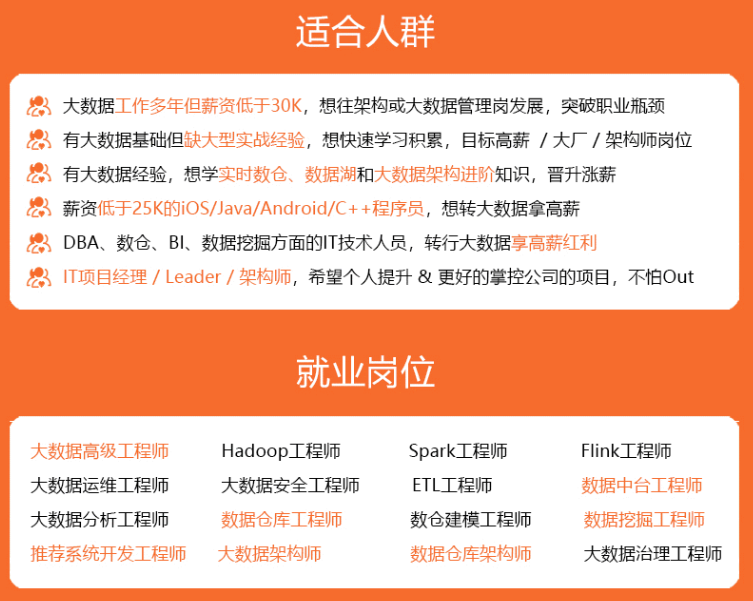

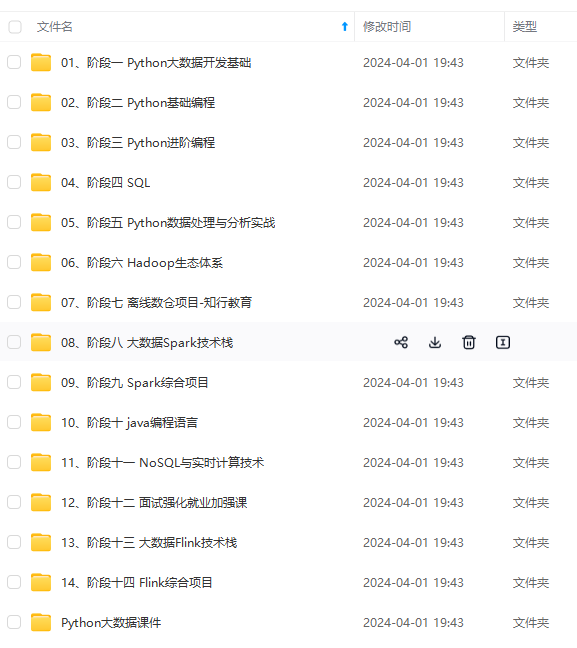

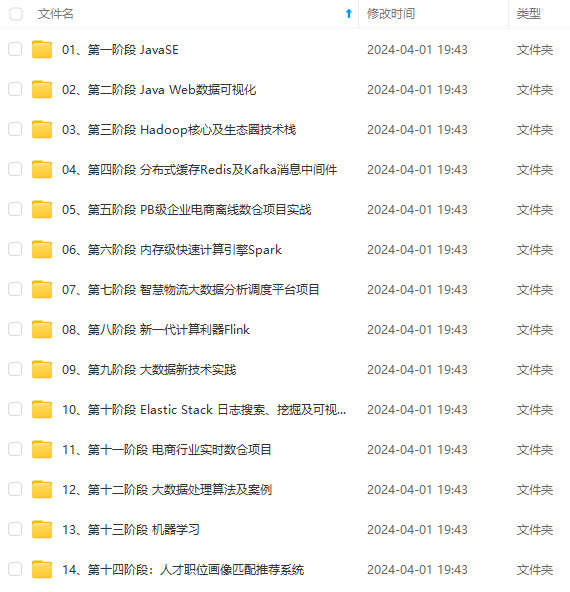

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

的进阶课程,涵盖了95%以上大数据知识点,真正体系化!**

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)