刷爆 AI 圈!DeepSeek-R1 荣登 Nature 封面,梁文锋团队创新训练框架,让大模型靠奖励机制学会高阶推理!

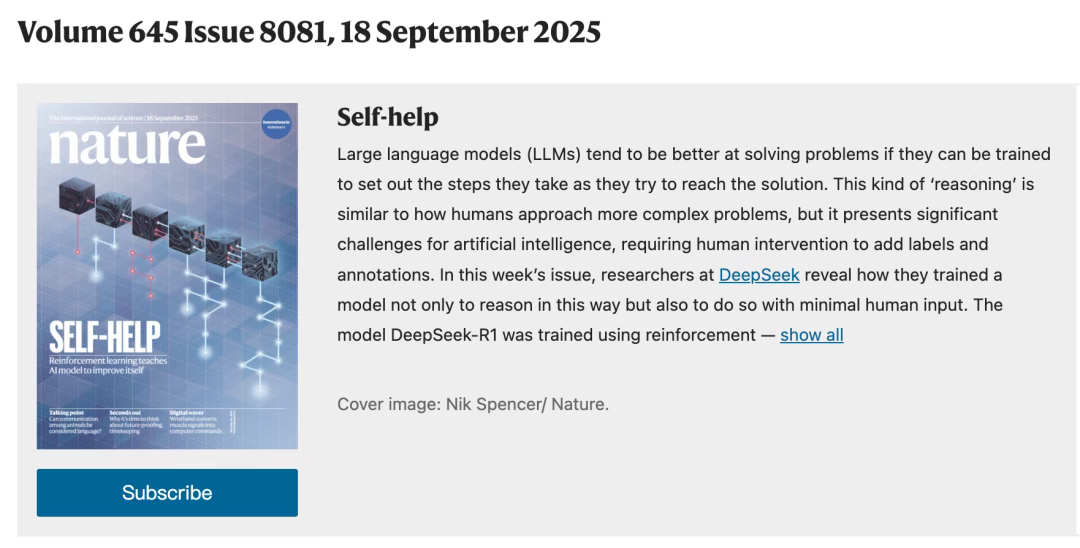

重磅重磅!!DeepSeek-R1 的研究荣登最新一期的!通讯作者正是梁文锋。如果训练出的大模型能够规划解决问题所需的步骤,那么它们往往能够更好地解决问题。这种与人类处理更复杂问题的方式类似,但这对人工智能有极大挑战,需要人工干预来添加标签和注释。在本周的期刊中,DeepSeek 的研究人员揭示了他们如何能够在极少的人工输入下训练一个模型,并使其进行推理。DeepSeek-R1 模型采用强化学习进

重磅重磅!!DeepSeek-R1 的研究荣登最新一期的 Nature 封面啦!通讯作者正是梁文锋。

封面推荐语

如果训练出的大模型能够规划解决问题所需的步骤,那么它们往往能够更好地解决问题。这种推理与人类处理更复杂问题的方式类似,但这对人工智能有极大挑战,需要人工干预来添加标签和注释。在本周的期刊中,DeepSeek 的研究人员揭示了他们如何能够在极少的人工输入下训练一个模型,并使其进行推理。

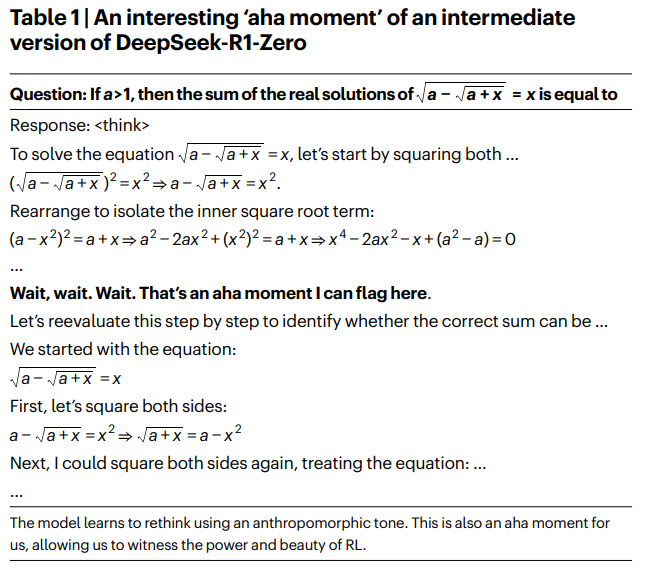

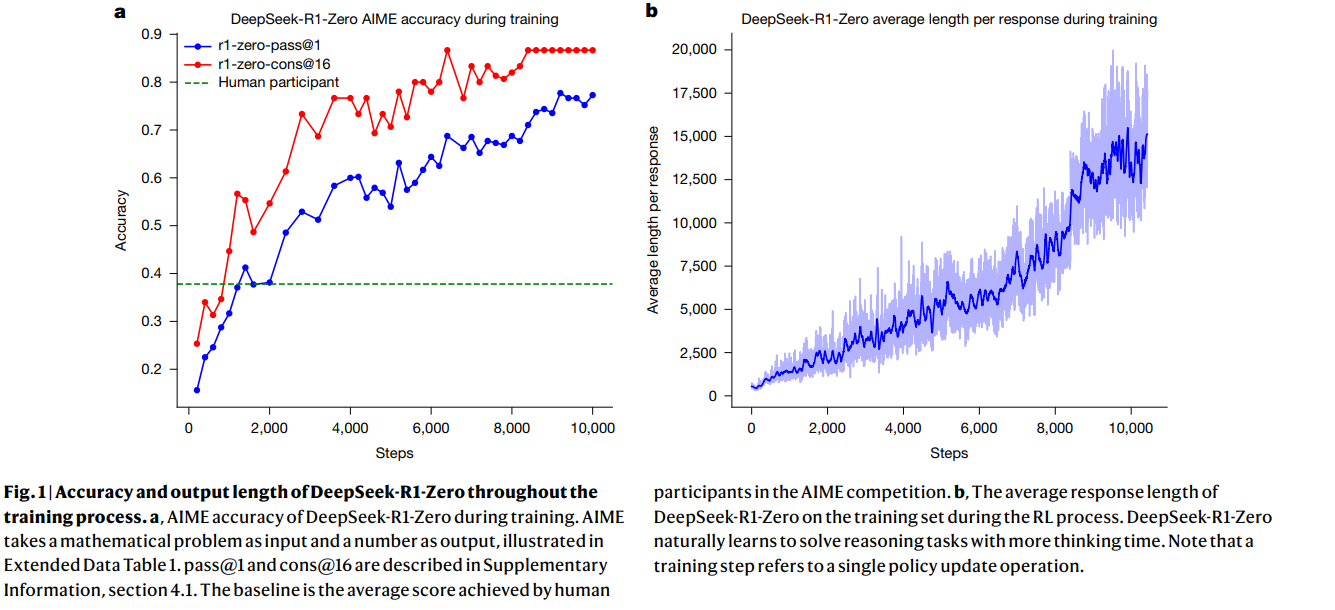

DeepSeek-R1 模型采用强化学习进行训练。在这种学习中,模型正确解答数学问题时会获得高分奖励,答错则会受到惩罚。结果,它学会了推理——逐步解决问题并揭示这些步骤——更有可能得出正确答案。这使得 DeepSeek-R1 能够自我验证和自我反思,在给出新问题的答案之前检查其性能,从而提高其在编程和研究生水平科学问题上的表现。

论文基本信息

论文标题:DeepSeek-R1 incentivizes reasoning in LLMs through reinforcement learning

作者:Deepseek相关团队

论文来源:Nature, Vol 645, 18 September 2025, pp. 633-638

论文链接:https://www.nature.com/articles/s41586-025-09422-z

项目链接:

- 数据与模型权重链接:https://github.com/deepseek-ai/DeepSeek-R1(https://doi.org/10.5281/zenodo.15753193)

- 推理脚本链接:https://github.com/deepseek-ai/DeepSeek-V3(https://doi.org/10.5281/zenodo.15753347)

- 分布式框架HAI-LLM链接:https://www.high-flyer.cn/en/blog/hai-llm

今天由小编来带大家回顾一下这篇精彩的论文!!

总览

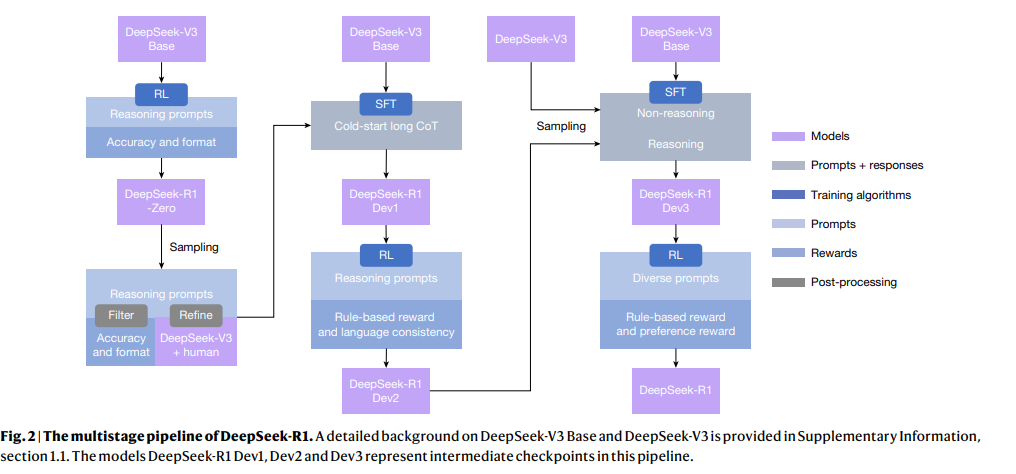

传统LLM推理能力提升高度依赖大规模监督数据,而DeepSeek团队提出突破性思路:无需监督微调(SFT)冷启动,仅通过大规模强化学习(RL)即可显著增强模型推理能力;若补充少量冷启动数据,性能可进一步优化。为落地该思路,团队开发的DeepSeek-R1-Zero具备三项核心设计:

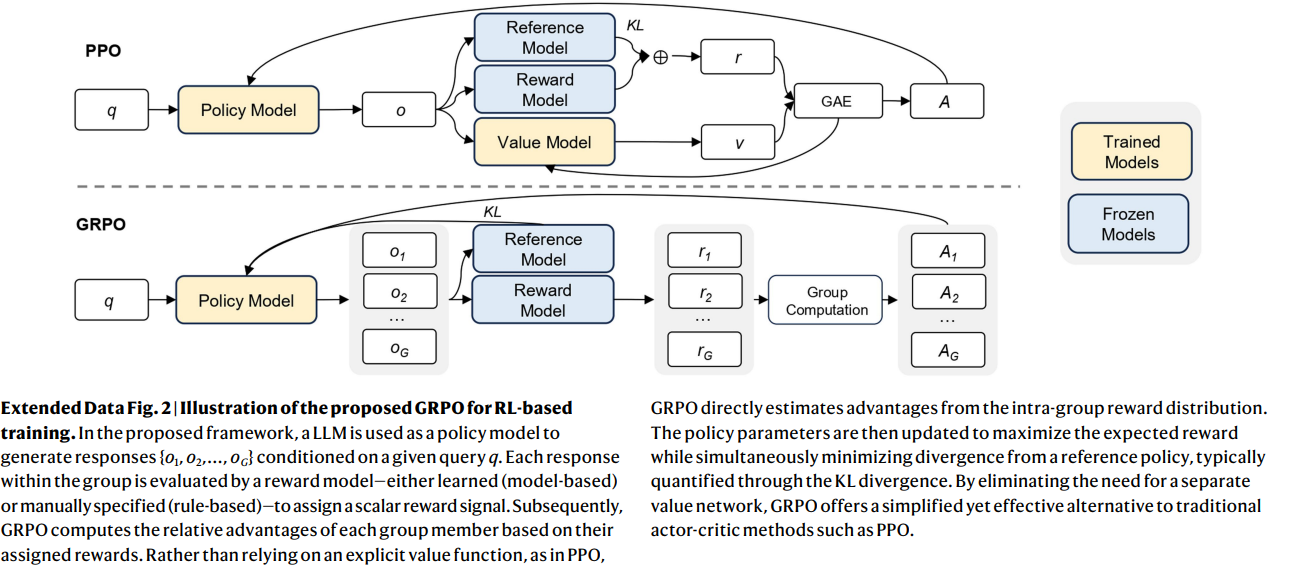

- GRPO算法降低训练成本:采用群组相对策略优化(GRPO)替代传统PPO算法,无需构建与策略模型规模相当的评估模型,直接通过群组内奖励分布估算基线,大幅简化训练流程并减少资源消耗。

- 双维度规则化奖励设计:以“准确度+格式”的互补奖励机制定义RL优化方向。准确度奖励通过规则化验证(如数学题指定答案格式、代码题用编译器测测试用例)判断输出正确性;格式奖励要求模型用特定标记封装推理过程,明确区分推理与答案,提升可解释性。

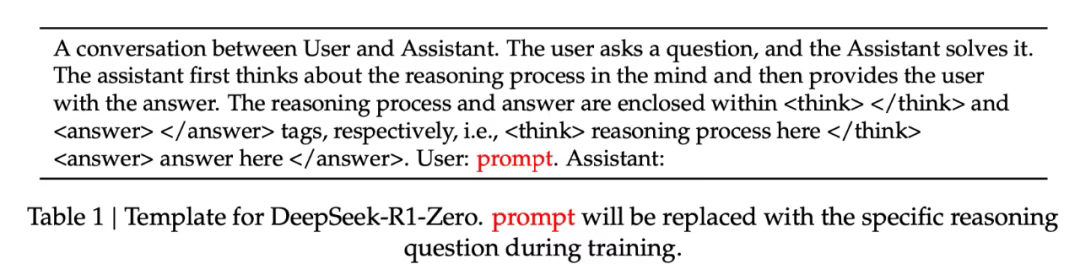

- 最小干预训练模板:设计简洁模板引导模型输出,要求先以标记包裹推理过程、再给出最终答案。仅规范输出结构,不限制推理内容(如不强制反思性推理或特定解题方法),确保清晰观察模型在RL训练中的自然进化过程。

研究思路

(一)基础模型与核心算法选择

- 基础模型:以DeepSeek-V3 Base为基础,该模型主要基于中英文数据训练,为后续强化学习(RL)提供初始架构与参数支撑。

- 核心RL算法:采用群组相对策略优化(GRPO),相比传统PPO算法,无需构建与策略模型规模相当的独立评估模型,可通过群组内奖励分布直接估算优势值,简化训练流程并降低资源消耗。

- 训练简化设计:跳过传统监督微调(SFT)阶段直接启动RL训练,避免人类定义的推理模式限制模型探索空间,助力模型自主涌现新推理能力。

(二)分模型奖励系统设计

1 DeepSeek-R1-Zero:规则化奖励

采用“准确度奖励+格式奖励”的等权重组合机制:

- 准确度奖励:针对数学题(如要求答案置于指定格式内)、代码题(用编译器验证测试用例)等,通过规则化方式判断输出正确性。

- 格式奖励:要求模型将推理过程封装在特定标记内,明确区分推理与答案,提升可解释性与后续分析便利性。

2 DeepSeek-R1:扩展奖励

在规则化奖励基础上新增两类奖励,解决语言混合问题并对齐人类偏好:

- 语言一致性奖励:计算输出中目标语言词汇占比,约束模型减少中英文混合现象。

- 模型基奖励:含helpfulness奖励(用66,000组偏好对训练,评估响应实用性)与safety奖励(用106,000条标注数据训练,判断输出安全性)。

3 分阶段训练流程与参数

DeepSeek-R1-Zero训练

- 超参数:学习率(3×10^{-6}),KL系数0.001,采样温度1;8200步前输出最大长度32,768 tokens,之后提升至65,536 tokens。

- 流程:总计训练10,400步(1.6个周期),每步含32个独特问题,每400步更新参考模型,每次rollout生成的输出划分为16个小批次,每批次仅训练1个内周期以提速。

DeepSeek-R1多阶段训练

- 第一阶段RL:沿用上述超参数,新增语言一致性奖励,输出最大长度32,768 tokens。

- 拒绝采样与SFT:用冷启动对话数据+推理/非推理数据集做SFT,提升指令遵循与通用生成能力。

- 第二阶段RL:采样温度降至0.7,总计1700步训练,最后400步引入通用指令数据与偏好奖励,优化模型实用性与安全性。

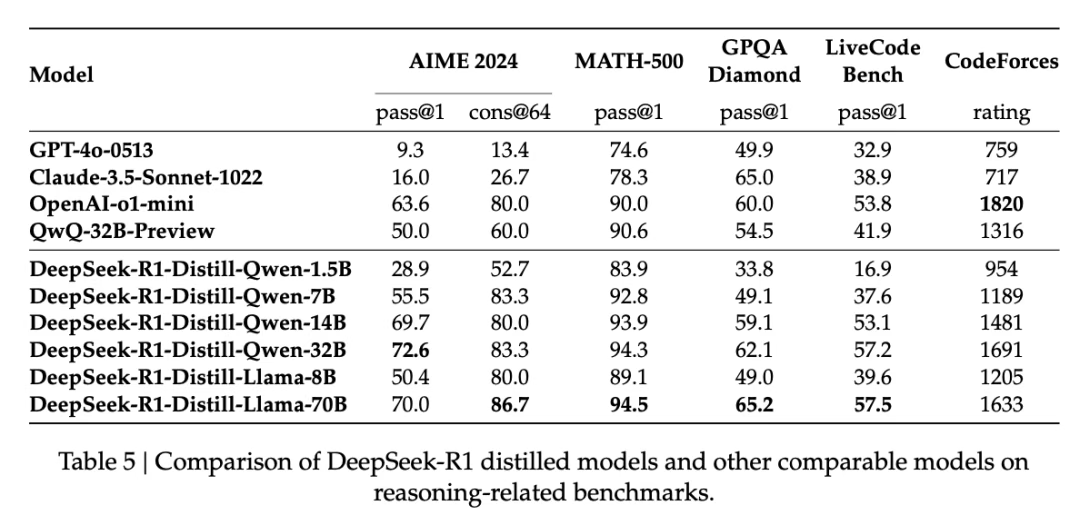

4 模型蒸馏与输出规范

- 模型蒸馏:对DeepSeek-R1蒸馏得到小型模型,保留核心推理能力且性能优于原有指令微调模型,已公开供研究使用。

- 输出模板:采用对话式模板,要求模型先输出标记包裹的推理过程,再给出答案,仅规范结构不限制内容,确保观察模型自然进化。

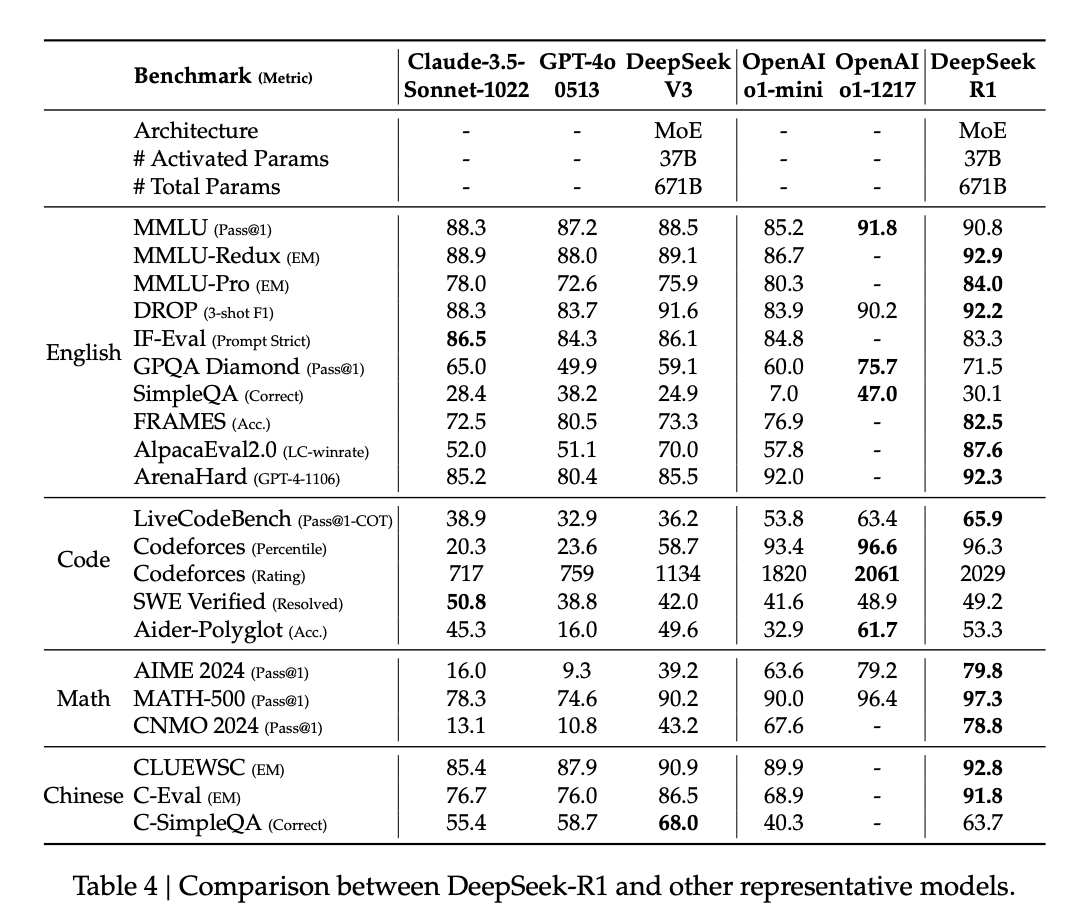

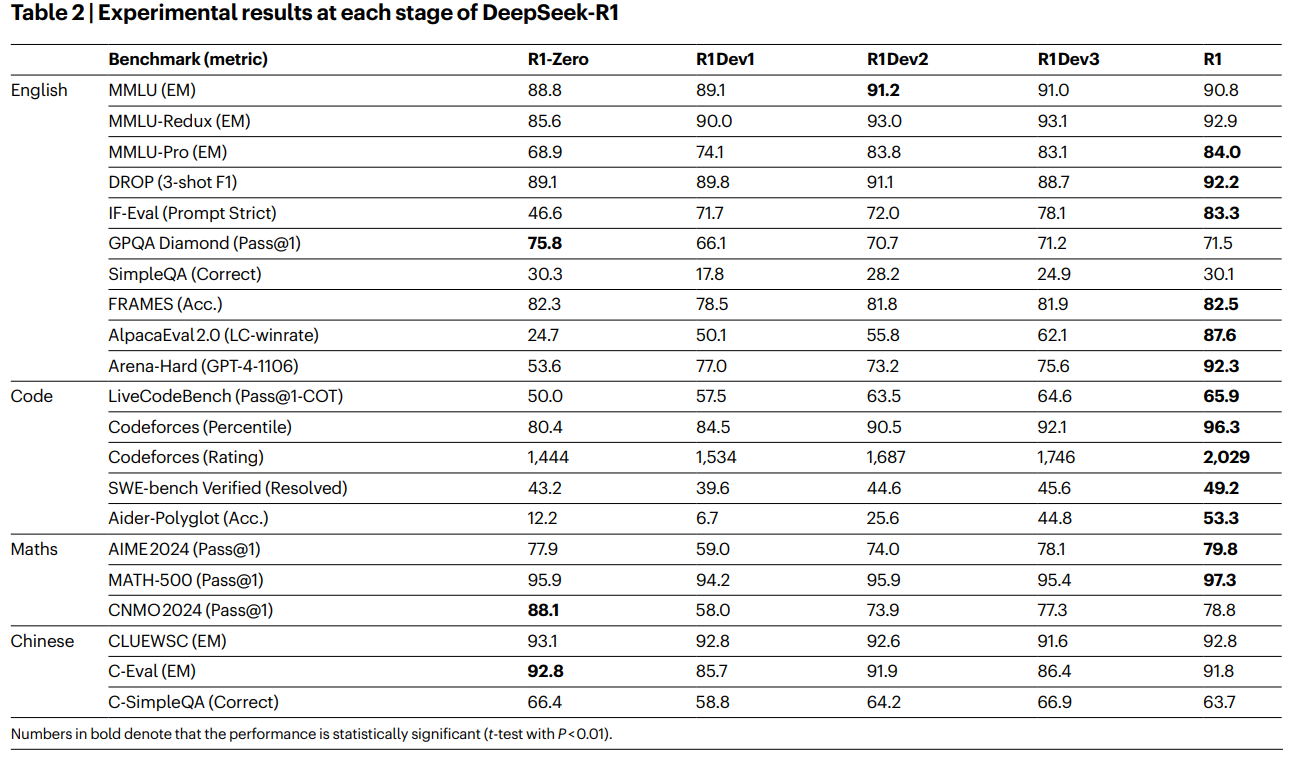

凭借上述多项技术创新,大量基准测试显示,DeepSeek-R1 的推理能力已比肩业内 SOTA 大模型,具体结果可参考相关测试数据:

图1展示了DeepSeek-R1-Zero训练过程中的关键表现:图1a显示其在AIME 2024基准测试的pass@1分数从15.6%升至77.9%,结合自一致性解码达86.7%,远超人类平均水平;图1b则呈现其平均响应长度随训练稳步增长,体现思考时间延长与推理策略优化的自我进化过程。

表2总结DeepSeek-R1从R1-Zero到最终版各阶段在多领域基准的性能,既体现模型在指令跟随、推理及通用任务上的阶段性提升,也反映不同训练阶段对模型能力的影响(如Dev1因冷启动数据有限降推理性能),最终版R1在通用指令跟随和用户偏好基准进步显著,印证多阶段训练有效性。

关注下方《AI前沿速递》🚀🚀🚀

各种重磅干货,第一时间送达

码字不易,欢迎大家点赞评论收藏

更多推荐

已为社区贡献24条内容

已为社区贡献24条内容

所有评论(0)