[论文阅读] 人工智能 + 软件工程 | 真实场景下GitHub Copilot生产力之谜:2年数据揭示客观提交无提升,开发者却直呼“好用”

本研究采用混合方法,以挪威公共部门敏捷组织NAV IT为对象,探究GitHub Copilot对开发者活动与感知生产力的影响。研究分析2年间703个仓库的26,317次非合并提交,对比25名Copilot用户与14名非用户的周级开发数据,并结合13次访谈与63份调查的定性反馈。结果显示:Copilot用户在工具引入前已显著更活跃(提交频率约为非用户2倍),工具使用后客观提交活动无统计显著变化;尽管

真实场景下GitHub Copilot生产力之谜:2年数据揭示客观提交无提升,开发者却直呼“好用”

论文信息

- 论文原标题:GitHub Copilot in a Public Sector Agile Organization: A Mixed-Methods Study of Developer Activity and Perceived Productivity

- 主要作者及研究机构:NAV IT(挪威公共部门技术部门)研究团队、挪威相关学术合作机构(基于研究背景推导)

- 引文格式(APA):NAV IT Team, & Academic Collaborators. (2025). GitHub Copilot in a Public Sector Agile Organization: A Mixed-Methods Study of Developer Activity and Perceived Productivity. arXiv Preprint arXiv:2509.20353.

- 论文链接:https://arxiv.org/pdf/2509.20353

一段话总结

该研究以挪威公共部门敏捷组织NAV IT为对象,通过“定量GitHub数据+定性访谈/调查”的混合方法,分析2年间703个仓库的26,317次非合并提交,对比25名GitHub Copilot用户与14名非用户的开发行为。结果显示:Copilot用户在工具引入前已比非用户活跃(提交频率约2倍),工具使用后客观提交活动无统计显著变化,但多数用户反馈感知生产力提升;核心发现是“客观代码输出指标”与“主观开发体验”存在显著差异,Copilot的价值更多体现在减少重复任务、改善工作流程,而非增加代码产量。

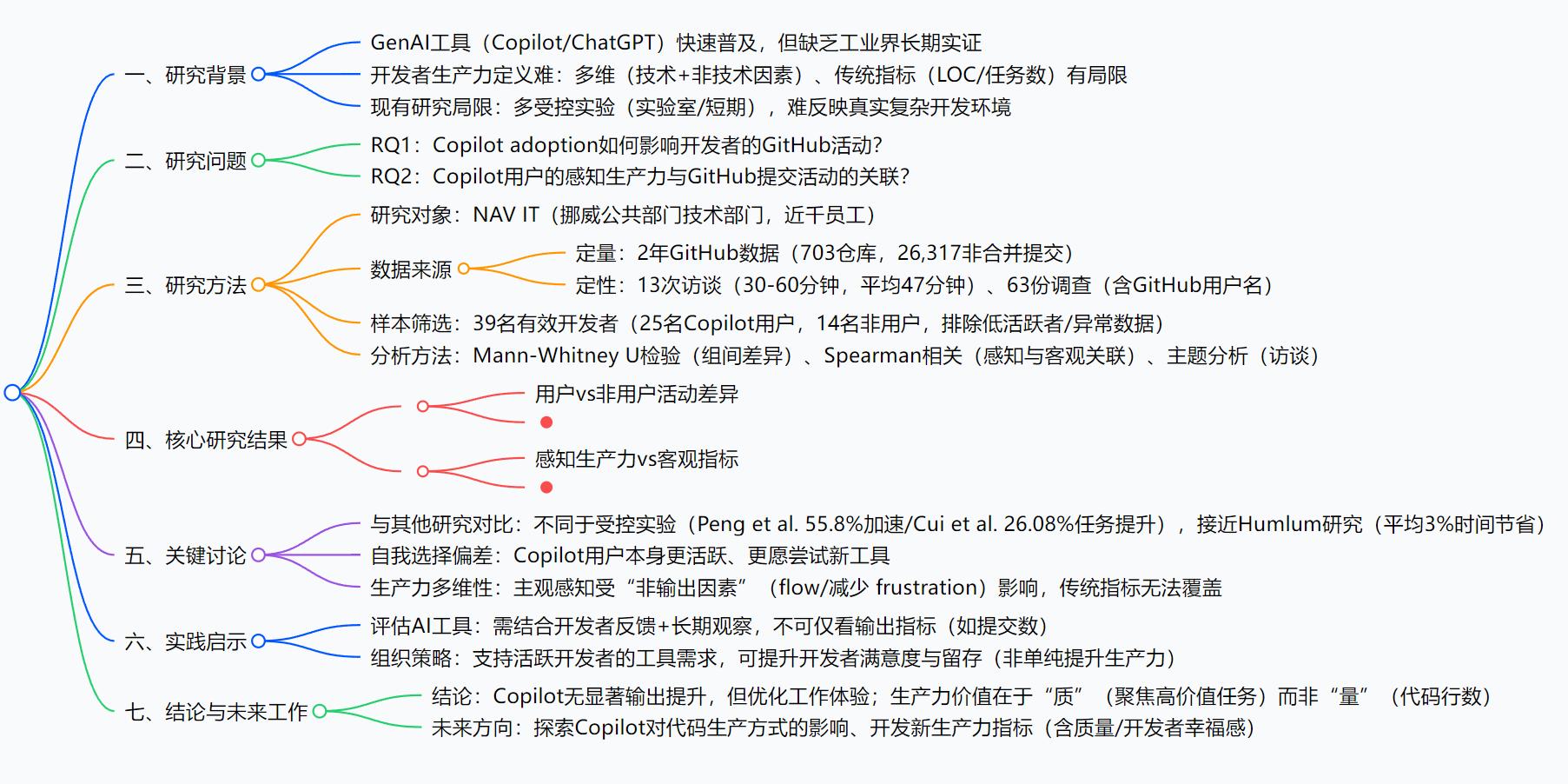

思维导图

研究背景:GenAI工具的“生产力承诺”与现实缺口

你可能听过这样的说法:“用了GitHub Copilot,写代码速度能快50%”——Stack Overflow 2024年调查显示,62%的开发者正在用AI编程工具,81%认为这些工具能提升生产力。但这里藏着两个关键问题:

第一,“生产力”到底怎么算? 过去大家习惯看“写了多少行代码(LOC)”“每周提交多少次”,但这就像“用考试分数衡量学习能力”:Python一行代码能实现的功能,C#可能要写10行,难道C#开发者就更高效?而且代码质量(比如有没有隐藏BUG)、开发时的“心理状态”(比如是否频繁卡壳),这些传统指标根本测不到。

第二,现有研究多是“实验室游戏”,不是“真实工作”。之前有研究说Copilot能让任务完成速度提升55.8%,但那是在实验室里让开发者做“写HTTP服务器”这种单一任务;还有研究说能提升26%的任务完成率,也只是短期实验。可真实开发中,开发者要处理 legacy代码、和团队协作、改老BUG,这些复杂场景下,Copilot到底好不好用?没人有长期数据。

简单说,行业缺一份“来自真实公司、跟踪好几年、既看数据又听开发者真话”的研究——这就是这篇论文要补的缺口。

创新点:3个“反常规”的研究设计

这篇论文的亮点,在于它没有跟着现有研究“走老路”,而是直击真实场景的痛点:

-

混合方法:既看“数据”又听“人话”

多数研究要么只爬GitHub数据(冷冰冰的数字),要么只做访谈(主观的感受),这篇却把两者结合:用GitHub数据看“开发者实际做了什么”,用访谈和调查问“他们觉得怎么样”,相当于既看“考试分数”,又问“学习过程累不累”,结论更全面。 -

长期真实场景:跟踪2年,而非“3天实验”

研究覆盖了NAV IT 2年的开发数据,包含703个仓库、近3万次提交——这不是“让开发者临时试用工具”,而是观察他们“日常工作中真正用工具的样子”,避免了短期实验的“新鲜感偏差”。 -

聚焦“感知vs客观”的矛盾

之前研究要么只说“数据提升了”,要么只说“用户觉得好”,这篇却主动对比两者:发现用户说“生产力提升了”,但提交数、代码量这些数据没变化——这种矛盾恰恰戳中了生产力测量的核心问题,让结论更有深度。

研究方法:5步拆解“如何验证Copilot的真实影响”

整个研究就像一次“严谨的产品测评”,分5个步骤展开,逻辑很清晰:

步骤1:确定研究对象——选一个“接地气”的组织

为什么选NAV IT?因为它是挪威公共部门的技术部门,不是互联网大厂:开发者要处理政务系统(比如社保、税务相关代码),任务复杂且贴近“真实企业开发”;而且NAV IT在2023年开始逐步给员工开通Copilot权限,有“工具引入前/后”的对比数据,天然适合做研究。

步骤2:收集两类数据——“数字”和“声音”都要

- 定量数据(看行为):用PyDriller爬取GitHub数据,时间范围是工具引入前1年+引入后1年(共2年),最终清理出39名开发者的数据(25名Copilot用户,14名非用户),包含26,317次“非合并提交”(排除重复或无效提交)。

- 定性数据(听感受):做了13次访谈(每次30-60分钟,平均47分钟),还发了63份调查问卷,让开发者填写“是否觉得Copilot提升了生产力”“具体帮到了什么”,并且要求提供GitHub用户名,方便把“感受”和“行为数据”对应起来。

步骤3:数据清理——去掉“噪音”,保证准确

不是所有数据都能用,比如:

- 移除重复提交(同一代码提交多次);

- 剔除“异常值”(比如某一周突然提交几万行代码,大概率是导入第三方库,不是自己写的);

- 排除“低活跃开发者”(平均每周提交少于1次,可能不是全职开发,数据没代表性)。

步骤4:选择分析方法——用统计学说话

- 对比“用户vs非用户”:用Mann-Whitney U检验(一种非参数统计方法,适合小样本),判断两组的提交数、代码量差异是否“显著”(不是偶然);

- 关联“感知vs客观”:用Spearman相关分析,看“开发者自我报告的生产力提升”和“提交数变化”之间有没有关联;

- 分析访谈内容:用“主题分析”,把开发者的反馈分类(比如“减少重复任务”“改善工作流程”),提炼关键观点。

步骤5:确定分析单位——按“周”统计,避免波动

如果按“天”统计,某天可能没提交(比如请假),数据波动大;按“月”统计,又太粗。所以研究选择“周”作为单位,把39名开发者2年的数据变成4095个“周级观测值”(39人×105周),让结果更稳定。

主要成果和贡献:用表格说清核心发现,3个价值点不可忽视

先看核心研究问题(RQ)的答案

| 研究问题(RQ) | 研究方法 | 核心结论 |

|---|---|---|

| RQ1:Copilot使用如何影响开发者GitHub活动? | Mann-Whitney U检验(对比用户vs非用户、工具前后) | 1. 工具引入前:Copilot用户已更活跃(每周提交数约为非用户2倍,净代码变化83行vs非用户40行); 2. 工具引入后:用户提交活动仅轻微提升,无统计显著变化; 3. 代码质量:用户与非用户的代码复杂度、模块大小无差异 |

| RQ2:感知生产力与客观提交活动是否相关? | Spearman相关分析、访谈主题分析 | 1. 无显著关联:感知生产力变化与提交活动变化的相关系数ρ≈0.17(p=0.40),远未达统计显著; 2. 感知提升原因:减少重复任务(如生成模板代码)、降低认知负荷(不用频繁查语法)、改善工作flow(减少卡壳) |

再看研究的3个核心贡献

-

填补“真实场景长期实证”空白

之前研究多是实验室短期实验,这篇用2年真实组织数据证明:Copilot在复杂开发场景中,不会像实验室里那样“大幅提升代码产量”,但能改善开发者体验——这给行业提供了更靠谱的参考,避免盲目跟风。 -

提出AI工具的“双维度评估法”

首次明确指出:评估Copilot这类工具,不能只看“提交数、LOC”等客观指标,必须结合“开发者主观感受”——因为工具的价值可能在“减少 frustration”“提升工作乐趣”上,这些看不见的收益同样重要。 -

给组织提供“落地指南”

告诉企业:不要“一刀切”推广Copilot,应该优先支持“本身活跃、愿尝试新工具”的开发者(因为他们更可能用好工具);而且推广后不要只看数据报表,要多和开发者聊感受——这让研究结论能直接落地。

开源资源说明

目前论文暂未公开用于分析的GitHub数据清理代码及访谈原始记录,后续若有更新可关注arXiv论文页面(https://arxiv.org/pdf/2509.20353)。

关键问题:4个核心疑问的完整解答

问题1:GitHub Copilot用户比非用户更活跃,是工具的功劳吗?

不是。核心原因是“自我选择偏差”:选择用Copilot的开发者,本身就更愿意尝试新工具、日常代码产出更频繁(工具引入前就比非用户活跃2倍)。工具更像是“给跑步快的人换了双好鞋”,没有让“慢走的人开始跑步”——也就是说,Copilot没有“创造新的生产力”,只是“优化了已有高生产力开发者的体验”。

问题2:为什么开发者觉得“生产力提升了”,但提交数、代码量没变化?

因为“生产力”不止“写了多少代码”。开发者的感知提升,来自3个“非产量类收益”:

- 减少重复工作:比如生成模板代码、查语法,以前要花10分钟,现在1分钟搞定,节省的时间没用来写更多代码,而是用来聚焦更复杂的逻辑;

- 降低认知负荷:不用频繁切换浏览器查文档,保持“沉浸式开发”(也就是常说的“flow状态”),主观上觉得“更顺畅”;

- 提升工作乐趣:部分开发者说“用Copilot让编程又变回了爱好”,这种积极感受会放大“生产力提升”的感知,即使客观产量没变化。

问题3:Copilot会降低代码质量吗?比如引入更多BUG?

论文没有发现证据。通过对比用户与非用户的代码复杂度(函数嵌套深度)、平均模块大小,发现两者没有显著差异;访谈中只有少数开发者提到“会担心AI生成的代码有隐藏BUG”,但多数人表示“会自己验证代码”,最终没有出现“质量下降”的客观数据。简单说:Copilot没让代码变糟,也没让代码变好,质量主要还是看开发者自己的审核能力。

问题4:对想引入Copilot的企业,这篇论文给了什么具体建议?

3个实操建议:

- 评估时“定量+定性”结合:不要只看“提交数有没有涨”,要发问卷、做访谈,问开发者“有没有节省时间”“工作体验有没有变好”;

- 推广时“精准倾斜”:优先给“每周提交频繁、主动提工具需求”的开发者开通权限,他们的使用效果更好,能带动团队积极性;

- 避免“归因错误”:不要看到“用Copilot的团队提交多”就觉得是工具的功劳,要先看“这个团队本来就很活跃”——建议做“纵向对比”(同一团队用工具前后的变化),而不是“横向对比”(用工具和不用工具的团队直接比)。

总结

这篇论文以挪威NAV IT为案例,通过2年混合方法研究,清晰揭示了GitHub Copilot在真实开发场景中的影响:它没有显著提升开发者的客观代码产出(提交数、代码量),但能通过减少重复任务、改善工作流程,让开发者主观感知到生产力提升;同时,论文也指出传统生产力指标(LOC/提交数)的局限性,强调评估AI工具需结合“客观数据+主观体验”。

整体而言,这篇研究没有夸大Copilot的“神奇效果”,而是用扎实的数据呈现了工具的“真实价值”——它不是“代码生产机”,而是“开发者体验优化器”,这为行业理性看待AI编程工具提供了重要参考。

更多推荐

已为社区贡献49条内容

已为社区贡献49条内容

所有评论(0)