一阶谓词逻辑及其重要子集对人工智能自然语言处理深层语义分析的影响与启示

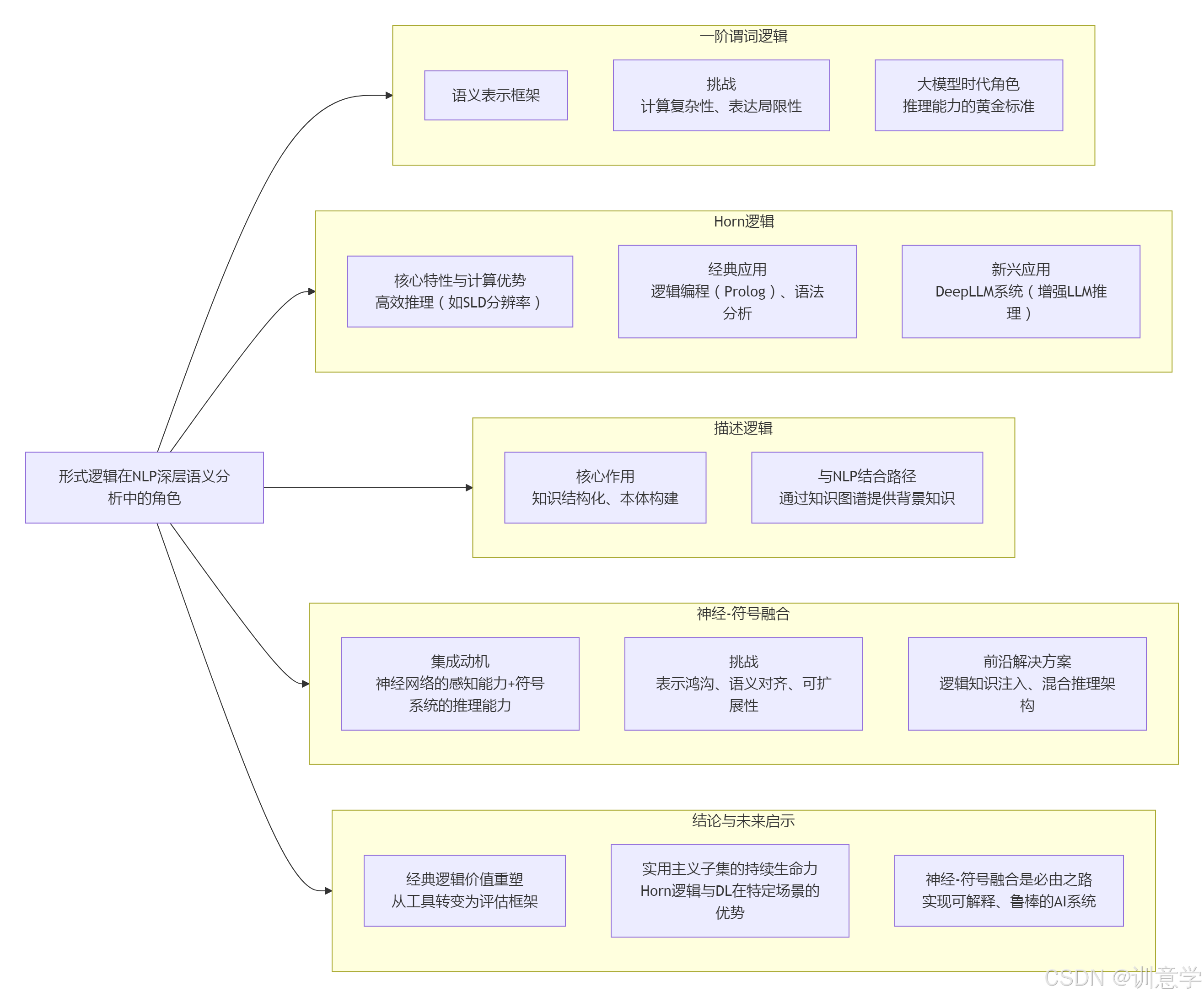

本文探讨了一阶谓词逻辑及其子集(Horn逻辑和描述逻辑)在自然语言处理(NLP)深层语义分析中的关键作用。随着大型语言模型(LLM)的发展,深层语义分析仍面临逻辑一致性、可解释性和复杂推理等挑战。一阶逻辑为语义表示提供理论基础,但存在计算复杂性和表达局限性;Horn逻辑凭借高效推理能力,正被用于增强LLM的深度推理;描述逻辑则通过构建结构化知识图谱,为NLP提供背景知识。未来趋势在于神经-符号系统

引言与核心摘要

随着大型语言模型(LLM)的兴起,自然语言处理(NLP)领域在近年来取得了革命性的进展。然而,要实现真正意义上的“深层语义分析”——即超越表层文本匹配,达到对语言内在逻辑、复杂关系和上下文推理的精准理解——仍然是人工智能面临的核心挑战。截至2025年,业界和学术界愈发认识到,单纯依赖数据驱动的连接主义方法存在瓶颈,尤其是在逻辑一致性、可解释性和复杂推理方面 。

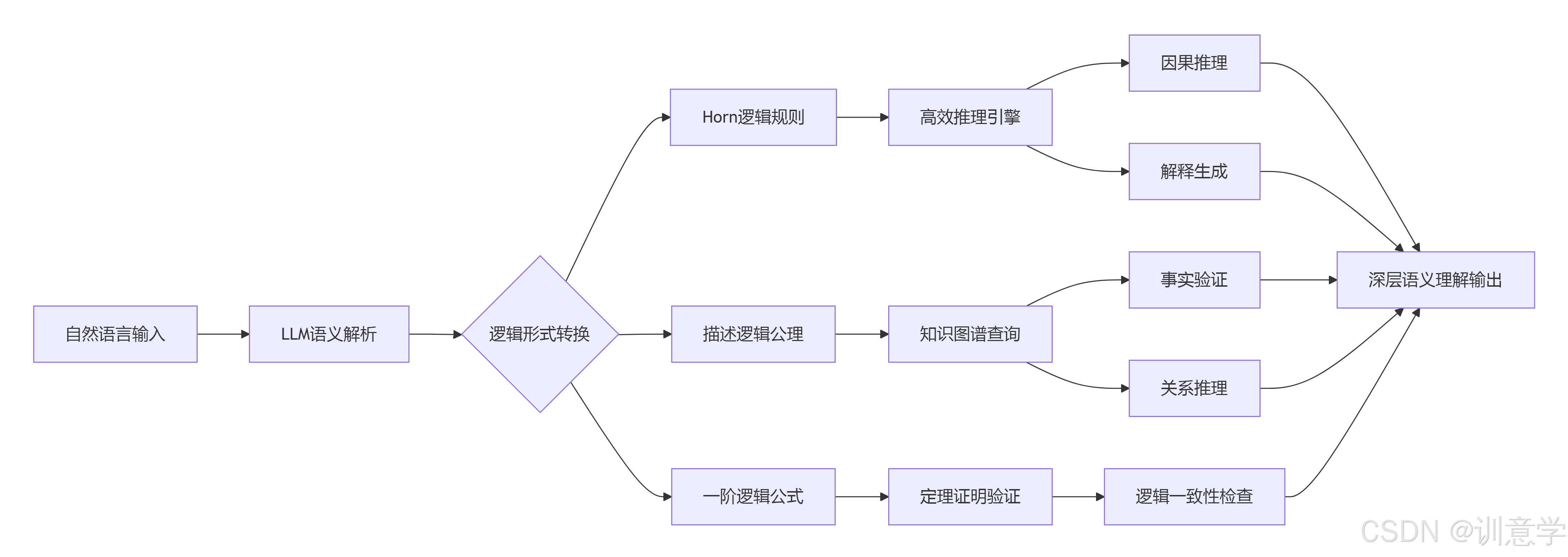

本报告旨在深入探讨形式逻辑,特别是一阶谓词逻辑(First-Order Logic, FOL)及其两个重要的计算友好型子集——Horn逻辑(Horn Logic)和描述逻辑(Description Logic, DL),在推动NLP深层语义分析方面所扮演的关键角色、带来的深远影响以及对未来研究的启示。报告将系统性地梳理这些逻辑体系如何为机器赋予结构化的知识表示能力、严谨的推理能力,并分析它们如何与现代神经网络模型融合,共同迈向更鲁棒和智能的自然语言理解新范式。

第一部分:一阶谓词逻辑 (FOL) —— 奠定深层语义分析的理论基石

一阶谓词逻辑作为一种强大且表达力丰富的形式语言,长期以来一直是计算语义学和知识表示的核心工具 。它为将模糊、多义的自然语言转化为计算机可处理的、具有明确语义的符号表示提供了理论基础 。

1.1 FOL作为语义表示的核心框架

一阶逻辑的核心优势在于其能够精确地表达关于对象、属性和它们之间关系陈述的能力 。通过使用量词(全称量词∀和存在量词∃)、谓词、函数和常量,FOL能够将自然语言句子转换为形式化的逻辑公式,从而捕捉其核心语义。例如,句子“每个学生都喜欢一门课程”可以被表示为:

∀x (Student(x) → ∃y (Course(y) ∧ Likes(x, y)))

这种转换是深层语义分析的第一步,它将非结构化的文本转化为结构化的、可用于逻辑推理的知识 。在计算语义学中,构建句子的详细含义表示,并支持各种形式的推理任务,都高度依赖于FOL这样的形式化逻辑工具 。

1.2 应用中的挑战:计算复杂性与表达局限性

尽管FOL理论上极其强大,但在实际应用中也面临着严峻的挑战。

首先,计算复杂性是其主要障碍。一阶逻辑的推理问题是“半可解的”(semi-decidable),这意味着虽然我们可以验证一个有效的推论,但对于一个无效的推论,算法可能永远不会终止 。这种潜在的无限计算使得在开放域、大规模的NLP任务中直接应用全功能的一阶逻辑推理器变得不切实际 。

其次,表达能力的局限性也日益凸显。标准的FOL难以处理自然语言中普遍存在的复杂现象,如时态、模态(可能性、必然性)、广义量词(如“大多数”、“几个”)以及话语层面的指代关系 。虽然可以通过非标准逻辑或高阶逻辑进行扩展 但这通常会进一步加剧计算的复杂性。

1.3 在大语言模型时代的再审视:作为推理能力的“黄金标准”

进入2025年,随着GPT系列等大型语言模型的普及,一个新的研究方向是评估和提升这些模型内隐的逻辑推理能力。研究发现,尽管LLM在许多NLU任务上表现出色,但它们在严格的一阶逻辑推理方面存在显著弱点,难以保持逻辑一致性 。

为了系统性地诊断这些缺陷,研究社区开发了专门的基准数据集,如 FOLIO 和 LogicNLI 。这些基准要求模型理解并推理基于一阶逻辑的自然语言陈述,从而将FOL定位为衡量现代AI模型深度推理能力的“黄金标准”。这标志着FOL的角色正从一个直接的实现工具,转变为一个关键的评估框架和理论指导,推动着下一代NLP模型的发展。

第二部分:Horn逻辑 —— 从高效推理到赋能LLM的实用主义路径

Horn逻辑是一阶逻辑的一个重要子集,它通过限制公式的结构(最多只包含一个正文字),极大地提升了计算效率,使其成为连接理论逻辑与实际应用的关键桥梁 。

2.1 Horn逻辑的核心特性与计算优势

Horn逻辑的公式,即Horn子句(Horn Clauses),是逻辑编程语言Prolog的基础 。其最大的优势在于推理的高效性。基于Horn子句的推理过程(如SLD-分辨率算法)是完备的,并且在许多情况下可以非常高效地执行,甚至在命题逻辑层面,其蕴含问题的求解可以在线性时间内完成 。这种良好的计算特性使其在自动定理证明、数据库查询和专家系统等领域得到了广泛应用 。

2.2 在NLP中的经典应用:逻辑编程与语法分析

在NLP领域,Horn逻辑通过Prolog等语言得到了早期且成功的应用。

- 知识表示:许多早期的NLP系统使用类似Prolog的Horn子句作为其核心的意义表示语言 。例如,DCKR(Definite Clause Knowledge Representation)方法就使用Prolog中的Horn子句来描述对象和语义信息 。

- 语法与语义整合分析:逻辑语法,特别是确定性上下文无关文法(DCG),是Horn子句在句法分析中的一个著名应用 。它允许在解析句子的同时,通过合一(unification)机制构建其逻辑形式(语义表示),从而将句法和语义处理无缝地结合在一个基于Horn子句定理证明器的框架中 。

2.3 新兴应用案例:为大型语言模型注入深度推理能力

在2025年的前沿研究中,Horn逻辑正被重新发掘,用于解决现代LLM面临的深度推理难题。一个极具代表性的案例是 DeepLLM 系统 。该系统创新地将LLM的对话线程转换为逻辑程序(即一组Horn子句),然后利用一个高效的Horn子句解释器(其灵感来源于SLD-分辨率)来进行深度、逐步的因果推理和解释 。

这种方法展示了Horn逻辑的现代价值:它不仅能作为一个高效的推理引擎,还能为LLM的“黑箱”决策过程提供一个结构化、可解释的框架。通过将对话的语义内容映射到Horn子句规则上,系统能够执行传统LLM难以完成的多步推理任务,如进行因果溯源或在推荐系统中提供有理有据的解释 。这表明,Horn逻辑作为一种轻量级、高效的推理工具,在与LLM结合的混合智能系统中具有巨大的应用潜力。

第三部分:描述逻辑 (DL) —— 构建结构化知识图谱以深化语义理解

描述逻辑是另一类广为人知的一阶逻辑可判定子集,它在表达能力和推理复杂性之间取得了精妙的平衡 。DL专注于描述概念(Classes)、角色(Properties)以及个体(Individuals)之间的关系,是构建本体(Ontologies)和语义网(Semantic Web)的理论基石 。

3.1 描述逻辑的核心作用:知识的结构化与形式化

与关注一般性推理的Horn逻辑不同,描述逻辑的核心价值在于提供一种结构化的方式来形式化特定领域的知识。通过DL,研究人员可以创建复杂的概念层次结构(如“猫是哺乳动物,哺乳动物是动物”),定义角色间的关系(如“has_pet”的定义域是“Person”,值域是“Animal”),并对知识库进行自动一致性检查、分类和实例检测 。

3.2 DL与NLP深层语义分析的结合路径

尽管搜索结果中鲜有DL直接用于NLP句子级别深层语义分析的案例,但其影响是间接而深远的,主要通过 知识图谱(Knowledge Graphs) 这一媒介。

-

为NLP提供背景知识:基于DL构建的知识图谱(如DBpedia, YAGO)可以为NLP模型提供丰富的、结构化的世界知识和常识。当模型处理文本时,可以通过实体链接等技术将文本中的实体与知识图谱中的节点关联起来,从而获取该实体的属性、类别和与其他实体的关系。这极大地增强了模型对文本的深层理解,尤其是在处理需要背景知识的问答、关系抽取和文本摘要任务时 。

-

约束和验证NLP的输出:NLP模型(特别是生成式LLM)的输出可能存在事实性错误或逻辑矛盾。一个基于DL的知识库可以作为一个“事实检验器”,用于验证模型生成内容的合理性。例如,如果模型生成“奥巴马出生在肯尼亚”,知识图谱可以迅速查询到“奥巴马”的“出生地”属性并发现矛盾,从而提高系统的可靠性。

-

构建领域专属的语义理解系统:在金融、医疗、法律等专业领域,深层语义分析高度依赖于精准的领域知识。利用描述逻辑构建这些领域的本体,可以为NLP系统提供一个坚实的语义框架,帮助其准确理解领域术语、实体关系和业务规则 。

第四部分:神经-符号融合 —— 迈向下一代深度语义分析的必然趋势

截至2025年,一个清晰的共识是,单纯的符号逻辑或单纯的神经网络都无法独自完美解决深层语义分析问题。未来在于二者的深度融合,即 神经-符号系统(Neural-Symbolic Systems) 。一阶逻辑及其子集在这一新兴范式中扮演着符号端的核心角色。

4.1 集成动机:优势互补

神经-符号集成的核心思想是结合连接主义(神经网络)和符号主义(逻辑)的优点 :

- 神经网络擅长从大规模非结构化数据中学习模式、处理噪声和模糊性,并生成分布式的语义表示(词嵌入) 。

- 逻辑系统提供严谨的推理能力、可解释性、模块化以及对抽象知识的强大表示能力 。

通过融合,我们期望构建出既能像神经网络一样从数据中学习,又能像逻辑系统一样进行可靠推理和解释的AI系统。

4.2 主要挑战

这种集成并非易事,面临诸多理论和工程上的挑战 :

- 表示鸿沟:如何有效地连接神经网络的连续、高维向量空间与逻辑系统的离散、符号表示 。

- 学习与推理的统一:如何设计一个统一的框架,使得逻辑推理过程本身可以被端到端地学习和优化。

- 可扩展性:如何在保持逻辑严谨性的同时,将系统扩展到大规模、开放领域的真实世界数据。

- 语义对齐:如何确保神经网络学习到的概念与符号逻辑中预定义的概念在语义上是一致的 。

4.3 前沿解决方案与研究趋势

针对上述挑战,学界已探索出多种融合路径:

-

逻辑知识注入 (Logic Injection) :这类方法尝试将符号化的逻辑规则“编译”或“注入”到神经网络的结构或学习过程中。例如, Deep Adaptive Semantic Logic (DASL) 这样的框架尝试将用户提供的专家知识(可能包括一阶逻辑或描述逻辑规则)编译进深度神经网络,以此来指导和约束模型的学习过程,提高其泛化能力和鲁棒性 。

-

混合推理架构 (Hybrid Reasoning Architectures) :这类系统采用“分而治之”的策略。一个神经模块负责从原始文本中进行感知和语义解析(如生成语义表示或逻辑形式),然后将结果传递给一个独立的符号推理引擎(如一阶逻辑定理证明器或Horn逻辑解释器)来执行复杂的、多步的逻辑推理 。例如,LINC 方法结合了LLM和一阶逻辑定理证明器来提升逻辑推理能力 ,而前述的 DeepLLM 也是这一思想的典范。

-

神经概率逻辑编程 (Neuro-Probabilistic Logic Programming) :这些更前沿的框架(如DeepProbLog)试图在一个统一的概率模型中同时表示神经网络的计算和逻辑规则的推理,从而实现端到端的学习和概率推理,更好地处理不确定性 。

结论与未来启示

本文章系统分析了一阶谓词逻辑及其子集Horn逻辑和描述逻辑在NLP深层语义分析中的作用。截至2025年9月,我们可以得出以下结论与启示:

-

经典逻辑的价值重塑:一阶谓词逻辑虽然因计算复杂性而难以直接大规模应用,但它作为语义表示的理论基础和评估现代AI模型推理能力的“试金石”,其重要性不减反增。

-

实用主义子集的持续生命力:Horn逻辑凭借其高效的推理特性,在与大型语言模型结合的混合系统中找到了新的用武之地,成为增强LLM深度推理和可解释性的有力工具。描述逻辑则通过构建结构化的知识图谱,为NLP模型提供了不可或缺的背景知识和事实约束,是实现知识驱动型语义理解的关键。

-

神经-符号融合是通往强人工智能的必由之路:未来的深层语义分析系统必然是逻辑推理与数据学习深度融合的产物。将一阶逻辑、Horn逻辑、描述逻辑等符号系统的结构化、可解释性优势,与神经网络的强大感知和学习能力相结合,是克服当前纯数据驱动方法瓶颈、实现更鲁棒、更可信、更智能的自然语言理解的最终方向。

未来的研究应继续深化神经-符号的集成方法,探索更高效的表示对齐技术、开发可微分的逻辑推理模块,并构建更大规模、更丰富的、与逻辑系统兼容的基准和数据集,从而推动人工智能在真正理解人类语言的道路上迈出坚实的一步。

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)