ollama安装及设置

如果需要修改访问端口,可以在OLLAMA_HOST后直接添加端口如:0.0.0.0:8080,默认是11434。,即只能本地访问127.0.0.1。如果要让局域网内其他设备访问 Ollama 服务,需要将。来指定监听的地址,默认情况下,它只监听。Ollama 服务使用环境变量。

·

一、从ollama官网下载并安装,在此不进行赘述

二、设置环境变量

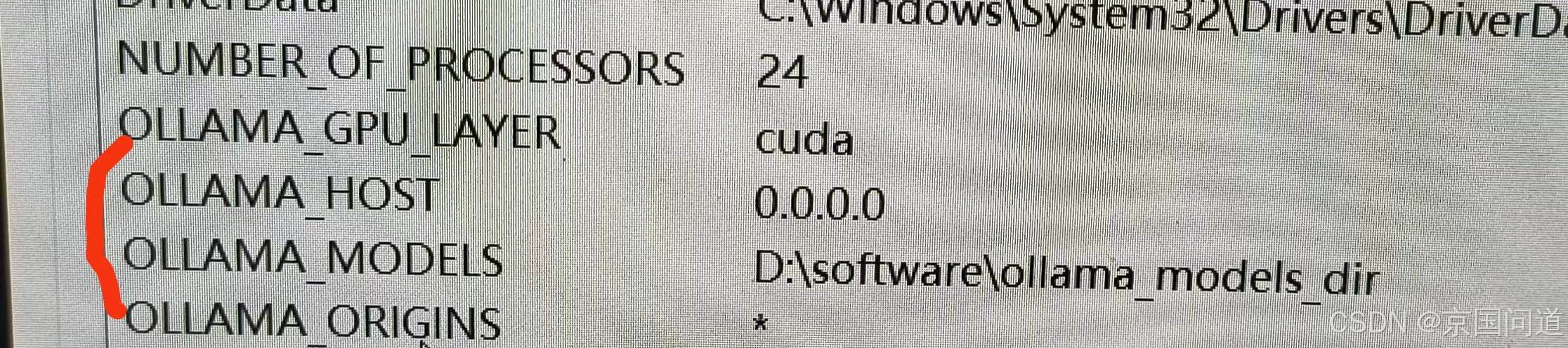

ollama最主要的是两个环境变量:

- OLLAMA_MODELS:指定下载模型的存放路径,不设置将会放在默认目录,例如C盘。

- OLLAMA_HOST:指定ollama运行时绑定ip,不设置只能本地访问。

Ollama 服务使用环境变量 OLLAMA_HOST 来指定监听的地址,默认情况下,它只监听 localhost,即只能本地访问127.0.0.1。如果要让局域网内其他设备访问 Ollama 服务,需要将 OLLAMA_HOST 设为 0.0.0.0。

如果需要修改访问端口,可以在OLLAMA_HOST后直接添加端口如:0.0.0.0:8080,默认是11434。

OLLAMA_GPU_LAYER变量值:cuda(NVIDIA)或directml(AMD/Intel)- (可选)强制指定 GPU 设备(多 GPU 时): 变量名:

CUDA_VISIBLE_DEVICES变量值:0(使用第一个 GPU) - 为了允许浏览器调用 Ollama 的 API,您需要设置跨域访问

- OLLAMA_ORIGINS 值为*

- OLLAMA_ORIGINS:配置允许跨域请求的来源列表。默认包含

localhost、127.0.0.1、0.0.0.0等本地地址以及一些特定协议的来源。通过设置此变量,可以指定哪些来源可以访问 Ollama 服务,例如OLLAMA_ORIGINS=*,https://example.com允许所有来源以及https://example.com的跨域请求。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)