用ollama本地部署deepseek最详细图文教程

用ollama本地部署deepseek

1.

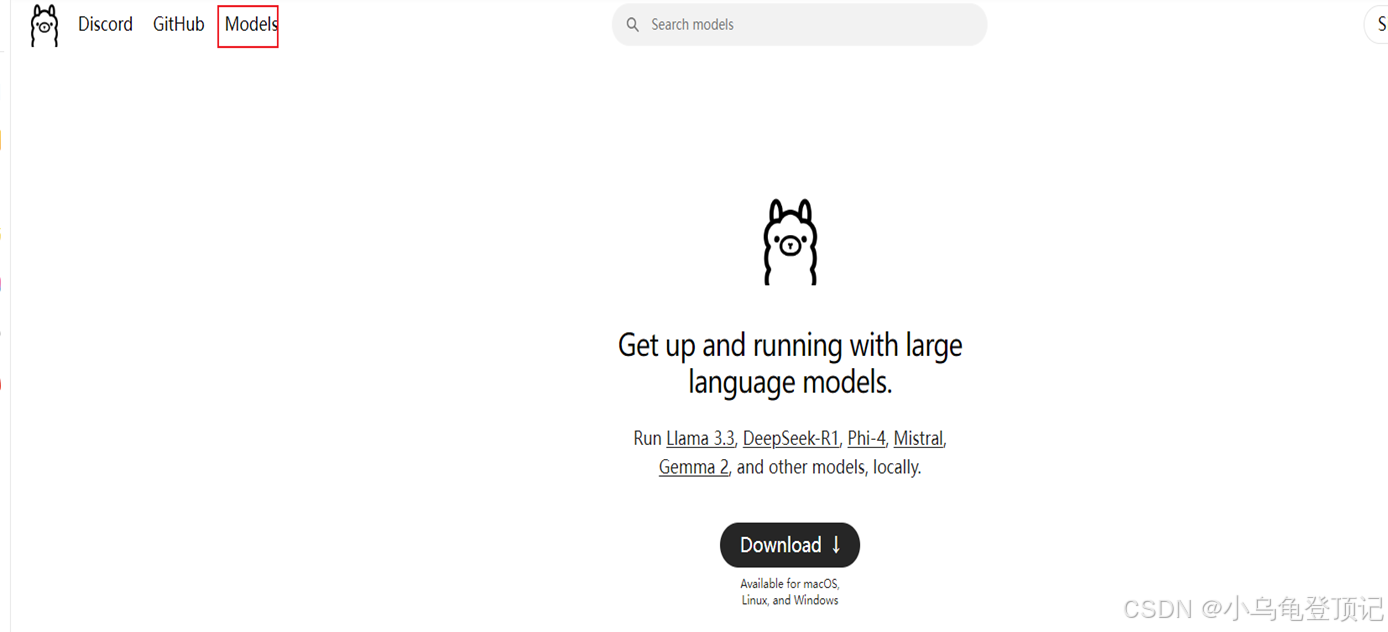

先从ollama 官网下载安装程序

官方网址:Ollama

进去之后点击Download下载windows版本的即可

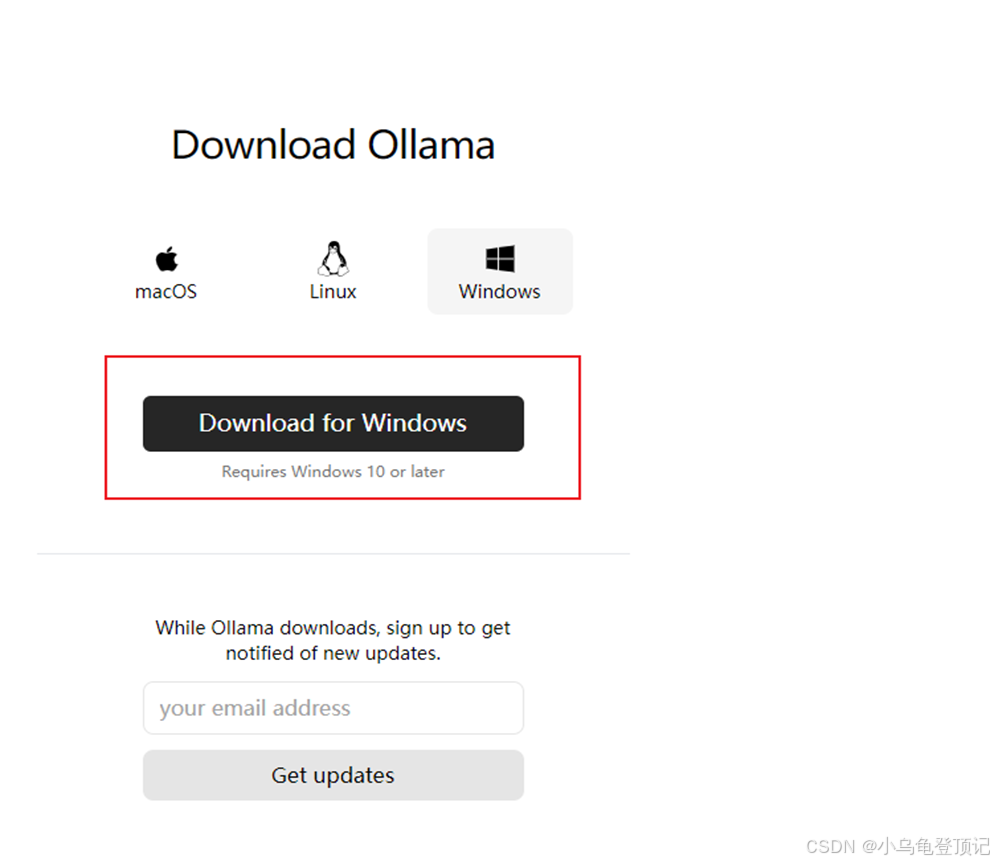

2.一般都下载windows版本

3.下载完成之后就是一个安装包,直接双击运行也可以,但是默认是装在C盘的

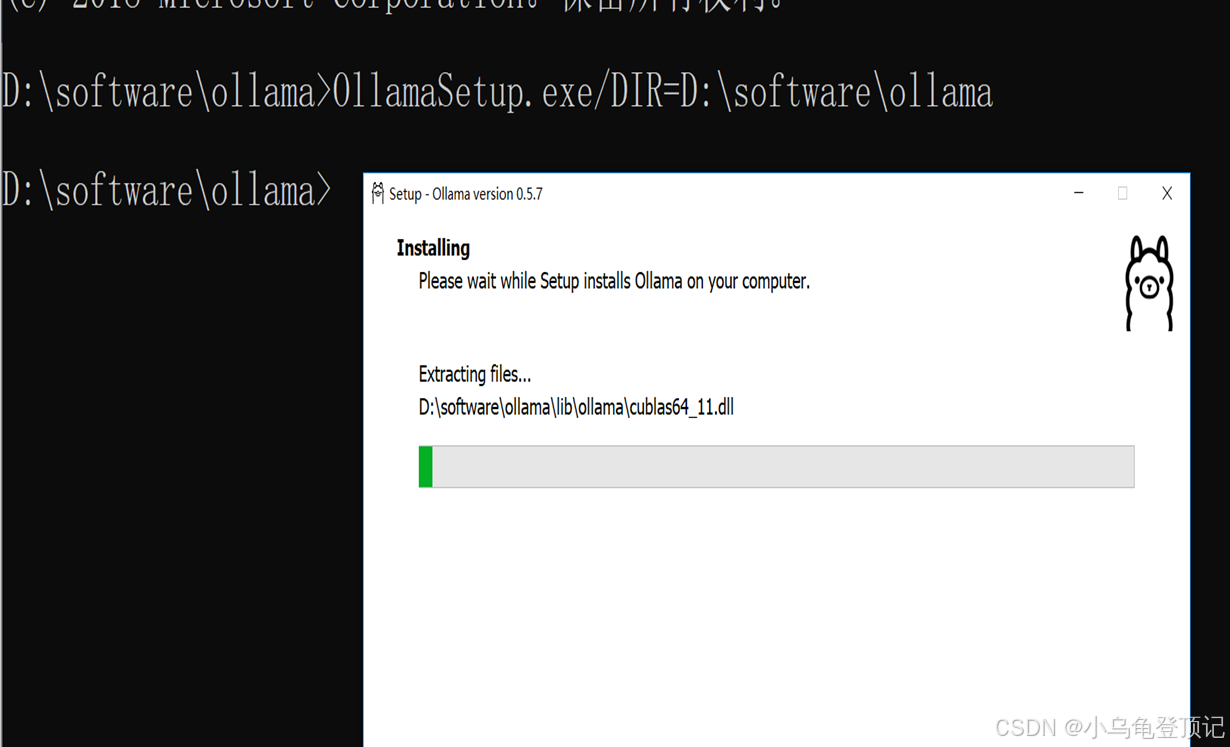

如何将ollama安装到别的盘符我这里演示装到D盘如下位置:

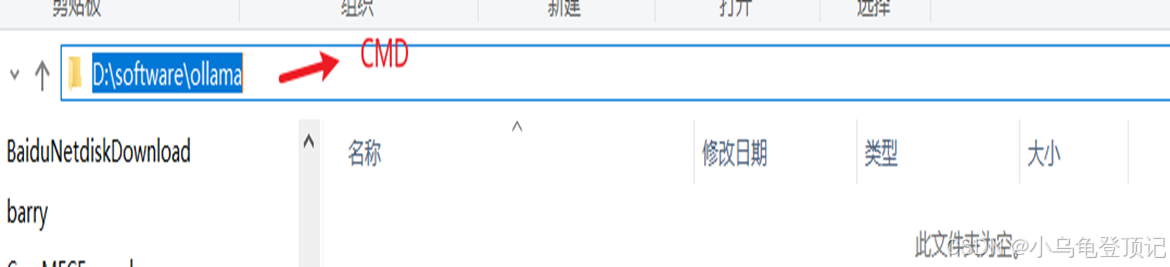

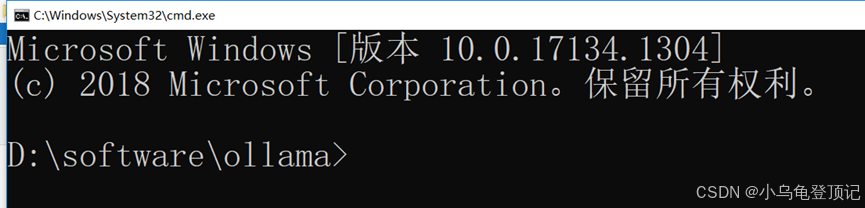

找到这个位置,在如下位置输入CMD

此时CMD 的执行目录就是在当前路径下,当然也可以通过别的方法来指定cmd的执行路径

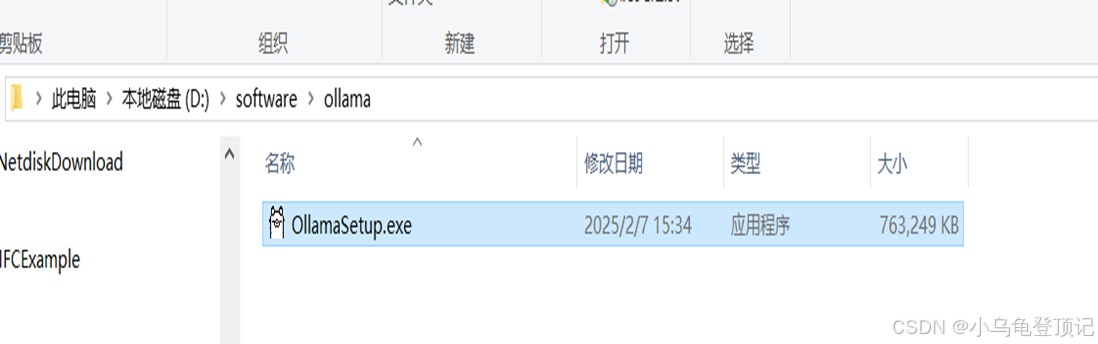

4.把ollama 安装包拷到此路径下

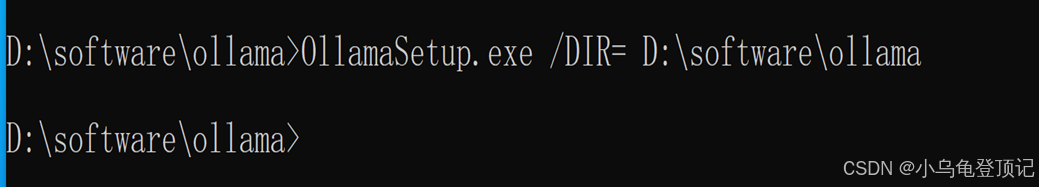

5.执行如下命令 OllamaSetup.exe/DIR=D:\software\ollama

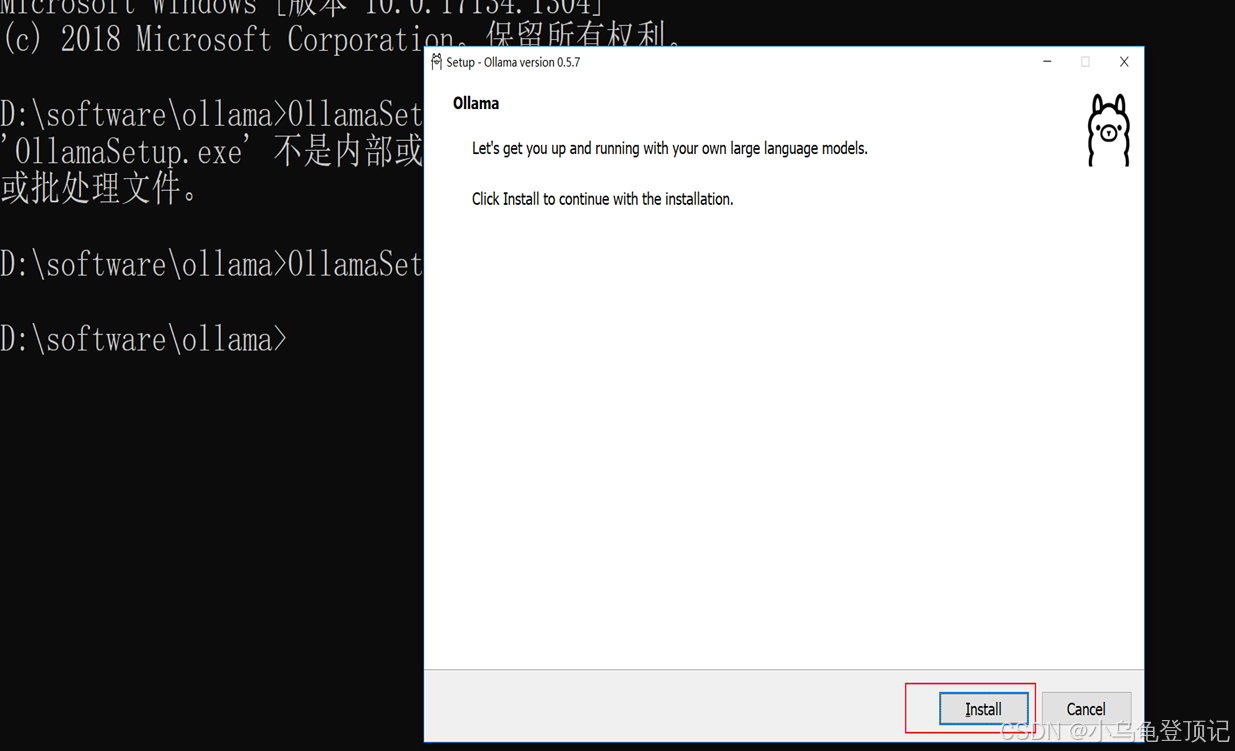

6.会弹出安装对话框点击install安装

7.进行安装

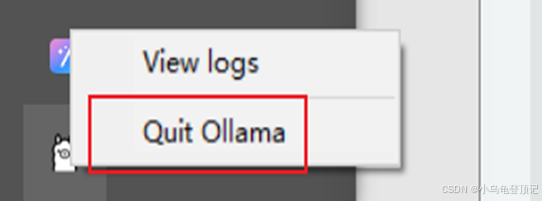

8.安装完成之后可以看到下方有一个ollam的运行图标,默认是运行的状态,也可以右击 选择退出

9.

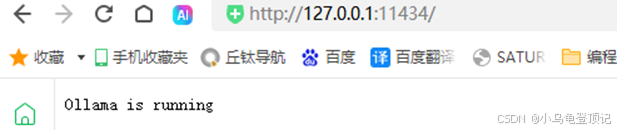

也可以在浏览奇中输入http://127.0.0.1:11434/,来查看ollama是否处于一个开启的状态

会看到如下的提示

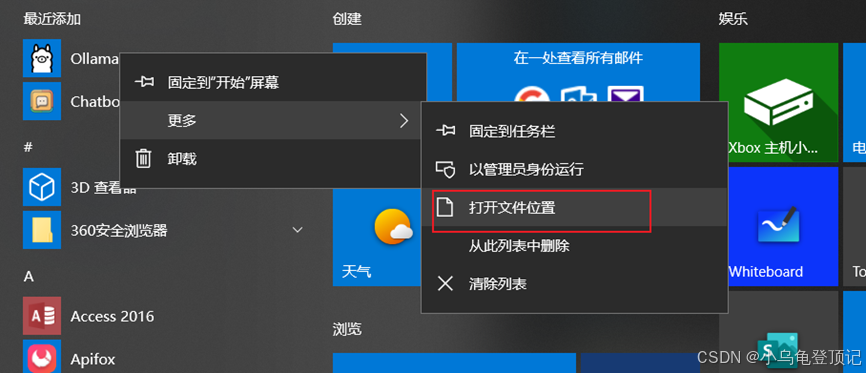

10.退出的ollama 如何在重新启动,打开windows菜单栏单机ollama就可以启动ollama

11.Ollama 默认是一个自启动的状态,我们可以关闭ollama的自启动功能,这样会减少计算机的内存

12.

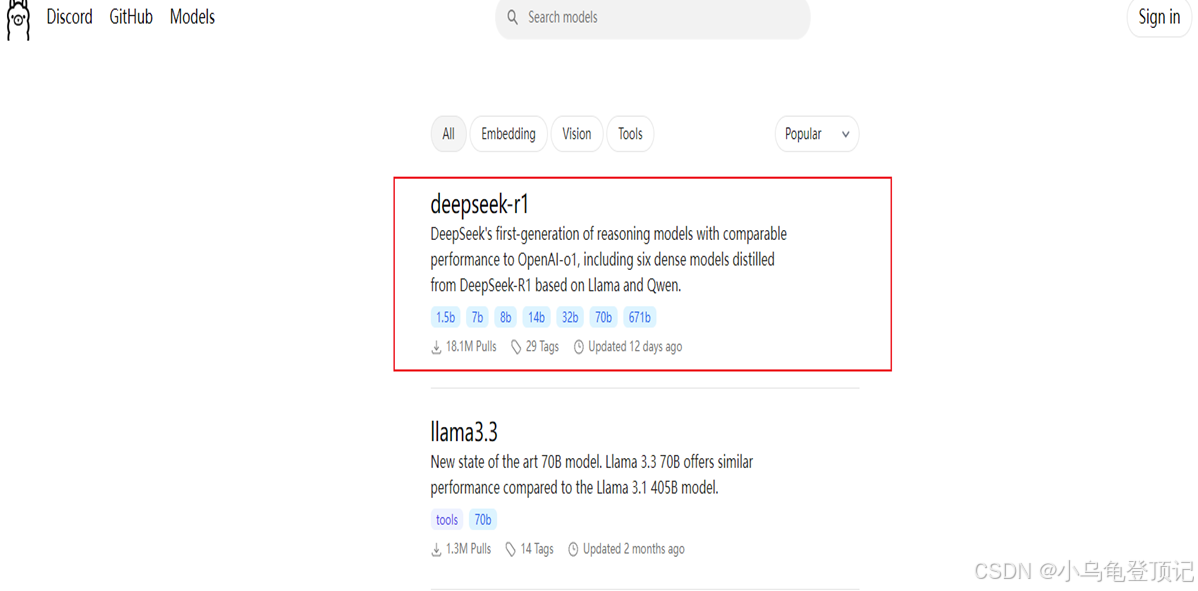

开始下载部署deepseek

在ollama的官网我们可以查看目前ollama支持哪些模型

13.点开可以看到deepseek 就排在第一个,这里有deepseek 不同参数的模型,1.5b基本上什么电脑都能部署,但是相对来讲比较弱智,7b和8b 拥有独立显卡的基本上也能部署,效果日常对话没啥问题,只能说差强人意,假如独显较好,拥有8g显存,都可以部署14b,假如是顶级消费显卡,那可以尝试32b,70b土豪可以尝试

14.

14.1

确认ollama 处于运行状态

Win+R 呼出运行窗口,输入cmd 呼出控制台命令行输入窗体

14.2

输入下面的命令

ollama run deepseek-r1:1.5b

14.3

按回车确认

14.4

ollama就会开始拉取deepseek-r1 1.5b 版本

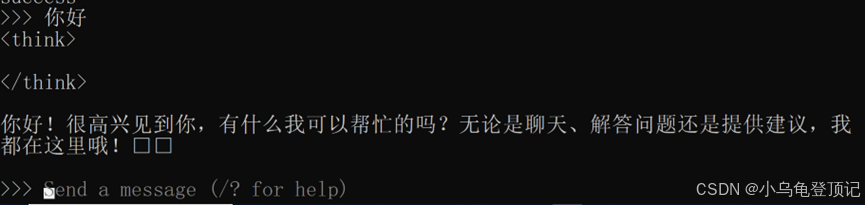

14.5

全部拉取成功

14.6

可以直接进行聊天

15.

列几个常用的ollama命令:

a.运行模型:ollama run 模型名

b.查看本地所有模型:ollama list

c.切换模型:ollama use 模型名(当你安装了多个模型可以切换模型)

c.删除指定模型:ollama rm 模型名

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)