解决win10下wsl无法访问主机ollama的localhost的问题

win10下,解决wsl无法访问主机中部署的ollama,无法访问localhost地址问题。

·

最近在wsl中部署了openwebui,在主机中部署了ollama,准备跑本地大模型,但是wsl无法获取主机的localhost:11434端口,而且win10无法通过镜像网络来使用wsl,强行开启将报错:

wsl: Hyper-V 防火墙不受支持

wsl: 不支持镜像网络模式: Windows 版本 19045.5737 没有所需的功能。

正在回退到 NAT 网络。

以下是我的环境:

PS C:\Windows\system32> wsl -v

WSL 版本: 2.4.13.0

内核版本: 5.15.167.4-1

WSLg 版本: 1.0.65

MSRDC 版本: 1.2.5716

Direct3D 版本: 1.611.1-81528511

DXCore 版本: 10.0.26100.1-240331-1435.ge-release

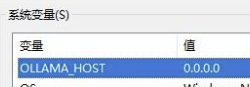

Windows 版本: 10.0.19045.5737考虑通过直接访问主机ip来实现,首先请确保wsl中能够ping通主机(局域网IPV4地址),通过添加系统环境变量

OLLAMA_HOST 为 0.0.0.0:11434之后重启ollama服务。

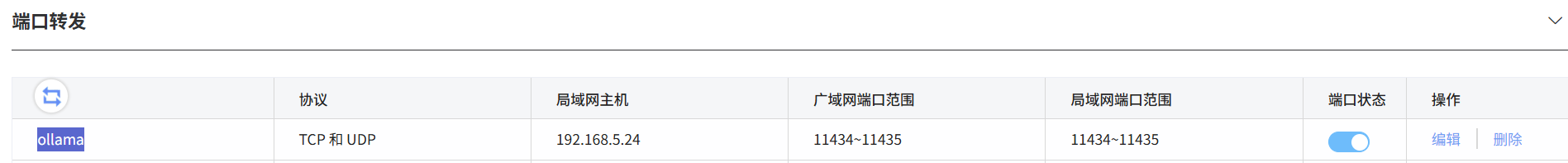

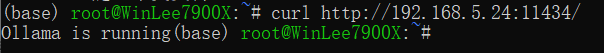

一般来说,wsl中已经可以通过ip地址访问ollama了,例如192.168.5.24:11434,如果想在局域网别的主机调用ollama,可以考虑再到路由器设置页面,设置本机的端口转发

然后大功告成。这个在家里用是ok的,在公司大局域网里就不太行。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)