【开发心得】Dify部署ollama模型的坑[2]

现在回想起来,感觉这个坑大概有两个原因:1、llama3不支持Jason格式的输出,至始至终都没有任何输出结果;2、猜想是服务器算力不够,没有GPU导致llama3罢工了。从一个现象可以猜想的出来,去掉了要求jason输出的要求,也依然没有输出;不知道大家是否碰到过类似的问题,欢迎留言。

目录

数据训练与自动化工作流

接着上次的说,使用Dify私有化部署ollama以后,一直在研究如何把私有化数据进行训练,能够在日常工作中做部分人工替代的工作。比如使用工作流的方式,来实现一些业务逻辑,最简单的工作流就是下面这个了,Dify只要你选择工作流,就很容易创建了。

而且,即使一开始选择的是聊天助手方式,也依然可以转换成工作流模式,这一点,Dify做的非常好。

又一个坑出现

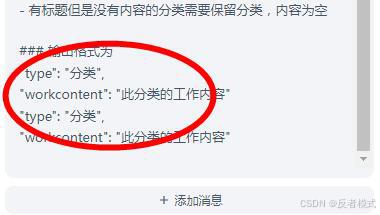

既然是探索,踩坑就是必然的。这次又碰到了一个坑。先看下图:

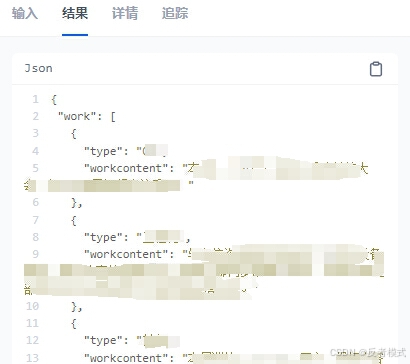

这次的探索很简单,就是给一段文字,让AI进行整理并分类总结。

只看运行输出的内容,你是不是认为输出的这个Jason格式正常,只是没有内容?

我也是这么认为的,但实际上,请看下图中的LLM的prompt设置,要求输出的格式并不是Jason。

原因探究

这到底是怎么回事呢?

为了找到原因,做了以下几个步骤:

1、重启ollama,但故障依旧;

2、使用LLM的自动生成功能重写prompt,没用,依然是输出为空;

3、 改变用户的输入内容,仍然没有输出;

先解决问题

百思不得其解的情况下,只好换千问模型试了一下,没想到竟然成功输出内容了。

思考总结

现在回想起来,感觉这个坑大概有两个原因:

1、llama3不支持Jason格式的输出,至始至终都没有任何输出结果;

2、猜想是服务器算力不够,没有GPU导致llama3罢工了。从一个现象可以猜想的出来,去掉了要求jason输出的要求,也依然没有输出;

不知道大家是否碰到过类似的问题,欢迎留言。

好在大模型有很多,这个不行,就换掉,不能在一个问题上浪费太多时间。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)