IntelliJ IDEA 接入 Ollama 本地模型 Qwen-coder

Ollama本地部署与使用指南:1)从官网下载安装包,可自定义安装路径(如D:\Ollama);2)设置环境变量修改模型存储位置和访问端口;3)通过命令行下载模型(支持断点续传);4)运行ollama run启动模型;5)在IDEA中安装ProxyAI插件并配置Ollama连接,即可在开发环境中使用本地大语言模型。注意下载模型时若网速过慢可中断后重新开始,系统会继续上次进度。

·

一:下载ollama

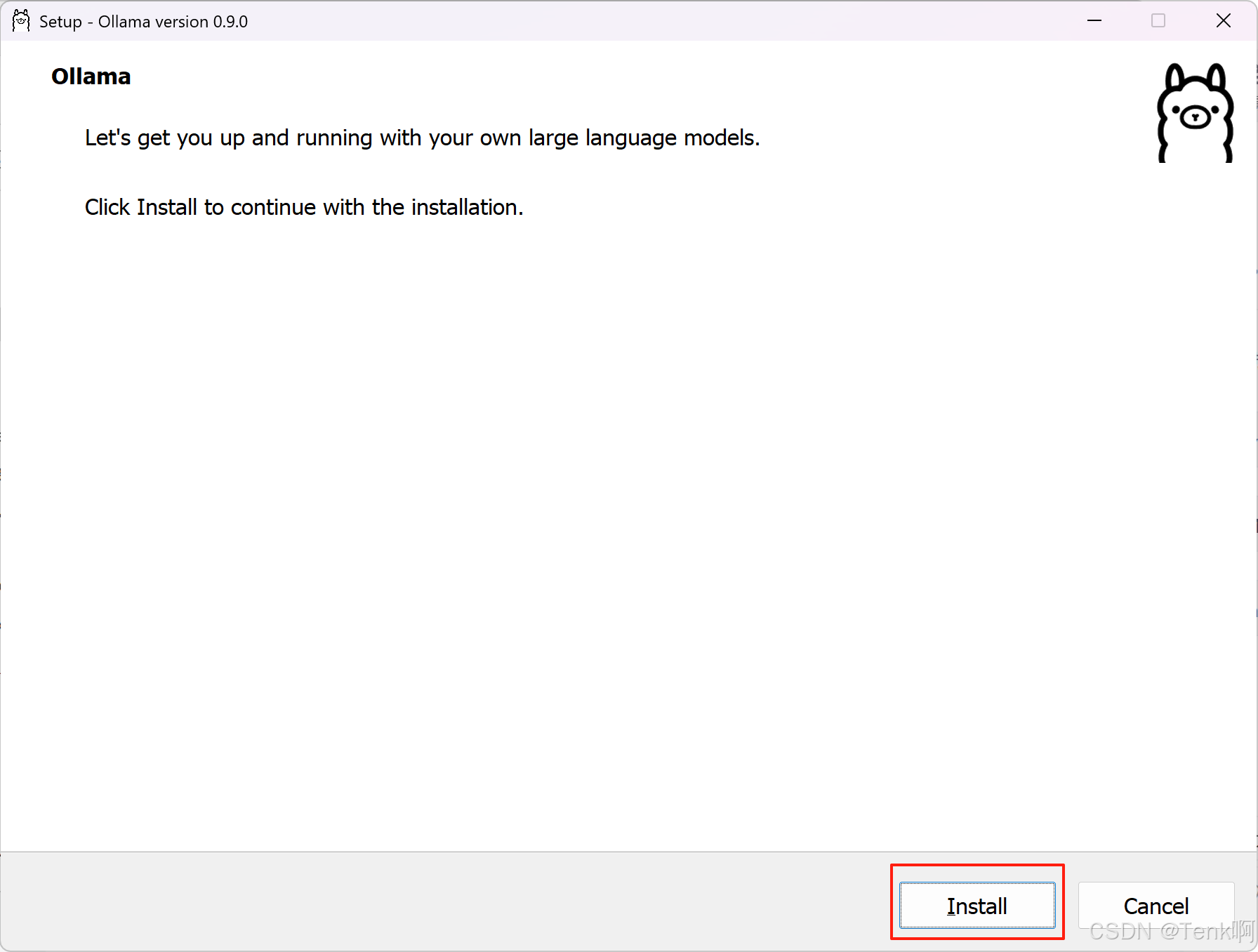

二:安装

一键自动安装,且安装的是C盘

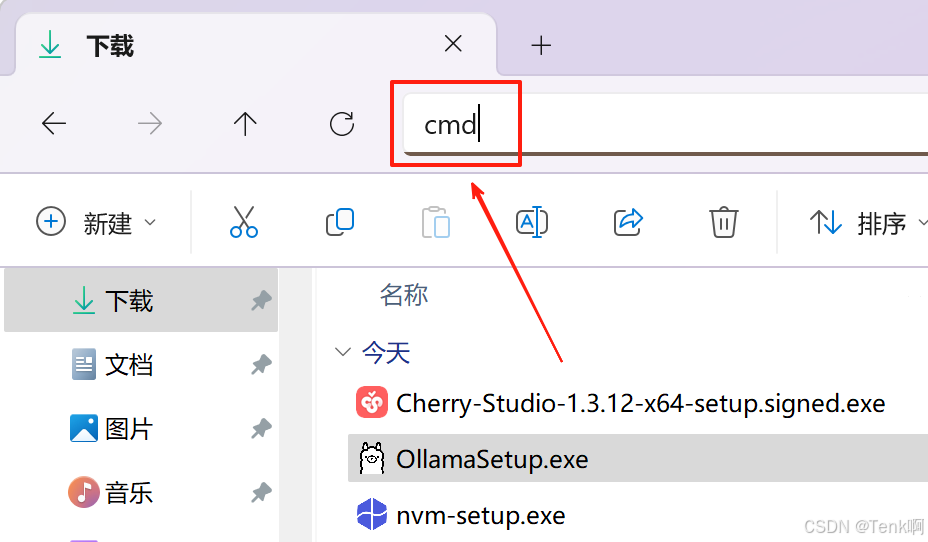

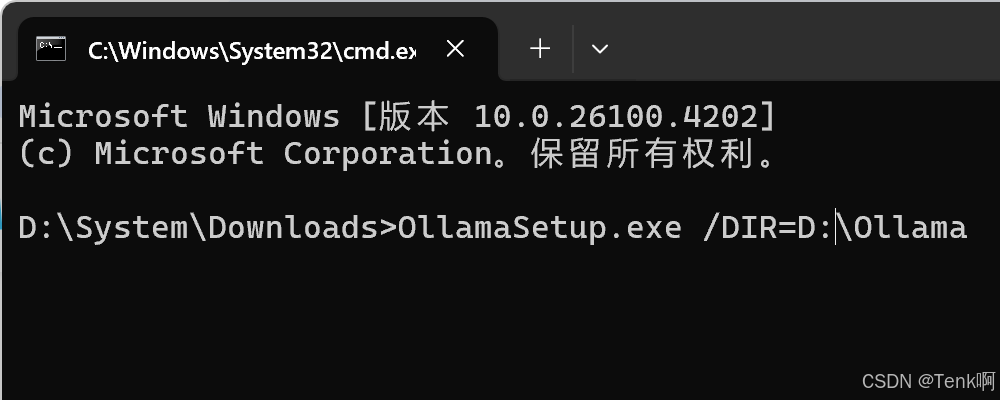

如果C盘紧张,想装在其他盘符,在安装包目录下打开cmd命令行,

在你想安装的盘下创建一个文件夹,例如在D盘创建一个名为Ollama的文件夹。使用命令行安装:将Ollama的安装包放在你创建的文件夹里,然后打开该文件夹的cmd命令行,输入:.\OllamaSetup.exe /DIR=D:\Ollama,然后安装即可。

三:下载模型

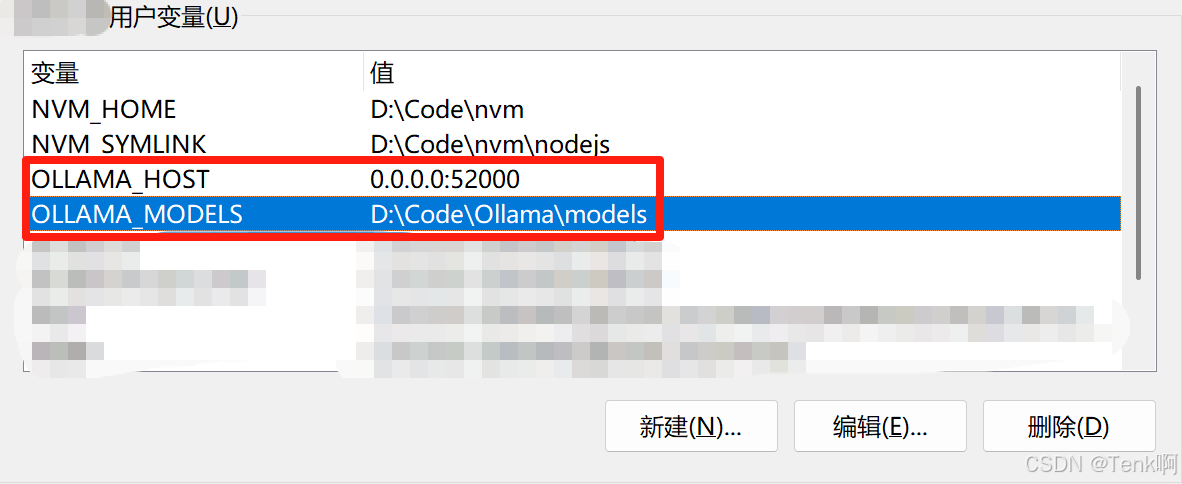

下载之前,我们还需要微调一下Ollama的配置

在系统环境变量中,新增以下两个变量

OLLAMA_MODELS:D:\Code\Ollama\models //更改模型储存位置

OLLAMA_HOST:0.0.0.0:52000 //修改端口,默认是11434,0.0.0.0表示任意ip可访问

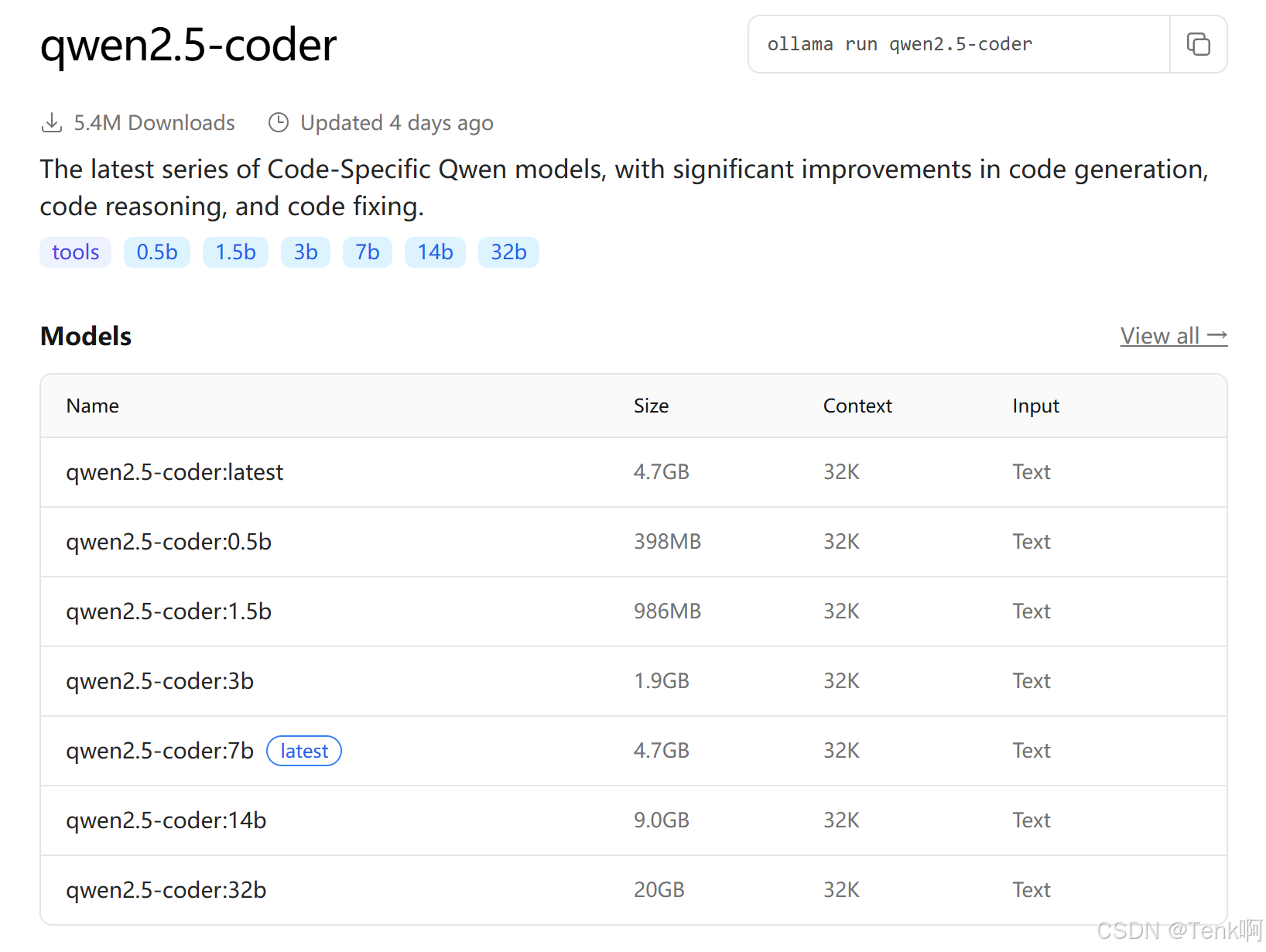

在Ollama官网搜索你想要的模型,我这里以qwen2.5-coder为例

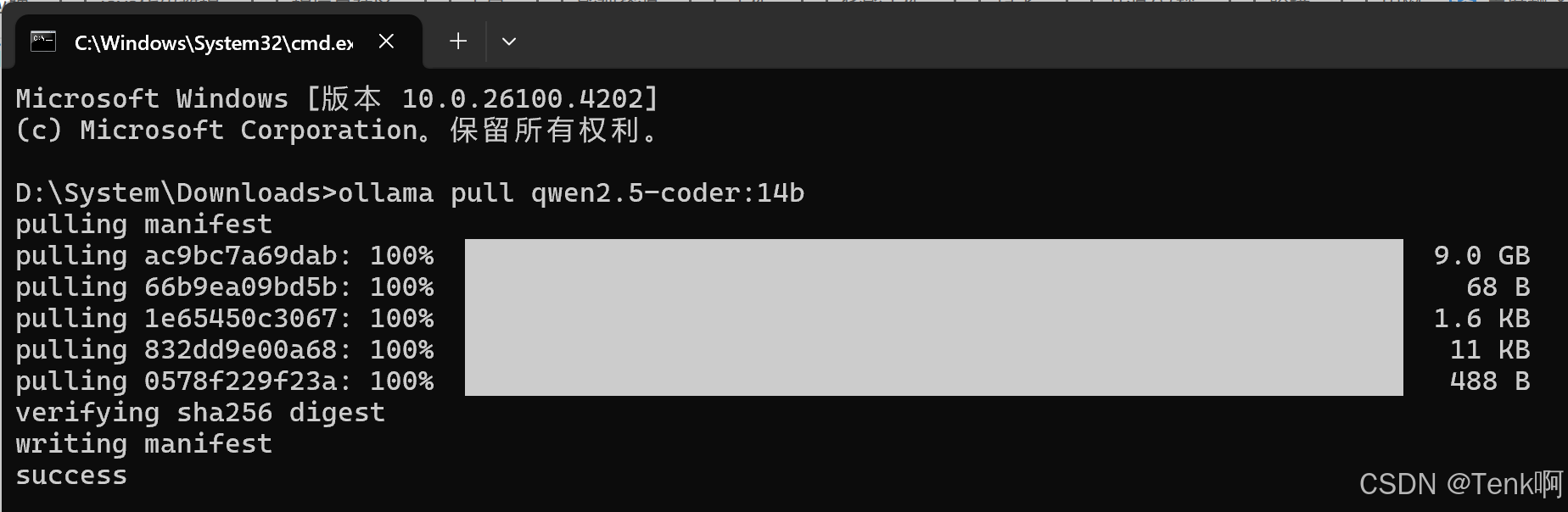

在命令行输入:ollama pull qwen2.5-coder:14b

如果遇到下载过程中,网速越来越慢,堪比百毒网盘的几kb/s,只需Ctrl+C停止下载,点击⬆️方向键,再次下载即可,ollama是有断点续传的,网速再慢,反复操作即可。

四:启动LLM模型

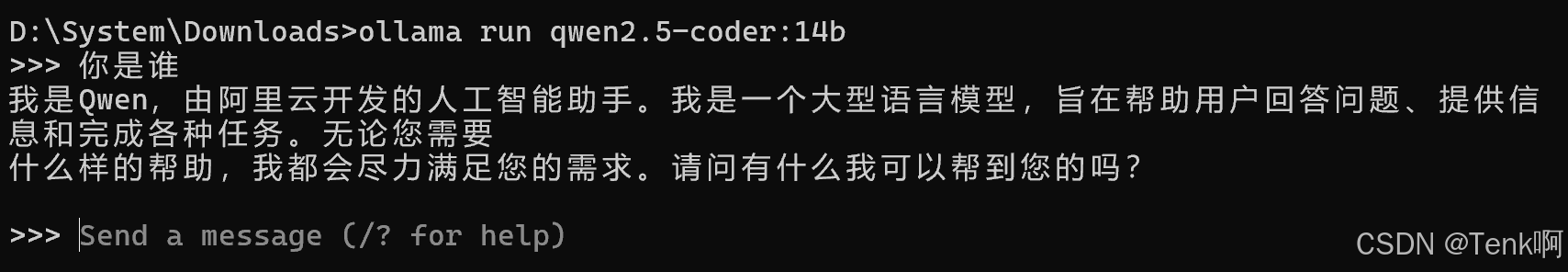

命令行输入命令:ollama run qwen2.5-coder:14b

五:接入IDEA

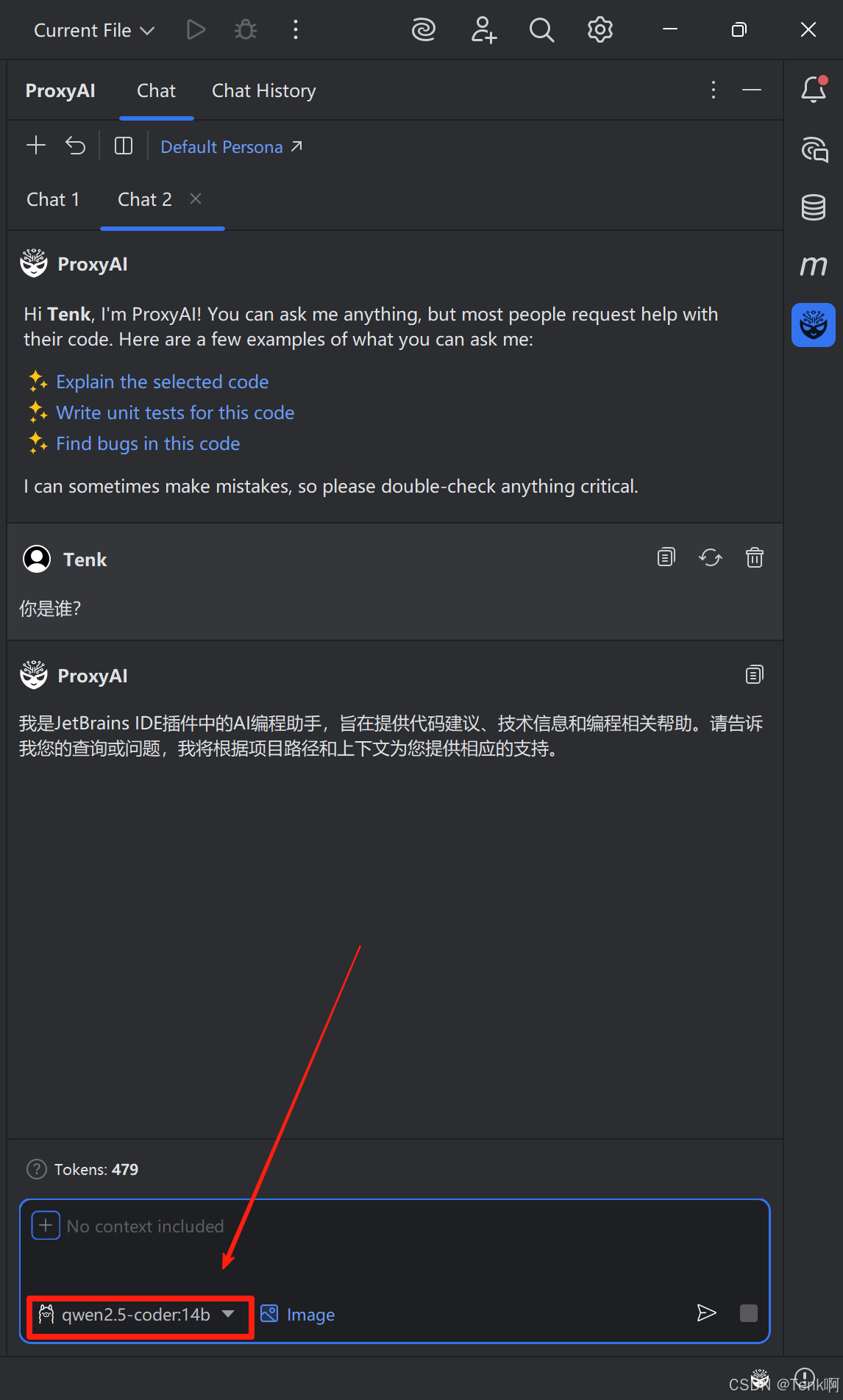

插件市场搜索:proxy ai 并安装

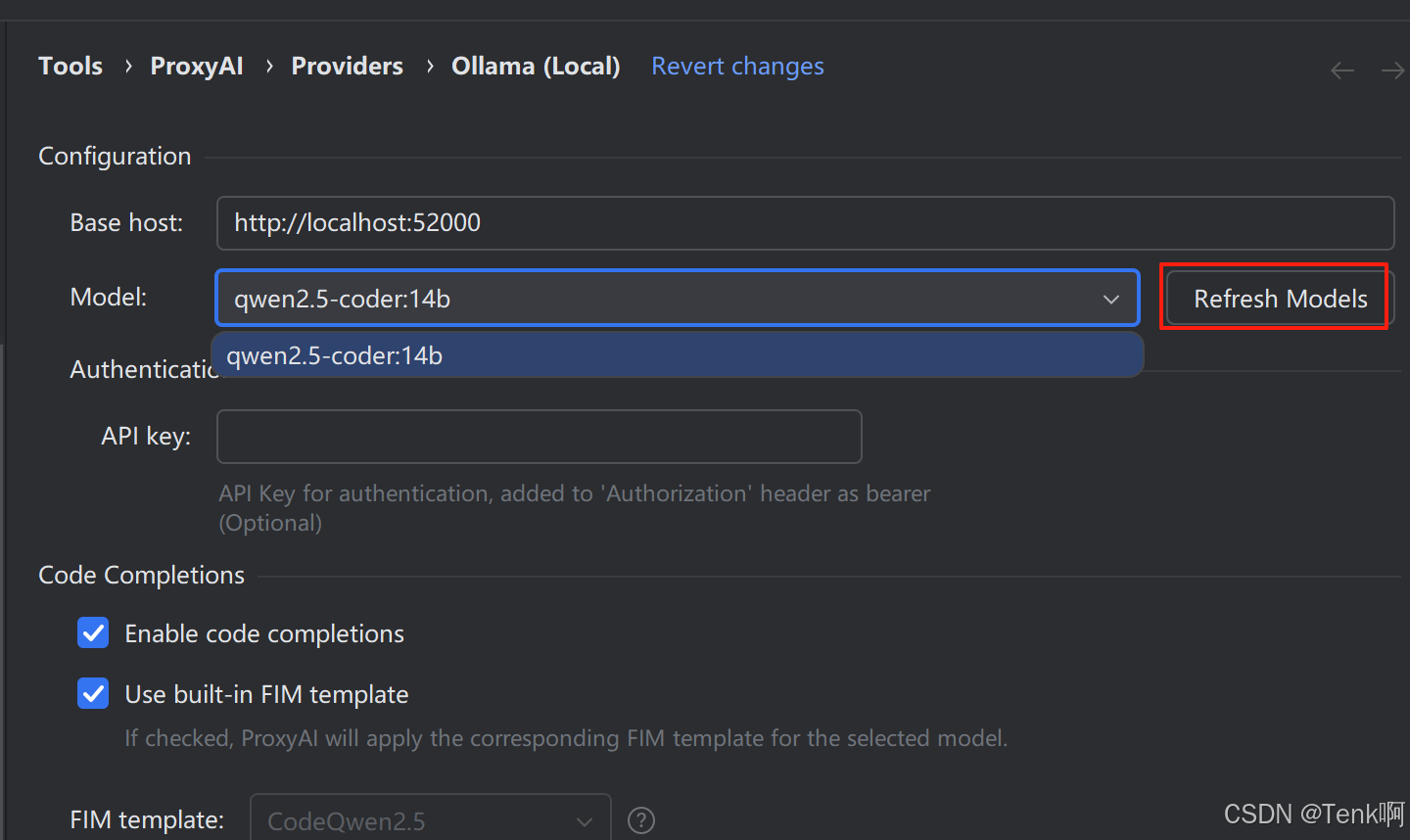

安装完成后在settings-->tools-->proxy ai-->providers-->Ollama(Local)处进行配置链接本地Ollama,配置后保存

使用效果

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)