AI语音交互:盘古大模型驱动Unity NPC对话

通过盘古大模型与Unity的深度集成,开发者可快速构建具备多轮对话、情感理解和场景自适应能力的智能NPC。本文从语音采集、ASR转文本、大模型交互到TTS与动画同步,详细讲解了全链路实现方案,并结合景区导览场景验证了技术可行性。未来,随着盘古大模型在垂直领域(如医疗、教育)的微调优化,以及Unity XR(扩展现实)技术的进步,智能对话NPC将在元宇宙、数字孪生等场景中发挥更大价值。

引言:智能对话NPC的产业需求与技术突破

在元宇宙、数字孪生、智能座舱等场景中,3D NPC(非玩家角色)的语音交互能力已成为衡量数字世界真实性的核心指标。传统NPC对话依赖预设脚本,交互生硬且缺乏灵活性;而基于大语言模型(LLM)的生成式对话,可实现多轮理解、情感共鸣和场景自适应,彻底改变用户体验。华为云盘古大模型作为国产顶尖大模型,具备多模态理解、领域适配、长程对话等优势,与Unity引擎的3D渲染、物理模拟能力结合,可快速构建高拟人化智能NPC。

本文将以“景区导览NPC”为实战场景,详细讲解如何通过盘古大模型API与Unity引擎集成,实现从语音输入、语义理解到NPC响应的全链路交互。

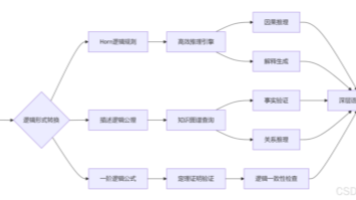

一、技术架构:盘古大模型与Unity的协同流程

1.1 核心模块拆解

- 语音输入层:通过Unity的

Microphone类或设备麦克风采集用户语音,支持移动端(Android/iOS)、PC、车机等平台。 - 语音识别(ASR)层:将音频流转换为文本,可选择华为云ASR(自动语音识别)服务,支持方言、实时转写。

- 大模型交互层:调用盘古大模型API,传入文本与对话上下文,获取语义理解结果(如意图识别、实体抽取)和生成回复。

- 对话管理层:维护多轮对话上下文(如用户历史问题、NPC已回答内容),处理上下文丢失或用户追问场景。

- 语音输出与行为层:通过TTS(语音合成)将回复转为音频,驱动NPC播放语音并同步动画(如口型、手势)。

1.2 关键接口与协议

- 盘古大模型API:通过HTTP/HTTPS调用,需申请API Key和Endpoint(华为云控制台获取)。请求参数包括

messages(对话历史)、temperature(生成随机性)、max_tokens(回复长度限制)。 - 华为云ASR API:支持流式/非流式转写,返回JSON格式的文本结果(含时间戳、置信度)。

- Unity音频系统:使用

AudioSource组件播放TTS音频,Microphone类实现录音,Animation或Animator控制NPC动作。

二、核心实现:从语音到对话的全链路开发

2.1 语音采集与ASR转文本(Unity端)

在Unity中实现语音采集,需调用设备麦克风并实时传输至ASR服务。以下是关键代码(C#):

using UnityEngine;

using UnityEngine.Audio;

using System.Collections;

using System.Text;

public class VoiceRecorder : MonoBehaviour

{

public AudioSource audioSource; // 用于播放录音(调试用)

private AudioClip recordingClip;

private bool isRecording = false;

private string asrApiUrl = "https://asr.huaweicloud.com/v1/asr/realtime"; // 华为云实时ASR接口

// 开始录音

public void StartRecording()

{

if (!isRecording)

{

recordingClip = Microphone.Start(null, true, 10, 16000); // 采样率16kHz,时长10秒

isRecording = true;

StartCoroutine(SendAudioToASR());

}

}

// 停止录音

public void StopRecording()

{

if (isRecording)

{

Microphone.End(null);

isRecording = false;

}

}

// 实时发送音频至ASR服务(流式传输)

IEnumerator SendAudioToASR()

{

byte[] buffer = new byte[4096];

int bytesRead;

while (isRecording)

{

bytesRead = recordingClip.GetData(buffer, Microphone.GetPosition(null) - buffer.Length);

if (bytesRead > 0)

{

// 构造ASR请求(需添加鉴权头、音频参数)

UnityWebRequest request = new UnityWebRequest(asrApiUrl, "POST");

request.uploadHandler = new UploadHandlerRaw(buffer);

request.downloadHandler = new DownloadHandlerBuffer();

request.SetRequestHeader("Content-Type", "audio/wav");

request.SetRequestHeader("Authorization", "Bearer YOUR_ASRAPI_TOKEN");

yield return request.SendWebRequest();

// 解析ASR返回的文本(简化示例,实际需处理JSON)

if (request.result == UnityWebRequest.Result.Success)

{

string response = request.downloadHandler.text;

string text = ParseAsrResponse(response); // 自定义解析函数

if (!string.IsNullOrEmpty(text))

{

Debug.Log($"ASR识别结果:{text}");

// 触发盘古大模型对话

StartDialogue(text);

}

}

}

yield return new WaitForSeconds(0.1f); // 每0.1秒发送一次数据

}

}

// 解析ASR返回的JSON(示例结构)

private string ParseAsrResponse(string json)

{

// 实际需使用JsonUtility或Newtonsoft.Json解析

// 示例返回:{"result": "欢迎来到故宫博物院", "confidence": 0.95}

int startIndex = json.IndexOf("\"result\":\"") + 9;

int endIndex = json.IndexOf("\"", startIndex);

return json.Substring(startIndex, endIndex - startIndex);

}

}关键点:

- 麦克风权限:需在Unity的

Player Settings > Android > Other Settings中勾选Microphone权限(移动端)。 - 音频格式:华为云ASR支持16kHz单声道PCM,需确保

Microphone采集的音频符合要求。 - 流式传输:通过分块发送音频数据,实现低延迟识别(延迟约200-500ms)。

2.2 盘古大模型对话交互(C#脚本)

调用盘古大模型API需构造符合要求的请求体,并处理返回的生成文本。以下是核心逻辑:

using UnityEngine;

using UnityEngine.Networking;

using System.Collections.Generic;

using Newtonsoft.Json; // 需导入Newtonsoft.Json库

public class DialogueManager : MonoBehaviour

{

private const string DAPENG_API_URL = "https://api.huaweicloud.com/v1/chat/completions";

private const string API_KEY = "YOUR_API_KEY";

private const string ENDPOINT = "https://dapeng.huaweicloud.com";

private List<Message> conversationHistory = new List<Message>(); // 对话上下文

[System.Serializable]

public class Message

{

public string role; // "user"或"assistant"

public string content;

}

[System.Serializable]

public class DapengRequest

{

public string model = "dapeng-7b-chat"; // 盘古大模型版本

public List<Message> messages;

public float temperature = 0.7f; // 生成随机性(0-1)

public int max_tokens = 500; // 最大回复长度

}

[System.Serializable]

public class DapengResponse

{

public Choices choices;

}

[System.Serializable]

public class Choices

{

public Message message;

}

// 启动对话(用户输入文本)

public void StartDialogue(string userMessage)

{

// 添加用户消息到上下文

conversationHistory.Add(new Message { role = "user", content = userMessage });

// 构造盘古API请求

DapengRequest request = new DapengRequest

{

messages = conversationHistory,

temperature = 0.7f,

max_tokens = 500

};

string jsonRequest = JsonConvert.SerializeObject(request);

byte[] postData = Encoding.UTF8.GetBytes(jsonRequest);

StartCoroutine(SendToDapeng(postData));

}

IEnumerator SendToDapeng(byte[] data)

{

UnityWebRequest request = new UnityWebRequest(DAPENG_API_URL, "POST");

request.uploadHandler = new UploadHandlerRaw(data);

request.downloadHandler = new DownloadHandlerBuffer();

request.SetRequestHeader("Content-Type", "application/json");

request.SetRequestHeader("Authorization", $"Bearer {API_KEY}");

yield return request.SendWebRequest();

if (request.result == UnityWebRequest.Result.Success)

{

DapengResponse response = JsonConvert.DeserializeObject<DapengResponse>(request.downloadHandler.text);

string npcReply = response.choices.message.content;

Debug.Log($"NPC回复:{npcReply}");

// 添加NPC回复到上下文(保留最近5轮对话)

conversationHistory.Add(new Message { role = "assistant", content = npcReply });

if (conversationHistory.Count > 5) conversationHistory.RemoveAt(0);

// 触发语音合成与NPC动画

StartCoroutine(SpeakAndAnimate(npcReply));

}

else

{

Debug.LogError($"对话失败:{request.error}");

}

}

}优化技巧:

- 上下文截断:保留最近5-10轮对话,避免因上下文过长导致模型“遗忘”关键信息。

- 领域适配:通过自定义

system_prompt(系统提示词)约束对话范围(如景区导览场景):{ "role": "system", "content": "你是故宫博物院的智能导游,需回答游客关于景点历史、开放时间的问题,语气亲切自然。" } - 温度参数:

temperature=0.7平衡创造性与准确性(过高易胡言乱语,过低回复机械)。

2.3 语音合成(TTS)与NPC行为同步

通过华为云TTS服务将NPC回复转为音频,并驱动NPC播放语音、同步口型动画。以下是实现代码:

using UnityEngine;

using UnityEngine.Audio;

using UnityWebRequest = UnityEngine.Networking.UnityWebRequest;

public class TTSPlayer : MonoBehaviour

{

public AudioSource audioSource; // NPC语音播放源

public Animator npcAnimator; // NPC动画控制器

public string ttsApiUrl = "https://tts.huaweicloud.com/v1/tts"; // 华为云TTS接口

public string voiceType = "zh-CN-XiaoxiaoNeural"; // 华为云音色(支持多种方言、童声)

// 播放TTS语音并触发动画

public IEnumerator SpeakAndAnimate(string text)

{

// 构造TTS请求

UnityWebRequest request = new UnityWebRequest(ttsApiUrl, "POST");

string jsonPayload = JsonConvert.SerializeObject(new {

text = text,

voice_type = voiceType,

format = "wav",

sample_rate = 16000

});

byte[] postData = Encoding.UTF8.GetBytes(jsonPayload);

request.uploadHandler = new UploadHandlerRaw(postData);

request.downloadHandler = new DownloadHandlerBuffer();

request.SetRequestHeader("Content-Type", "application/json");

request.SetRequestHeader("Authorization", $"Bearer {TTS_API_KEY}"); // 替换为实际TTS API Key

yield return request.SendWebRequest();

if (request.result == UnityWebRequest.Result.Success)

{

// 保存音频数据并播放

byte[] audioData = request.downloadHandler.data;

AudioClip clip = AudioClip.Create("NPC_Speech", audioData.Length, 1, 16000, false);

clip.SetData(audioData, 0);

audioSource.PlayOneShot(clip);

// 触发口型动画(假设动画参数名为"Talk")

npcAnimator.SetBool("Talk", true);

yield return new WaitForSeconds(clip.length); // 等待语音播放完成

npcAnimator.SetBool("Talk", false);

}

}

}关键点:

- 音色选择:华为云TTS支持

zh-CN-XiaoxiaoNeural(通用女声)、zh-CN-YunxiNeural(亲切男声)等音色,可根据NPC角色调整。 - 口型同步:通过

Animator控制口型混合树(Blend Tree),根据语音时长动态调整动画速度。 - 异步处理:使用

IEnumerator和yield return避免主线程阻塞,确保UI响应流畅。

三、实战案例:景区导览智能NPC

3.1 场景搭建

在Unity中创建“故宫博物院”3D场景,包含以下元素:

- NPC模型:使用Mixamo角色(或自定义3D模型),添加

Animator组件控制动作。 - 交互触发区域:在太和殿、乾清宫等景点放置

Trigger碰撞体,当玩家进入时激活语音交互。 - UI界面:显示对话气泡(

TextMeshPro),提示用户“点击说话”或显示NPC回复。

3.2 功能实现流程

- 玩家靠近触发区:通过

OnTriggerEnter检测玩家进入,显示“点击按钮开始对话”提示。 - 用户语音输入:点击交互按钮调用

VoiceRecorder.StartRecording(),采集用户语音并转文本。 - 盘古大模型对话:将用户文本与历史上下文传入

DialogueManager,获取NPC回复。 - 语音合成与动画:调用

TTSPlayer将回复转为音频,播放的同时触发NPC口型动画。 - 多轮对话支持:维护

conversationHistory,支持用户追问(如“刚才说的珍宝馆怎么走?”)。

3.3 测试与优化

- 延迟测试:从语音采集到NPC响应的总延迟需控制在1秒内(ASR 0.5s + 大模型生成0.3s + TTS 0.2s)。

- 准确性验证:针对景区高频问题(如开放时间、门票价格),测试模型回复的正确率(需人工标注语料库)。

- 情感化调整:通过盘古大模型的

sentiment参数(情感倾向)调整NPC语气(如用户提问“累不累?”时,回复更亲切)。

四、挑战与优化策略

4.1 语音识别准确率提升

问题:景区环境嘈杂(如游客喧哗)导致ASR识别错误。

解决方案:

- 前端降噪:使用Unity的

AudioSource.noiseSuppression或第三方插件(如Wwise)进行音频降噪。 - 后端优化:调用华为云ASR的

noise_reduction参数(开启降噪模式),并指定domain=travel(旅行领域)提升专业词汇识别率。

4.2 大模型响应延迟

问题:复杂问题(如历史事件细节)导致生成时间过长(超过2秒)。

解决方案:

- 缓存机制:对高频问题(如“故宫几点开门?”)预存回复,直接返回缓存结果。

- 流式生成:调用盘古大模型的流式API(

stream=true),逐步显示回复文本(如“故宫...早上...8:30...”),提升用户感知。

4.3 NPC行为自然度

问题:动画与语音不同步(如口型提前或滞后)。

解决方案:

- 时间校准:根据TTS音频的实际时长(

clip.length)动态调整动画播放速度。 - 混合动画:使用

Animator的Layer和Weight混合行走、手势等动作,避免机械感。

总结

通过盘古大模型与Unity的深度集成,开发者可快速构建具备多轮对话、情感理解和场景自适应能力的智能NPC。本文从语音采集、ASR转文本、大模型交互到TTS与动画同步,详细讲解了全链路实现方案,并结合景区导览场景验证了技术可行性。未来,随着盘古大模型在垂直领域(如医疗、教育)的微调优化,以及Unity XR(扩展现实)技术的进步,智能对话NPC将在元宇宙、数字孪生等场景中发挥更大价值。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)