谷歌轻量级内容理解大模型速读:gemma-3n-E2B-it-litert-preview

Gemma 3n是由谷歌DeepMind团队开发的一系列轻量级、开源的多模态模型,基于与Gemini模型相同的研究和技术构建。该模型支持文本、图像和音频等多种输入,输出为生成的文本内容,适用于问答、摘要、推理等任务。Gemma 3n在包含11万亿标记的多样化数据集上训练,涵盖140多种语言,并采用严格的过滤方法确保数据安全。模型使用TPU硬件进行训练,通过选择性参数激活技术减少资源需求。在性能评估

gemma-3n-E2B-it-litert-preview

一、模型概述

Gemma 3n是由谷歌DeepMind团队开发的一系列轻量级、尖端的开源模型。这些模型基于与Gemini模型相同的研究和技术构建,专为各种内容理解任务而设计,包括问答、摘要和推理等。其较小的模型尺寸使得在资源有限的环境中部署成为可能,如笔记本电脑、台式机或个人云基础设施,从而实现对尖端AI模型的民主化访问,促进创新。

二、模型输入输出

Gemma 3n模型的输入包括文本字符串(如问题、提示或要总结的文档)、图像(标准化为256x256、512x512或768x768分辨率并编码为256个标记每个)、音频数据(从单声道编码为每秒6.25个标记)以及总输入上下文32K个标记。输出为对输入生成的文本,如问题的答案、图像内容分析或文档摘要,总输出长度可达32K个标记,减去请求输入标记。

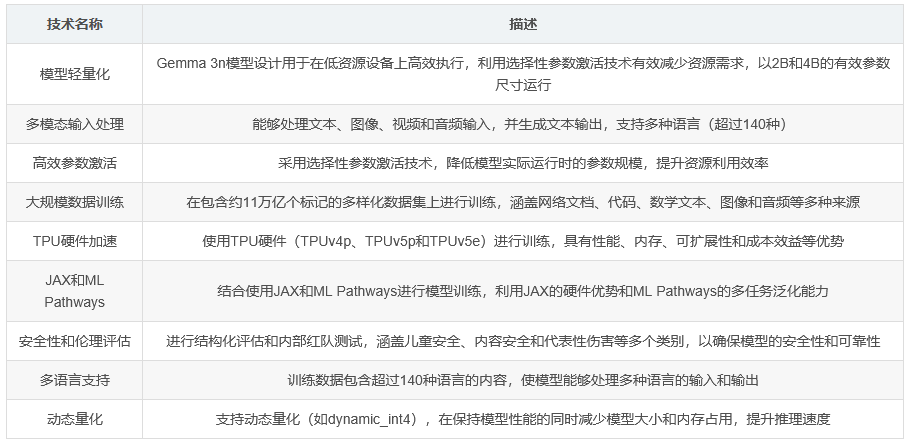

三、技术细节

(一)模型数据

Gemma 3n模型在包含约11万亿个标记的多样数据集上进行训练,知识截止日期为2024年6月。数据集包括网络文档、代码、数学文本、图像和音频等多种来源,涵盖超过140种语言。在数据预处理方面,应用了严格的CSAM(儿童性虐待材料)过滤、敏感数据过滤以及其他基于内容质量和安全性的过滤方法。

(二)硬件与软件

Gemma模型使用TPU(Tensor Processing Unit)硬件(TPUv4p、TPUv5p和TPUv5e)进行训练。TPU专为机器学习中的矩阵运算设计,具有性能、内存、可扩展性和成本效益等优势。训练使用JAX和ML Pathways进行,其中JAX允许研究人员利用最新硬件(包括TPU)进行快速高效的大型模型训练,ML Pathways是谷歌构建能够跨多个任务泛化的AI系统(特别是大型语言模型)的最新努力。

(三)高效参数管理

Gemma 3n模型采用选择性参数激活技术以减少资源需求。该技术使模型能够以2B和4B的有效参数尺寸运行,低于它们所包含的总参数数量。

四、性能评估

Gemma 3n模型在多个基准测试中进行了评估,包括推理和事实性、多语言、STEM和代码等方面。例如,在HellaSwag基准测试中,E2B PT模型在10-shot设置下的准确率为72.2%,E4B PT模型为78.6%;在BoolQ基准测试中,E2B PT模型在0-shot设置下的准确率为76.4%,E4B PT模型为81.6%。此外,还在三星S25 Ultra设备上对Android性能基准进行了测试,结果显示在CPU和GPU后端的不同量化模型在预填充和解码速度、首次标记时间、模型大小和内存使用等方面的性能表现。

五、安全性和伦理考量

谷歌对Gemma 3n模型进行了结构化评估和内部红队测试,以确保其符合相关的内容政策。评估涵盖了儿童安全、内容安全和代表性伤害等多个类别。测试结果显示,与之前的Gemma模型相比,该模型在所有安全测试领域都表现出安全的性能水平,并且在高严重性违规方面显著改进。然而,评估的一个局限性是主要使用英语语言提示。

六、应用场景和限制

(一)应用场景

Gemma 3n模型在内容创作与通信(如文本生成、聊天机器人、文本摘要、图像数据提取和音频数据提取)、研究与教育(如自然语言处理和生成模型研究、语言学习工具和知识探索)等领域具有广泛的应用潜力。

(二)限制

Gemma 3n模型存在一些限制,包括训练数据的质量和多样性对模型能力的影响、模型在处理复杂任务和开放性任务时的挑战、对语言模糊性和细微差别的理解能力有限、生成响应的事实准确性问题以及模型在应用常识推理方面的不足。

七、风险与缓解措施

开发生成模型引发了一些伦理问题,如偏差和公平性、错误信息和滥用、透明度和责任等。为了缓解这些风险,谷歌鼓励持续监测、在模型训练和微调期间探索去偏差技术、实施内容安全机制、通过技术限制和教育来防止恶意使用、以及采用隐私保护技术等。

八、总结

Gemma 3n模型作为谷歌DeepMind团队开发的轻量级、开源的多模态模型,凭借其在多种任务上的适用性、较低的资源需求和对多种语言的支持,为广泛的用户提供了一个强大而灵活的AI工具。尽管如此,用户在使用过程中也应充分了解其局限性和潜在风险,以确保安全、负责任地应用该技术。

更多推荐

已为社区贡献31条内容

已为社区贡献31条内容

所有评论(0)