AI、人工智能基础:流行的Transformer 有多牛?横扫 NLP 界的 “流量明星” 架构解密

了解Transformer背景。

各位观众老爷,大家好,我是诗人啊_,今天和各位分享: Transformer的背景介绍, 认识Transformer框架

(屏幕前的你,帅气低调有内涵,美丽大方很优雅…所以,求个点赞、收藏、关注呗~)

无论你是刚踏入深度学习领域的新手,还是想巩固序列模型基础的开发者,跟着这个案例去思考,不仅能吃透Transformer的相关知识,更能直观触发现 '原来这些知识, 也没这么难'

一、Transformer背景介绍

学习目标

- 了解Transformer背景

1 Transformer的诞生

2018年10月,Google发出一篇论文《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》, BERT模型横空出世, 并横扫NLP领域11项任务的最佳成绩!

论文地址: https://arxiv.org/pdf/1810.04805.pdf

而在BERT中发挥重要作用的结构就是Transformer, 之后又相继出现XLNET,roBERT等模型击败了BERT,但是他们的核心没有变,仍然是:Transformer。

2 Transformer的优势

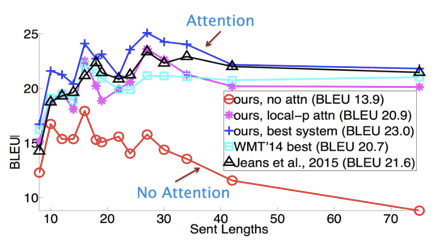

相比之前占领市场的LSTM和GRU模型,Transformer有两个显著的优势:

1、Transformer能够利用分布式GPU进行并行训练,提升模型训练效率.

2、在分析预测更长的文本时, 捕捉间隔较长的语义关联效果更好.

下面是一张在测评比较图:

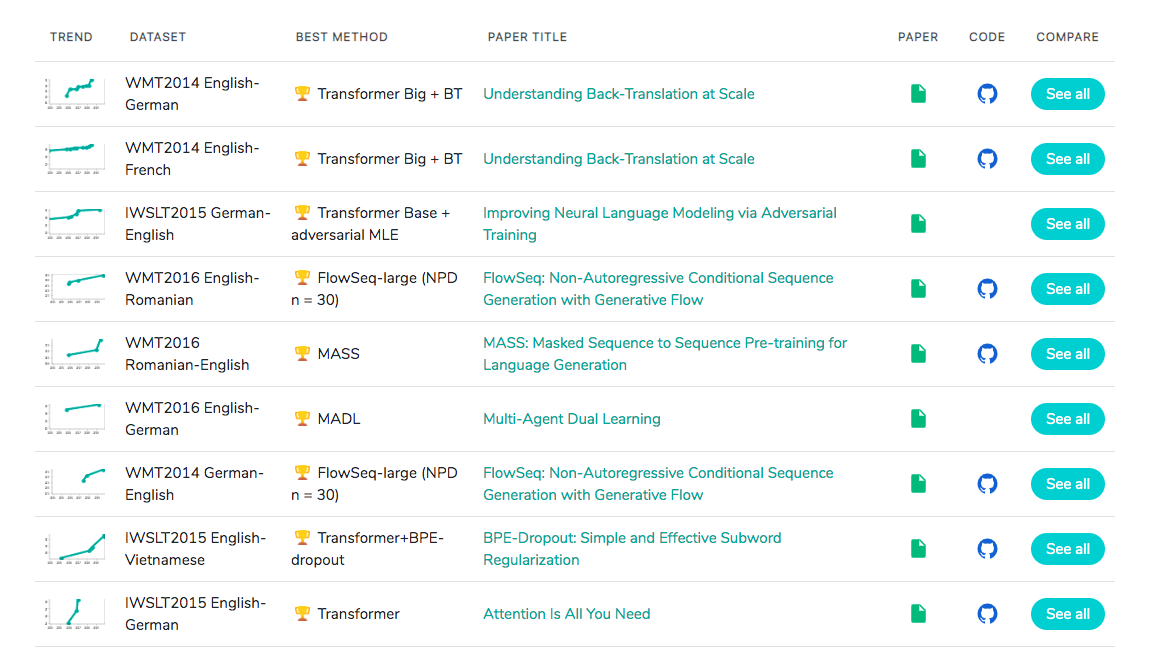

3 Transformer的市场

在著名的SOTA机器翻译榜单上, 几乎所有排名靠前的模型都使用Transformer,

其基本上可以看作是工业界的风向标, 市场空间自然不必多说!

二、 认识Transformer架构

学习目标

- 了解Transformer模型的作用.

- 了解Transformer总体架构图中各个组成部分的名称.

1 Transformer模型的作用

-

基于seq2seq架构的transformer模型可以完成NLP领域研究的典型任务, 如机器翻译, 文本生成等. 同时又可以构建预训练语言模型,用于不同任务的迁移学习.

-

在接下来的架构分析中, 我们将假设使用Transformer模型架构处理从一种语言文本到另一种语言文本的翻译工作, 因此很多命名方式遵循NLP中的规则. 比如: Embeddding层将称作文本嵌入层, Embedding层产生的张量称为词嵌入张量, 它的最后一维将称作词向量等.

2 Transformer总体架构图

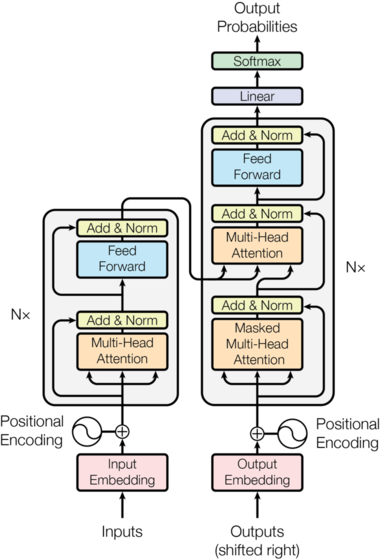

2.1 Transformer总体架构

- 输入部分

- 输出部分

- 编码器部分

- 解码器部分

2.2 输入部分包含¶

- 源文本嵌入层及其位置编码器

- 目标文本嵌入层及其位置编码器

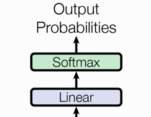

2.3 输出部分包含

- 线性层

- softmax层

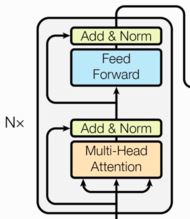

2.4 编码器部分

- 由N个编码器层堆叠而成

- 每个编码器层由两个子层连接结构组成

- 第一个子层连接结构包括一个多头自注意力子层和规范化层以及一个残差连接

- 第二个子层连接结构包括一个前馈全连接子层和规范化层以及一个残差连接

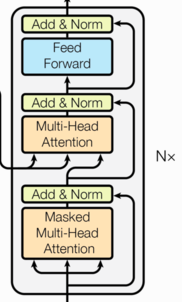

2.5 解码器部分

- 由N个解码器层堆叠而成

- 每个解码器层由三个子层连接结构组成

- 第一个子层连接结构包括一个多头自注意力子层和规范化层以及一个残差连接

- 第二个子层连接结构包括一个多头注意力子层和规范化层以及一个残差连接

- 第三个子层连接结构包括一个前馈全连接子层和规范化层以及一个残差连接

3 小结

-

学习了Transformer模型的作用:

- 基于seq2seq架构的transformer模型可以完成NLP领域研究的典型任务, 如机器翻译, 文本生成等. 同时又可以构建预训练语言模型,用于不同任务的迁移学习.

-

Transformer总体架构可分为四个部分:

- 输入部分

- 输出部分

- 编码器部分

- 解码器部分

-

输入部分包含:

- 源文本嵌入层及其位置编码器

- 目标文本嵌入层及其位置编码器

-

输出部分包含:

- 线性层

- softmax处理器

-

编码器部分:

- 由N个编码器层堆叠而成

- 每个编码器层由两个子层连接结构组成

- 第一个子层连接结构包括一个多头自注意力子层和规范化层以及一个残差连接

- 第二个子层连接结构包括一个前馈全连接子层和规范化层以及一个残差连接

-

解码器部分:

- 由N个解码器层堆叠而成

- 每个解码器层由三个子层连接结构组成

- 第一个子层连接结构包括一个多头自注意力子层和规范化层以及一个残差连接

- 第二个子层连接结构包括一个多头注意力子层和规范化层以及一个残差连接

- 第三个子层连接结构包括一个前馈全连接子层和规范化层以及一个残差连接

作者有话说:

首先,感谢您看到了这里,感谢支持!不知道, 通过案例, 您是否对Transformer的执行流程有了更为全面的了解?

这个世界上, 人杰辈出, 天才俊杰比比皆是. 要坚信, 所有的知识都是人想出来了, '他们能想到, 我也一定能想到!'. 所有不会的知识, 一定只是现在不会, 坚持!

我是诗人啊_程序员,致力于分享人工智能方面的知识,近期 NLP 自然语言处理系列文章发布中,如果感兴趣,来个关注呗~

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)