2024年hadoop平台完全分布式搭建,大数据开发程序员春招三面蚂蚁金服

1.编辑hosts文件,添加主机名映射内容添加内容:(IP地址填写你自己主机的IP地址)2.生成公钥和私钥然后按四次回车3.复制公钥到其他容器(包括自己)填入yes回车,然后输入root密码即可4.测试是否能免密登录ssh masterssh slave1ssh slave2若回显登录界面,则设置成功(另外两个节点重复以上操作)1.解压jdk安装包到/opt/module中。

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

安装前准备

一、设置ssh免密登录

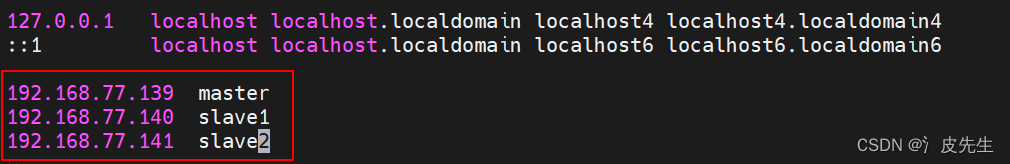

1.编辑hosts文件,添加主机名映射内容

vim /etc/hosts

添加内容:

192.168.77.139 master

192.168.77.140 slave1

192.168.77.141 slave2

(IP地址填写你自己主机的IP地址)

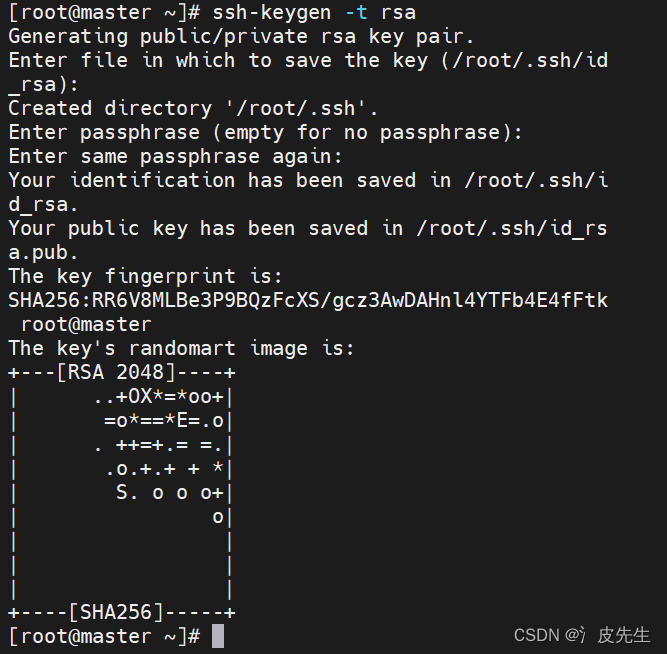

2.生成公钥和私钥

ssh-keygen –t rsa

然后按四次回车

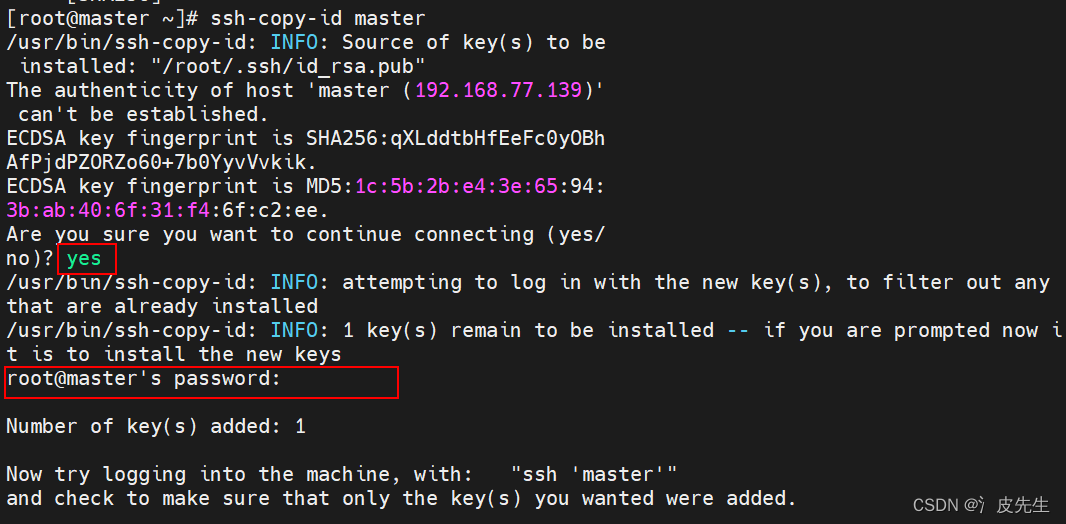

3.复制公钥到其他容器(包括自己)

ssh-copy-id master

ssh-copy-id slave1

ssh-copy-id slave2

填入yes回车,然后输入root密码即可

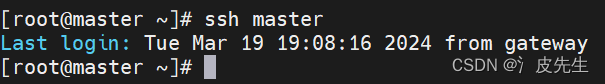

4.测试是否能免密登录

ssh master

ssh slave1

ssh slave2

若回显登录界面,则设置成功

(另外两个节点重复以上操作)

二、java安装及环境变量配置

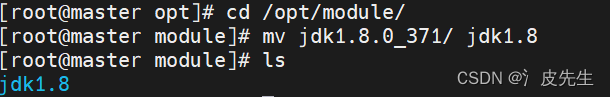

1.解压jdk安装包到/opt/module中

tar -zxvf jdk-8u371-linux-x64.tar.gz(包名根据自己的写) -C /opt/module

cd /opt/module

mv jdk1.8.0_192 jdk1.8(非必须)

(为了使用便利,可把jdk名改简单点,下面都以jdk1.8来写)

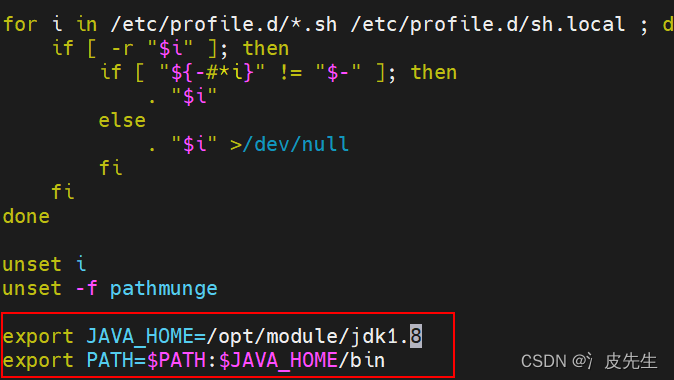

2.配置JAVA环境变量,编辑文件/etc/profile,添加内容,输入命令,使添加配置生效

vim /etc/profile

添加以下内容

export JAVA_HOME=/opt/module/jdk1.8

export PATH= P A T H : PATH: PATH:JAVA_HOME/bin

使配置生效

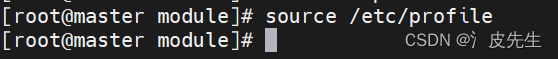

source /etc/profile

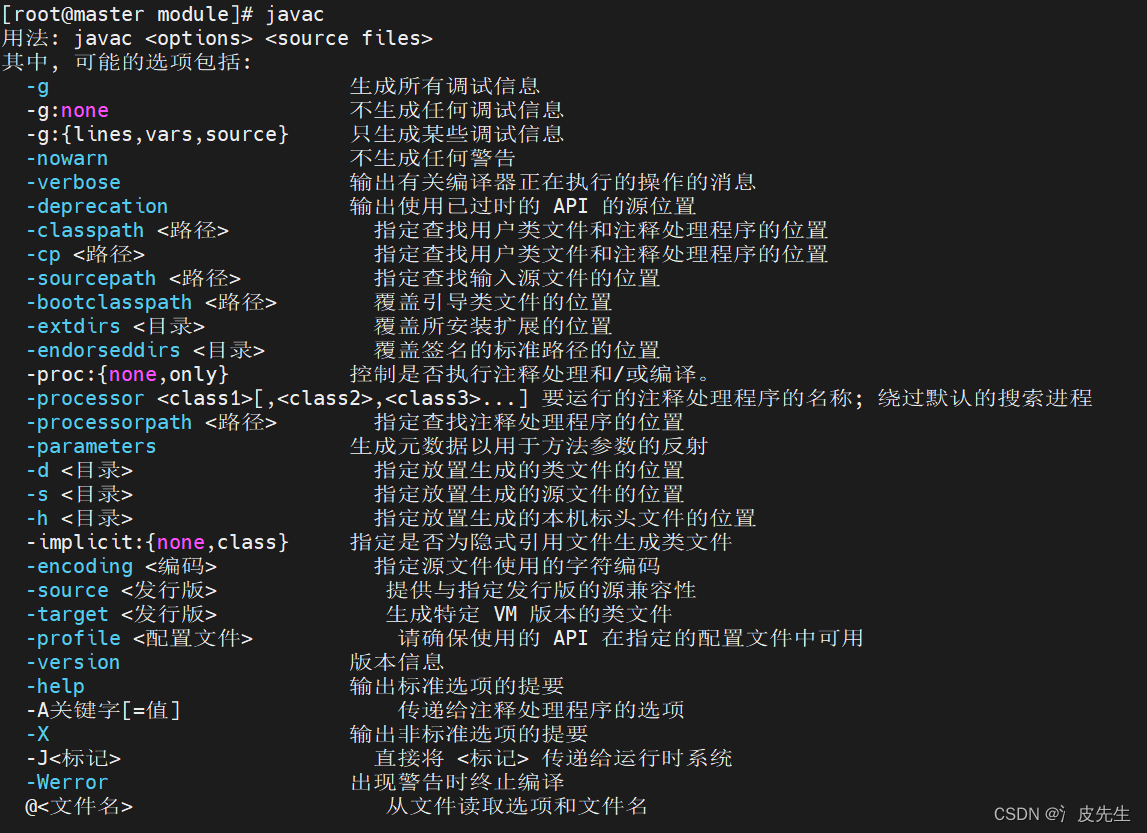

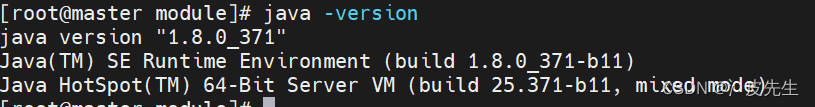

3.验证java环境变量是否配置成功

java –version

javac

若正常回显结果则代表安装配置正确

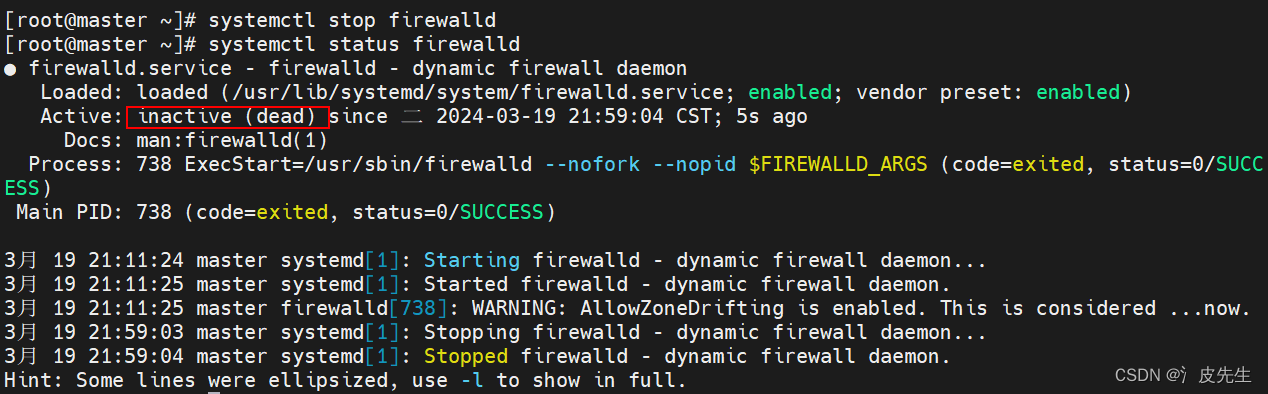

三、关闭防火墙****(三个节点都需要)****

systemctl stop firewalld

hadoop平台搭建

一、hadoop安装及环境变量配置

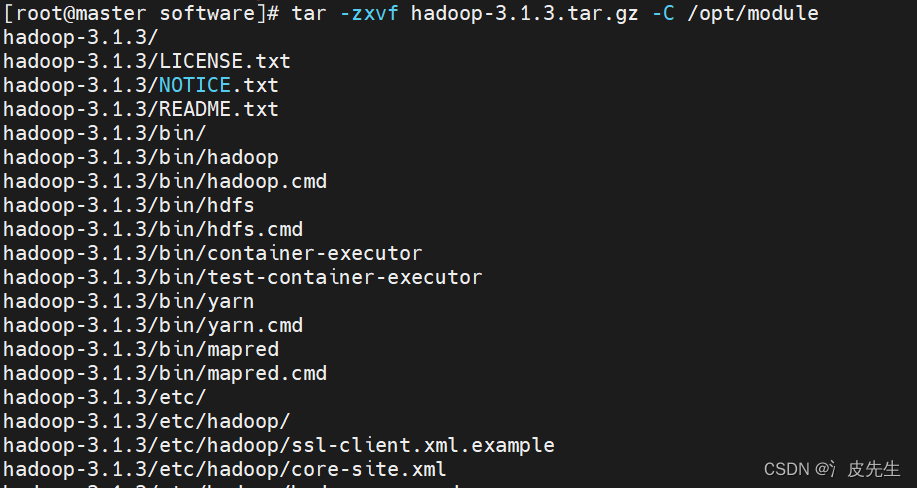

1.解压hadoop安装包到/opt/module中

cd /opt/software

tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module

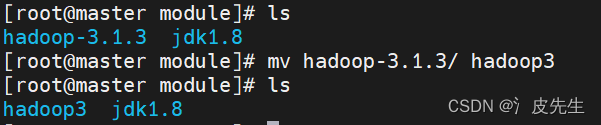

cd /opt/module

mv hadoop-3.2.3 hadoop3

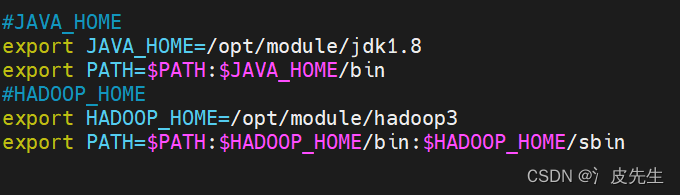

2.配置hadoop环境变量,编辑文件/etc/profile,添加内容,输入命令使其生效

vim /etc/profile

添加内容

export HADOOP_HOME=/opt/module/hadoop3

export PATH= P A T H : PATH: PATH:JAVA_HOME/bin: H A D O O P _ H O M E / b i n : HADOOP\_HOME/bin: HADOOP_HOME/bin:HADOOP_HOME/sbin

使配置生效

source /etc/profile

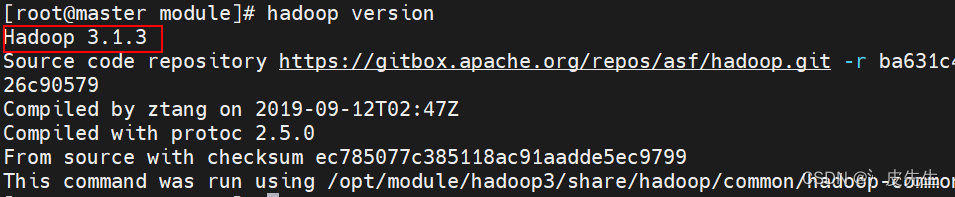

3.验证hadoop环境变量是否配置成功

hadoop version

slave1、slave2使用scp命令分发到slave1、slave2

scp传输文件命令:scp -r 要传输的目录 主机名:传输到的位置

-r传输目录,传送文件可不加

scp -r module slave1:/opt

scp -r module slave2:/opt

scp /etc/profile slave1:/etc/profile

scp /etc/profile slave2:/etc/profile

二****、H********adoop集群配置****

集群部署规划

注意:

- Namenode和secondarynamenode不要安装在同一台服务器

- Resourcemanagery也很消耗内存,不要和namenode、secondarynamenode配置在同一台机器上

| master | slave1 | slave2 | |

| HDFS | Namenode Datanode | datanode | Secondarynamenode datanode |

| YARN | nodemanager | Resourcemanager nodemanager | nodemanager |

1.进入到/opt/module/hadoop3/etc/hadoop目录下

cd /opt/module/hadoop3/etc/hadoop

2.修改core-site.xml,hdfs-site.xml,yarn-site.xml,mapred-site.xml四个配置文件

(hadoop默认配置文件在/opt/module/hadoop3/share/hadoop中)

核心配置文件core-site.xml

fs.defaultFS

hdfs://master:9820

(hadoop.tmp.dir是Hadoop文件系统依赖的基础配置,默认存放在/tmp/{$user}下。但是存放在/tmp下是不安全的,因为系统重启后文件有可能被删除,所以会指向另外的路径)

hadoop.tmp.dir

/opt/module/hadoop3/data

hadoop.http.staticuser.user

root

HDFS配置文件hdfs-site.xml

dfs.namenode.http-address

master:9870

(该部分可能不需要)dfs.namenode.secondary.http-address

slave2:9868

dfs.replication

3

YARN配置文件yarn-site.xml

yarn.resourcemanager.hostname

slave1

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

Manager -->

yarn.resourcemanager.hostname

slave1

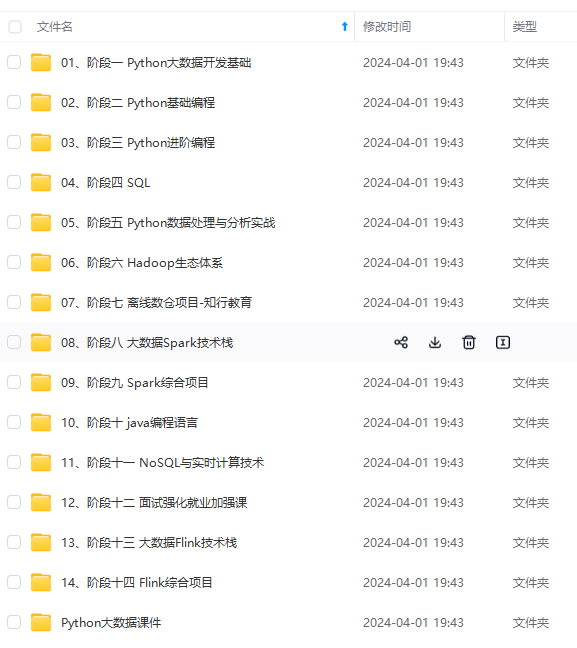

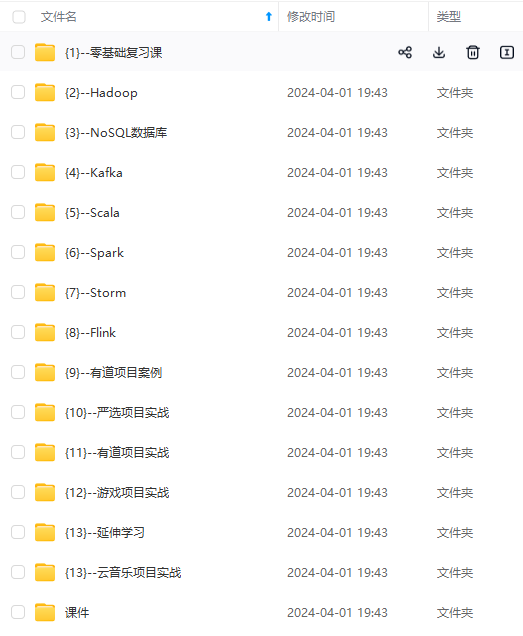

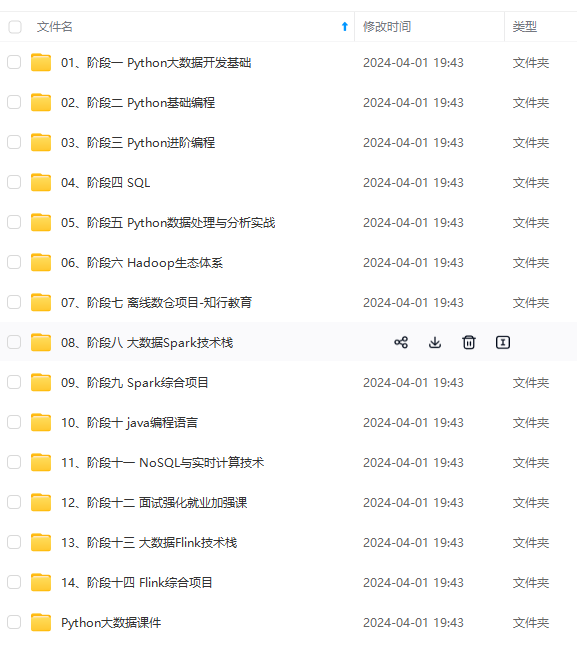

[外链图片转存中…(img-KQ80d4eW-1714851060216)]

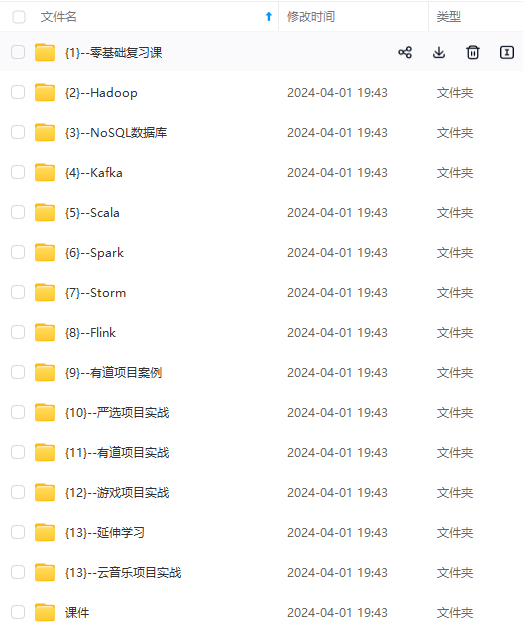

[外链图片转存中…(img-1bYazMEB-1714851060217)]

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)