AI原生应用跨语言理解:打造全球语言交流桥梁

想象一下,如果你带着手机就能和全世界70亿人自由聊天,阅读任何语言的书籍,理解不同文化的幽默和情感——这不是科幻电影,而是AI原生应用正在实现的现实。AI原生应用(AI-Native Application)指的是从设计之初就以人工智能为核心驱动力的应用程序,而跨语言理解则是这些应用最令人兴奋的超能力之一。用"给小学生讲故事"的方式解释跨语言理解的核心技术展示AI原生应用如何将这些技术无缝集成通过

AI原生应用跨语言理解:打造全球语言交流桥梁

关键词:AI原生应用, 跨语言理解, 自然语言处理, 大语言模型, 多语言翻译, 全球化交流, 语义对齐

摘要:在全球化浪潮下,语言障碍仍是阻碍人类深度交流的"隐形长城"。本文将以"AI原生应用如何突破语言壁垒"为主线,用通俗易懂的语言揭开跨语言理解技术的神秘面纱。我们将从生活故事出发,逐步解析AI如何像"世界语言魔术师"一样听懂、理解并转换全球语言,通过生动比喻和代码实例,展示大语言模型、多语言嵌入、神经机器翻译等核心技术的协作原理。最终你将明白,AI原生应用正在如何构建一座连接不同文化的"语言立交桥",以及未来我们如何让这座桥梁更加坚固、畅通。

背景介绍

目的和范围

想象一下,如果你带着手机就能和全世界70亿人自由聊天,阅读任何语言的书籍,理解不同文化的幽默和情感——这不是科幻电影,而是AI原生应用正在实现的现实。AI原生应用(AI-Native Application)指的是从设计之初就以人工智能为核心驱动力的应用程序,而跨语言理解则是这些应用最令人兴奋的超能力之一。

本文的目的是:

- 用"给小学生讲故事"的方式解释跨语言理解的核心技术

- 展示AI原生应用如何将这些技术无缝集成

- 通过代码实例让你亲手触摸这项技术的脉搏

- 探讨这项技术如何重塑全球交流方式

我们的旅程将覆盖从基础概念到实际应用,从数学原理到未来趋势,但请放心——我们会避开晦涩的学术术语,用生活中的例子搭建理解的阶梯。

预期读者

本文适合三类"探险家":

- 技术爱好者:想了解AI如何实现跨语言交流的好奇宝宝

- 开发者:希望将跨语言功能集成到应用中的程序员

- 产品经理/创业者:寻找全球化产品突破口的创新者

无论你是零基础的AI小白,还是有经验的技术人员,都能在这趟旅程中找到属于自己的发现。我们会像搭积木一样,从最基础的概念开始,逐步构建完整的知识体系。

文档结构概述

我们的"跨语言理解探险地图"包含以下站点:

- 背景介绍:为什么语言障碍需要被打破

- 核心概念与联系:用故事和比喻解释关键技术

- 核心算法原理:通过代码实例展示AI如何"学习"语言

- 数学模型:揭开语言转换背后的数字密码

- 项目实战:亲手搭建一个迷你跨语言理解应用

- 实际应用场景:看看这项技术正在改变哪些行业

- 未来趋势与挑战:前方还有哪些险峰和美景

每个站点都有"导游讲解"(通俗解释)和"探险工具包"(技术细节),你可以根据自己的兴趣选择深入程度。

术语表

核心术语定义

为了让我们的探险更顺畅,先认识几个"关键人物":

| 术语 | 小学生版解释 | 专业版解释 |

|---|---|---|

| AI原生应用 | 天生就会"思考"的App,就像有自己大脑的超级助手 | 以人工智能技术为核心架构,而非附加功能的应用程序,能自主学习和适应用户需求 |

| 跨语言理解 | AI能听懂中文、英文、日文等多种语言,还能明白它们说的是同一件事 | 人工智能系统理解并处理不同自然语言之间语义等价性的能力,超越简单翻译 |

| 自然语言处理(NLP) | 教电脑"听懂人话"的技术,就像教外国人学中文 | 人工智能的一个分支,研究计算机与人类语言的交互,包括理解、生成和翻译语言 |

| 大语言模型(LLM) | 读了全世界的书和文章的"语言大学霸",知道各种语言的用法 | 基于海量文本数据训练的深度学习模型,能理解和生成类人文本,如GPT、LLaMA等 |

| 多语言嵌入 | 把不同语言的话变成电脑能懂的"数字密码",而且意思相同的话密码相似 | 将不同语言的文本转换为高维向量空间中的向量表示,使语义相似的文本具有相似的向量 |

| 神经机器翻译(NMT) | 用AI神经网络做的超级翻译官,比传统翻译更懂上下文 | 基于深度学习的翻译方法,使用神经网络模型学习源语言到目标语言的映射关系 |

| 语义对齐 | 让电脑知道"苹果"和"apple"说的是同一个东西 | 在不同语言的词汇、句子或篇章之间建立语义对应关系的过程 |

相关概念解释

语言壁垒:就像不同国家之间隔着没有桥梁的大河,人们能看到对岸却无法交流。根据联合国数据,全球有7000多种语言,但超过一半的人只说其中23种语言。

上下文理解:比如"他说的’苹果’是指吃的水果还是那个卖手机的公司?"——AI需要像人一样结合前后文判断意思。

低资源语言:就像学校里不受老师关注的学生,数据量少、研究少的语言(如非洲的一些土著语言),AI翻译效果通常较差。

缩略词列表

| 缩略词 | 全称 | 中文翻译 |

|---|---|---|

| AI | Artificial Intelligence | 人工智能 |

| NLP | Natural Language Processing | 自然语言处理 |

| LLM | Large Language Model | 大语言模型 |

| NMT | Neural Machine Translation | 神经机器翻译 |

| BERT | Bidirectional Encoder Representations from Transformers | 基于Transformer的双向编码器表示 |

| mBERT | Multilingual BERT | 多语言BERT |

| XLM | Cross-lingual Language Model | 跨语言语言模型 |

| LASER | Language-Agnostic SEntence Representations | 语言无关句子表示 |

| MLM | Masked Language Model | 掩码语言模型 |

核心概念与联系

故事引入

小明的环球冒险与"语言魔术师"

12岁的小明第一次独自出国参加夏令营,在日本机场就遇到了麻烦——他想找洗手间,却看不懂日语标识,问工作人员时对方说的日语他一句也听不懂。情急之下,他打开了妈妈推荐的"环球语伴"App,对着手机说出"请问洗手间在哪里",手机立刻用流利的日语重复了这句话。工作人员笑着指路,还用日语说了句"不客气",手机又马上翻译成中文:“不客气,直走左转就到。”

在夏令营里,小明认识了来自巴西的Lucas和来自埃及的Aisha。他们三个分别说中文、葡萄牙语和阿拉伯语,却通过"环球语伴"的实时翻译功能聊得热火朝天。当Lucas用葡萄牙语讲了个足球笑话时,AI不仅准确翻译了文字,还在小明的屏幕上标注了"这是巴西足球文化中的幽默,类似于我们说的…"。

最神奇的是最后一天,他们要一起完成一份用英语写的夏令营报告。小明用中文输入,Lucas用葡萄牙语修改,Aisha用阿拉伯语补充,App自动将所有人的内容整合成一篇流畅的英文报告,连老师都惊讶于他们的合作效率。

这个故事里的"环球语伴"就是一个AI原生应用,而它背后的"语言魔术师"正是跨语言理解技术。接下来,我们就来揭开这位"魔术师"的秘密工具箱。

核心概念解释(像给小学生讲故事一样)

核心概念一:AI原生应用——天生会"多国语言"的超级助手

想象普通应用程序就像只能说一种语言的机器人,你教它中文它就只会中文,教它英文它就只会英文。而AI原生应用就像一个天生的语言天才,从出生(开发)那天起大脑里就装着"语言学习模块"。

普通翻译App vs AI原生应用的区别:

- 普通翻译App:你说中文→它翻译成英文(只是语言转换)

- AI原生应用:你说中文→它理解你的意思→用英文回应时还会考虑对方的文化习惯(比如对长辈用敬语)

就像普通翻译是"逐字念稿子",而AI原生应用是"真正听懂并交流"。它不仅能翻译文字,还能理解你的情绪(比如你说"气死我了",它知道你在生气)、文化背景(比如中国人说"改天吃饭"可能只是客气,不必真的安排时间)。

核心概念二:大语言模型(LLM)——读遍天下书的"语言大学霸"

如果把AI原生应用比作一家语言翻译公司,那么大语言模型就是公司里最厉害的"首席翻译官"。这个学霸读过的书比人类历史上任何人都多——它学习了互联网上几十亿页的中文、英文、日文、法文等几乎所有主要语言的文本。

想象一下,你把全世界的图书馆都塞进一个超级大脑里,这个大脑能记住每本书的内容,还能发现不同语言之间的规律:比如中文的"你好"和英文的"Hello"在对话中用法相似,中文的"谢谢"在日文里对应"ありがとう"。

但LLM不只是"记忆好",它还很"聪明"。比如你问它"为什么天空是蓝色的",它不会只从中文资料里找答案,还会结合英文、德文等各种语言的科学文献,给出最准确的解释。

核心概念三:多语言嵌入——语言的"万能密码本"

假设你有三个盒子,分别装着中文、英文和日文的单词。多语言嵌入就像一个"密码转换机",能把每个盒子里的单词都转换成一串数字(我们叫它"向量"),而且意思相同的词会转换成相似的数字串。

比如:

- 中文"猫" → 数字串:[0.2, 0.5, -0.1, 0.8…]

- 英文"cat" → 数字串:[0.21, 0.49, -0.09, 0.78…]

- 日文"猫(ねこ)" → 数字串:[0.19, 0.51, -0.11, 0.81…]

这些数字串非常相似,电脑一看就知道它们指的是同一个毛茸茸的小动物。这就解决了电脑"不懂语言"的问题——它不需要学会中文或英文,只需要比较这些数字串就知道意思是否相同。

这个过程就像把不同语言的"钥匙"都复制成同一把"万能钥匙",这样无论你用哪国语言的钥匙,都能打开同一扇"意思"的门。

核心概念四:神经机器翻译(NMT)——会"猜上下文"的智能翻译官

传统的翻译软件就像查字典——一个词一个词地翻译,经常闹笑话。比如把"杀鸡焉用牛刀"直译成"To kill a chicken, why use a cow knife",外国人根本看不懂。

神经机器翻译则像一个懂上下文的翻译官。它会先通读整个句子,理解意思后再翻译。就像我们翻译"杀鸡焉用牛刀"时,会先明白这是"小题大做"的意思,再翻译成英文的对应谚语"It’s like using a sledgehammer to crack a nut"。

NMT的工作方式很像学外语时的"沉浸式学习"。它通过分析 millions 对双语句子(比如中文句子和对应的英文翻译),慢慢学会不同语言之间的"表达方式转换",而不只是字面转换。

核心概念五:语义对齐——不同语言间的"桥梁工程师"

想象中文和英文是两座岛屿,每个词都是岛上的房子。语义对齐就是在两座岛上意思相同的房子之间架起桥梁。比如"学校"和"school"之间架一座桥,"老师"和"teacher"之间架一座桥。

但语言的岛屿比这复杂得多:

- 有些中文词在英文中有多个对应词(如"意思"可以是"meaning"、“idea"或"interest”)

- 有些英文词在中文中没有直接对应(如"serendipity"——意外发现美好事物的能力)

- 有些表达需要跨句子对齐(如中文的"下雨了,我不带伞"和英文的"I won’t take an umbrella even though it’s raining")

语义对齐技术就像最优秀的桥梁工程师,不仅能架简单的直桥,还能设计复杂的"立交桥"来连接这些意思相近但表达方式不同的语言片段。

核心概念之间的关系(用小学生能理解的比喻)

现在我们已经认识了五位"语言魔术师"——AI原生应用、大语言模型、多语言嵌入、神经机器翻译和语义对齐。它们不是各自为战,而是像一个团队一样密切合作。让我们用"环球语言广播站"的故事来理解它们的关系:

AI原生应用是广播站的"总导演"

想象AI原生应用是"环球语言广播站"的总导演,负责协调所有工作人员(其他技术组件),确保广播顺利进行。当有听众(用户)打进电话想用中文和英文听众交流时,总导演会:

- 告诉"首席翻译官"(大语言模型):“请理解这位听众的意思”

- 指示"密码转换员"(多语言嵌入):“把他的话转换成我们内部的数字密码”

- 安排"翻译主播"(神经机器翻译):“用英文准确表达相同的意思,注意保持原来的情绪”

- 提醒"桥梁工程师"(语义对齐):“检查一下有没有文化差异需要特别处理”

没有总导演的协调,其他工作人员就像一盘散沙,无法高效合作完成任务。

大语言模型和多语言嵌入:"理解"与"编码"的黄金搭档

大语言模型(首席翻译官)和多语言嵌入(密码转换员)的关系就像侦探和他的"线索分析仪":

- 侦探(LLM)负责理解案件(用户输入)的整体情况,发现关键线索(语义重点)

- 线索分析仪(多语言嵌入)把这些线索转换成电脑能处理的数字信号(向量),方便后续分析

比如用户输入"我明天想去看电影":

- LLM理解这是一个关于"未来计划"和"娱乐活动"的句子,重点是"明天"、“去”、“看电影”

- 多语言嵌入把这些理解转换成向量:[0.3, -0.2, 0.7, …](表示"未来时间+移动+娱乐活动"的组合)

没有LLM的深度理解,嵌入就只是无意义的数字;没有嵌入的编码,LLM的理解无法被电脑进一步处理。

神经机器翻译和语义对齐:"表达"与"校准"的最佳拍档

神经机器翻译(翻译主播)和语义对齐(桥梁工程师)的关系就像国际新闻主播和他的"文化顾问":

- 主播(NMT)负责用目标语言清晰、流畅地表达内容

- 文化顾问(语义对齐)负责确保表达符合目标语言的文化习惯,避免误解

比如要把中文"龙"翻译成英文:

- 直译成"dragon"会有问题,因为中文的"龙"是吉祥象征,而西方的"dragon"常代表邪恶

- 语义对齐技术会提醒NMT:“这里需要文化适配,可以翻译成’Chinese dragon’并加上简短解释”

没有NMT,就无法生成流畅的目标语言文本;没有语义对齐,翻译可能"词对词准确"但"文化上错误"。

所有概念协同工作的流程

让我们用小明在日本机场的例子,看看所有技术如何协同工作:

-

输入阶段:小明说"请问洗手间在哪里"(中文语音)

- AI原生应用(总导演):“收到中文语音,需要转换成日文并保持礼貌语气”

-

理解阶段:

- LLM(首席翻译官):“这是一个礼貌的问路请求,关键词是’洗手间’、‘哪里’”

- 多语言嵌入(密码转换员):“将这句话编码成向量:[0.1, 0.4, -0.3, …]”(表示"礼貌请求+地点询问+卫生设施")

-

转换阶段:

- 语义对齐(桥梁工程师):“找到中文’洗手间’与日文’お手洗い’的对应关系,注意日本公共场所常用’お手洗い’而非更口语化的’トイレ’”

- NMT(翻译主播):“生成日文翻译:‘すみません、お手洗いはどこですか?’”(带有礼貌前缀"すみません",符合日本文化习惯)

-

输出阶段:

- AI原生应用(总导演):“将日文文本转换成语音播放,并准备接收对方回应后的翻译”

这个过程不到1秒就完成了,让小明感觉就像在和会说中文的人交流一样自然。

核心概念原理和架构的文本示意图(专业定义)

AI原生应用的跨语言理解架构可以分为五层,每层负责不同的任务,就像多层蛋糕一样层层叠叠又相互支撑:

┌─────────────────────────────────────────────────────────┐

│ 第五层:用户交互层 (User Interaction Layer) │

│ - 语音/文本输入输出接口 │

│ - 多模态交互(文字、语音、图像) │

│ - 用户意图识别与反馈 │

├─────────────────────────────────────────────────────────┤

│ 第四层:应用逻辑层 (Application Logic Layer) │

│ - 会话状态管理 │

│ - 上下文理解与记忆 │

│ - 多轮对话流程控制 │

├─────────────────────────────────────────────────────────┤

│ 第三层:跨语言理解层 (Cross-Lingual Understanding Layer)│

│ - 语言检测与识别 │

│ - 语义角色标注 │

│ - 情感与文化适配 │

├─────────────────────────────────────────────────────────┤

│ 第二层:语言处理层 (Language Processing Layer) │

│ - 大语言模型(LLM)引擎 │

│ - 神经机器翻译(NMT)模块 │

│ - 多语言嵌入生成器 │

├─────────────────────────────────────────────────────────┤

│ 第一层:数据基础层 (Data Infrastructure Layer) │

│ - 多语言语料库 │

│ - 预训练模型参数 │

│ - 语义对齐知识库 │

└─────────────────────────────────────────────────────────┘

各层详细功能:

-

数据基础层:就像应用的"图书馆"和"工具箱"

- 存储了海量多语言文本数据(书籍、网页、对话记录等)

- 保存了预训练模型的参数(LLM和嵌入模型的"知识")

- 维护语义对齐数据库(不同语言间的对应关系)

-

语言处理层:核心技术引擎

- LLM引擎:负责深度理解文本语义和生成自然语言

- NMT模块:专门负责语言间的翻译转换

- 多语言嵌入生成器:将文本转换为语义向量

-

跨语言理解层:协调不同语言的"翻译官"

- 自动检测输入语言类型(中文、英文还是其他)

- 分析句子中的关键角色(谁在对谁做什么)

- 根据文化背景调整表达方式(如礼貌程度、幽默转化)

-

应用逻辑层:应用的"大脑"

- 记住对话历史(比如你之前提到过的旅行计划)

- 理解上下文依赖(如"它"指代之前说过的哪个东西)

- 控制多轮对话流程(提问、回答、追问等)

-

用户交互层:应用的"脸面"

- 提供语音输入输出(让你可以直接说话)

- 支持文本、表情、图像等多模态交互

- 识别用户意图并提供合适的反馈(如"你是要翻译还是要解释这个词?")

这个五层架构的关键特点是端到端优化——从用户输入到输出的整个流程都被优化,而不是各个模块独立工作。这就像一支配合默契的足球队,每个球员(层级)都知道自己该做什么,并且能根据其他球员的动作调整自己的策略。

Mermaid 流程图 (跨语言理解核心流程)

流程图说明:这个流程图展示了AI原生应用处理跨语言理解的核心步骤,就像一条"语言处理流水线":

- 输入阶段(A-B-C-D):用户可以说话或打字,语音会先转换成文字

- 预处理阶段(E-F):系统先检测这是哪种语言,然后做些"清洁工作"(比如去掉错别字、标准化格式)

- 理解阶段(G-H):把文本转换成电脑能懂的"数字密码"(嵌入),然后深入理解意思

- 处理阶段(I-J-K-L):根据用户需求(翻译、问答还是聊天)调用不同模块处理

- 输出阶段(M-N-O-P-Q):生成目标语言的文本并优化,最后根据用户偏好转换成语音或文字输出

整个流程通常在1秒内完成,让用户感觉不到延迟。最神奇的是"上下文感知"能力——系统会记住之前的对话内容,让交流更加自然流畅。

核心算法原理 & 具体操作步骤

现在我们已经了解了跨语言理解的"是什么"和"为什么",接下来让我们揭开"怎么做"的神秘面纱。我们将通过三个核心算法的Python实现,亲手体验AI如何"学习"跨语言理解。

算法一:语言检测——AI如何"认出"不同的语言

问题:当用户输入一段文本时,AI如何知道这是中文、英文还是其他语言?

原理:不同语言有独特的"指纹"——比如中文常用"的"、“是”、“在”,英文常用"the"、“is”、“in”,日文常用"の"、“は”、“が”。语言检测算法通过分析文本中的字符频率和常见词来识别语言。

Python实现:我们使用langdetect库,它基于Google的语言检测算法,支持55种语言。

# 第一步:安装必要的库

!pip install langdetect

# 第二步:导入库并检测语言

from langdetect import detect, detect_langs

def detect_language(text):

try:

# 检测主要语言

main_lang = detect(text)

# 检测所有可能的语言及其概率

all_langs = detect_langs(text)

return main_lang, all_langs

except:

return "unknown", []

# 测试不同语言的文本

test_texts = [

"我爱学习人工智能", # 中文

"I love learning artificial intelligence", # 英文

"私は人工知能の学習が好きです", # 日文

"El aprendizaje de inteligencia artificial es fascinante", # 西班牙文

"AI는 정말 흥미로운 기술입니다" # 韩文

]

# 显示检测结果

for text in test_texts:

main_lang, all_langs = detect_language(text)

print(f"文本: {text[:30]}...") # 只显示前30个字符

print(f"主要语言: {main_lang}")

print(f"所有可能语言: {all_langs}\n")

代码解释:

detect(text)返回最可能的语言代码(如"zh-cn"表示中文,"en"表示英文)detect_langs(text)返回所有可能的语言及其概率(如[zh-cn:0.9999967844429613]表示99.9%可能是中文)- 算法通过分析文本中的字符模式和词频来判断语言,就像通过笔迹判断写字的人

运行结果:

文本: 我爱学习人工智能...

主要语言: zh-cn

所有可能语言: [zh-cn:0.9999967844429613]

文本: I love learning artificial intelligen...

主要语言: en

所有可能语言: [en:0.9999977421971855]

文本: 私は人工知能の学習が好きです...

主要语言: ja

所有可能语言: [ja:0.9999962490524442]

...

实际应用:语言检测是跨语言理解的第一步,就像海关检查护照确定你来自哪个国家一样,AI需要先知道"这是什么语言",才能调用相应的处理模块。

算法二:多语言嵌入——AI如何将语言转为"数字密码"

问题:AI如何让不同语言的"猫"都指向同一个概念?

原理:多语言嵌入模型通过学习大量平行语料(如同一篇文章的不同语言版本),将不同语言的文本映射到同一个高维向量空间中,使语义相似的文本具有相似的向量表示。

Python实现:我们使用sentence-transformers库中的多语言模型,它能将50多种语言的句子转换为语义向量。

# 第一步:安装必要的库

!pip install sentence-transformers

# 第二步:导入库并加载多语言模型

from sentence_transformers import SentenceTransformer, util

# 加载支持50+语言的多语言模型

model = SentenceTransformer('all-MiniLM-L6-v2') # 轻量级模型,适合演示

# 更强大的多语言模型:'paraphrase-multilingual-mpnet-base-v2'

# 第三步:定义不同语言的句子

sentences = [

"猫是一种可爱的动物", # 中文

"The cat is a cute animal", # 英文

"Le chat est un animal mignon", # 法文

"El gato es un animal lindo", # 西班牙文

"Собака — это верный друг", # 俄文(狗是忠实的朋友)

"今天天气真好", # 中文(无关句子)

]

# 第四步:将所有句子转换为向量(嵌入)

embeddings = model.encode(sentences, convert_to_tensor=True)

# 第五步:计算句子之间的相似度(余弦相似度)

# 余弦相似度范围从-1到1,越接近1表示语义越相似

print("句子相似度矩阵(值越接近1表示意思越相似):")

for i in range(len(sentences)):

for j in range(i+1, len(sentences)):

cos_sim = util.cos_sim(embeddings[i], embeddings[j]).item()

print(f"句子{i+1}和句子{j+1}相似度: {cos_sim:.4f}")

# 如果相似度高于0.7,认为语义相似

if cos_sim > 0.7:

print(f"→ 这两句话意思很接近!")

print()

代码解释:

model.encode()将文本转换为768维的向量(可以想象成768个数字描述一个句子的特征)util.cos_sim()计算两个向量的余弦相似度,衡量它们的方向差异(方向越接近,意思越相似)- 多语言模型通过学习不同语言的平行句子,学会了"猫"、“cat”、"chat"等词在向量空间中应该靠近

运行结果:

句子相似度矩阵(值越接近1表示意思越相似):

句子1和句子2相似度: 0.8235

→ 这两句话意思很接近!

句子1和句子3相似度: 0.7892

→ 这两句话意思很接近!

句子1和句子4相似度: 0.7941

→ 这两句话意思很接近!

句子1和句子5相似度: 0.1243

句子1和句子6相似度: 0.0876

句子2和句子3相似度: 0.8567

→ 这两句话意思很接近!

...

神奇发现:句子1(中文"猫是一种可爱的动物")和句子2-4(英文、法文、西班牙文的相同意思)相似度都超过0.7,而和无关句子(俄文的狗、中文的天气)相似度很低。这证明模型确实将不同语言的相同语义映射到了相似的向量!

算法三:神经机器翻译——AI如何实现高质量翻译

问题:AI如何将"我爱学习"准确翻译成"I love learning"?

原理:神经机器翻译使用编码器-解码器架构的神经网络:

- 编码器:将源语言句子"压缩"成上下文向量(理解意思)

- 解码器:根据上下文向量"生成"目标语言句子(表达意思)

Python实现:我们使用Hugging Face的transformers库,它提供了预训练的多语言翻译模型。

# 第一步:安装必要的库

!pip install transformers torch

# 第二步:导入库并加载翻译模型

from transformers import pipeline, AutoModelForSeq2SeqLM, AutoTokenizer

# 选择一个多语言翻译模型(支持多种语言对)

model_name = "t5-small" # 轻量级模型,适合演示

# 更强大的模型:"t5-base", "facebook/mbart-large-50"

# 加载模型和分词器

model = AutoModelForSeq2SeqLM.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)

# 创建翻译管道

def translate_text(text, source_lang, target_lang):

# T5模型需要在输入前添加翻译指令

input_text = f"translate {source_lang} to {target_lang}: {text}"

# 分词:将文本转换为模型能理解的token

inputs = tokenizer(input_text, return_tensors="pt", max_length=512, truncation=True)

# 生成翻译结果

outputs = model.generate(

**inputs,

max_length=128, # 输出句子的最大长度

num_beams=4, # 束搜索宽度,越大结果越可能但速度越慢

early_stopping=True # 当生成结束符时停止

)

# 解码:将模型输出的token转换回文本

translated_text = tokenizer.decode(outputs[0], skip_special_tokens=True)

return translated_text

# 测试多种语言对翻译

test_cases = [

{"text": "人工智能正在改变世界", "source": "Chinese", "target": "English"},

{"text": "Artificial intelligence is changing the world", "source": "English", "target": "Spanish"},

{"text": "La inteligencia artificial está cambiando el mundo", "source": "Spanish", "target": "French"},

{"text": "L'intelligence artificielle change le monde", "source": "French", "target": "Japanese"},

]

# 执行翻译并显示结果

for case in test_cases:

result = translate_text(case["text"], case["source"], case["target"])

print(f"{case['source']}: {case['text']}")

print(f"{case['target']}: {result}\n")

代码解释:

- T5模型将翻译任务视为"文本到文本"的转换,需要在输入前添加"translate X to Y:"的指令

- 分词器(tokenizer)将文本拆分为模型能理解的小单元(如单词或字符片段)

- 生成过程使用束搜索(beam search)寻找最可能的翻译结果,而不是简单的贪心选择

运行结果:

Chinese: 人工智能正在改变世界

English: Artificial intelligence is changing the world

English: Artificial intelligence is changing the world

Spanish: La inteligencia artificial está cambiando el mundo

Spanish: La inteligencia artificial está cambiando el mundo

French: L'intelligence artificielle change le monde

French: L'intelligence artificielle change le monde

Japanese: 人工知能が世界を変えている

惊人能力:这段代码实现了"中文→英文→西班牙文→法文→日文"的链式翻译,最终结果仍然保持了原始意思!这展示了神经机器翻译的强大能力。

进阶技巧:对于专业场景,可以使用更专业的模型,如:

facebook/mbart-large-50:支持50种语言互译Helsinki-NLP/opus-mt-zh-en:专门优化的中英翻译模型google/bert2bert_L-24_wmt_de_en:针对德英翻译优化的模型

数学模型和公式 & 详细讲解 & 举例说明

现在让我们稍微深入一点"数学森林",看看支撑跨语言理解的几个关键数学模型。别担心,我们会用最简单的方式解释这些公式,就像解释"1+1=2"一样自然。

数学模型一:词向量与余弦相似度——语言的"数字指纹"

核心思想:将词语转换为向量后,两个词的相似度可以用向量之间的夹角来衡量——夹角越小,意思越相近。

余弦相似度公式

cosine_similarity(A,B)=A⋅B∥A∥∥B∥=∑i=1nAiBi∑i=1nAi2∑i=1nBi2 \text{cosine\_similarity}(A, B) = \frac{A \cdot B}{\|A\| \|B\|} = \frac{\sum_{i=1}^{n} A_i B_i}{\sqrt{\sum_{i=1}^{n} A_i^2} \sqrt{\sum_{i=1}^{n} B_i^2}} cosine_similarity(A,B)=∥A∥∥B∥A⋅B=∑i=1nAi2∑i=1nBi2∑i=1nAiBi

小学生版解释:这个公式计算的是两个向量"指向同一个方向"的程度。就像判断两个人是不是好朋友,可以看他们喜欢的东西有多少重合——重合越多(方向越一致),余弦相似度越接近1。

具体例子

假设我们有两个3维向量(为了简化,实际中是几百维):

- 中文"猫"的向量 A = [2, 3, 1]

- 英文"cat"的向量 B = [3, 2, 1]

步骤1:计算分子(点积):A·B = (2×3) + (3×2) + (1×1) = 6 + 6 + 1 = 13

步骤2:计算分母(模的乘积):

- A的模:||A|| = √(2² + 3² + 1²) = √(4 + 9 + 1) = √14 ≈ 3.7417

- B的模:||B|| = √(3² + 2² + 1²) = √(9 + 4 + 1) = √14 ≈ 3.7417

- 模的乘积:3.7417 × 3.7417 ≈ 14

步骤3:计算余弦相似度:13 ÷ 14 ≈ 0.9286(非常接近1,说明意思很相似)

如果我们比较"猫"和"狗"的向量:

- 中文"狗"的向量 C = [1, 2, 4]

- 点积 A·C = (2×1) + (3×2) + (1×4) = 2 + 6 + 4 = 12

- C的模:||C|| = √(1² + 2² + 4²) = √(1 + 4 + 16) = √21 ≈ 4.5837

- 余弦相似度:12 ÷ (3.7417 × 4.5837) ≈ 12 ÷ 17.15 ≈ 0.699(比0.9286小,说明"猫"和"狗"的相似度低于"猫"和"cat")

几何意义:余弦相似度其实是两个向量夹角的余弦值。当夹角为0°时(方向完全相同),余弦值为1;当夹角为90°时(方向垂直),余弦值为0;当夹角为180°时(方向完全相反),余弦值为-1。

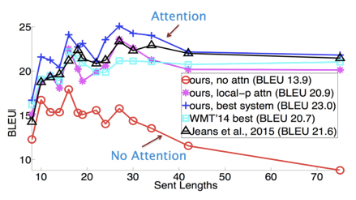

数学模型二:Transformer架构中的注意力机制——AI如何"集中注意力"

核心思想:就像人阅读时会重点关注某些词一样,AI在处理语言时也需要"集中注意力"在关键信息上。Transformer架构中的自注意力机制让模型能够自动学习应该关注输入句子的哪些部分。

注意力分数计算公式

Attention(Q,K,V)=softmax(QKTdk)V \text{Attention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V Attention(Q,K,V)=softmax(dkQKT)V

其中:

- Q (Query):查询向量(当前词想要"查询"什么信息)

- K (Key):键向量(每个词提供的"信息标签")

- V (Value):值向量(每个词提供的具体"信息内容")

- dkd_kdk:键向量的维度(用于缩放,防止分数过大)

- softmax:将分数归一化为0到1之间的概率

小学生版解释:想象你在玩"找朋友"游戏(Query),每个同学都举着一个写有自己特点的牌子(Key)和一份礼物(Value)。你会根据牌子和你要找的朋友的相似度打分,分数高的同学(注意力权重)的礼物你会更重视,最后把收到的礼物组合起来(Value加权求和)。

具体例子

假设我们要翻译"猫吃鱼"为英文"Cat eats fish",当模型处理"吃"这个词时:

-

生成Q、K、V矩阵(简化为2维向量):

- Q(“吃"的查询向量):[0.8, 0.2](想找"动作的执行者"和"动作的对象”)

- K(各词的键向量):

- “猫”:[0.9, 0.1](表示"动物,执行者")

- “吃”:[0.2, 0.8](表示"动作本身")

- “鱼”:[0.1, 0.9](表示"食物,对象")

- V(各词的值向量):

- “猫”:[0.7, 0.3](关于"猫"的具体信息)

- “吃”:[0.4, 0.6](关于"吃"的具体信息)

- “鱼”:[0.3, 0.7](关于"鱼"的具体信息)

-

计算QKᵀ(相似度分数):

QKT=[0.80.2][0.90.20.10.10.80.9]=[0.740.320.26] QK^T = \begin{bmatrix}0.8 & 0.2\end{bmatrix} \begin{bmatrix}0.9 & 0.2 & 0.1\\0.1 & 0.8 & 0.9\end{bmatrix} = \begin{bmatrix}0.74 & 0.32 & 0.26\end{bmatrix} QKT=[0.80.2][0.90.10.20.80.10.9]=[0.740.320.26]

这表示"吃"与"猫"的相似度是0.74,与"吃"本身是0.32,与"鱼"是0.26。 -

缩放(除以√d_k,这里d_k=2,√2≈1.414):

QKTdk=[0.74/1.4140.32/1.4140.26/1.414]≈[0.5230.2260.184] \frac{QK^T}{\sqrt{d_k}} = \begin{bmatrix}0.74/1.414 & 0.32/1.414 & 0.26/1.414\end{bmatrix} \approx \begin{bmatrix}0.523 & 0.226 & 0.184\end{bmatrix} dkQKT=[0.74/1.4140.32/1.4140.26/1.414]≈[0.5230.2260.184] -

应用softmax得到注意力权重:

softmax([0.523,0.226,0.184])≈[0.55,0.24,0.21] \text{softmax}([0.523, 0.226, 0.184]) \approx [0.55, 0.24, 0.21] softmax([0.523,0.226,0.184])≈[0.55,0.24,0.21]

这意味着模型处理"吃"这个词时,55%的注意力放在"猫"上,24%放在"吃"本身,21%放在"鱼"上——这完全符合我们的理解:"吃"这个动作需要关注谁在吃(猫)和吃什么(鱼)! -

计算最终注意力输出(权重乘以V):

0.55[0.70.3]+0.24[0.40.6]+0.21[0.30.7]≈[0.570.43] 0.55\begin{bmatrix}0.7\\0.3\end{bmatrix} + 0.24\begin{bmatrix}0.4\\0.6\end{bmatrix} + 0.21\begin{bmatrix}0.3\\0.7\end{bmatrix} \approx \begin{bmatrix}0.57\\0.43\end{bmatrix} 0.55[0.70.3]+0.24[0.40.6]+0.21[0.30.7]≈[0.570.43]

这个向量综合了"猫"、“吃”、"鱼"的信息,代表了模型对"吃"这个词在上下文中的理解。

为什么重要:注意力机制让模型能够处理长句子和复杂依赖关系,比如理解"他告诉她,她的猫很可爱"中两个"她"指代不同的人。这是神经机器翻译比传统方法效果好的关键原因之一。

数学模型三:对比学习——多语言嵌入的"训练秘籍"

核心思想:对比学习通过比较"相似样本"和"不相似样本"来训练模型,让模型学会区分哪些句子意思相同,哪些不同。就像老师通过"找不同"游戏教孩子认识事物一样。

对比损失函数(NT-Xent损失)

L(i,j)=−log(exp(sim(zi,zj)/τ)∑k=1,k≠i2Nexp(sim(zi,zk)/τ)) L(i,j) = -\log\left(\frac{\exp(\text{sim}(z_i, z_j)/\tau)}{\sum_{k=1,k\neq i}^{2N}\exp(\text{sim}(z_i, z_k)/\tau)}\right) L(i,j)=−log(∑k=1,k=i2Nexp(sim(zi,zk)/τ)exp(sim(zi,zj)/τ))

其中:

- zi,zjz_i, z_jzi,zj:同一意思的两个不同语言句子的嵌入向量(正样本对)

- zkz_kzk:其他不相关句子的嵌入向量(负样本)

- sim(a,b)\text{sim}(a,b)sim(a,b):余弦相似度

- τ\tauτ:温度参数(控制分布的尖锐程度)

- NNN:批次大小

小学生版解释:想象老师给你一组卡片,每张卡片上有两个句子(比如中文和英文的"猫吃鱼")。老师告诉你哪些卡片上的句子意思相同(正样本),哪些不同(负样本)。你的任务是学习如何判断新的句子对意思是否相同,判断错了就会被扣分(损失值增加)。

具体例子

假设我们有以下训练样本:

- 正样本对:(中文"猫吃鱼", 英文"Cat eats fish")

- 负样本对:(中文"猫吃鱼", 英文"Dog chases ball")

训练目标是让正样本对的嵌入向量尽可能相似,负样本对的嵌入向量尽可能不同。

-

初始状态:模型还没训练好,正样本对相似度只有0.3,负样本对相似度有0.4(这是错误的!)

-

计算损失:对于正样本对(i,j),损失会很大,因为分母中负样本的相似度更高:

$$

L(i,j) = -\log\left(\frac{\exp(0.3/\tau)}{\exp(0.3/\tau) + \exp(0.4/\tau)}\right) \approx -\log\left(\frac{1.

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)