目标检测:Faster R-CNN

self.cls_score = nn.Conv2d(512, num_anchors * 2, kernel_size=1) # 2 类(背景/前景)self.bbox_pred = nn.Conv2d(512, num_anchors * 4, kernel_size=1) # 边界框偏移# 特征提取网络# RPN# 分类和边界框回归的全连接层# 特征提取# RPN 前向传播# 生成候选区域(

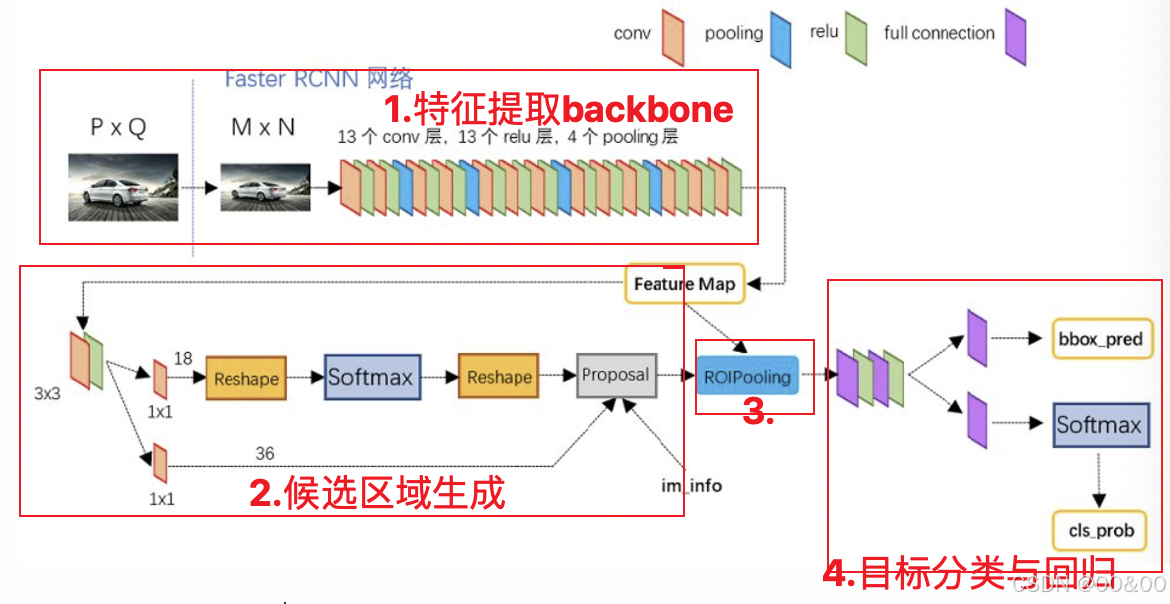

Faster R-CNN(Faster Region Convolutional Neural Network)是一种高效的深度学习模型,专门用于目标检测任务。它在速度和精度上都取得了显著的改进,成为许多计算机视觉应用的基础。以下是对Faster R-CNN的深入讲解:

1. 背景和发展

Faster R-CNN 是 R-CNN(Region-based Convolutional Neural Networks)系列模型的第三个版本,由 Shaoqing Ren 等人在2015年提出。R-CNN系列的目标是通过卷积神经网络(CNN)提取图像特征,并结合候选区域(Region Proposal)来完成目标检测。早期的 R-CNN 和 SPPnet 依赖于选择性搜索来生成候选区域,这一过程较为耗时。Faster R-CNN 通过引入区域建议网络(RPN),实现了候选区域生成的端到端训练,显著提高了检测速度,使得目标检测变得更加实用和高效。

2. 模型结构

Faster R-CNN 的主要组成部分包括:

2.1. 特征提取网络(Backbone)

Faster R-CNN 通常使用预训练的卷积神经网络(如 VGG16、ResNet 等)作为特征提取器。这些网络负责从输入图像中提取丰富的特征图(feature maps),这些特征图包含了图像的语义信息和空间信息,后续的区域建议和目标分类都依赖于这些特征。

2.2. 区域建议网络(RPN)

区域建议网络(RPN)是Faster R-CNN 的核心组件,负责从特征图中生成候选区域(Region of Interest, RoIs)。RPN 的工作流程如下:

锚框(Anchors):在特征图的每个位置生成多个锚框,锚框具有不同的大小和纵横比。

分类子网:对每个锚框进行分类,判断其是否包含目标(前景)或背景。

回归子网:对每个锚框进行位置回归,精细调整锚框的坐标,使其更接近真实目标的边界框。

RPN 的输出是可能包含目标的候选区域,这些区域将被送入后续的处理阶段。

2.3. RoI Pooling

获取候选区域后,Faster R-CNN 使用 ROI Pooling 操作,将这些区域映射到固定大小的特征图(通常是 7x7),以便为每个候选区域提供一致的特征表示。这一过程确保了不同大小的候选区域能够被统一处理,从而便于后续的分类和回归。

2.4. 分类与回归层

经过 RoI Pooling 后,得到的特征会被送入全连接层(Fully Connected Layers),进行目标的分类和边界框回归:

分类层:输出每个候选区域的类别概率。

回归层:输出每个候选区域的精确边界框坐标。

3. 损失函数

Faster R-CNN 的训练过程依赖于多任务损失(Multitask Loss),通常分为四部分:

3.1 目标分类损失:计算目标类别的预测损失,通常使用交叉熵损失。

3.2 边界框回归损失:计算检测框与真实框之间的 L1 损失或 Smooth L1 损失。

3.3 RPN 分类损失:与目标分类损失相同,但用于 RPN 的输出。

3.4 RPN 回归损失:与边界框回归损失相同,但用于 RPN 的输出。

这四个损失组合在一起,形成总损失,模型通过梯度下降法不断优化这些参数。

4. 性能和应用

Faster R-CNN 在多个目标检测基准(如 PASCAL VOC 和 MS COCO)上表现出色,速度快且精确,显著超越了早期的 R-CNN 和 SPPnet。

应用场景

自动驾驶:检测和跟踪行人、车辆等对象,确保安全驾驶。

视频监控:实时监控场景中的各种对象,辅助安防系统。

无人机监测:在难以接触的区域进行监测,识别特定对象。

医学影像分析:检测医疗图像中的病灶或异常,辅助医生诊断。

5. 优缺点

5.1 优点

高效性:通过 RPN 提高了目标检测速度,无需使用选择性搜索,减少了计算开销。

精确性:结合多层特征提取,具有较高的识别精度,适用于各种场景。

5.2 缺点

计算资源需求高:需要较高的计算能力,尤其在处理高分辨率图像时,可能需要强大的 GPU 支持。

小目标检测精度不足:在小目标检测时,可能面临精度下降的问题,尤其是在复杂背景下。

6. Faster R-CNN 的代码实现

以下是一个简单的 Faster R-CNN 的实现示例,使用 PyTorch 框架:

6.1 导入必要的库

import torch

import torch.nn as nn

import torchvision.models as models

import torchvision.ops as ops6.2 定义区域建议网络 RPN

class RPN(nn.Module):

def __init__(self, in_channels, num_anchors):

super(RPN, self).__init__()

self.conv = nn.Conv2d(in_channels, 512, kernel_size=3, padding=1)

self.cls_score = nn.Conv2d(512, num_anchors * 2, kernel_size=1) # 2 类(背景/前景)

self.bbox_pred = nn.Conv2d(512, num_anchors * 4, kernel_size=1) # 边界框偏移

def forward(self, x):

x = nn.functional.relu(self.conv(x))

cls_scores = self.cls_score(x)

bbox_preds = self.bbox_pred(x)

return cls_scores, bbox_preds6.3 定义 Faster R-CNN 模型

class FasterRCNN(nn.Module):

def __init__(self, num_classes, num_anchors):

super(FasterRCNN, self).__init__()

# 特征提取网络

self.backbone = models.vgg16(pretrained=True).features

# RPN

self.rpn = RPN(in_channels=512, num_anchors=num_anchors)

# RoI Pooling

self.roi_pool = ops.MultiScaleRoIAlign(output_size=(7, 7), sampling_ratio=2)

# 分类和边界框回归的全连接层

self.fc_cls = nn.Linear(512 * 7 * 7, num_classes)

self.fc_reg = nn.Linear(512 * 7 * 7, num_classes * 4)

def forward(self, images, rois):

# 特征提取

features = self.backbone(images)

# RPN 前向传播

rpn_cls_scores, rpn_bbox_preds = self.rpn(features)

# 生成候选区域(RoIs),此部分需要结合先验知识或提高代码的复杂性

# 示例中仅展示结构,实际中应从 RPN 输出选择

rois = self.generate_rois(rpn_cls_scores) # 需要实现

# RoI Pooling

pooled_features = self.roi_pool(features, rois, images.shape[2:])

# 分类和回归

pooled_features = pooled_features.view(pooled_features.size(0), -1)

cls_scores = self.fc_cls(pooled_features)

bbox_preds = self.fc_reg(pooled_features)

return cls_scores, bbox_preds, rpn_cls_scores, rpn_bbox_preds6.4 定义损失函数

def faster_rcnn_loss(cls_scores, bbox_preds, rpn_cls_scores, rpn_bbox_preds, targets):

# 计算分类损失和边界框损失,可扩展实现 RPN 损失

cls_loss = nn.CrossEntropyLoss()(cls_scores, targets['labels'])

bbox_loss = nn.SmoothL1Loss()(bbox_preds, targets['boxes'])

rpn_cls_loss = nn.CrossEntropyLoss()(rpn_cls_scores, targets['rpn_labels'])

rpn_bbox_loss = nn.SmoothL1Loss()(rpn_bbox_preds, targets['rpn_boxes'])

total_loss = cls_loss + bbox_loss + rpn_cls_loss + rpn_bbox_loss

return total_loss6.5 训练模型

def train_faster_rcnn(model, dataloader, optimizer, num_epochs):

model.train()

for epoch in range(num_epochs):

for images, targets in dataloader:

optimizer.zero_grad()

cls_scores, bbox_preds, rpn_cls_scores, rpn_bbox_preds = model(images, targets['rois'])

# 计算损失

loss = faster_rcnn_loss(cls_scores, bbox_preds, rpn_cls_scores, rpn_bbox_preds, targets)

loss.backward()

optimizer.step()

print(f"Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item():.4f}")6.6 使用示例

# 假设我们有一个数据加载器 dataloader

# num_classes 是目标类别的数量,num_anchors 是锚框的数量

num_classes = 21 # 20 个物体类别 + 1 个背景类别

num_anchors = 9 # 3 种尺度 x 3 种纵横比

model = FasterRCNN(num_classes, num_anchors)

optimizer = torch.optim.SGD(model.parameters(), lr=0.001, momentum=0.9)

# 训练模型

train_faster_rcnn(model, dataloader, optimizer, num_epochs=10)Faster R-CNN 通过引入 RPN,实现了高效的目标检测。在此示例中,展示了如何使用 PyTorch 实现基本的 Faster R-CNN 架构。实际应用中,需要更多细节(如 RPN 输出的候选区域选择与处理),同时对检测精度进行调优和优化。

7. 未来发展

随着深度学习和计算机视觉技术的不断进步,Faster R-CNN 也在不断演变。新的模型和技术(如 YOLO 和 SSD)开始出现,提供了更快的速度或更高的实时性。同时,Faster R-CNN 的变体也在不断产生,以适应不同应用和需求,例如:

轻量化模型:为移动设备和边缘计算优化的版本。

多任务学习:同时进行目标检测和其他任务(如图像分割)的模型。

总的来说,Faster R-CNN 是目标检测领域的重要里程碑,推动了相关研究和应用的发展,并为后续的算法提供了坚实的基础。它的成功不仅在于检测精度的提高,还在于通过端到端训练的方式简化了目标检测的流程。

更多推荐

已为社区贡献59条内容

已为社区贡献59条内容

所有评论(0)