【亲测免费】 Unbabel COMET:多语言翻译质量评估模型

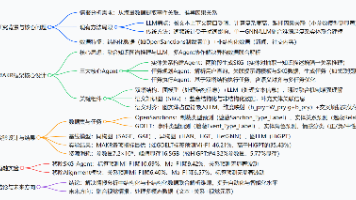

Unbabel COMET:多语言翻译质量评估模型项目介绍Unbabel's COMET 是一个先进的机器翻译(Machine Translation, MT)质量评估框架,它利用神经网络模型来预测翻译的主观质量,而不仅仅是依赖简单的编辑距离或词对齐等传统方法。COMET设计用于支持多种评价任务,如自动评价翻译的整体质量、特定方面的质量和跨语言能力。它通过在大规模标注数据上训练,提供了比传统的..

Unbabel COMET:多语言翻译质量评估模型

项目介绍

Unbabel's COMET 是一个先进的机器翻译(Machine Translation, MT)质量评估框架,它利用神经网络模型来预测翻译的主观质量,而不仅仅是依赖简单的编辑距离或词对齐等传统方法。COMET设计用于支持多种评价任务,如自动评价翻译的整体质量、特定方面的质量和跨语言能力。它通过在大规模标注数据上训练,提供了比传统的基于规则或统计的质量评估指标更精细和准确的反馈。

项目快速启动

安装

首先,确保你的系统已安装了Python 3.7或更高版本,然后使用pip安装COMET:

pip install comet-core

对于最新特性或者想要从源码编译安装,可以从GitHub克隆仓库并安装:

git clone https://github.com/Unbabel/COMET.git

cd COMET

pip install -r requirements.txt

python setup.py install

使用示例

以下是如何使用COMET对一对翻译实例进行评估的基本步骤:

from comet_ml import Model

model = Model(

model_name="wmt20-comet-da",

output_path="your/output/path"

)

translation = "这是一个翻译的例子。"

reference = "This is a translation example."

result = model.predict([({

'src': reference,

'mt': translation

}], aggregate=False)

print(result)

这将返回一个质量分数,表示给定翻译相对于参考文本的质量。

应用案例和最佳实践

COMET广泛应用于机器翻译系统的开发和优化中。开发者可以通过对比自己的翻译系统输出与专业人工翻译的结果,得到量化反馈,进而调整模型参数以提高翻译质量。此外,COMET也能帮助研究人员进行系统比较,在机器翻译比赛(如WMT)中作为官方评价工具之一,其最佳实践包括:

- 数据预处理:确保输入给COMET的源文本和机器翻译文本已经过适当的清理和标准化。

- 选择合适模型:根据特定的语言对和应用场景选用最相关的COMET模型版本。

- 持续监控:在机器翻译服务运行期间,定期使用COMET评估产出,及时发现质量下滑。

典型生态项目

COMET的生态系统包含了与之协同工作的各种工具和服务,例如:

- MT评估工作流集成:COMET可以无缝集成到现有的机器翻译项目工作流程中,比如通过API调用自动化评估过程。

- 研究与竞赛:它是多项机器翻译基准测试(如WMT)的核心组件,促进了MT领域内模型性能的比较和研究发展。

- 定制化评估模型:高级用户可以基于COMET框架,训练特定于某种行业领域或风格的翻译质量评估模型。

通过这样的整合和应用,COMET不仅提升了翻译质量评估的效率,也推动了机器翻译技术的前沿探索和实际应用。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)