[论文阅读] 人工智能+ | 突破LLM情报分析瓶颈!MAKR多Agent框架让长文本因果推理更精准

针对大语言模型(LLM)处理情报分析长文本时,因上下文窗口和计算复杂度限制导致因果推理能力弱的问题,本文提出多Agent协作的知识推理(MAKR)框架。该框架通过实体关系构建Agent增量生成语义知识图(SKG),显式建模实体关联;采用双塔结构让图模型与LLM分别处理图结构和文本信息,经融合机制增强逻辑理解;结合任务规划Agent解析查询、任务执行Agent优化语义对齐。在GDELT和OpenSa

突破LLM情报分析瓶颈!MAKR多Agent框架让长文本因果推理更精准

一、论文信息

| 项目 | 详情 |

|---|---|

| 论文原标题 | 多Agent协作的知识推理框架 |

| 主要作者 | 王日龙、李振平、李晓松、高强、何亚、钟勇、赵英潇 |

| 研究机构 | 1. 军事科学院军事科学信息研究中心(北京 100142);2. 上海交通大学电子信息与电气工程学院(上海 200200);3. 中国科学院成都计算机应用研究所(成都 610213) |

| APA引文格式 | Wang, R. L., Li, Z. P., Li, X. S., Gao, Q., He, Y., Zhong, Y., & Zhao, Y. X. (2025). 多Agent协作的知识推理框架 [Framework of Multi-Agent Collaborative Knowledge Reasoning]. 计算机应用 [Journal of Computer Applications]. https://doi.org/10.11772/j.issn.1001-9081.2025030349 |

| 收稿/网络首发日期 | 收稿:2025-04-03;网络首发:2025-08-06 |

二、一段话总结

针对当前大语言模型(LLM)处理情报分析长文本时,因上下文窗口有限、计算复杂度高而难以捕捉事件因果关联的问题,研究团队提出多Agent协作的知识推理(MAKR)框架。该框架通过增量构建语义知识图(SKG)显式建模实体关联,采用双塔结构让图模型与LLM分别处理图结构和文本信息,再经融合机制增强逻辑理解;同时设计实体关系构建、任务规划、任务执行三大Agent,新增图节点关系预测优化语义对齐。在GDELT(安全事件分析)和OpenSanctions(制裁关联分析)数据集实验中,MAKR在事件预测、因果推断的Mi-F1、Ma-F1、AUC等指标上显著优于HetGNN、HiGPT等基线模型,虽参数量(7.2×10⁹)和显存(16.5GB)略高于HiGPT,但精度提升与资源消耗呈合理权衡,验证了其在计算资源受限工业场景的实用价值。

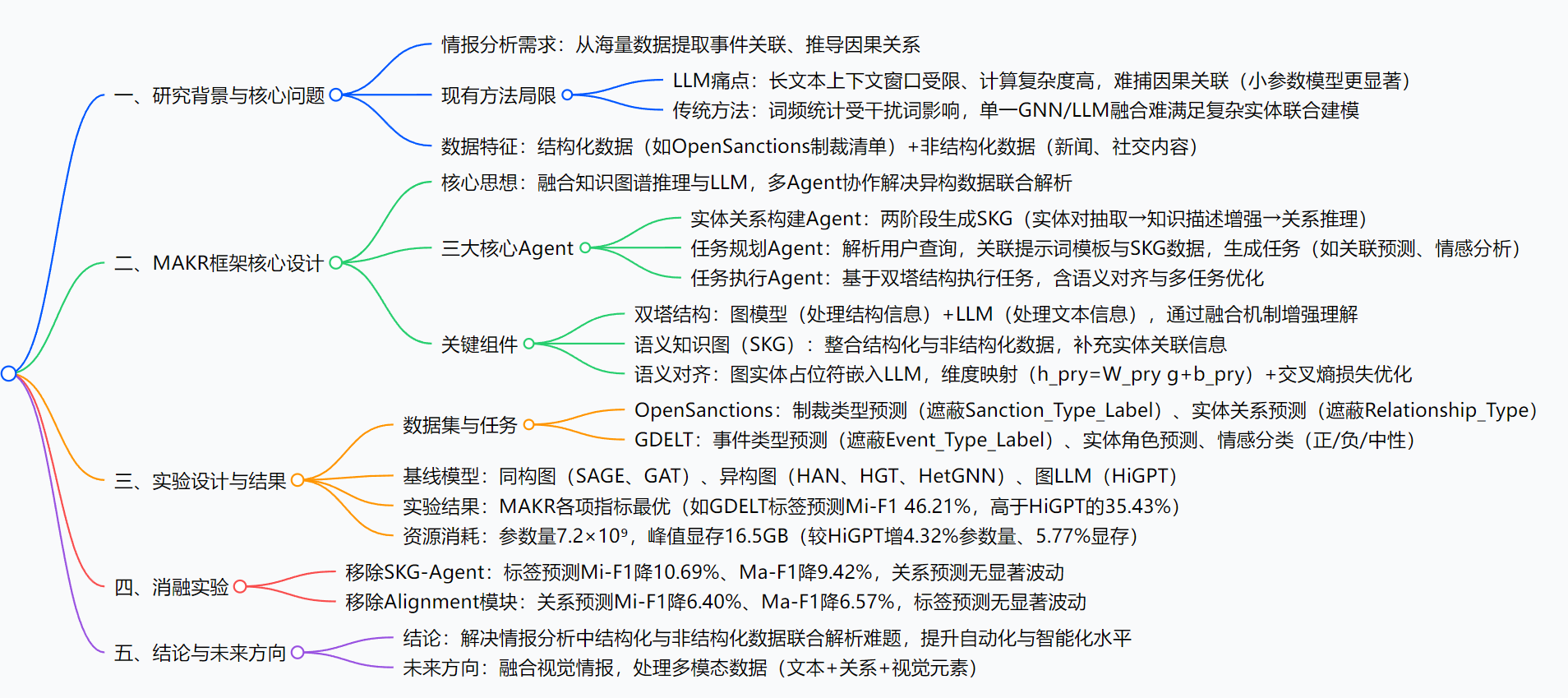

三、思维导图

四、研究背景

想象一下:情报分析师需要从100篇关于“跨国制裁”的新闻、50份联合国制裁清单中,弄清楚“某个人为何被制裁、关联了哪些组织”——这就像在一本没有目录的厚书里找关键线索,传统工具总有“力不从心”的时候。

从技术角度看,情报分析领域的核心难题源于数据复杂性与工具局限性的矛盾:

- 数据“混搭”难处理:数据分两类——结构化数据(如OpenSanctions里的“某组织被美国制裁”清单,关系明确)和非结构化数据(如新闻里“该组织涉嫌为恐怖分子转账”的描述,信息零散但关键),传统方法要么只懂处理结构化数据,要么对非结构化文本“抓不住重点”;

- LLM“记不住”长文本:现在常用的LLM(如ChatGPT类模型)处理长文本时,会像人读长文章一样“前面记后面忘”——比如分析“John Doe被制裁”时,LLM可能漏看3篇文档前提到的“他与某敏感组织的关联”,导致推理出现“逻辑断裂”,甚至得出错误结论;

- 传统模型“单打独斗”:有的模型(如图神经网络GNN)擅长处理实体关系,但不懂文本语义;有的模型(如LLM)懂文本,但不会“梳理”实体间的复杂关联,两者融合时也常出现“信息割裂”,没法协同解决问题。

这些问题导致情报分析效率低、误差高,尤其在“跨国威胁检测”“战略态势推演”等关键场景,哪怕一个小错误都可能影响决策——这就是MAKR框架要解决的核心痛点。

五、创新点

MAKR框架的“厉害之处”,在于它不像传统模型“单打独斗”,而是用“团队协作+精准分工”的思路突破瓶颈,核心创新有3个:

- “增量建图”补全信息:专门设计“实体关系构建Agent”,像分析师的“助手”一样,从非结构化文本里“挑重点”——先提取实体(如“Kiev”“Washington”),再补充实体描述(如“Kiev是乌克兰首都”),最后生成“语义知识图(SKG)”,把零散的文本信息变成“实体-关系”清晰的“地图”,让LLM不再“记混线索”;

- “双塔结构”分工协作:就像两个专家各司其职又互相配合——“图塔”(GNN模型)专门分析SKG里的实体关系(如“谁制裁谁”),“文本塔”(LLM)专门理解文本语义(如“制裁原因”),最后通过“门控注意力机制”把两者的结论融合,既避免了“图塔不懂文本”“文本塔不懂关系”的问题,又增强了对复杂逻辑的理解;

- “多Agent+多任务”双保险:除了“建图Agent”,还设计了“任务规划Agent”(帮用户把“模糊查询”变成“明确任务”,比如把“查某制裁”变成“预测制裁类型+找关联实体”)和“任务执行Agent”(用双塔结构执行任务);同时,在训练时新增“图节点关系预测任务”,让模型既学“理解文本”,又学“梳理关系”,进一步优化语义与结构的对齐效果。

六、研究方法和思路

MAKR框架的实现逻辑可以拆成“3步走”,每一步都对应一个核心Agent,流程清晰且可落地:

第一步:准备工作——定义基础规则

先明确两个关键定义,为后续工作“搭架子”:

- 问题定义:Agent的工作流程用公式表示为 (Y=f(O | Agent)),其中(O)是输入(结构化图数据+非结构化文本),(Y)是输出(如“某实体的制裁类型”);

- 异质图定义:把所有数据都变成“图”的形式——用(G=(V, E, N, R))表示,(V)是实体(如人、组织),(E)是实体间的联系(如“制裁”“隶属”),(N/R)是实体/联系的类型,比如“John Doe(人)-制裁自-联合国(机构)”就是一条边。

第二步:核心Agent工作流程

1. 实体关系构建Agent:生成SKG(语义知识图)

相当于“整理线索”,分2步:

- 步骤1:抽实体对——用提示词(如“提取文本中的人和组织”)从文本里找出核心实体对((v))和初步联系((e)),公式为 (v, e= Agent(Promt _{v}, x))((x)是输入文本);

- 步骤2:补全关系——为实体加描述(如“John Doe,男,1980年生”),帮模型理解上下文,再推理出具体关系((r)),公式为 (content = Agent(Promt _{k}, x, v))、(r= Agent(Promt, content, v));

- 最终:把(v)(实体)、(r)(关系)、(e)(联系)、(content)(描述)合并,生成SKG。

2. 任务规划Agent:明确“要做什么”

相当于“拆解任务”,分2步:

- 步骤1:解析查询——用户说“查某制裁”,Agent会拆成“预测制裁类型”“找关联实体”等具体任务;

- 步骤2:绑定数据与提示词——从SKG里挑相关数据,套入提示词模板(如“基于Entity_ID、Country预测Sanction_Type_Label”),用LLM生成任务指令,公式为 (data =LLM (q, g, Prompt _{r}))((q)是用户查询,(g)是SKG数据)。

3. 任务执行Agent:用双塔结构“干活”

相当于“落地分析”,分3步:

- 步骤1:异构数据读取——“文本塔”(LLM)处理SKG里的文本描述,公式为 (x_{es }=LLM(x, Prompt_t));“图塔”(GNN)处理SKG里的实体关系,公式为 (g_{cub }=Graph(v, e, n, r));

- 步骤2:语义对齐——把图里的实体变成LLM能懂的“语言”:用占位符(如“[实体1]”)嵌入LLM输入,再通过公式 (h_{pry }=W_{pry } g+b_{pry }) 把图实体的维度转成和LLM一致;

- 步骤3:多任务优化——同时训练两个任务:LLM优化文本预测(用交叉熵损失),GNN优化关系预测(公式为 (\theta_{p=0}^{*}=argmin(-\sum log P(r_0|e_i,e_j)))),让模型“两手都硬”。

第三步:模型训练与优化

所有Agent基于DeepSeek-R1(任务规划、图生成)和Llama3-7b(任务执行)构建,用Sentence-BERT生成文本嵌入,确保语义表示稳定;训练时用9000条数据训练、1000条验证、1500条测试,保证结果可靠。

七、主要成果和贡献

1. 核心成果

| 核心问题(RQ) | 实验设置 | 关键结论 |

|---|---|---|

| RQ1:MAKR在情报分析任务中性能是否优于现有模型? | 数据集:OpenSanctions(制裁类型/关系预测)、GDELT(事件类型/角色预测);基线模型:SAGE、GAT、HAN、HGT、HetGNN、HiGPT;指标:Mi-F1、Ma-F1、AUC | MAKR所有指标最优: - OpenSanctions标签预测Mi-F1 47.21%(HiGPT 45.40%); - GDELT关系预测Mi-F1 46.23%(HiGPT 33.88%); 平均较HiGPT提升超4.5% |

| RQ2:MAKR的资源消耗是否合理? | 硬件:NVIDIA A100 80GB GPU;对比模型:GAT、HetGNN、HiGPT | 资源消耗略高于HiGPT,但性价比高: - 参数量7.2×10⁹(HiGPT 6.9×10⁹,增4.32%); - 峰值显存16.5GB(HiGPT 15.6GB,增5.77%); 精度提升可降低人工复核成本 |

| RQ3:SKG-Agent和Alignment模块的作用? | 消融实验:①移除SKG-Agent;②移除Alignment模块 | - SKG-Agent是标签预测核心:移除后标签预测Mi-F1降10.69%; - Alignment是关系预测核心:移除后关系预测Mi-F1降6.40% |

2. 领域贡献

- 对情报分析:以前分析师要花几天整理的“制裁网络”“事件关联”,MAKR能自动梳理,还能避免“漏看线索”,让分析更准、更快,尤其适合“资源有限”的场景(如中小机构没有超算);

- 对技术领域:解决了“GNN不懂文本、LLM不懂关系”的融合难题,提出的“多Agent+双塔结构”思路,能为其他需要“异构数据联合分析”的领域(如金融风险检测、医疗数据挖掘)提供参考;

- 落地价值:已经在“安全事件分析”(GDELT)和“制裁关联分析”(OpenSanctions)两个真实场景验证有效,不是“纸上谈兵”,未来加视觉数据后,还能处理“卫星图像+文本报告”这类更复杂的情报。

3. 开源信息

论文中未提及开源代码或数据集地址,仅提到OpenSanctions数据集可通过官方网站(https://www.opensanctions.org/)获取。

八、关键问题

Q1:MAKR框架主要解决了LLM在情报分析中的什么核心问题?

A1:主要解决LLM的“长文本因果推理弱”问题——LLM处理长文本时,因上下文窗口有限,无法捕捉跨文档的实体关联(如A文档提“某组织涉恐”,B文档提“该组织与John Doe有关”,LLM可能没关联起来),导致推理“逻辑断裂”;MAKR通过生成SKG显式建模实体关系,再用双塔结构融合图与文本信息,让LLM能“看到”完整的关联链条,提升因果推理精度。

Q2:在OpenSanctions数据集的制裁类型预测任务中,MAKR比HiGPT强在哪里?

A2:主要强在“精度更高”且“兼顾资源”:在制裁类型预测的Mi-F1(对小类别敏感)、Ma-F1(对大类别敏感)、AUC(抗样本不均衡)三个关键指标上,MAKR分别为47.21%、42.82%、62.10%,HiGPT分别为45.40%、41.77%、59.69%——MAKR在小类别制裁类型(如“武器禁运”)和大类别制裁类型(如“经济制裁”)的预测上都更准,且抗数据不均衡的能力更强,同时资源消耗仅小幅增加。

Q3:MAKR的“双塔结构”和传统的“GNN+LLM”融合方法有什么不同?

A3:传统融合方法常把GNN的输出直接“喂给”LLM,容易出现“信息割裂”(GNN的关系信息没被LLM充分理解);而MAKR的双塔结构是“分工+对齐”:①分工:“图塔”只处理实体关系,“文本塔”只处理文本,避免互相干扰;②对齐:通过“占位符嵌入+维度映射”,把图实体转成LLM能懂的“语言”,再用自注意力网络让两者语义对齐,真正实现“1+1>2”的融合效果。

Q4:MAKR适合哪些实际应用场景?不适合哪些场景?

A4:适合“需要异构数据联合分析、资源有限”的场景,如:①中小机构的情报分析(无超算,MAKR资源消耗合理);②金融风险检测(整合“交易数据(结构化)+新闻舆情(非结构化)”找风险关联);③医疗病例分析(结合“病历文本+检查数据”推导病因)。

不适合“仅需单一文本处理”的场景,如:①简单的文本摘要生成;②单文档的情感分析——这类场景用纯LLM更高效,没必要用MAKR的复杂框架。

九、总结

MAKR框架通过“多Agent协作”和“双塔结构融合”,巧妙解决了情报分析中“结构化与非结构化数据联合解析”的核心难题。它的优势在于:既用SKG补全了实体关联,让LLM不再“记混线索”;又通过分工明确的Agent和双塔结构,实现了“GNN懂关系、LLM懂文本”的协同;还在资源有限的场景下,做到了“精度提升与资源消耗的平衡”。

实验结果证明,MAKR在真实的情报分析任务中(安全事件、制裁关联)比现有模型更准、更实用,不仅能提升情报分析的自动化水平,还为其他异构数据处理领域提供了可借鉴的技术思路。未来融合视觉数据后,MAKR的应用范围会更广泛,但目前仍需解决“SKG对图拓扑结构表征不足”的小问题——总体而言,是一篇“问题抓得准、方法有创新、落地有价值”的研究。

更多推荐

已为社区贡献49条内容

已为社区贡献49条内容

所有评论(0)