【AI大模型】部署优化量化:FP16

FP16(半精度浮点数)是AI模型部署中的基础量化技术,将32位浮点降至16位,可减少50%内存占用并提升计算效率2-3倍。文章从原理、应用场景(推理/训练)、实现方案(PyTorch/TensorRT)到挑战应对(数值溢出/精度损失)进行全面解析,对比INT8/BF16等方案,指出FP16在平衡精度与速度上的优势。典型测试显示FP16能降低50%内存,加速2.5倍以上,建议新硬件优先采用BF16

FP16(半精度浮点数)是大型AI模型部署中最基础且广泛应用的量化技术,通过将模型权重和计算从FP32(单精度)降至FP16(16位浮点),显著提升推理速度并降低资源消耗。以下从核心原理到实践落地的全面解析:

一、FP16量化核心原理

| 特性 | FP32(单精度) | FP16(半精度) | 优化效果 |

|---|---|---|---|

| 比特位数 | 32位 | 16位 | ⬇️ 内存占用减少50% |

| 数值范围 | ±3.4e38 | ±6.5e4 | ⚠️ 范围缩小,可能溢出 |

| 精度(小数位) | 23位尾数 | 10位尾数 | ⚠️ 精度损失,影响微小数值计算 |

| 硬件支持 | 通用支持 | NVIDIA GPU(Pascal+) AMD GPU / NPU |

⬆️ 计算吞吐提升2-3倍 |

二、FP16在模型部署中的核心价值

-

内存优化

-

模型权重内存占用直接减半(例如:7B参数模型从28GB → 14GB)

-

激活值(Activations)和梯度存储同步压缩

-

直接效果:可在消费级显卡(如RTX 3090 24GB)运行13B级别大模型

-

-

计算加速

-

现代GPU的Tensor Core针对FP16计算优化

-

计算吞吐峰值提升2-8倍(如A100 FP16算力312 TFLOPS vs FP32 156 TFLOPS)

-

数据搬运带宽压力降低

-

-

能效提升

-

更少的数据传输 → 更低功耗

-

同等算力下功耗降低30%-50%

-

三、FP16部署实践方案

方案1:直接转换(推理场景)

# PyTorch 示例 - 模型权重整体转为FP16

model = load_pretrained_model()

model.half() # 所有权重转换为FP16

# 输入数据同步转换

input_data = input_data.half()

# 推理执行

with torch.no_grad():

output = model(input_data)方案2:混合精度训练(训练微调场景)

from torch.cuda import amp

scaler = amp.GradScaler() # 梯度缩放防止下溢出

for data in dataloader:

inputs, labels = data

inputs, labels = inputs.cuda(), labels.cuda()

with amp.autocast(): # 自动转换计算为FP16

outputs = model(inputs)

loss = criterion(outputs, labels)

scaler.scale(loss).backward() # 缩放梯度

scaler.step(optimizer) # 更新参数

scaler.update() # 调整缩放因子方案3:推理引擎集成(生产部署)

# TensorRT 部署FP16优化

builder = trt.Builder(logger)

network = builder.create_network()

parser = trt.OnnxParser(network, logger)

# 解析ONNX模型

with open("model.onnx", "rb") as f:

parser.parse(f.read())

# 启用FP16并构建引擎

config = builder.create_builder_config()

config.set_flag(trt.BuilderFlag.FP16) # 启用FP16

engine = builder.build_engine(network, config)四、FP16的挑战与应对策略

问题1:数值溢出(溢出风险)

-

现象:大梯度/激活值超出FP16范围(±65,504)

-

解决方案:

-

梯度缩放(Gradient Scaling):在反向传播前放大梯度,更新参数前还原

-

动态损失缩放(如PyTorch的

GradScaler)

-

问题2:精度损失(下溢出风险)

-

现象:微小梯度(<6e-8)在FP16中变为0

-

解决方案:

-

保留主权重为FP32(混合精度训练)

-

关键层(如LayerNorm/Softmax)保持FP32计算

-

问题3:硬件兼容性

-

限制:旧GPU(Maxwell架构前)无FP16加速

-

解决方案:

-

动态回退FP32:

if not torch.cuda.is_fp16_supported(): model.float() -

使用模拟FP16(不推荐,速度无提升)

-

五、FP16 vs 其他量化方案

| 指标 | FP16 | INT8 | BF16 | 适用场景 |

|---|---|---|---|---|

| 精度 | 中等 | 低 | 接近FP32 | 通用任务 |

| 内存占用 | 50% FP32 | 25% FP32 | 50% FP32 | 边缘设备优选INT8 |

| 计算加速 | 2-3× | 4×+ | 2-3× | 云端推理FP16/BF16主流 |

| 硬件要求 | Pascal+ GPU | Turing+ GPU | Ampere+ GPU | 新硬件选BF16避免精度损失 |

| 训练支持 | ✅ | ❌(仅推理) | ✅ | 训练用FP16/BF16 |

关键结论:FP16是平衡精度与速度的最佳起点,Ampere架构以上GPU优先选BF16

六、典型性能提升数据

| 模型 | 硬件 | FP32延迟 | FP16延迟 | 加速比 | 内存下降 |

|---|---|---|---|---|---|

| BERT-Large | T4 GPU | 120ms | 45ms | 2.67× | 1.9GB→0.9GB |

| GPT-2 (1.5B) | A10G | 350ms | 140ms | 2.5× | 6GB→3GB |

| ResNet-50 | Jetson Xavier | 85ms | 32ms | 2.65× | 98MB→49MB |

七、操作建议

-

推理部署

# 使用Hugging Face Optimum+ONNX Runtime optimum-cli export onnx --model distilbert-base-uncased --device cuda --fp16 . -

生产检查清单:

-

✅ 验证损失函数是否稳定(训练时)

-

✅ 测试极端输入下的数值溢出

-

✅ 监控输出差异(FP16 vs FP32的余弦相似度>0.99)

-

✅ 关键业务层保持FP32(如金融风控模型的输出层)

-

-

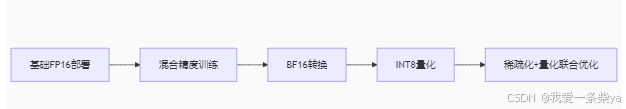

进阶路线:

FP16是打开大模型高效部署大门的**第一把钥匙**。掌握其核心逻辑与实践技巧,可立竿见影提升推理效率,为后续INT8/BF16等高级优化奠定基础。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)