AutoGen(二) 一文搞懂AutoGen消息机制:多智能体协作通信全流程实战

本文深入解析了AutoGen框架的消息机制在多智能体协作中的应用。文章首先概述了AutoGen消息系统的核心优势,包括支持多模态消息和高扩展性。随后详细介绍了文本消息和多模态消息的创建方法,并提供了实战代码示例展示如何利用MultiModalMessage驱动智能体任务。文章还探讨了非OpenAI模型的对接方法,重点解析了model_info参数的配置要点,为开发者提供了清晰的参数说明和使用建议。

一文搞懂AutoGen消息机制:多智能体协作通信全流程实战(附代码)

关键词:AutoGen、LLM、多智能体、消息机制、实战、附代码、全流程

引言

在AI多智能体系统开发中,消息机制是实现智能体高效协作的核心。AutoGen作为新一代LLM多智能体框架,凭借灵活的消息系统,极大简化了智能体间的通信与任务编排。本文将带你深入理解AutoGen的消息机制,掌握文本与多模态消息的实战用法,并通过代码案例助你快速上手,打造属于你的智能体协作应用。

1. AutoGen消息机制概述

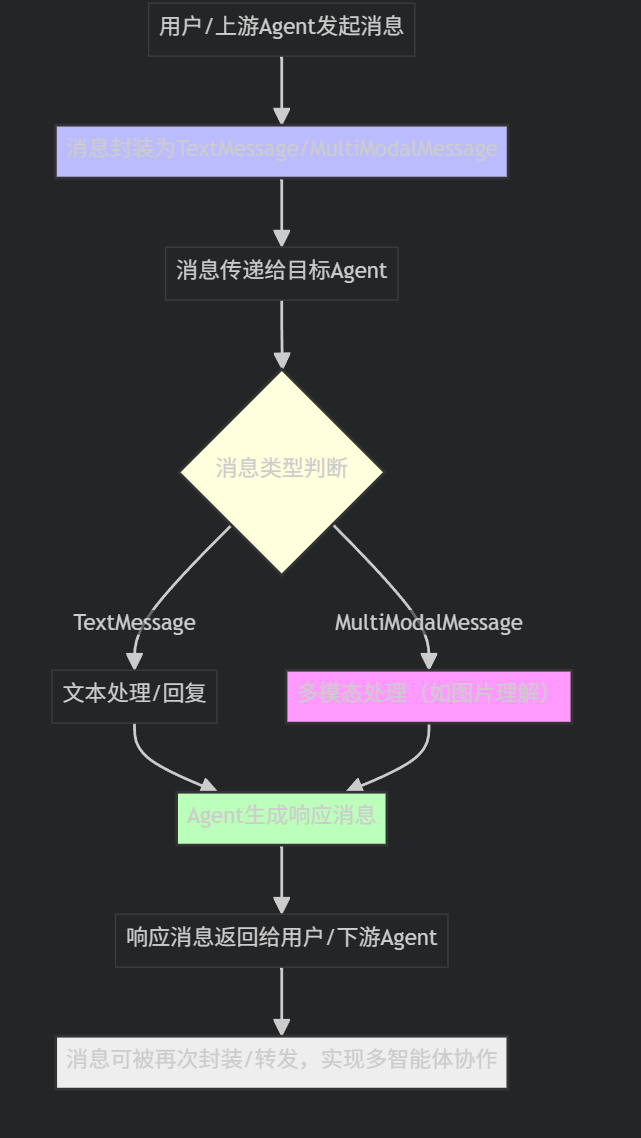

AutoGen的AgentChat模块通过消息(Message)实现智能体、协调器、应用之间的信息流转。消息不仅承载了任务指令、数据,还支持多模态内容(如图片、文本),为复杂场景下的多智能体协作提供了坚实基础。

核心优势

- 多类型消息支持:文本、图片等多模态内容无缝集成

- 高扩展性:基于BaseChatMessage,便于自定义消息类型

- 开发效率高:消息即任务,简化智能体间的协作流程

2. 消息类型全解析

AutoGen消息体系主要分为两大类:

2.1 智能体间消息(Agent-Agent Messages)

用于不同智能体之间的信息交换,基于 BaseChatMessage派生,常用类型包括:

- TextMessage:纯文本消息,适合指令、对话等场景

- MultiModalMessage:支持文本+图片等多模态内容,适合复杂任务

代码示例:创建文本消息

from autogen_agentchat.messages import TextMessage

text_message = TextMessage(content="Hello, world!", source="User")

代码示例:创建多模态消息

from io import BytesIO

import requests

from autogen_agentchat.messages import MultiModalMessage

from autogen_core import Image as AGImage

from PIL import Image

pil_image = Image.open(BytesIO(requests.get("https://picsum.photos/300/200").content))

img = AGImage(pil_image)

multi_modal_message = MultiModalMessage(content=["请描述这张图片的内容", img], source="User")

2.2 智能体内部事件与消息

用于智能体自身的状态管理、事件通知等,通常由框架自动处理,开发者关注较少。

3.实战代码:多模态消息驱动的智能体任务

from autogen_agentchat.messages import MultiModalMessage

from autogen_core import Image as AGImage

from PIL import Image

import requests

from io import BytesIO

from autogen_ext.models.ollama import OllamaChatCompletionClient

from autogen_agentchat.agents import AssistantAgent

import asyncio

# 创建模型客户端

model_client = OllamaChatCompletionClient(

model="qwen2.5vl:3b",

model_info={"vision": True, "function_calling": False, "json_output": False, "structured_output": True}

)

agent = AssistantAgent(

name="assistant",

model_client=model_client,

system_message="you are a assistant",

)

# 构造多模态消息

pil_image = Image.open(BytesIO(requests.get("https://picsum.photos/300/200").content))

img = AGImage(pil_image)

multi_modal_message = MultiModalMessage(content=["请描述这张图片的内容", img], source="User")

async def main():

result = await agent.run(task=multi_modal_message)

print(result)

if __name__ == "__main__":

asyncio.run(main())

4. 应用场景与进阶技巧

- 智能问答系统:结合图片和文本,实现多模态问答

- 代码生成与调试:通过消息传递代码片段、调试信息

- 博弈AI开发:多智能体间实时通信,动态决策

进阶技巧

- 自定义消息类型,扩展更多场景

- 利用消息历史,实现上下文记忆与多轮对话

5. 常见问题与解决方案(FAQ)

Q1:消息内容支持哪些类型?

A:TextMessage支持字符串,MultiModalMessage支持字符串和AGImage对象。

Q2:如何调试消息传递?

A:建议在开发阶段打印消息内容,或使用断点调试on_messages、run等方法。

Q3:多模态消息图片如何传递?

A:需先用PIL加载图片,再用AGImage封装,最后作为content元素传入MultiModalMessage。

7. 非OpenAI模型对接与参数详解

在AutoGen中,除了OpenAI官方模型外,还可以灵活集成本地或第三方大模型(如Ollama、Qwen、Llama等)。这类模型通常需要通过自定义的 model_client进行对接,并在初始化时传入详细的 model_info参数,以确保功能正常。

7.1 非OpenAI模型对接示例

以Ollama本地模型为例,以下代码展示了如何在AutoGen中集成并配置:

from autogen_ext.models.ollama import OllamaChatCompletionClient

from autogen_agentchat.agents import AssistantAgent

# 创建模型客户端

model_client = OllamaChatCompletionClient(

model="qwen2.5vl:3b", # 指定本地或第三方模型名称

model_info={

"vision": True, # 是否支持多模态(如图片理解)

"function_calling": False, # 是否支持函数调用

"json_output": False, # 是否直接输出JSON格式

"structured_output": True # 是否支持结构化输出

}

)

agent = AssistantAgent(

name="assistant",

model_client=model_client,

system_message="you are a assistant",

)

7.2 model_info参数详解

| 参数名 | 类型 | 作用说明 |

|---|---|---|

| vision | bool | 是否支持视觉多模态输入(如图片、视频)。True表示支持,False表示不支持。 |

| function_calling | bool | 是否支持函数调用(Function Calling)。True表示支持,False表示不支持。 |

| json_output | bool | 是否直接输出JSON格式内容。True表示输出JSON,False表示普通文本。 |

| structured_output | bool | 是否支持结构化输出(如表格、对象等)。True表示支持,False表示不支持。 |

| family(可选) | 枚举/字符串 | 指定模型家族(如ModelFamily.R1),用于某些高级配置。 |

注意:不同模型的参数支持情况可能不同,具体以模型文档为准。对于本地或第三方模型,务必根据实际功能设置上述参数,否则可能导致功能异常或报错。

7.3 对接建议

- 模型兼容性:确保所选模型支持你所需的功能(如多模态、结构化输出等)。

- 参数配置:合理设置

model_info,避免因参数不匹配导致的运行异常。 - 调试方法:如遇到模型响应异常,可逐项排查参数设置,并参考模型官方文档。

结语

AutoGen的消息机制为多智能体协作提供了强大支撑。掌握消息类型与实战用法,将助你高效开发智能体应用,玩转AI前沿。赶快动手试试吧!

如需更多AutoGen实战案例、进阶技巧,欢迎评论区留言交流,或关注我获取最新AI开发干货!

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)