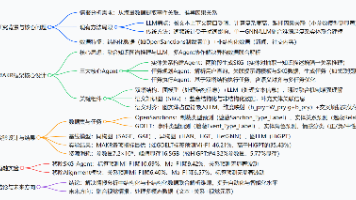

机器学习算法(六):随机森林算法

本文详细介绍了随机森林算法的原理、优缺点及实现方法。随机森林是一种集成学习算法,通过构建多棵决策树并综合其预测结果来提高准确率。文章分析了Bootstrap采样、随机特征选择等核心概念,并讨论了超参数调优技巧。重点展示了使用Java的Weka库实现随机森林的完整流程,包括数据加载、模型训练、预测和评估(10折交叉验证)。虽然随机森林存在训练时间长、内存占用高等缺点,但其高准确率、处理缺失数据等优势

目录

深入解析随机森林算法(Random Forest)及其在Java中的实现

引言

在机器学习领域,**随机森林(Random Forest)**是一种强大的集成学习算法。作为一种基于决策树的算法,随机森林通过构建多个决策树并综合其输出结果来提高预测的准确性和稳定性。本文将详细介绍随机森林的原理、优缺点、参数调优,以及如何使用Java实现一个基本的随机森林模型。

一、随机森林算法概述

1.1 随机森林是什么

随机森林是一种集成学习方法,基于 Bagging(Bootstrap Aggregating) 原理,通过构建多棵决策树并对其结果进行投票或平均,来实现对未知数据的预测。每一棵决策树的训练都是基于从原始训练集进行有放回抽样(即Bootstrap采样),并且在树的构建过程中随机选择特征子集进行分裂。

1.2 随机森林的工作原理

随机森林的工作原理主要包括以下几个步骤:

- 数据集采样:从训练集数据中随机采样生成多个子集,每个子集用于训练一棵决策树。

- 决策树构建:对于每个子集,随机森林算法通过决策树算法构建一棵决策树,在每个节点上随机选择特征子集进行分裂。

- 集成学习:所有的决策树训练完成后,使用多数投票(分类任务)或平均(回归任务)来得出最终的预测结果。

1.3 随机森林的优缺点

优点:

- 高准确率:通过集成多个决策树,随机森林能够减少过拟合,提高模型的稳定性。

- 处理大规模数据:能够高效处理高维数据和大规模数据集。

- 处理缺失数据:可以在数据缺失时继续进行预测,不需要对数据进行填补。

- 无需特征选择:由于其内建的特征选择机制,随机森林在大部分情况下无需进行手动特征选择。

缺点:

- 训练时间较长:因为构建了多棵决策树,训练过程的计算量较大,尤其是在数据集较大时。

- 模型可解释性差:相比于单棵决策树,随机森林的模型复杂性较高,难以进行详细的解释。

- 内存占用高:需要存储多个决策树,可能会消耗大量内存。

二、随机森林的核心概念

2.1 Bootstrap采样

Bootstrap是从原始数据集通过有放回的方式抽取样本,这样会产生一些重复的样本,也有一些样本未被选中。每一棵决策树都使用一个不同的子集进行训练,这样可以提高模型的多样性。

2.2 随机特征选择

在每个决策树的节点分裂时,随机森林不会使用所有的特征,而是从所有特征中随机选择一个子集。这个操作避免了模型对某些特征的过度依赖,从而提高了泛化能力。

2.3 投票与平均

- 分类问题:每棵决策树对数据进行分类,随机森林将所有树的分类结果进行投票,选择出现最多的类别作为最终预测结果。

- 回归问题:随机森林对每棵树的输出值进行平均,得到最终的预测值。

三、随机森林的超参数调优

在使用随机森林时,有几个重要的超参数需要调整:

- n_estimators(树的数量):表示随机森林中决策树的数量,通常更多的树可以提升模型的准确性,但会增加计算开销。

- max_depth(树的最大深度):控制树的最大深度,避免过拟合。

- min_samples_split(分裂所需的最小样本数):控制节点分裂时,所需的最小样本数,较大的值可以防止过拟合。

- min_samples_leaf(叶节点的最小样本数):叶子节点最少需要的样本数量。

- max_features(每次分裂时使用的特征数):控制每棵树分裂时选择的最大特征数。这个参数可以用来防止过拟合。

四、使用Java实现随机森林

接下来,我们将使用Java中的开源机器学习库 Weka 来实现一个简单的随机森林模型。

4.1 准备工作

首先,确保你已经添加了 Weka 库。如果你是通过 Maven 来管理项目依赖,可以在 pom.xml 文件中添加如下依赖:

<dependency>

<groupId>nz.ac.waikato.cms.weka</groupId>

<artifactId>weka</artifactId>

<version>3.8.5</version>

</dependency>

4.2 Java代码实现

import weka.classifiers.trees.RandomForest;

import weka.core.Instances;

import weka.core.converters.ConverterUtils.DataSource;

public class RandomForestExample {

public static void main(String[] args) throws Exception {

// 载入数据集

DataSource source = new DataSource("path_to_your_data.arff");

Instances data = source.getDataSet();

// 设置类别属性

if (data.classIndex() == -1)

data.setClassIndex(data.numAttributes() - 1);

// 创建并训练随机森林模型

RandomForest rf = new RandomForest();

rf.setNumTrees(100); // 设置决策树的数量

rf.setMaxDepth(10); // 设置树的最大深度

rf.buildClassifier(data);

// 预测新样本

Instances testData = source.getDataSet(); // 可以替换为测试数据

for (int i = 0; i < testData.numInstances(); i++) {

double label = rf.classifyInstance(testData.instance(i));

System.out.println("Predicted label: " + label);

}

}

}

4.3 代码解析

- DataSource:用于加载数据集文件,可以是

.arff文件。 - RandomForest:Weka 中的随机森林模型,我们通过设置

numTrees和maxDepth等参数来配置模型。 - classifyInstance:该方法用于对单个实例进行分类预测。

4.4 模型评估

为了评估模型的性能,可以使用交叉验证,Weka 提供了 CrossValidation 类来实现:

import weka.classifiers.Evaluation;

import weka.classifiers.trees.RandomForest;

import weka.core.Instances;

import weka.core.converters.ConverterUtils.DataSource;

public class ModelEvaluation {

public static void main(String[] args) throws Exception {

// 加载数据

DataSource source = new DataSource("path_to_your_data.arff");

Instances data = source.getDataSet();

if (data.classIndex() == -1)

data.setClassIndex(data.numAttributes() - 1);

// 构建模型

RandomForest rf = new RandomForest();

rf.setNumTrees(100);

rf.buildClassifier(data);

// 交叉验证

Evaluation eval = new Evaluation(data);

eval.crossValidateModel(rf, data, 10, new java.util.Random(1));

// 输出评估结果

System.out.println(eval.toSummaryString());

}

}

此代码使用 10折交叉验证 来评估模型的性能,输出分类准确率、混淆矩阵等指标。

五、总结

随机森林作为一种集成学习方法,凭借其高准确率、抗过拟合的特性,在多种应用中都表现出了优异的性能。尽管训练过程相对复杂且耗时,但通过合理的参数调优和适当的硬件支持,随机森林在实际应用中仍然是一种非常可靠的模型。在Java中,我们可以借助Weka等工具轻松实现和评估随机森林模型,从而为我们的机器学习项目提供强有力的支持。

希望本文的讲解能帮助你深入理解随机森林的原理,并掌握如何在Java中实现和调优随机森林模型。

推荐阅读:

更多推荐

已为社区贡献38条内容

已为社区贡献38条内容

所有评论(0)